My ultimate data structure and algorithm guide

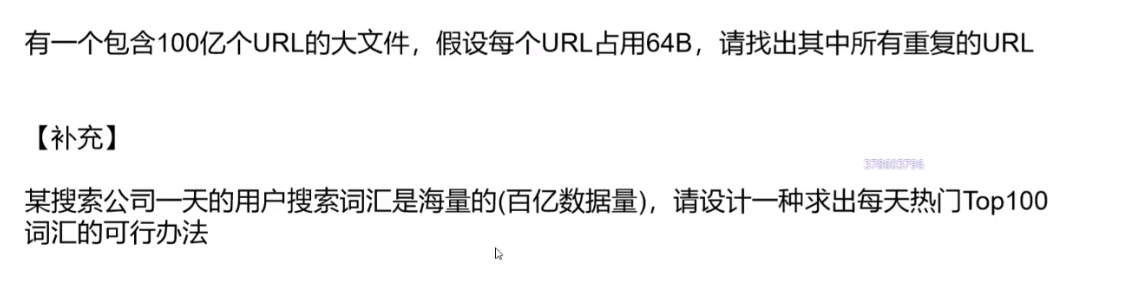

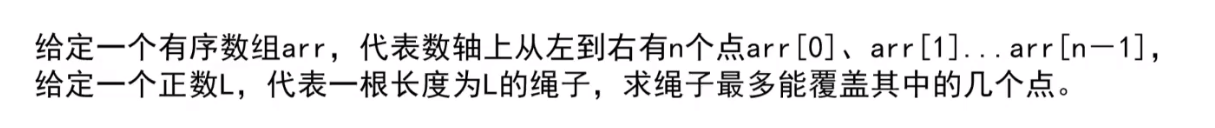

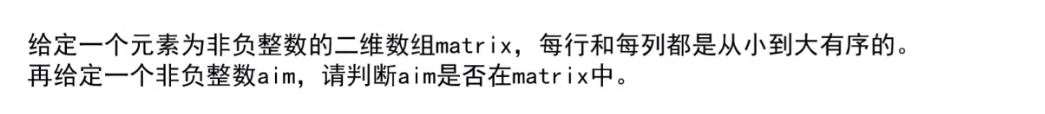

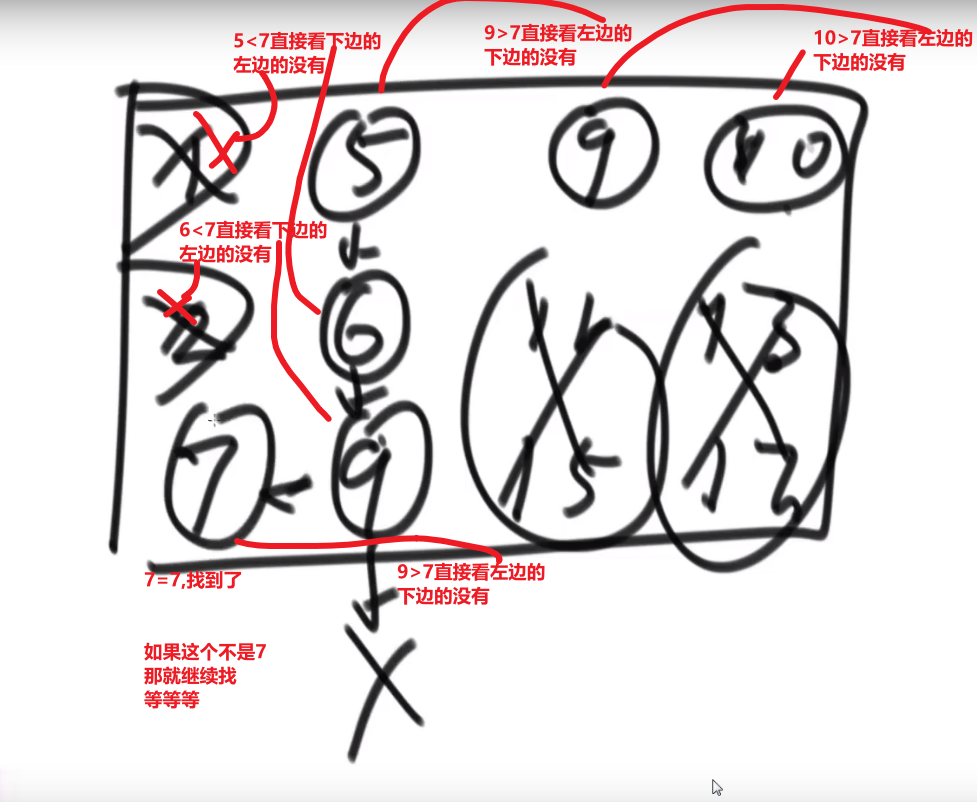

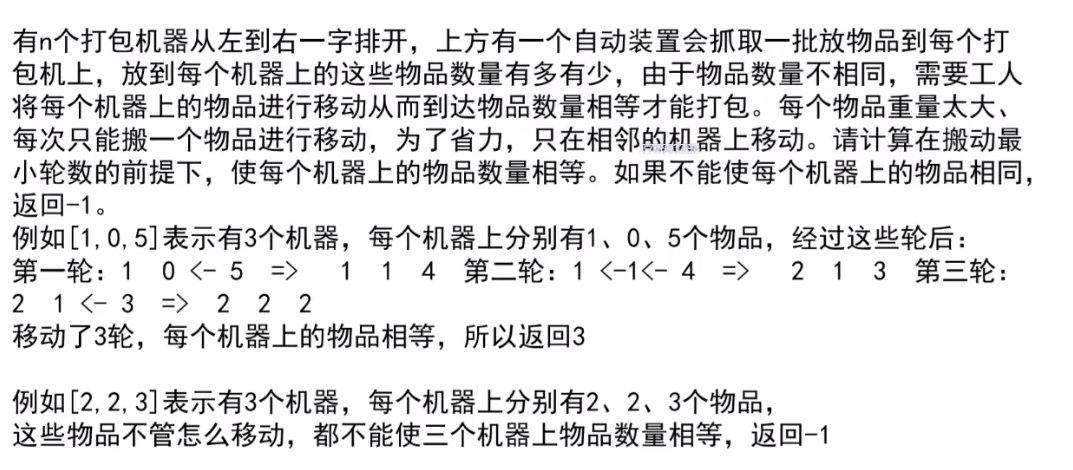

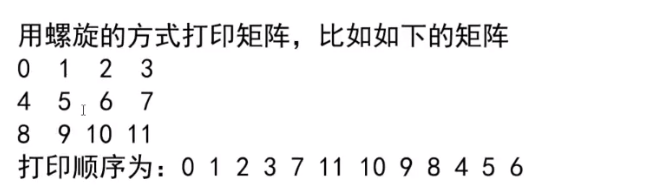

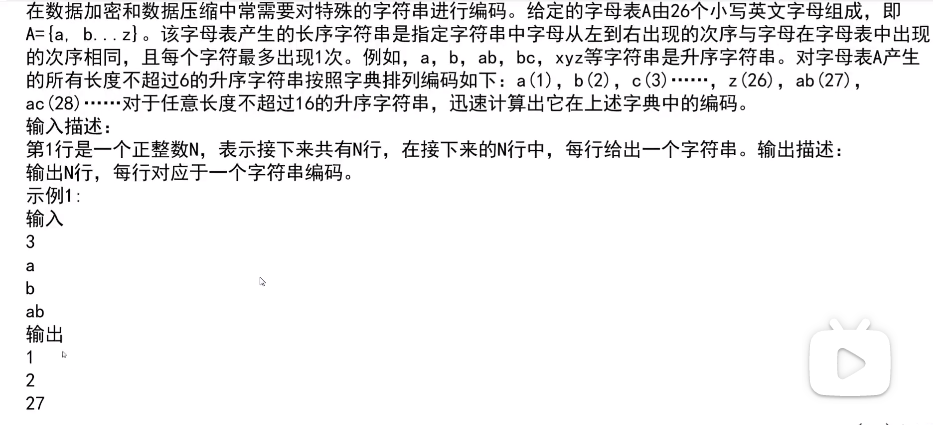

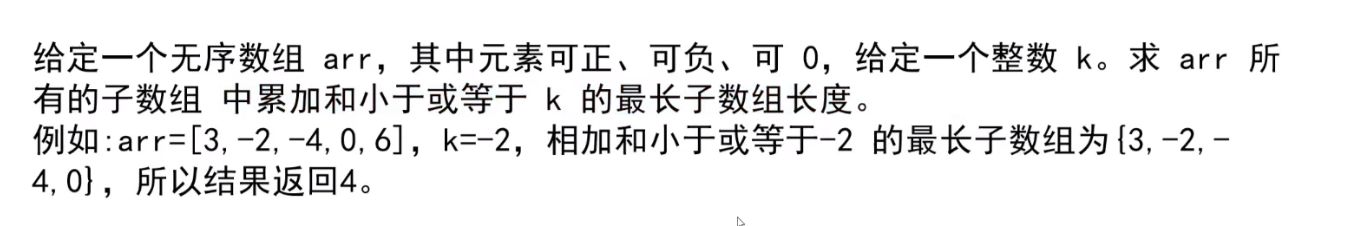

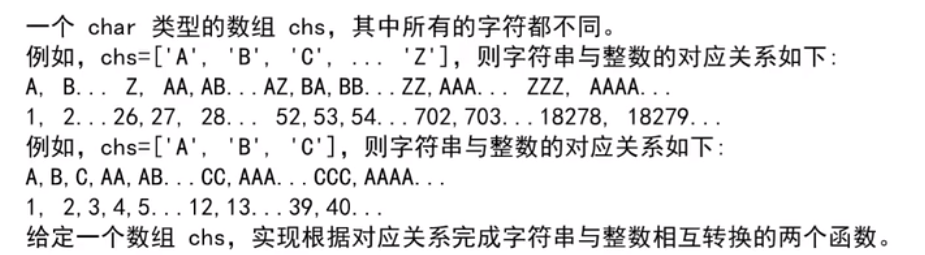

# 前言

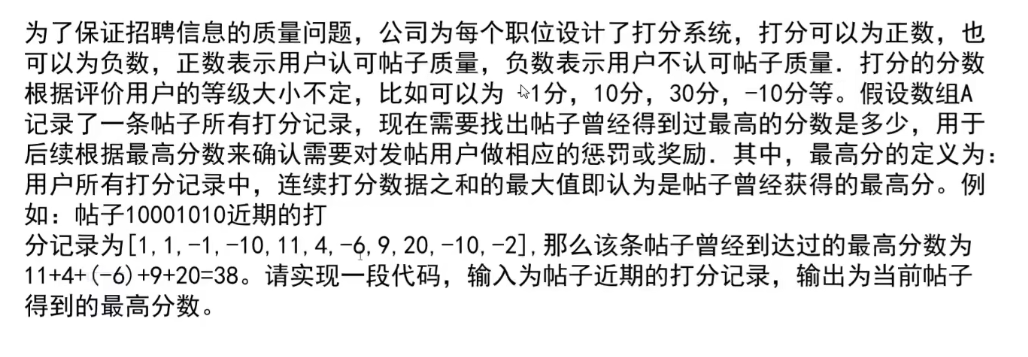

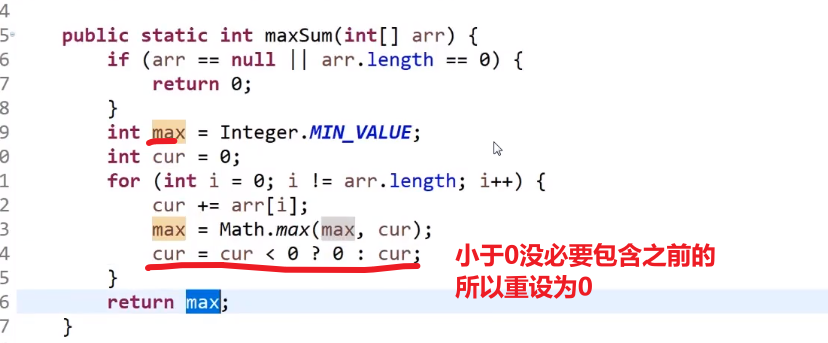

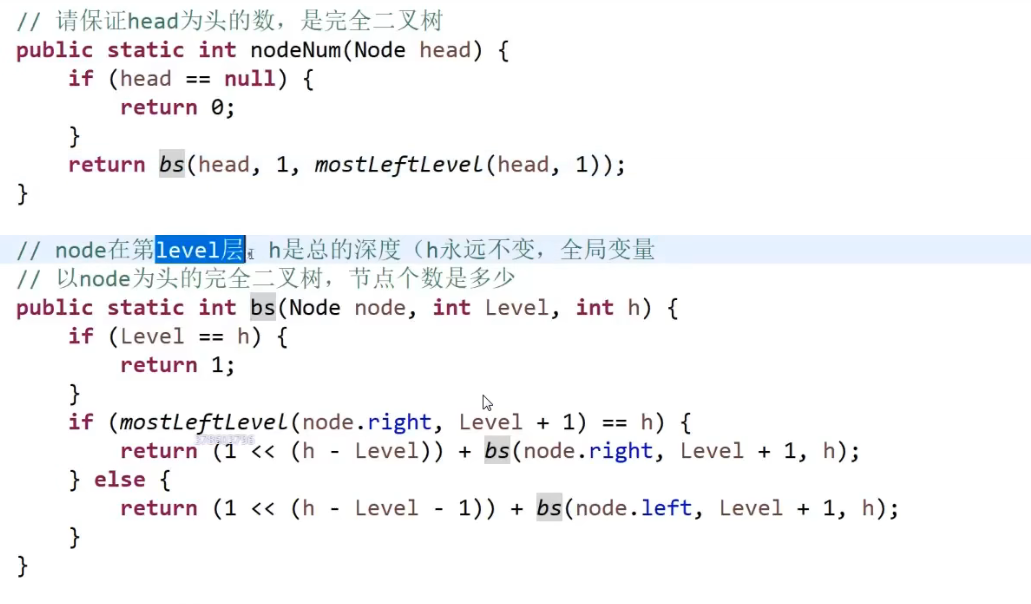

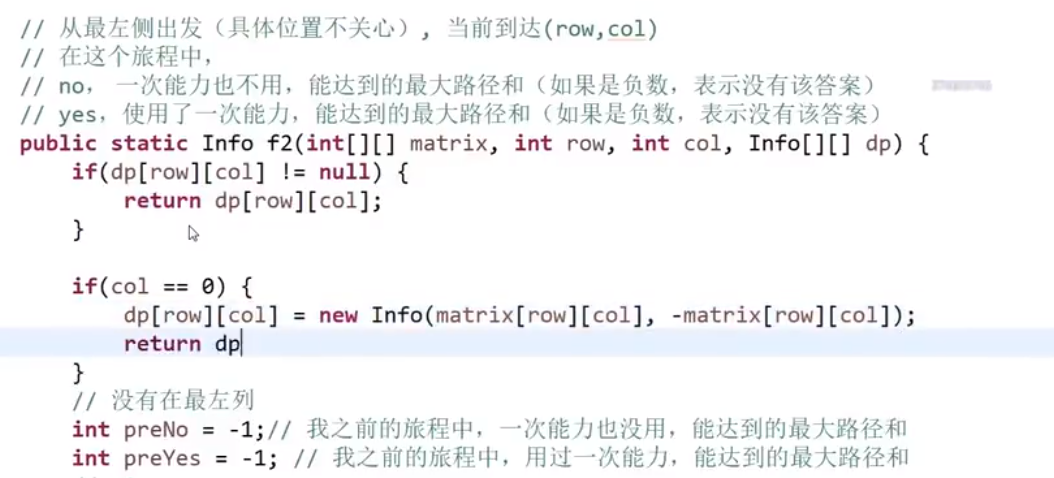

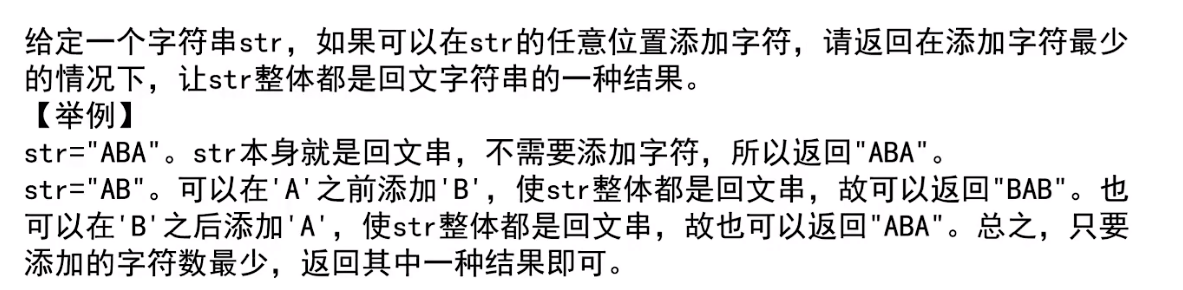

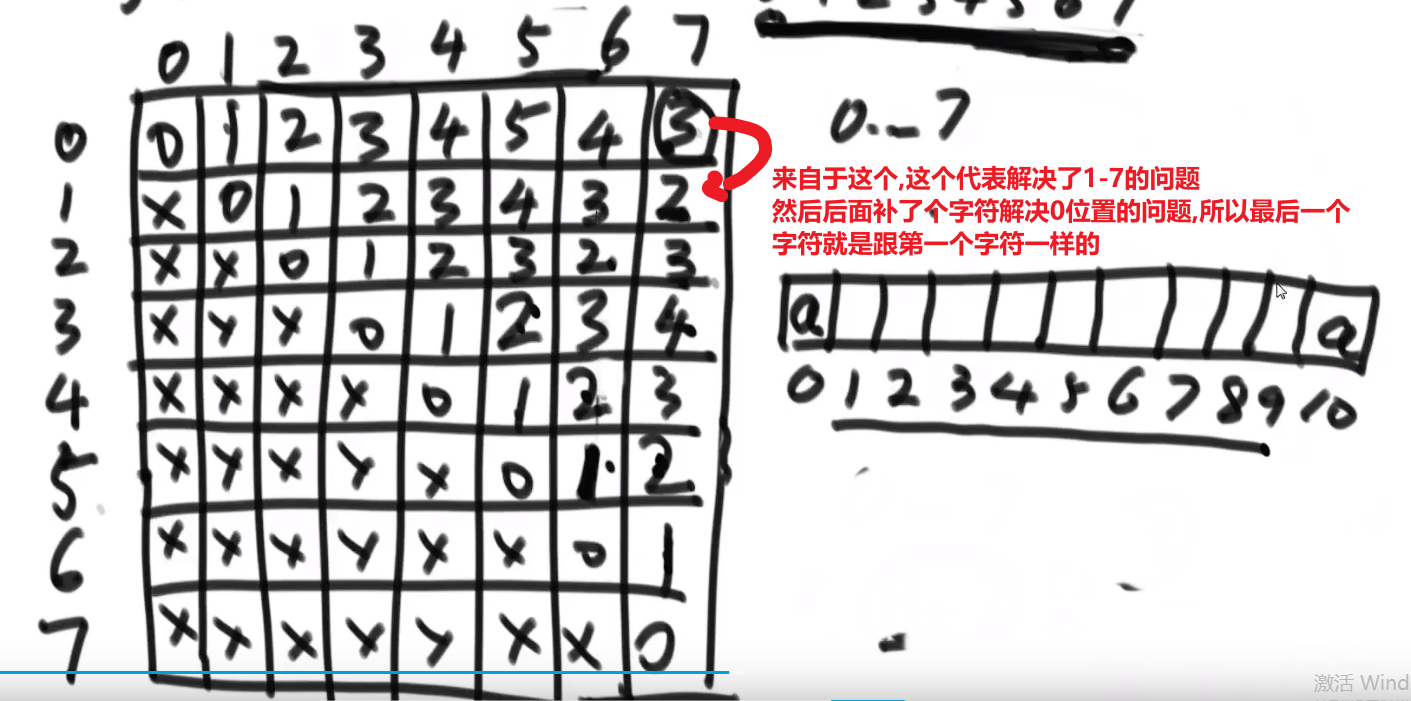

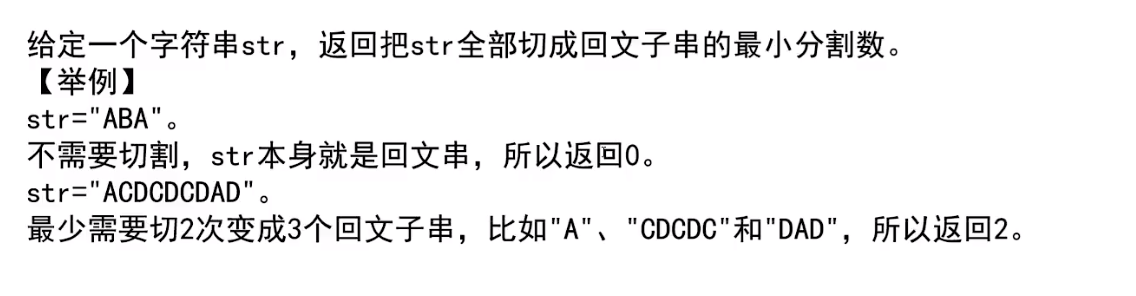

此笔记是按照 b 站左程云左神讲的课做的笔记

从初级班班内容到高级班,此笔记应该是对该视频最全的笔记,内涵题目代码讲解以及一些个人思想 (废话)

- 模板部分主要是为了参加比赛的同学方便截取

- 个人看法部分是一些我自己做的题

- 算法课以及刷题以及技巧为视频的初级中级以及高级版的内容 (按照顺序)

之后还会按照代码随想录出一篇个人刷题的记录以及刷题思想,敬请期待!

写笔记不易,求个点赞!

# 模板

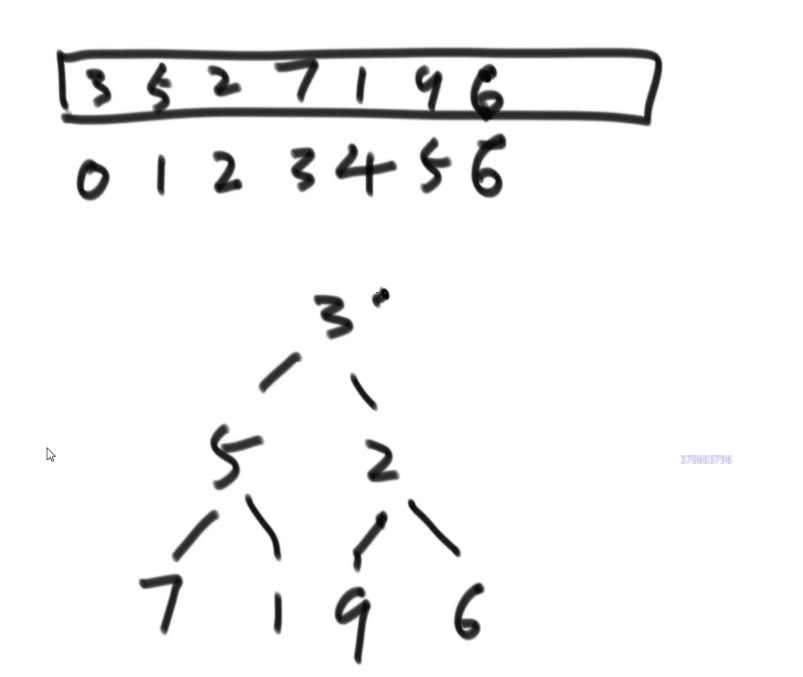

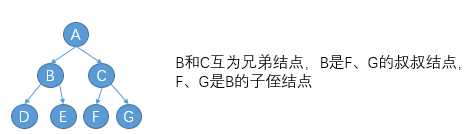

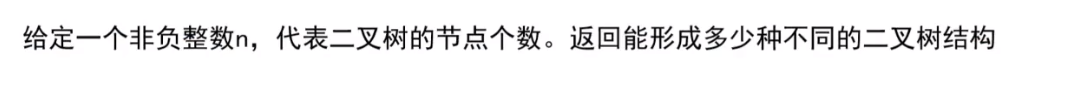

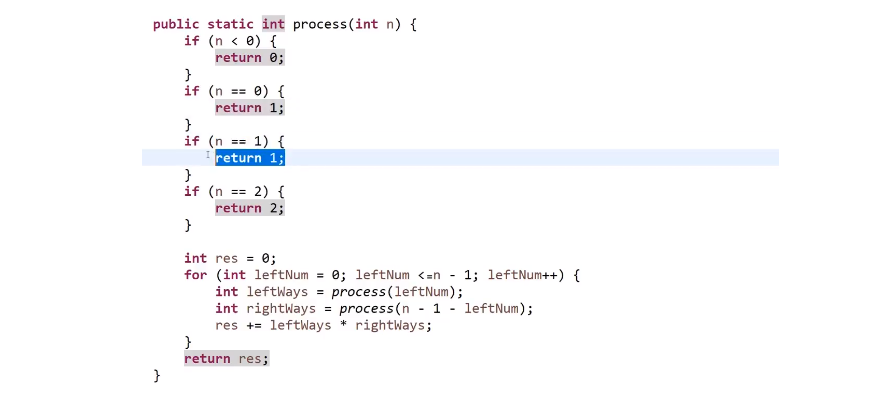

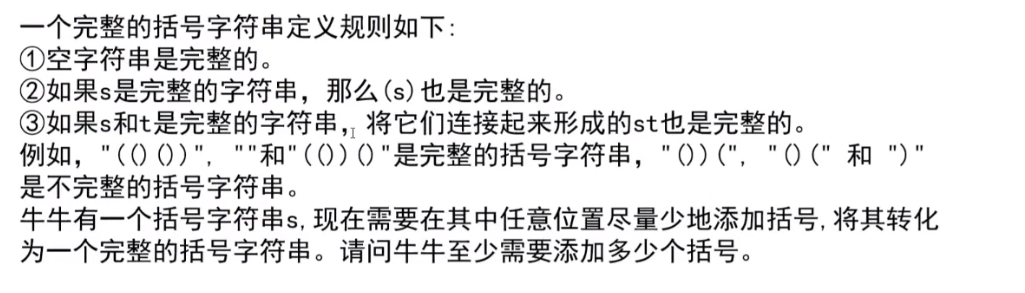

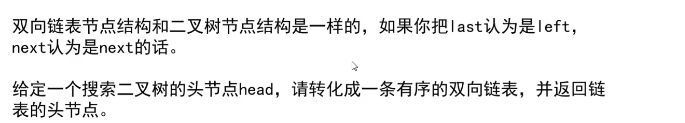

# 二叉树

据不完全总结,二叉树的题大致可以分为两种,一种是通过前序、中序、后序、层序遍历来解决问题。

另一种为递归问题,需要从每个节点来获取信息,然后提取出题目中要求的信息

# 遍历模版

# 二叉树非递归遍历

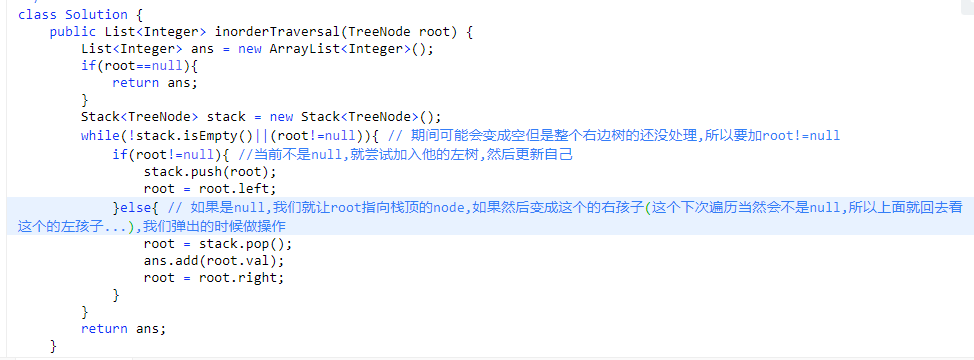

# 中序

- 先找到最左节点,并逐步压栈

- 当最左为空时,弹出栈顶(此时为最左节点),并输出

- 找最左节点有没有右孩子,有则压栈(循环 1,2),没有进行下一步

- 没有右孩子时,当前节点为 null,弹出栈顶(此时栈顶为最左节点的父亲节点)

- 输出 最左节点的父亲节点 的值

- 找 5 中的节点有没有右孩子 重复(1,2)

- 当栈为空 且 当前遍历的节点为 null 时 ,遍历结束

public List<Integer> inorderTraversal(TreeNode root) {

if(root==null){

return new ArrayList<>();

}

List<Integer> list = new ArrayList<>();

Stack<TreeNode> stack=new Stack<>();

while(!stack.isEmpty() || root!=null){

if(root!=null){

stack.push(root);

root=root.left;

}else{

root=stack.pop();

list.add(root.val);

root=root.right;

}

}

return list;

}

# 前序

public List<Integer> preorderTraversal(TreeNode root) {

if(root==null){

return new ArrayList<>();

}

List<Integer> list = new ArrayList<>();

Stack<TreeNode> stack=new Stack<>();

stack.push(root);

while(!stack.isEmpty()){

TreeNode node = stack.pop();

if(node.right!=null){

stack.push(node.right);

} list.add(node.val);

if(node.left!=null){

stack.push(node.left);

}

}

return list;

}

# 后序

public List<Integer> postorderTraversal(TreeNode root) {

if(root==null){

return new ArrayList<>();

}

List<Integer> list = new ArrayList<>();

Stack<TreeNode> stack=new Stack<>();

Stack<Integer> temp =new Stack<>();

stack.push(root);

while(!stack.isEmpty()){

TreeNode node = stack.pop();

if(node.left!=null){

stack.push(node.left);

}

temp.push(node.val);

if(node.right!=null){

stack.push(node.right);

}

}

while(!temp.isEmpty()){

list.add(temp.pop());

}

return list;

}

# 层次遍历非递归

很多求层相关的问题都可以使用此模版解题

public List<List<Integer>> resList = new ArrayList<List<Integer>>();

public List<List<Integer>> levelOrder(TreeNode root) {

checkFun02(root);

return resList;

}

public void checkFun02(TreeNode node) {

if (node == null) return;

Queue<TreeNode> que = new LinkedList<TreeNode>();

que.offer(node);

while(!que.isEmpty()){

List<Integer> itemList = new ArrayList<Integer>();

int len = que.size();

while (len > 0) {

TreeNode tmpNode = que.poll();

itemList.add(tmpNode.val);

if (tmpNode.left != null) que.offer(tmpNode.left);

if (tmpNode.right != null) que.offer(tmpNode.right);

len--;

}

resList.add(itemList);

}

}

# 注意事项

求二叉树对称的时候就是把两个树的节点同时加入队列进行比较

遇到在二叉搜索树上求什么最值,求差值之类的,都要思考一下二叉搜索树可是有序的,要利用好这一特点

迭代法中,一般一起操作两个树都是使用队列模拟类似层序遍历,同时处理两个树的节点,这种方式最好理解,如果用模拟递归的思路的话,要复杂一些。

大多数二叉搜索树的题目,其实都离不开中序遍历,因为这样就是有序的

# 递归模版

可以解决面试中绝大多数的二叉树问题尤其是树型 dp 问题

本质是利用递归遍历二叉树的便利性

# 递归套路步骤

- 假设以 X 节点为头,假设可以向 X 左树和 X 右树要任何信息

- 在上一步的假设下,讨论以 X 为头节点的树,得到答案的可能性 (最重要)

- 列出所有可能性后,确定到底需要向左树和右树要什么样的信息

- 把左树信息和右树信息求全集,就是任何一 一棵子树都需要返回的信息 S

- 递归函数都返回 S,每一棵子树都这么要求

- 写代码,在代码中考虑如何把左树的信息和右树信息整合出整棵树的信息

# 图

# 图:

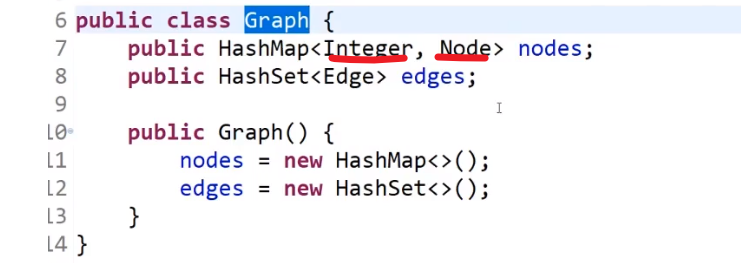

public class Graph {

public HashMap<Integer,Node> nodes;//点的集合

public HashSet<Edge> edges;//边的集合

public Graph() {

nodes = new HashMap<>();

edges = new HashSet<>();

}

}

# 点:

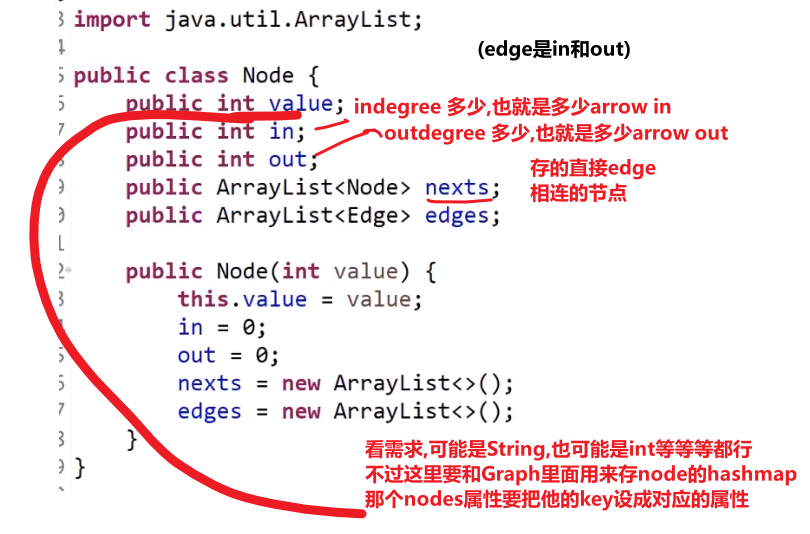

public class Node {

public int value;//节点的数值

public int in;//入度(有多少个节点指向我)

public int out;//出度(我指向多少个节点)

public ArrayList<Node> nexts;//从我出发能到达的下一级节点,邻居节点

public ArrayList<Edge> edges;//从我出发发散出的边的集合

public Node(int value) {

this.value = value;

in = 0;

out = 0;

nexts = new ArrayList<>();

edges = new ArrayList<>();

}

}# 边:

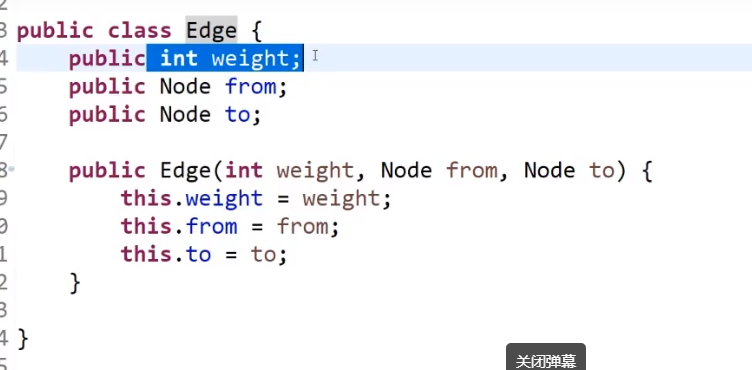

public class Edge {

public int weight;//这个边的权重是多少

public Node from;//这个边从哪里出发

public Node to;//这个边到达哪里的

public Edge(int weight, Node from, Node to) {

this.weight = weight;

this.from = from;

this.to = to;

}

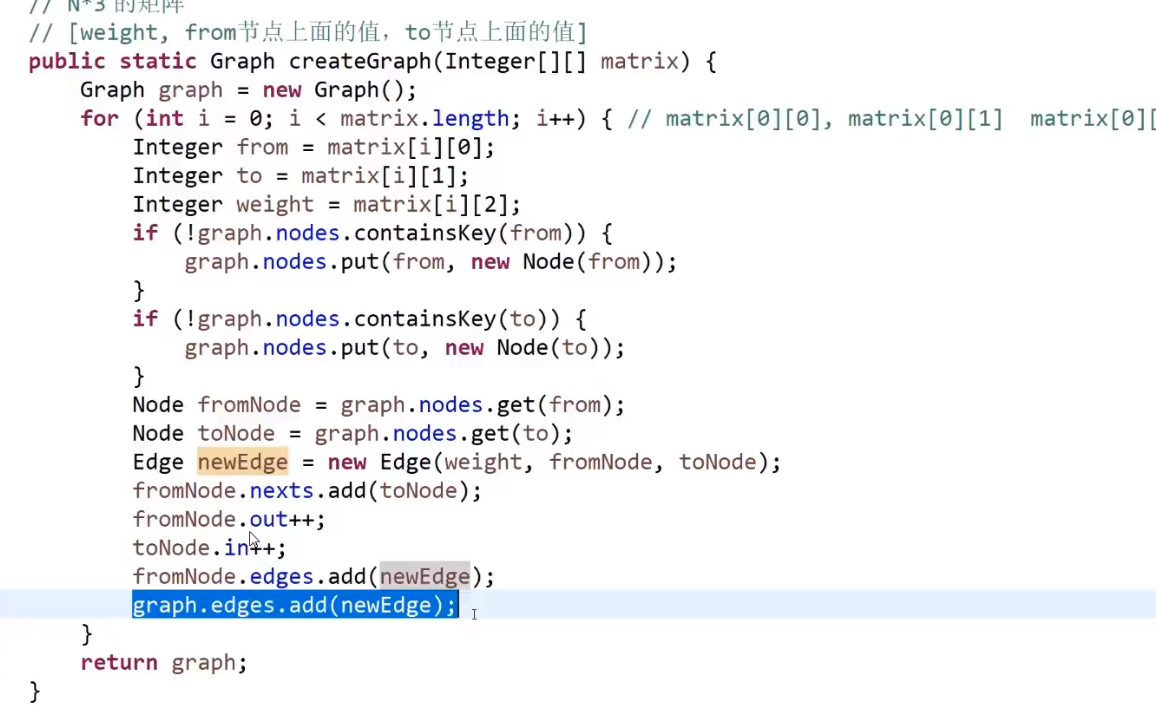

}# 图生成器 (接口,这个要按需求以及输入的来改变):

public class GraphGenerator {

public static Graph createGraph(Integer[][] matrix) {//输入一个矩阵

Graph graph = new Graph();//初始化自定义的图

for (int i = 0; i < matrix.length; i++) {

Integer weight = matrix[i][0];//边的权重

Integer from = matrix[i][1];//from节点的序列

Integer to = matrix[i][2];//to节点的序列

if (!graph.nodes.containsKey(from)) {//先检查from节点存在否,不存在就建

graph.nodes.put(from, new Node(from));

}

if (!graph.nodes.containsKey(to)) {//再检查to节点存在否,不存在就建立

graph.nodes.put(to, new Node(to));

}

Node fromNode = graph.nodes.get(from);//拿出from点

Node toNode = graph.nodes.get(to);//拿出to点

Edge newEdge = new Edge(weight, fromNode, toNode);//建立新的边

fromNode.nexts.add(toNode);//from的邻接点增加了一个to节点

fromNode.out++;//from的出度加1

toNode.in++;//to节点的入度加1

fromNode.edges.add(newEdge);//from节点的边集增加

graph.edges.add(newEdge);//加到整个图的边集里

}

return graph;

}

}# 对数器

使用对数器,具体步骤:

1)有一个你想要测的方法 a

2)实现一个绝对正确但是复杂度不好的方法 b

3) 实现一个随机样本产生器

4)实现比对的方法

5)把方法 a 和方法 b 比对很多次来验证方法 a 是否正确。

6)如果有一个样本使得比对出错,打印样本分析是哪个方法出 错

7)当样本数量很多时比对测试依然正确,可以确定方法 a 已经 正确。

好处:

验证方法对不对

可以很快找到错误 case(几千几万 case 中)

判断贪心对不对

具体实现(例如测试冒泡排序方法是否正确):

想要测试冒泡排序方法 a(判断该方法是否正确):

public static void bubbleSort(int[] arr) {

if (arr == null || arr.length < 2) {

return;

}

for (int e = arr.length - 1; e > 0; e--) {//范围每次缩减1,因为每次都排好了一个数

for (int i = 0; i < e; i++) {//从头到e进行两两比较

if (arr[i] > arr[i + 1]) {

swap(arr, i, i + 1);//(前面比后面大就进行交换)

}

}

}

}

public static void swap(int[] arr, int i, int j) {//两两交换

int tmp = arr[i];

arr[i] = arr[j];

arr[j] = tmp;

}# 1)产生一个长度随机的数组(可能为正,也可能为负,0)

随机样本产生器:

public static int[] generateRandomArray(int maxSize, int maxValue) {

int[] arr = new int[(int) ((maxSize + 1) * Math.random())];

for (int i = 0; i < arr.length; i++) {

arr[i] = (int) ((maxValue + 1) * Math.random()) - (int) (maxValue * Math.random());

}

return arr;

}# 2)绝对正确的方法

调用函数自带的排序方法(实现一个绝对正确但是复杂度不好的方法 b,用于和冒泡排序测试方法比较,判断测试方法是否正确)

public static void comparator(int[] arr) {

Arrays.sort(arr);

}# 3)大样本测试

public static void main(String[] args) {

int testTime = 500000;//测试次数

int maxSize = 100;

int maxValue = 100;

boolean succeed = true;

for (int i = 0; i < testTime; i++) {

int[] arr1 = generateRandomArray(maxSize, maxValue);//产生随机数组

int[] arr2 = copyArray(arr1);

bubbleSort(arr1);//测试的方法

comparator(arr2);//绝对正确的方法

if (!isEqual(arr1, arr2)) {

succeed = false;

break;

}

}

System.out.println(succeed ? "Nice!" : "Fucking fucked!");

}

public static boolean isEqual(int[] arr1, int[] arr2) {//实现比对的方法 ,比较两个数组的每个数是否相等

if ((arr1 == null && arr2 != null) || (arr1 != null && arr2 == null)) {

return false;

}

if (arr1 == null && arr2 == null) {

return true;

}

if (arr1.length != arr2.length) {

return false;

}

for (int i = 0; i < arr1.length; i++) {

if (arr1[i] != arr2[i]) {

return false;

}

}

return true;

}

# 回溯模板

# Subsets

https://leetcode.com/problems/subsets/

public List<List<Integer>> subsets(int[] nums) {

List<List<Integer>> list = new ArrayList<>();

Arrays.sort(nums);

backtrack(list, new ArrayList<>(), nums, 0);

return list;

}

private void backtrack(List<List<Integer>> list , List<Integer> tempList, int [] nums, int start){

list.add(new ArrayList<>(tempList));

for(int i = start; i < nums.length; i++){

tempList.add(nums[i]);

backtrack(list, tempList, nums, i + 1);

tempList.remove(tempList.size() - 1);

}

}# Subsets II (contains duplicates)

https://leetcode.com/problems/subsets-ii/

public List<List<Integer>> subsetsWithDup(int[] nums) {

List<List<Integer>> list = new ArrayList<>();

Arrays.sort(nums);

backtrack(list, new ArrayList<>(), nums, 0);

return list;

}

private void backtrack(List<List<Integer>> list, List<Integer> tempList, int [] nums, int start){

list.add(new ArrayList<>(tempList));

for(int i = start; i < nums.length; i++){

if(i > start && nums[i] == nums[i-1]) continue; // skip duplicates

tempList.add(nums[i]);

backtrack(list, tempList, nums, i + 1);

tempList.remove(tempList.size() - 1);

}

} # Permutations

https://leetcode.com/problems/permutations/

public List<List<Integer>> permute(int[] nums) {

List<List<Integer>> list = new ArrayList<>();

// Arrays.sort(nums); // not necessary

backtrack(list, new ArrayList<>(), nums);

return list;

}

private void backtrack(List<List<Integer>> list, List<Integer> tempList, int [] nums){

if(tempList.size() == nums.length){

list.add(new ArrayList<>(tempList));

} else{

for(int i = 0; i < nums.length; i++){

if(tempList.contains(nums[i])) continue; // element already exists, skip

tempList.add(nums[i]);

backtrack(list, tempList, nums);

tempList.remove(tempList.size() - 1);

}

}

} # Permutations II (contains duplicates)

https://leetcode.com/problems/permutations-ii/

public List<List<Integer>> permuteUnique(int[] nums) {

List<List<Integer>> list = new ArrayList<>();

Arrays.sort(nums);

backtrack(list, new ArrayList<>(), nums, new boolean[nums.length]);

return list;

}

private void backtrack(List<List<Integer>> list, List<Integer> tempList, int [] nums, boolean [] used){

if(tempList.size() == nums.length){

list.add(new ArrayList<>(tempList));

} else{

for(int i = 0; i < nums.length; i++){

if(used[i] || i > 0 && nums[i] == nums[i-1] && !used[i - 1]) continue;

used[i] = true;

tempList.add(nums[i]);

backtrack(list, tempList, nums, used);

used[i] = false;

tempList.remove(tempList.size() - 1);

}

}

}# Combination Sum

https://leetcode.com/problems/combination-sum/

public List<List<Integer>> combinationSum(int[] nums, int target) {

List<List<Integer>> list = new ArrayList<>();

Arrays.sort(nums);

backtrack(list, new ArrayList<>(), nums, target, 0);

return list;

}

private void backtrack(List<List<Integer>> list, List<Integer> tempList, int [] nums, int remain, int start){

if(remain < 0) return;

else if(remain == 0) list.add(new ArrayList<>(tempList));

else{

for(int i = start; i < nums.length; i++){

tempList.add(nums[i]);

backtrack(list, tempList, nums, remain - nums[i], i); // not i + 1 because we can reuse same elements

tempList.remove(tempList.size() - 1);

}

}

}# Combination Sum II (can’t reuse same element)

https://leetcode.com/problems/combination-sum-ii/

public List<List<Integer>> combinationSum2(int[] nums, int target) {

List<List<Integer>> list = new ArrayList<>();

Arrays.sort(nums);

backtrack(list, new ArrayList<>(), nums, target, 0);

return list;

}

private void backtrack(List<List<Integer>> list, List<Integer> tempList, int [] nums, int remain, int start){

if(remain < 0) return;

else if(remain == 0) list.add(new ArrayList<>(tempList));

else{

for(int i = start; i < nums.length; i++){

if(i > start && nums[i] == nums[i-1]) continue; // skip duplicates

tempList.add(nums[i]);

backtrack(list, tempList, nums, remain - nums[i], i + 1);

tempList.remove(tempList.size() - 1);

}

}

} # Palindrome Partitioning

https://leetcode.com/problems/palindrome-partitioning/

public List<List<String>> partition(String s) {

List<List<String>> list = new ArrayList<>();

backtrack(list, new ArrayList<>(), s, 0);

return list;

}

public void backtrack(List<List<String>> list, List<String> tempList, String s, int start){

if(start == s.length())

list.add(new ArrayList<>(tempList));

else{

for(int i = start; i < s.length(); i++){

if(isPalindrome(s, start, i)){

tempList.add(s.substring(start, i + 1));

backtrack(list, tempList, s, i + 1);

tempList.remove(tempList.size() - 1);

}

}

}

}

public boolean isPalindrome(String s, int low, int high){

while(low < high)

if(s.charAt(low++) != s.charAt(high--)) return false;

return true;

} # 代码随想录

# 二分查找法

class Solution {

public:

int searchInsert(vector<int>& nums, int target) {

int n = nums.size();

int left = 0;

int right = n; // 我们定义target在左闭右开的区间里,[left, right)

while (left < right) { // 因为left == right的时候,在[left, right)是无效的空间

int middle = left + ((right - left) >> 1);

if (nums[middle] > target) {

right = middle; // target 在左区间,因为是左闭右开的区间,nums[middle]一定不是我们的目标值,所以right = middle,在[left, middle)中继续寻找目标值

} else if (nums[middle] < target) {

left = middle + 1; // target 在右区间,在 [middle+1, right)中

} else { // nums[middle] == target

return middle; // 数组中找到目标值的情况,直接返回下标

}

}

return right;

}

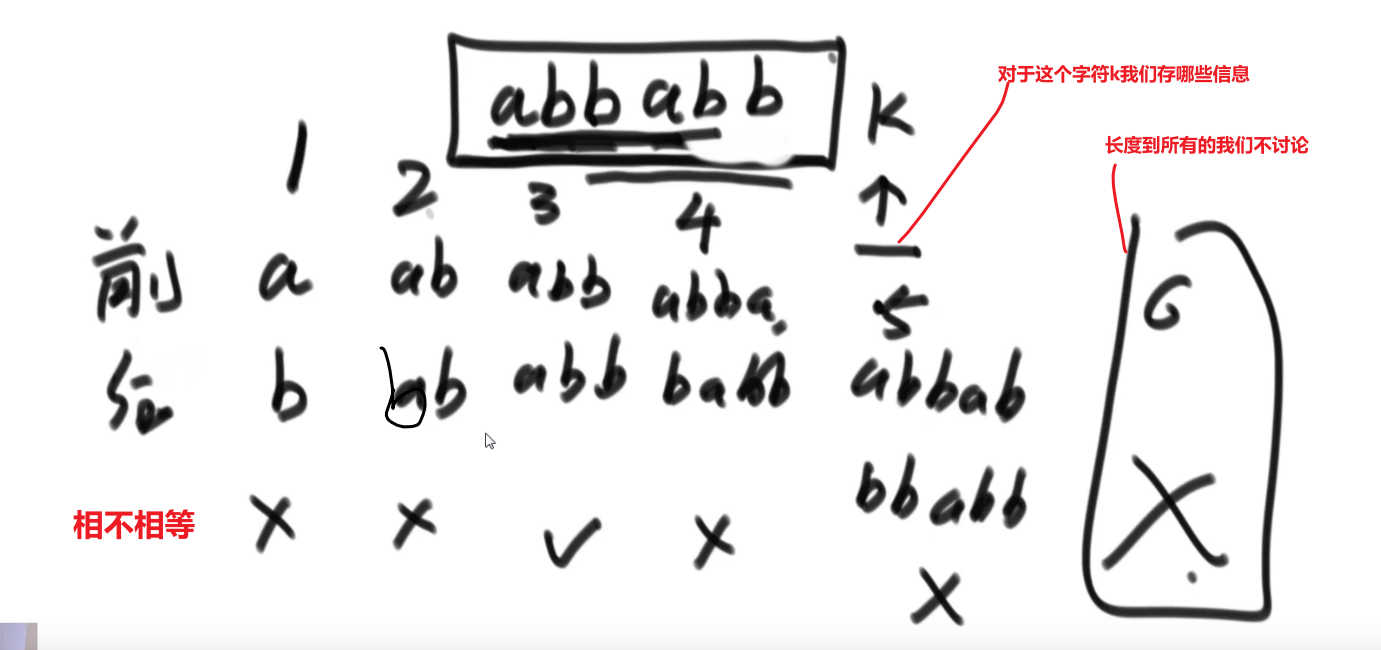

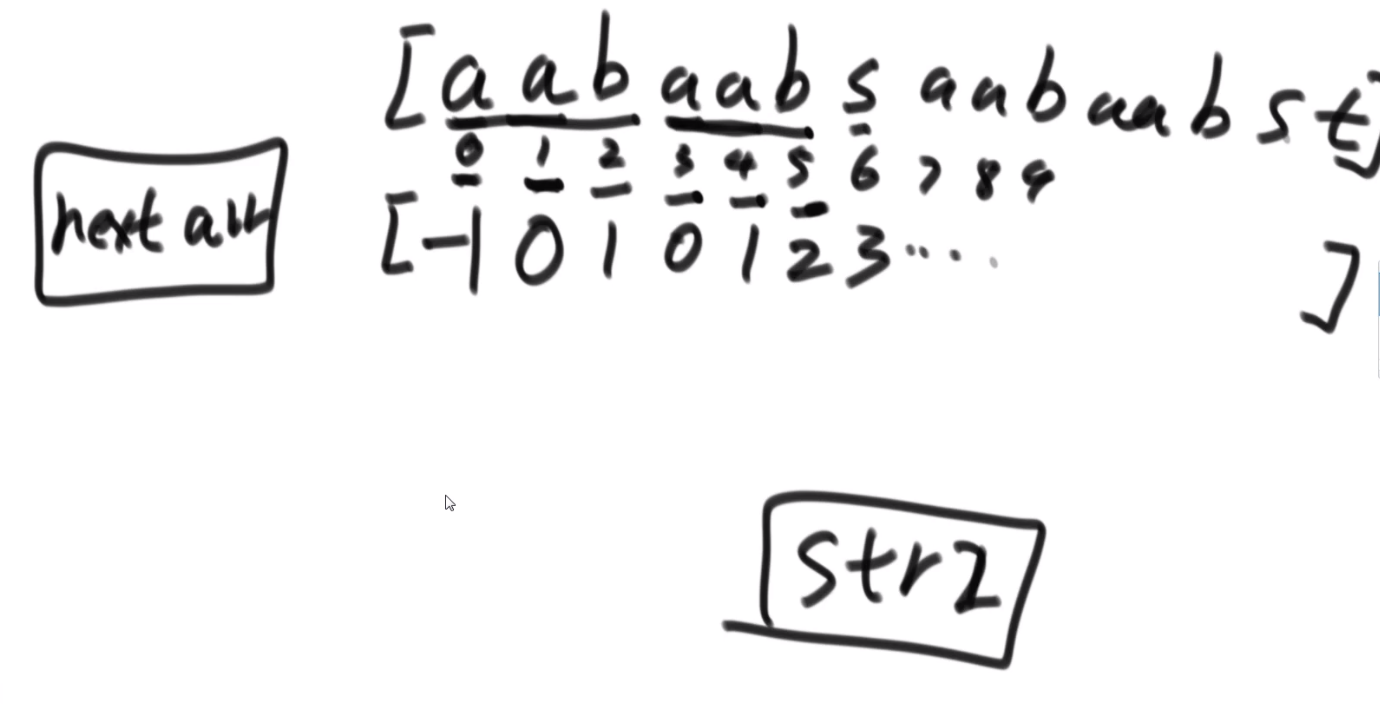

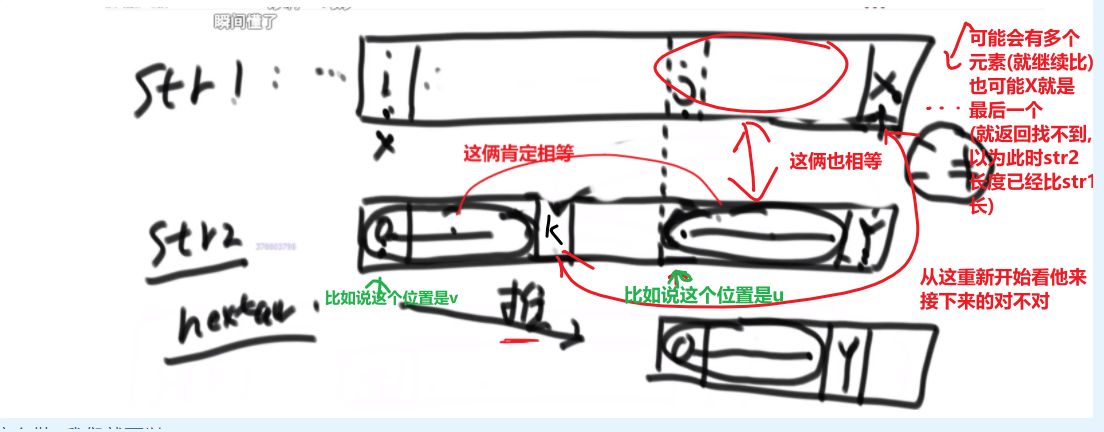

};# #KMP

void kmp(int* next, const string& s){

next[0] = -1;

int j = -1;

for(int i = 1; i < s.size(); i++){

while (j >= 0 && s[i] != s[j + 1]) {

j = next[j];

}

if (s[i] == s[j + 1]) {

j++;

}

next[i] = j;

}

}# #二叉树

二叉树的定义:

struct TreeNode {

int val;

TreeNode *left;

TreeNode *right;

TreeNode(int x) : val(x), left(NULL), right(NULL) {}

};# #深度优先遍历(递归)

# 前序遍历(中左右)

void traversal(TreeNode* cur, vector<int>& vec) {

if (cur == NULL) return;

vec.push_back(cur->val); // 中 ,同时也是处理节点逻辑的地方

traversal(cur->left, vec); // 左

traversal(cur->right, vec); // 右

}# 中序遍历(左中右)

void traversal(TreeNode* cur, vector<int>& vec) {

if (cur == NULL) return;

traversal(cur->left, vec); // 左

vec.push_back(cur->val); // 中 ,同时也是处理节点逻辑的地方

traversal(cur->right, vec); // 右

}# 后序遍历(左右中)

void traversal(TreeNode* cur, vector<int>& vec) {

if (cur == NULL) return;

traversal(cur->left, vec); // 左

traversal(cur->right, vec); // 右

vec.push_back(cur->val); // 中 ,同时也是处理节点逻辑的地方

}# #深度优先遍历(迭代法)

vector<int> preorderTraversal(TreeNode* root) {

vector<int> result;

stack<TreeNode*> st;

if (root != NULL) st.push(root);

while (!st.empty()) {

TreeNode* node = st.top();

if (node != NULL) {

st.pop();

if (node->right) st.push(node->right); // 右

if (node->left) st.push(node->left); // 左

st.push(node); // 中

st.push(NULL);

} else {

st.pop();

node = st.top();

st.pop();

result.push_back(node->val); // 节点处理逻辑

}

}

return result;

}# 中序遍历(左中右)

vector<int> inorderTraversal(TreeNode* root) {

vector<int> result; // 存放中序遍历的元素

stack<TreeNode*> st;

if (root != NULL) st.push(root);

while (!st.empty()) {

TreeNode* node = st.top();

if (node != NULL) {

st.pop();

if (node->right) st.push(node->right); // 右

st.push(node); // 中

st.push(NULL);

if (node->left) st.push(node->left); // 左

} else {

st.pop();

node = st.top();

st.pop();

result.push_back(node->val); // 节点处理逻辑

}

}

return result;

}# 后序遍历(左右中)

vector<int> postorderTraversal(TreeNode* root) {

vector<int> result;

stack<TreeNode*> st;

if (root != NULL) st.push(root);

while (!st.empty()) {

TreeNode* node = st.top();

if (node != NULL) {

st.pop();

st.push(node); // 中

st.push(NULL);

if (node->right) st.push(node->right); // 右

if (node->left) st.push(node->left); // 左

} else {

st.pop();

node = st.top();

st.pop();

result.push_back(node->val); // 节点处理逻辑

}

}

return result;

}# #广度优先遍历(队列)

vector<vector<int>> levelOrder(TreeNode* root) {

queue<TreeNode*> que;

if (root != NULL) que.push(root);

vector<vector<int>> result;

while (!que.empty()) {

int size = que.size();

vector<int> vec;

for (int i = 0; i < size; i++) {// 这里一定要使用固定大小size,不要使用que.size()

TreeNode* node = que.front();

que.pop();

vec.push_back(node->val); // 节点处理的逻辑

if (node->left) que.push(node->left);

if (node->right) que.push(node->right);

}

result.push_back(vec);

}

return result;

}# #二叉树深度

int getDepth(TreeNode* node) {

if (node == NULL) return 0;

return 1 + max(getDepth(node->left), getDepth(node->right));

}# #二叉树节点数量

int countNodes(TreeNode* root) {

if (root == NULL) return 0;

return 1 + countNodes(root->left) + countNodes(root->right);

}# #回溯算法

void backtracking(参数) {

if (终止条件) {

存放结果;

return;

}

for (选择:本层集合中元素(树中节点孩子的数量就是集合的大小)) {

处理节点;

backtracking(路径,选择列表); // 递归

回溯,撤销处理结果

}

}# #并查集

int n = 1005; // 根据题意而定

int father[1005];

// 并查集初始化

void init() {

for (int i = 0; i < n; ++i) {

father[i] = i;

}

}

// 并查集里寻根的过程

int find(int u) {

return u == father[u] ? u : father[u] = find(father[u]);

}

// 将v->u 这条边加入并查集

void join(int u, int v) {

u = find(u);

v = find(v);

if (u == v) return ;

father[v] = u;

}

// 判断 u 和 v是否找到同一个根

bool same(int u, int v) {

u = find(u);

v = find(v);

return u == v;

}# 个人看法

# 第一题

-

换个角度思考,比如说找两个数字相加会等于一个数字 (target), 也就是说找那个数字 (target) 减去其中一个数字的数字,这个样子我们可以固定一个数字 (比如说一个 for loop 的 i 每次 iteration 都是固定的) 然后去找 target-i.

-

注意数据结构,看要想干什么,是查询还是什么?查询用什么块?(数组遍历 O (N),hash table 约 O (1) 除非 worst case)

-

如果我们要按照一个数字找跟他相关的比如说这个数字在一个 array 里面的下标可以用一个 hash table (HashMap) 来存他们的 key value pair. 这个样子要是搜查 key (数字) 的时候可以通过他的 hash function 更快的查询到那个 key, 找到那个 key 也可以知道那个 key 的 value (下标) 了.

-

如果我们要把数据传到另外一个数据结构比如说 array to HashMap (hash table) 一般会用到一个 loop 然后挨个传进来,然后再进行操作,想想能不能在传的时候,在那个 loop 里面,直接在传每一个数据之前或者之后进行操作?

- 比如说我们要找像上面的说的 target-i, 必须要有一个数字是固定的 (就让我们这个 loop 本身的数字每个 iteration 的数字固定住), 然后还需要找 target-i. 我们可以直接看这个数字在不在这个新的数据结构里面 (这样就是查询可以像上面的说的用 hash table 更快), 如果已经有了就直接 return, 如果不在 再 把当前这个固定的数字给传进新的数据结构。接下来下一个 iteration 下一个数字固定住,找相对应的 target-i. 这么做是对的因为我们还是会把数据一个一个传进去,所以如果有复合需求的那两个数字在的话,在第一个数字当固定,另外一个数字因为还没放进去所以没有,但是当第二数字当固定,这前面的数字已经放进去了,那就会查到。如果没有复合条件的,那就不会有结果.

# 第二题

- 如果需要的是一个 linkedlist 的第一个 node (他的 next 会指向下一个然后 next 的 next 指向…so on), 不一定需要我们第一个就是那个第一个 node, 我们可以先暂时用一个不是第一个的 node (value 不一样) 来指向第一个 node, 然后返回的时候再

return node.next;就可以得到第一个 node - 如果 linkedlist 已经指向了结尾 (到了 null), 是不是可以认为 value 为 0 然后再继续.

- sum = number1 + number2 + carry(from previous number)

# 第 387. First Unique Character in a String

- 用一个数组,长度 26, 每一个都是存字符串里面出现哪个字符出现几次。比如说下标为 1 的就是‘b’-‘a’, 然后记录着‘b’这个字符出现了几次

- 之后返回哪个存的是 1 的下标对应的字符就行了

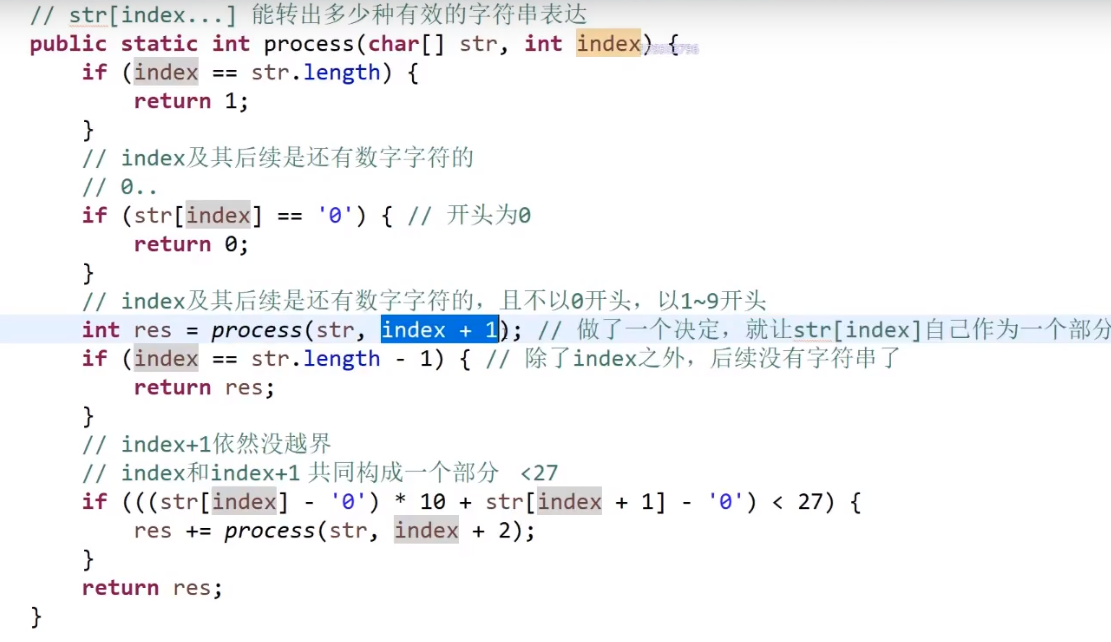

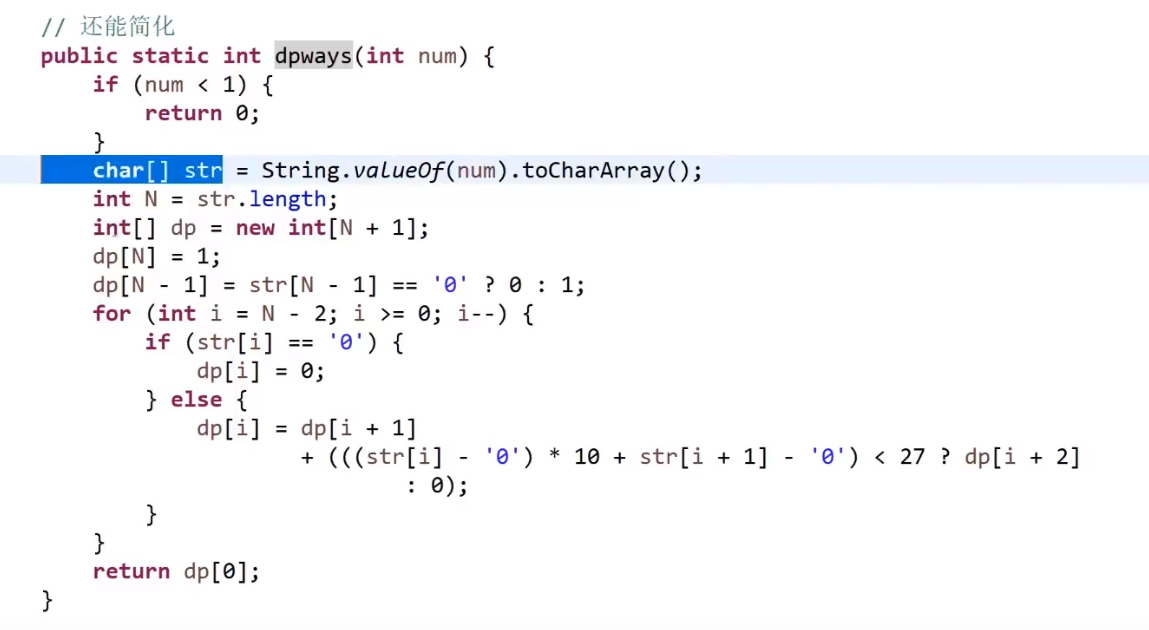

# 第 91. Decode Ways

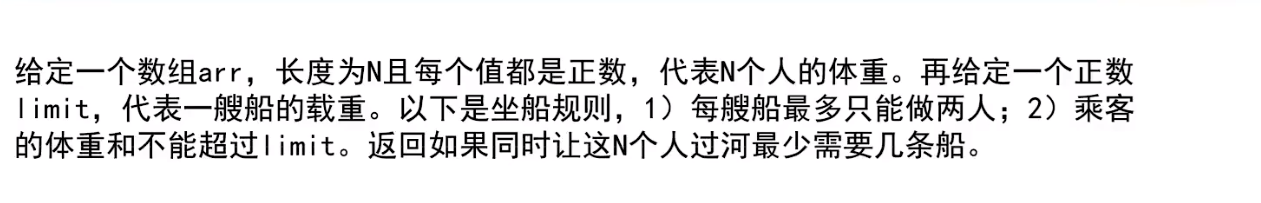

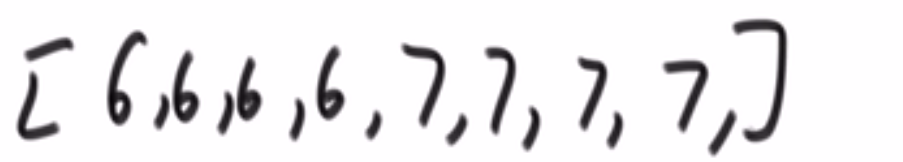

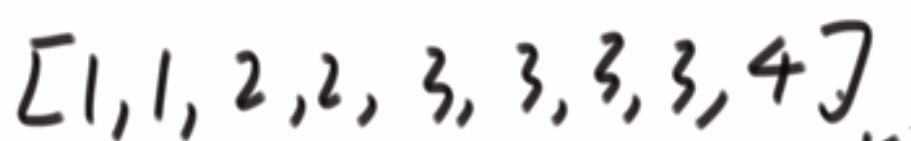

# 第 881. Boats to Save People

- 直接排序然后双指针 O (nlogn)

- 因为说了每条船两个人最多,所以双指针很合适

- 注意我这里用的 res++ 到处都是,其实可以改进,只需要记录双指针,只要 left<=right 就执行,之后其实我们靠 right 指针获取需要多少串,或许用个变量去 track

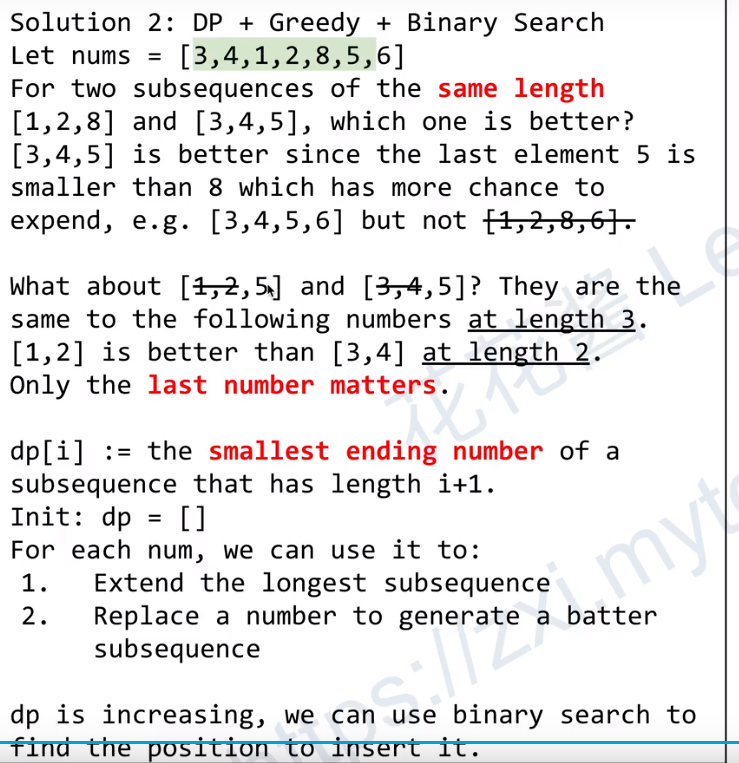

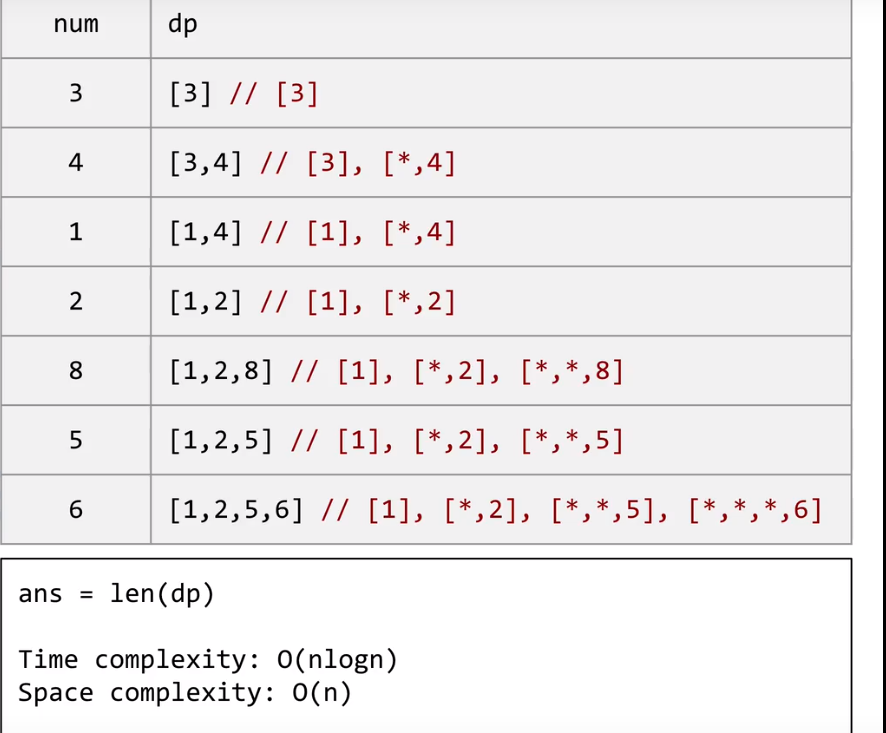

# 第 300. Longest Increasing Subsequence

序列问题

-

brute force 的话会是所有 subsequence, 这个复杂度为 2n-1 (跟求一个字符串的所有 subset 差不多一样)

-

dp 方法,就是创建一个数组,数组每一个元素代表原数组中当前元素为结尾的最长合法的数组序列长度,最后答案就是 dp 里面最大值,是 O (n2) 因为需要 dp 里面每一个元素都需要往之前的元素找最大的值,才可以知道自己的最大值可以是多少

做法就是两个 for loop, 每一个元素,我们一开始把 dp 对应位置设置为 1, 然后接着 for loop 看 dp 数组里面这个位置之前有多少个比这个小的,每一次遇到就让当前他的值跟那个值 + 1 (代表他自己) 比较,之后要是又遇到了个小的,会接着比,这是因为这个数字存的当前数字作为结尾的数字序列最长长度不一样比后面的数字存的当前数字作为结尾的数字序列最长长度小,因为那个后面的数可能比自己这个数还要小 (但确实是符合那个比我们当前到了的 i 位置的数字要小)

期间我们没处理完一次 dp [i] 我们就查看一下,反正就是保存最大的 dp [i] 值就是答案

注意这个 dp 数组的作用,是记录每一个数作为数字序列结尾的最长长度是多少

-

dp 加 binary search

在这里,dp [i] 存的值代表 i+1 长度的序列中,结尾最小的元素是什么

- 如果当前数是大于我们 dp 数组此时存的最后一个数 (比如说 x 位置), 那直接把当前数加到 dp 数组 (x+1 位置), 说明我们现在 so far 处理的合法的最长数组序列长度增加了一个,然后这个长度最小的元素也就是我们这个新加的

- 如果当前素是小于或者等于我们 dp 数组此时存的最后一个数 (比如说 x 位置), 说明我们之前处理的那些位置有一个位置,有可能被换成当前这个数 (只有这个数比那个数也小的话), 代表当前数才是作为那个长度合法的最长数组序列的最后一个元素是最小的,他能换哪个?他能换当前 dp 数组第一个比他小的 / 或者是跟他数一样的 (dp 数组很明显是升序排序的), 我们可以用 Array.binarySearch 找到那个数 (这个系统函数如果找不到你要找的数,就会返回一个负数,然后你把返回的负数 - 1 然后再 - 1 就是那个第一个比我们找的数要大的数的下标! 新东西!学到了!!!*), 然后把当前数替代那个数

- 之后处理完所有数,答案就是我们的 dp 数组的长度 (如果用的是 arraylist, 如果是数组的话用变量记录什么的就行了)

# 第 94. Binary Tree Inorder Traversal

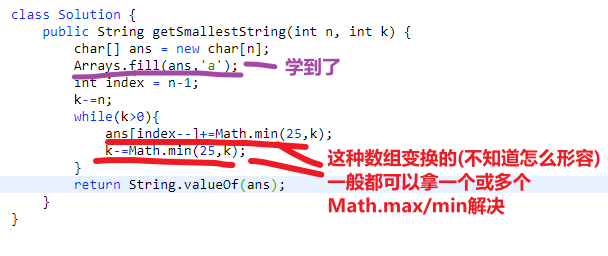

# 第 1663. Smallest String With A Given Numeric Value

- 用一个字符数组,n 的大小,一开始直接设置为全是 a, 然后让 k 值 - n*1

- 之后只要 k 还要比 0 大,就需要把字符数组 (从最后一个开始往前) 变成 z 或者变成 k 值哪个更小边哪个 (可以用 char 直接加 Math.min (25,k))

- 然后当然把 k 更新,就是减去 Math.min (25,k)

- 之后就是 while 循环检查 k 是不是还是大于 0 等等

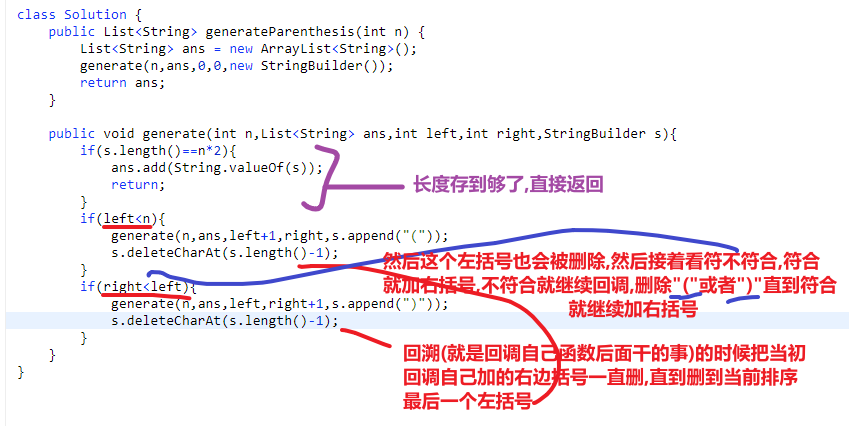

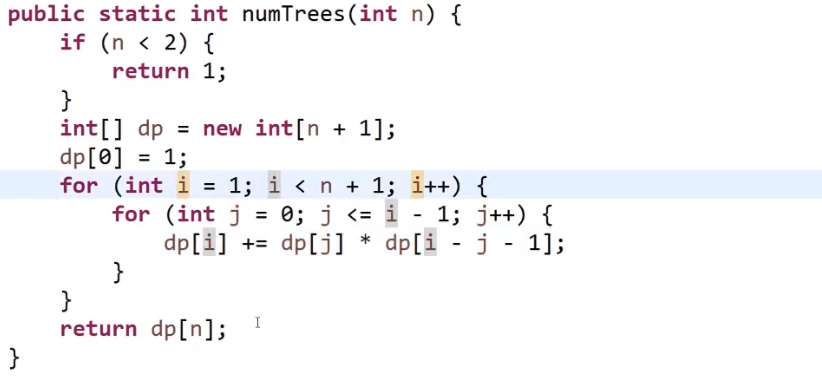

# 第 22. Generate Parentheses

- 回溯方法就是传一个 list 用来存每一个答案,然后每个答案就用 stringbuilder

- 回溯函数还有 max,open 代表当前层穿件来的 sb 有多少左括号,close 代表当前层穿件来的 sb 有多少右括号

- 我们当前 sb 等于 max*2 的话代表找到一个直接加入到 list 里面去

- 否则如果我们左括号加的数量没超过 max 数量我们就一直加,加完回调自己

- 我们右括号在下面,只有右括号没有超过左括号数量时,我们才让右括号增加,然后回调自己

- 每次右括号加完回调完自己都会先经过左括号的判断看看当前层符不符合那个小于 max 的情况

- 注意!!!

- 我们左边在最后是需要清除掉最后一个加的!!!这么做了才能创造其他的可能性

- 我们右边在最后是需要清除掉最后一个加的!!!这么做了才能创造其他的可能性

相当于我们对于当前刚加完的左括号数做完回调之后我们我们把改层加的这个左括号从 sb 去掉,然后再试试加右边括号等等等

同理,我们右边的刚加的可能也需要去掉,这样才有其他的可能性

可以这么想:

- 每一次的排序都是靠着你 ** 所有左边括号 (中间还有可能夹着几个右括号)** 怎么放的,然后对于每种包括着所有左括号之间的排序,我们可以对剩下的 (没被包括住的右括号), 进行增加,一直增加到合适长度就把结果放入 list 里面去

- 因为当前的结果已经放回到 list, 然后就会 return, 一层一层往回走,因为我们之后放的右边括号 (这个判断在下面), 我们在返回的时候就把我们当初一个一个加的右括号从 sb 里面删除

- 直到回溯到我们那个保存的排序的最后一个左括号也被删除了,就会接着往下看此时的 sb 符不符合那个下面加右括号的 if, 如果符合就会添加,此时这个左括号相当于是被之后再加了,等等

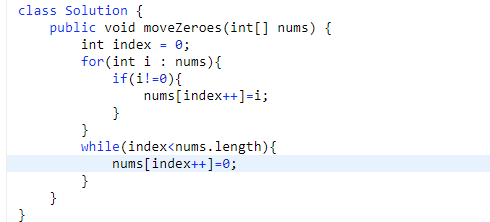

# 第 283. Move Zeroes

- 第一次遍历,保持自己的一个 index, 然后只有当前数组数不是 0 就把放到自己维持的 index 上

- 之后从自己的 index 数到数组长度位置都是 0

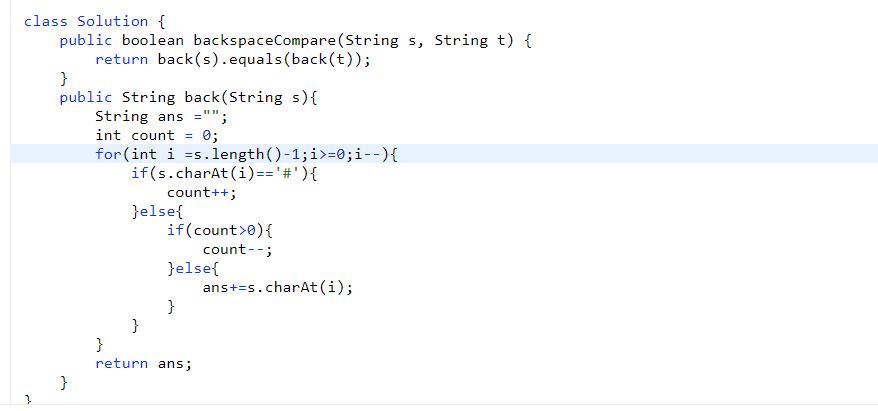

# 第 844. Backspace String Compare

- 从每一个字符串后面开始生成字符串,如果是 #就增加 count

- 要不是 #的话那么只有在 count 为 0 的时候才可以加到字符串

- 为 s 生成字符串,为 t 生成字符串,之后比较他们相不相等就行了

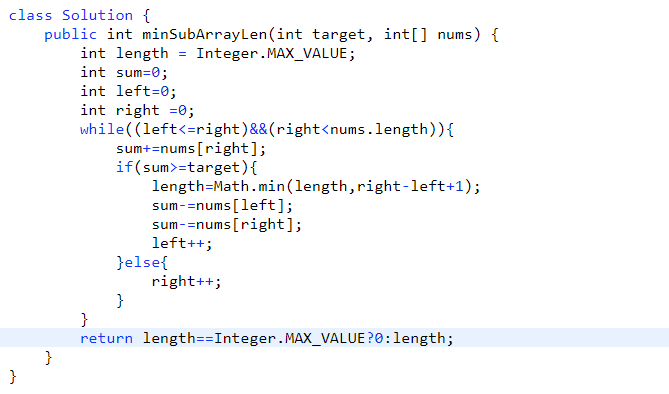

# 第 209. Minimum Size Subarray Sum

- 滑动窗口,规矩定好 (loop 然后里面 if 的更改情况)

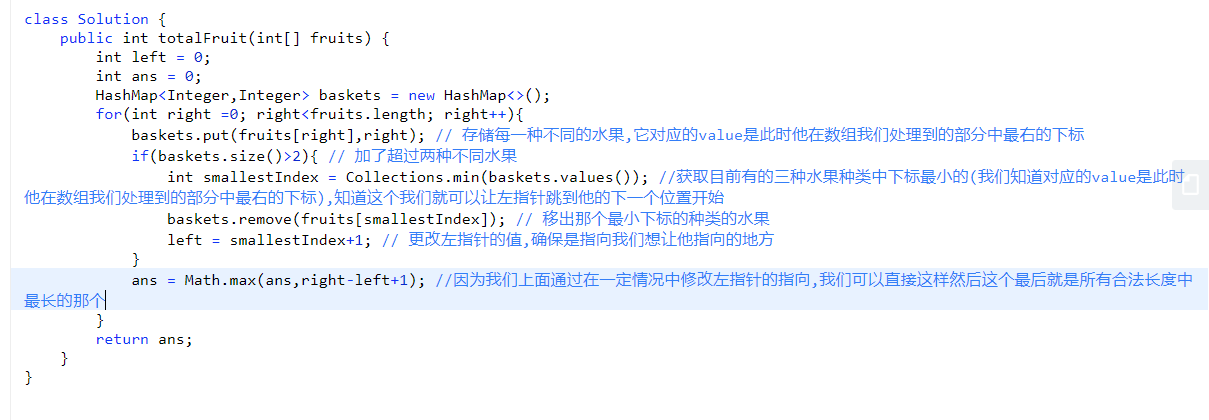

# 第 904. Fruit Into Baskets

- 滑动窗口

- 让左指针直接跳到一个位置

- right-left+1 代表目前窗口长度

- right 不一定要停啊等等等

# 算法课

# 异或

# 异或换值

给两个变量的值换过来:

a = a^b

b = a^b

a = a^b注意 a 和 b 可以是一样的数字等等等,但是不可以是同一个,比如说数组里面 a 和 b 不能代表同一个元素

# 异或算一个不一样的

数组有一个数字出现了奇数次,其他的数都是偶数:

int xor = 0;

for (int i =0; i<nums.length; i++){

xor^=nums[i]

}最后 xor 会等于那个出现奇数次的,出现偶数次的数都被自己消除掉了

- 0^N=N

- N^N=0

- a^b=b^a

- a^b^c=a^(b^c)

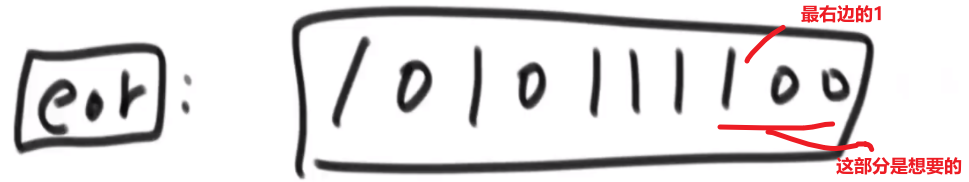

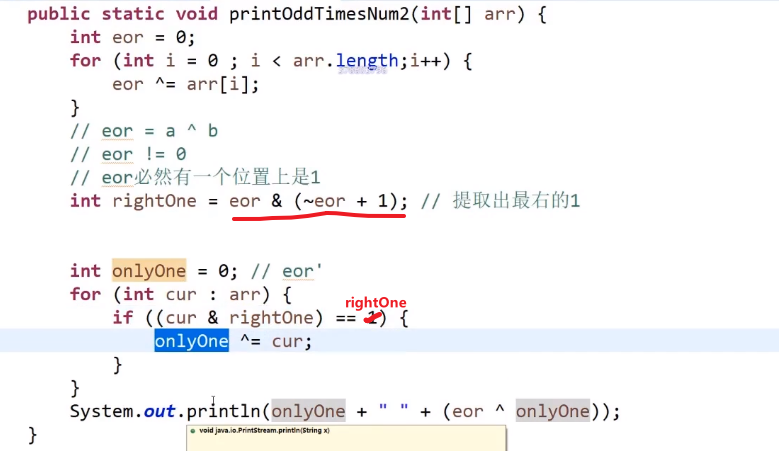

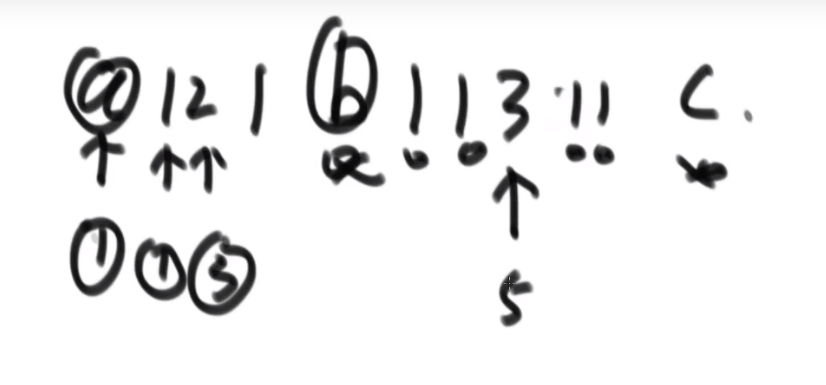

# 异或算两个不一样的

数组有两个数字出现了奇数次,其他的数都是偶数:

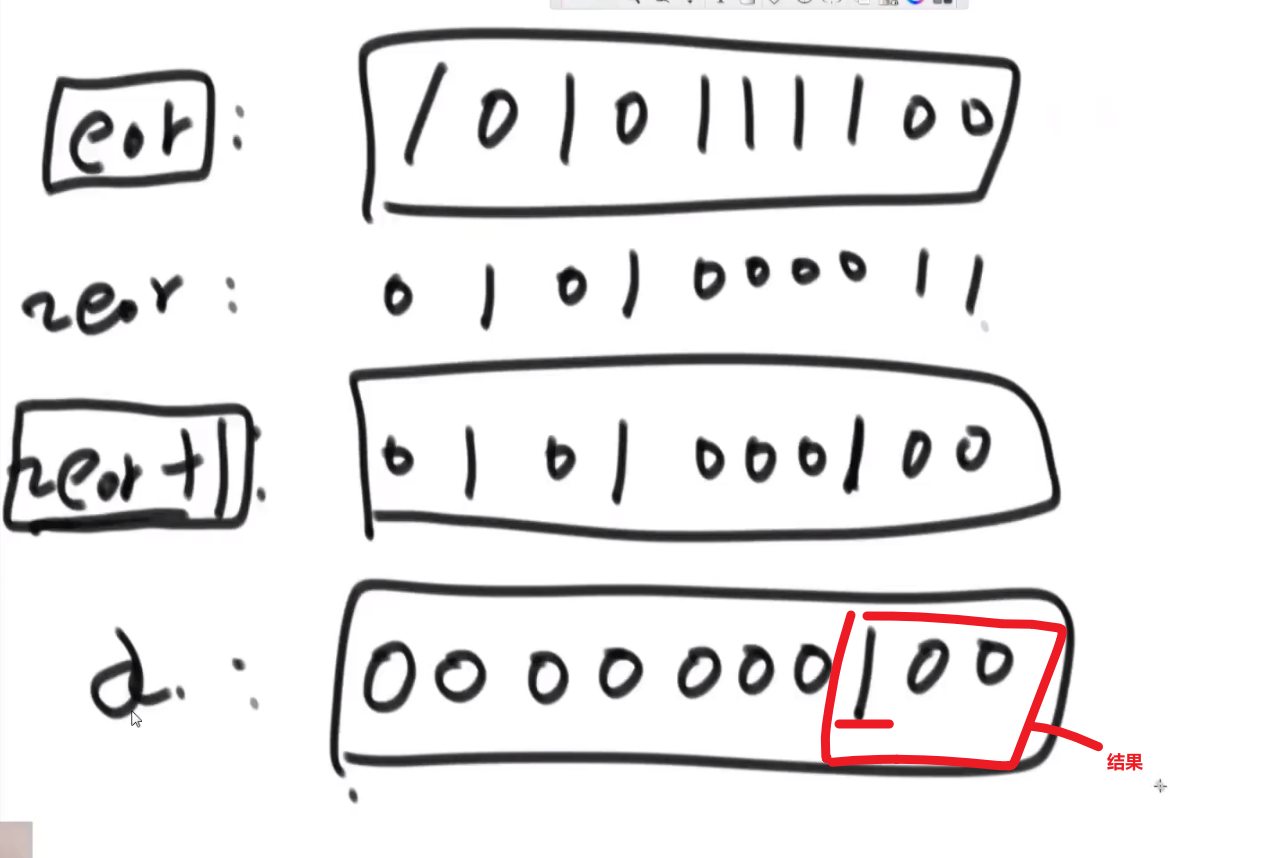

- 我们还是一个奇数次的做法先得到 xor, 那两个出现奇数次的数字 (比如说 a 和 b) 最后 xor 会等于 a^b

- 因为这两个数不一样,所以把他们转换成二进制他们肯定会在某一位上有一个是 0 有一个个是 1

- 0^1=1, 所以 xor (=a^b) 在那个位上也会是 1, 所以我们可以把 xor 的二进制最右边的数字部分获取出来

我们可以使用

eor & (~eor + 1)这个能提取出这个数 (eor) 的二进制最右边的 1 的数字以及后面转换成十进制的数字

- 我们有了这个数后我们就可以声明一个新变量 xor2 再次遍历数组,然后只有那个元素的结尾那几个我们上面取出来的几位二进制一样才可以让 xor2^= 那个元素 (使用

&判断就行,这个是 bit by bit, 这个细节比较多 (自己去查), 注意只是一个&!!!) - 就算我们这个判断可能会让别的数也判断对,但那也是对于出现偶数次的数,我们知道另外一个出现奇数次的数字不可能在这个对应二进制位置上是一样的 (我们当前这个数的最右边的二进制为 1 的位置在另外一个出现奇数次的数字在那个位置肯定会是 1, 所以我们 xor 的结果在那个二进制位置也才可以是 1)

- 这样我们相当于是给那两个出现奇数次的元素给分成两个组了,然后出现偶数次的不同数字随便分,反正他们会自己消灭自己的 (异或就是这样的)

最后 xor2 得出的就是要么是 a 要么是 b, 我们再 xor^xor2 就可以获得另外一个数字了

# 排序

# 冒泡排序

- 遍历数组

- 每次遍历让所有的元素 (除了最后) 跟下一个元素比,如果出现 inversion 就换过来

- 每次 outerloop 遍历就会让当前没有 sorted 部分找出一个最大元素放到正确的位置上 (被换到那)

不管什么输入都是固定操作,除了最好 case 不需要换的操作

# 选择排序

- 遍历数组

- 每次遍历都要遍历数组没有 sorted 部分找到当前最大 / 最小元素放到正确的位置上

不管什么输入都是固定操作

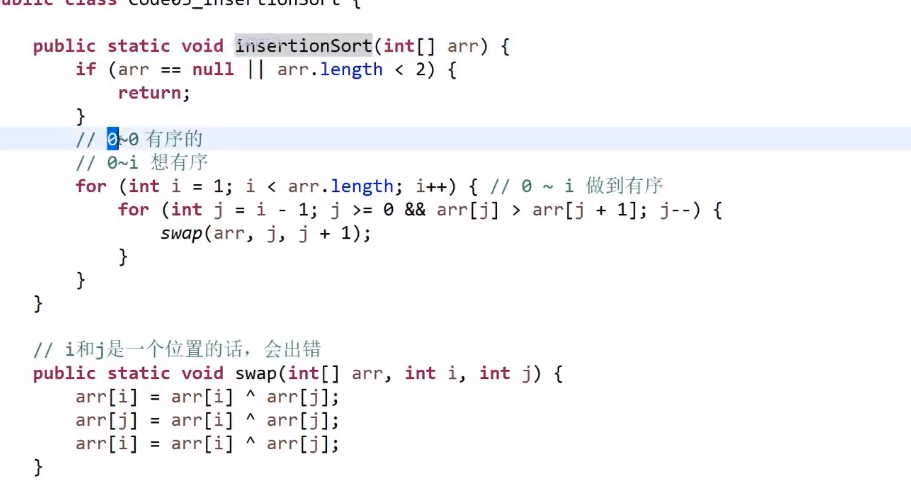

# 插入排序

- 遍历数组

- 首先做到 0-0 有序,这个很明显本身就做到了

- 接着我们要做到 0-1 有序,所以先看在 1 号元素

- 如果比前一个小就交换,交换完了再看前面有没有要交换的了,(前面没数了,也挺了), 我们此时做到了 0-1 有序

- 如果比前一个大,不需要交换

- 接着我们要做到 0-2 有序,所以先看在 2 号元素

- 如果比前一个小就交换,交换完了再看前面有没有要交换的了,一直换到对的地方

- 如果比前一个大,不需要交换

- 接着我们要做到 0-3 有序,所以先看在 3 号元素

- 如果比前一个小就交换,交换完了再看前面有没有要交换的了,一直换到对的地方

- 如果比前一个大,不需要交换

… 最终我们做到了 0-nums.length-1 有序了

这个不像冒泡排序和选择排序是固定操作,如果给的就是有序的,那就比一比就完成了所以会是 O (N), 但我们说时间复杂度都是 worst case 所以还是 O (N^2)

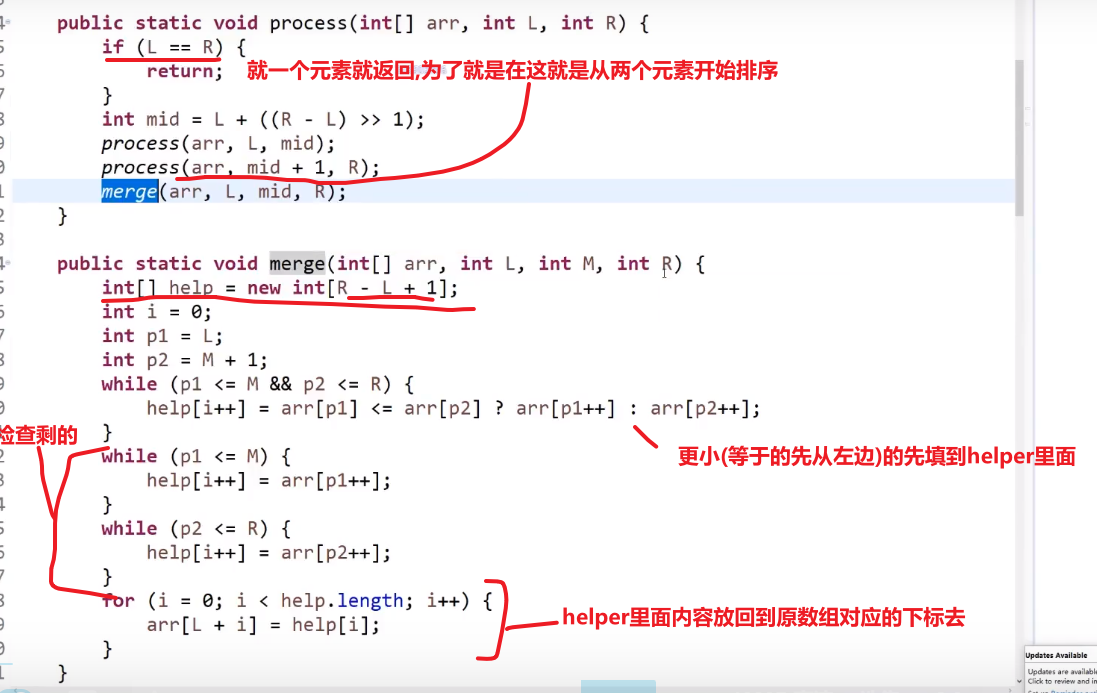

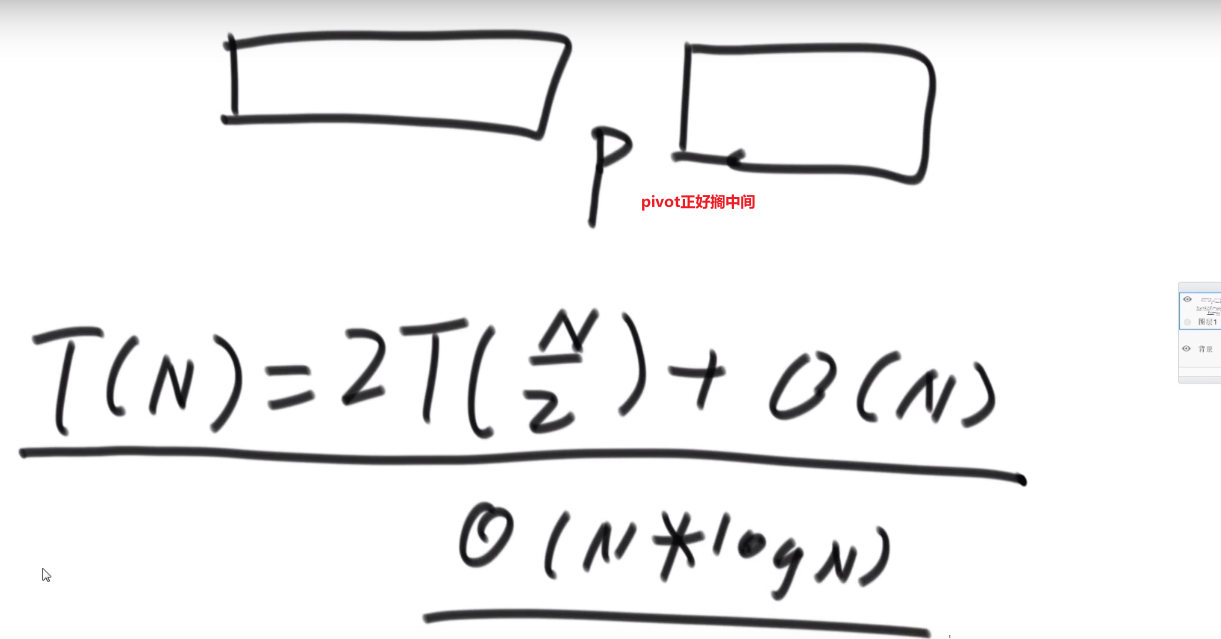

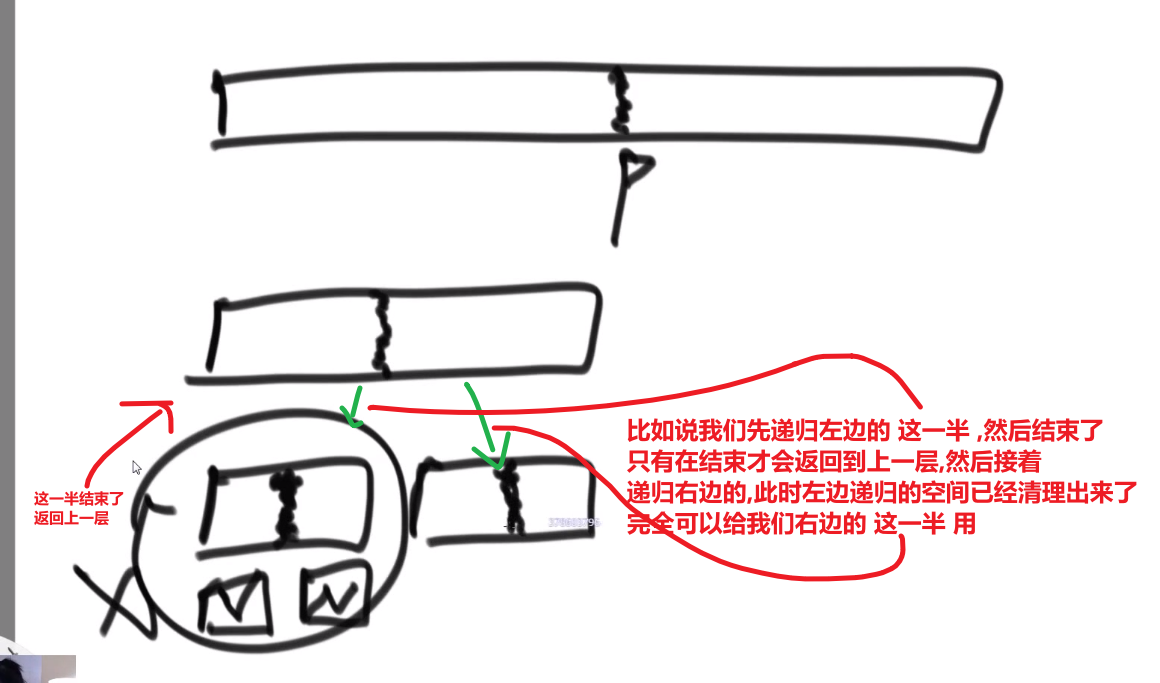

# 归并排序

- 找到当前中心点 mid

- 调用自己排序 left 到 mid

- 调用自己排序 mid+1 到 right

- 然后就 merge (需要一个 helper array 当工具人,然后需要考虑要是 merge 的某一边没清理干净,还有剩的)

空间复杂度就是那个 helper 数组,每次递归就会用到然后用完就没了会被垃圾回收器自动清理,注意这个并不是在递归里面产生的数组,那就不一样了,要是是在递归可能就不是 O (N) 空间复杂度了,merge 不是递归操作

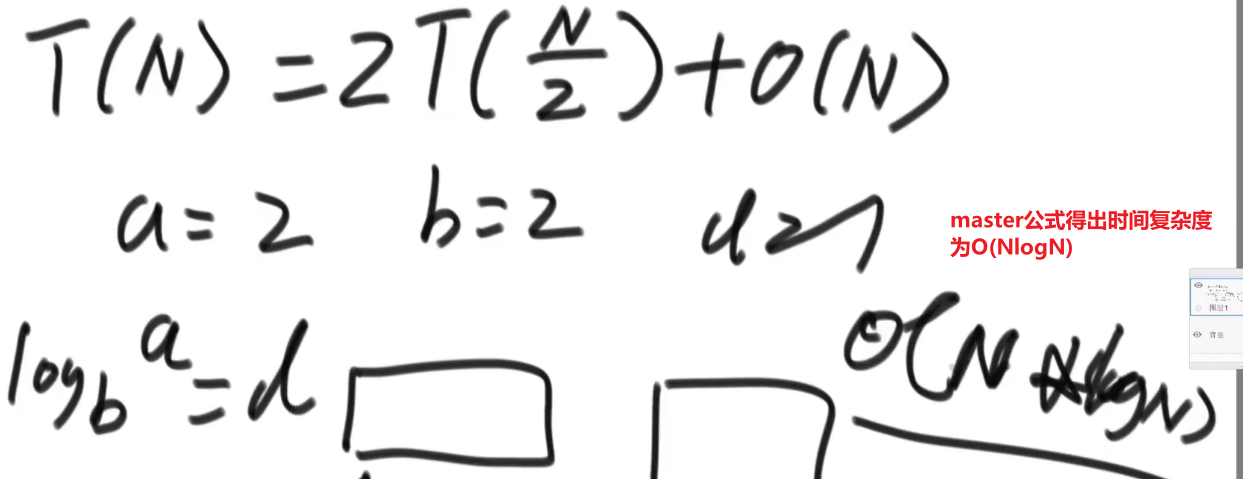

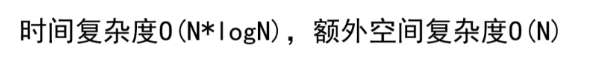

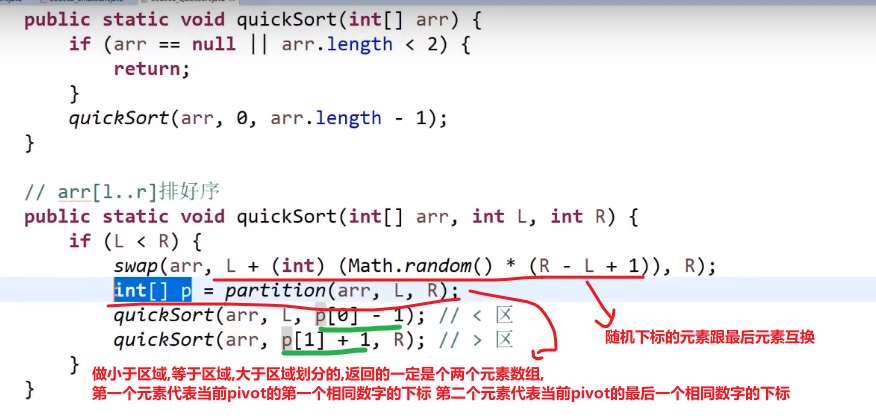

# 快速排序

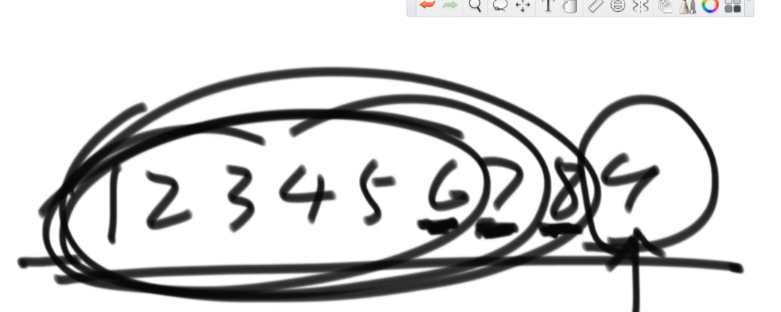

快排 3.0 (1.0 和 2.0 参考别处,这里直接讲 3.0)

- 就是随机选一个数组中的数字把他放到数组最后面

- 接着让这个数字按照我们那个荷兰国旗问题解决方式一样,让小于这个数组放左边, 等于这个数字放中间,大于这个数字的放右边

- 然后把最后这个元素换到大于区域的当前 k 下标也就是大于区域第一个数,我们把这个数放到这就是可以让他和他一样的数 (如果有) 贴贴

- 接着直接调用自己递归,对当前的小于区域和当前的大于区域重复上面的操作,这就会让__每一个元素__他的左边就是比他小的,他的右边就是比他大的

我们这里使用荷兰国旗问题解决方式,那个等于区域就相当于如果有一些数字和当前数字一样,完全没有必要让他们在进行什么操作,直接拍一块,然后操作小于这个数的和大于这个数的就行了,就相当于一次可能处理了多个数,也有可能就处理了一个 (如果这个数字在这个数组里面是 unique 的)

注意如果不使用随机数字当做 pivot, 那么时间复杂度就是 O (N^2) 因为这个就是针对于 worst case, 所以要是固定选一个位置的当做 pivot 肯定他的 worst case 就是 O (N^2)

比如说固定从最后一个数当做 pivot:

最好情况是

我们使用随机选的,都是概率事件,最后按照数学结论就是 O (Nlog (N)), 所以我们快排都是随机挑的 pivot (或者其他的等等等)

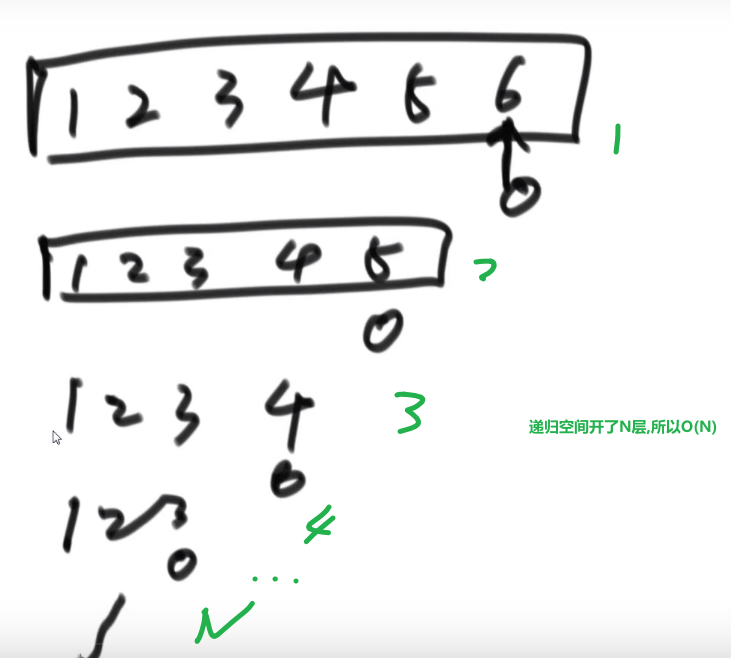

如果不是随机 (或者什么奇特的方法) 找 pivot 那么最差情况是 O (N)

如果好情况,或者就是随机也可以,那么空间复杂度就是 O (logN)

可以看到,就是类似于二叉树的展开

注意空间复杂度在递归的计算方法!!!这根我之前想的不太一样哈

可以理解为最大需要的额外的空间

我们是否可以使用非递归方式写快排,是不是可以省掉这个空间呢?不行!

这是因为我们快排实际的 partition 我们是不知道划分成什么样的,我们是跟实际状况的,有个小于区域,有一个等于区域,有个大于区域,就是因为我们这些数据状况 (到底每一层被划分成什么样子) 我们不知道,我们需要看实际状况,所以才需要记录这些区域的中点位置

就好比我们当前需要递归左边的小于区域,我们去执行压栈… 然后把小于区域执行完成了,我们返回到了这一层,我们此时需要递归右边的大于区域,但我们怎么知道这个大于区域到底是哪部分?当然是靠我们压栈保存这些中点信息,有了每一层的中点细,我们才可以按照那个中点信息 (那个下标), 来找到右边的大于区域然后递归他

所以就算自己写,自己写让他压栈,也照样是保存那个数据,所以那个空间是省不了的!

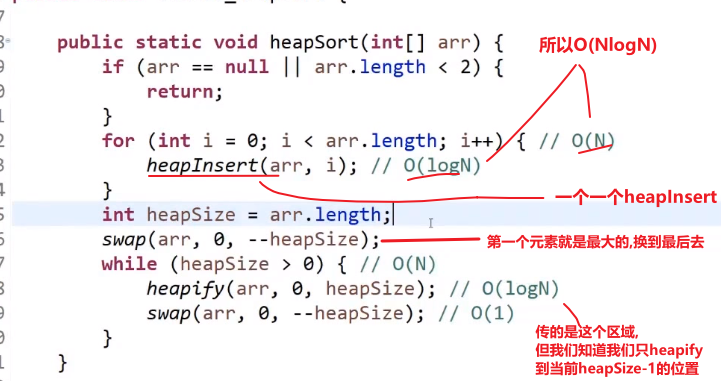

# 堆排序

一个一个数字传进来的 heap insert

-

首先有数组,然后 heapSize 一开始是 0, 这个就是数组中现在几个数是我现在的堆

-

先接收第一个数字 (注意这样就是一个一个传的,而不是整个直接给你让你变成大根堆)

-

把那个数字放到我们 heapSize 现在的值的下标位置上,heapSize++, 现在我们数组中有一个数是我们的大根堆

-

接着把下一个数字放到 heapSize 现在的值的下标位置上,heapSize++

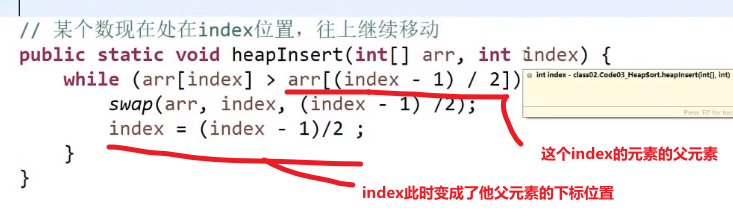

现在看这个放的数字的位置会是第一个的子孩子,所以要看现在还是不是大根堆,也就是当前数字有没有他父亲大 (他可以靠 (i-1)/2 下标算出他父亲的下标)

- 如果没有父亲大或者等于,那就直接下一个

- 如果有父亲大,那就 bubble up (注意要是比当前父亲大,然后互换了,需要继续比较看换了后比那个时候的父亲是不是更大,如果还是更大,那就需要继续换,这个就是 bubble up 或者 heap insert)

-

把一个一个传进来的数字都这么操作放入数组中,然后当结束时 heapSize==nums.length

-

我们已经有了一个大根堆结构

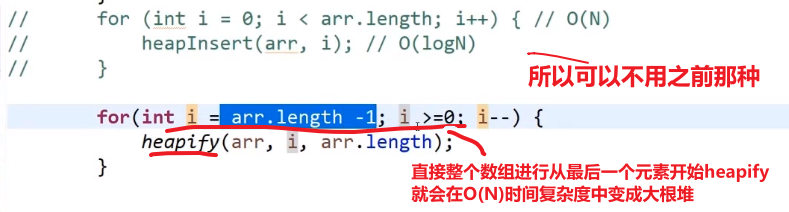

** 如果直接让我们对一个数组变成一个大根堆,而不是一个一个元素 heap insert, 用这个方式!!!**

修改我们的 heapSort 里面的方法,就是不用 heap insert, 而是从最后一个元素使用 heapify

使用这个这个更快!!!时间复杂度比一个一个 heap insert 更低 (虽然之后一个个元素放到正确位置然后进行 heapify 还是占大头 O (NlogN) 所以 overall 还是 O (NlogN) 时间复杂度)

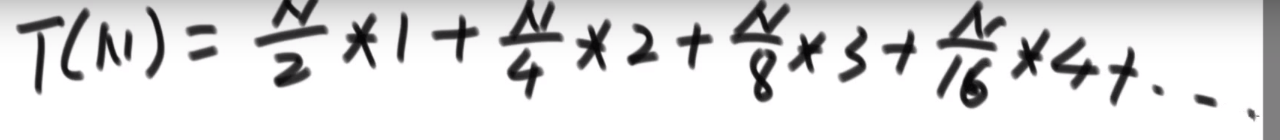

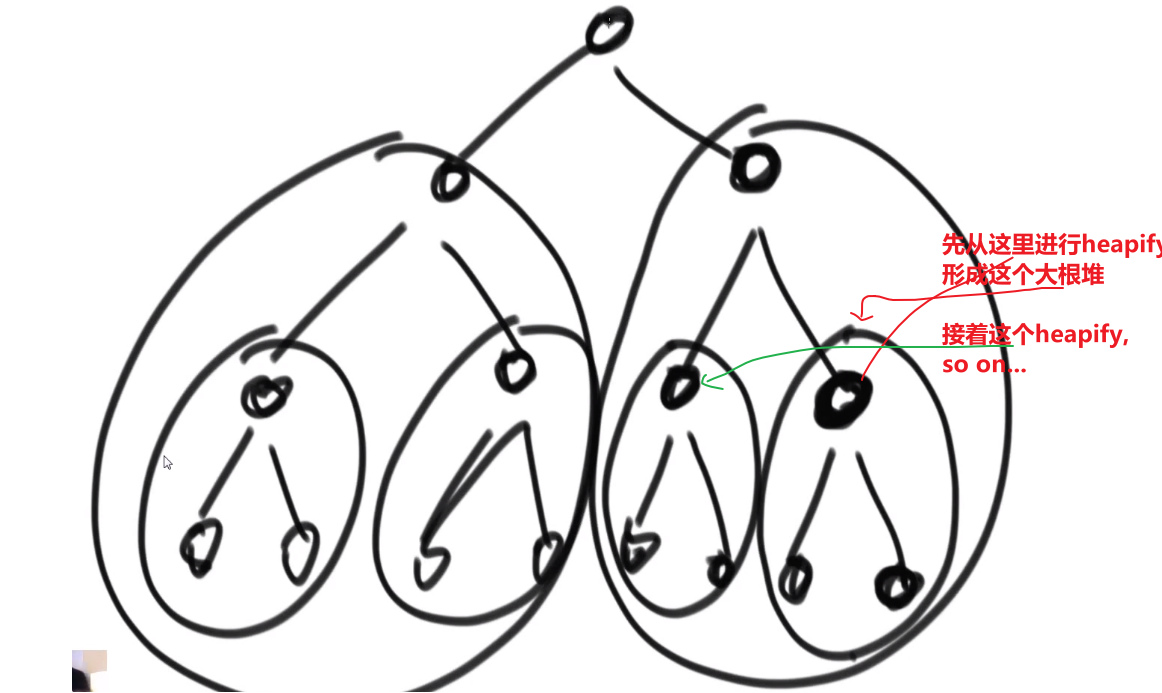

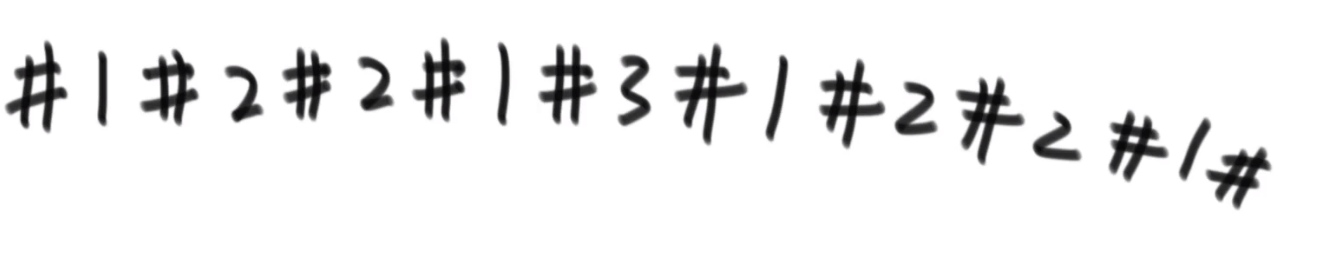

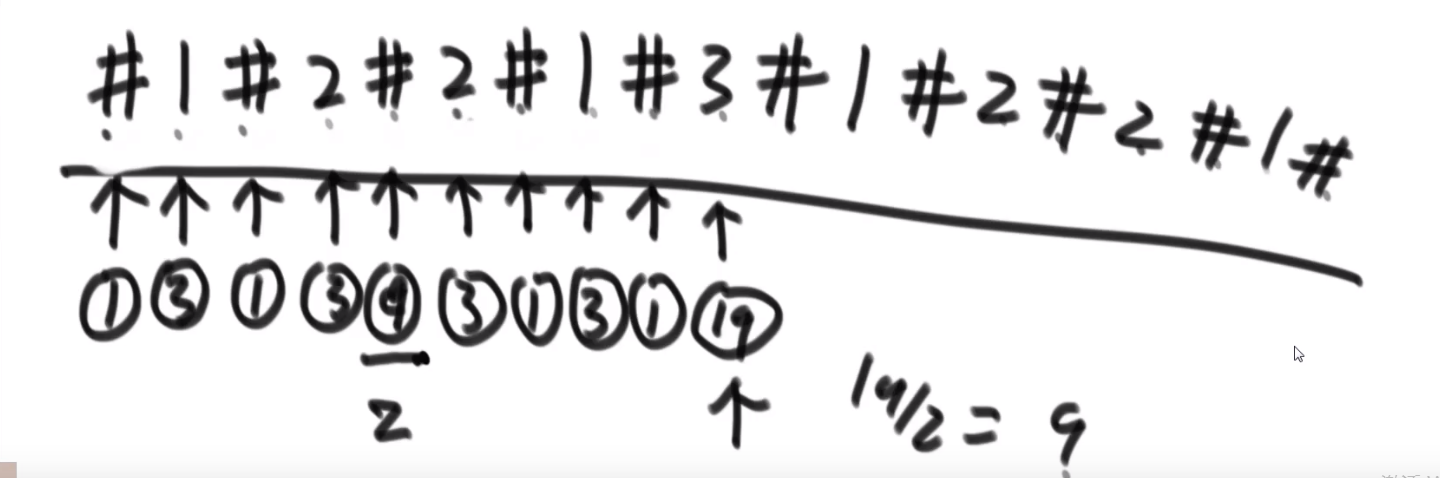

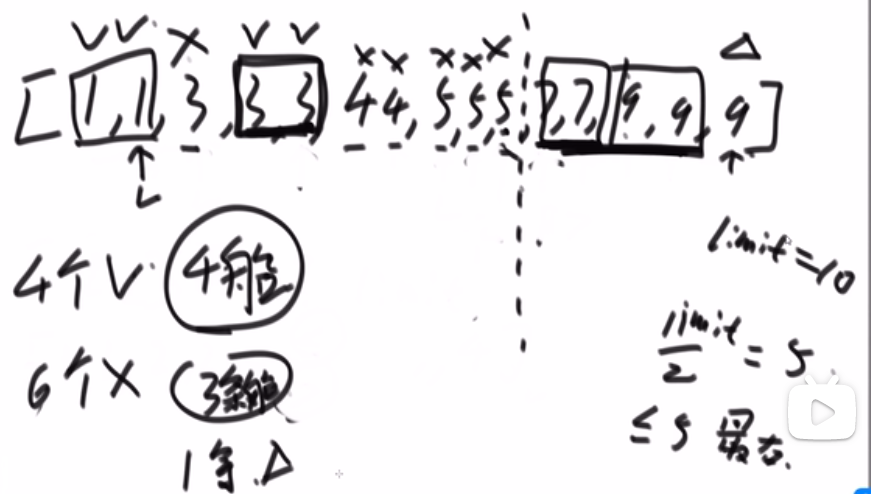

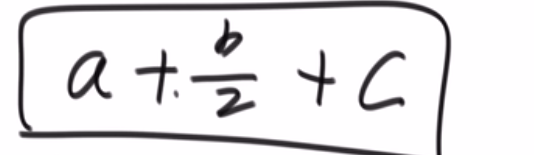

其实这么做更好,比一个一个进行 heap insert 形成大根堆要更好,这是因为:

- 首先如果 N 个元素,那么差不多会有 N/2 个 leaf node, 每个 leaf node 进行 heapify 操作,因为他下面什么都没有,所以假设只是看了一眼,所以就是 1

- 如果 N 个元素,那么差不多会有 N/4 个倒数第二层的节点,每个那一层节点进行 heapify 操作,最多只是看一眼然后移动一步,所以就是 2

- 如果 N 个元素,那么差不多会有 N/8 个倒数第三层的节点,每个那一层节点进行 heapify 操作,最多只是看一眼然后移动一步然后再看一眼再移动一步,所以就是 3 (其实应该是 4, 但就差不多,这些大概理念)

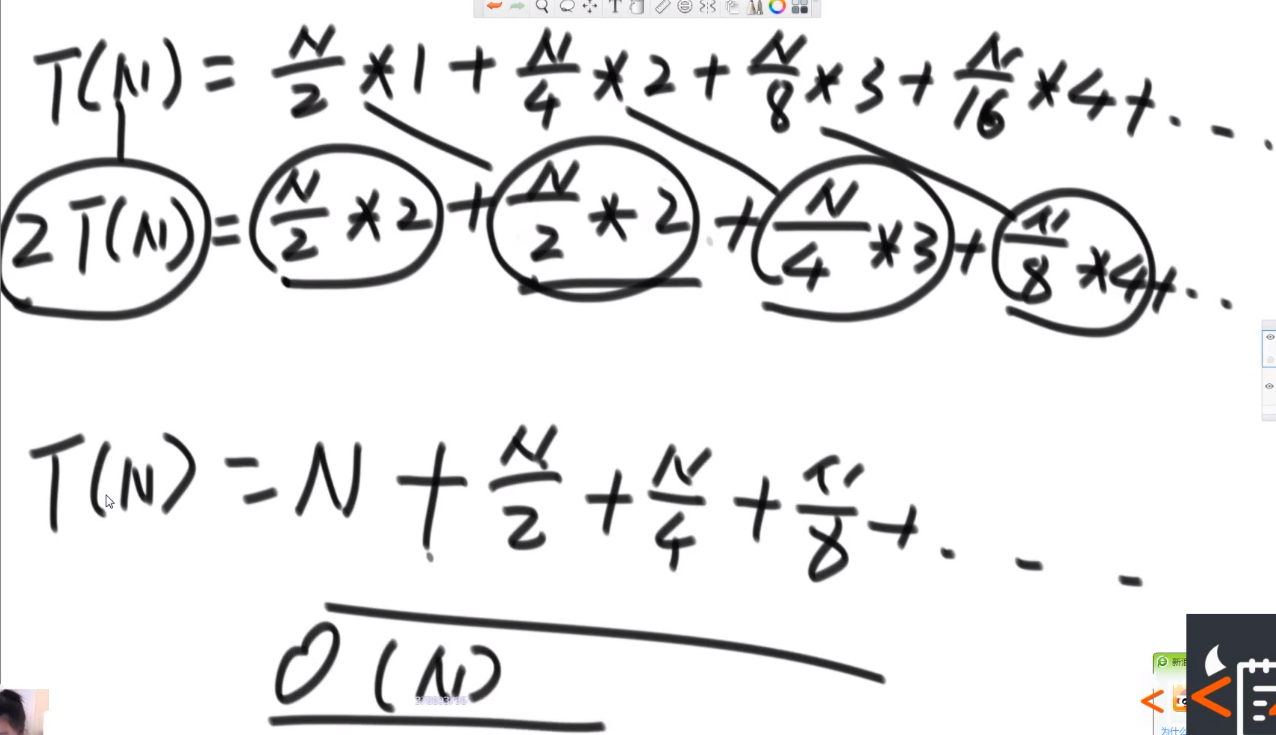

所以整体复杂度:

我们可以解开:

__== 所以如果我们直接整个数组变成堆,而不是一个一个元素 heap insert (复杂度 O (NlogN)), 那么我们复杂度只需要 O (N) 了!!!==__

不过之后一个个元素放到正确位置然后进行 heapify 还是占大头 O (NlogN) 所以 overall 还是 O (NlogN) 时间复杂度

- 把每一个子树变成一个大根堆,这样子整个都会是个大根堆

其实从这个数组最后一个数字也就是,最后最右一个 leaf 出发开始 heapify 也可以!!!只不过那些 leaf 进行 heapify 都是不会动的

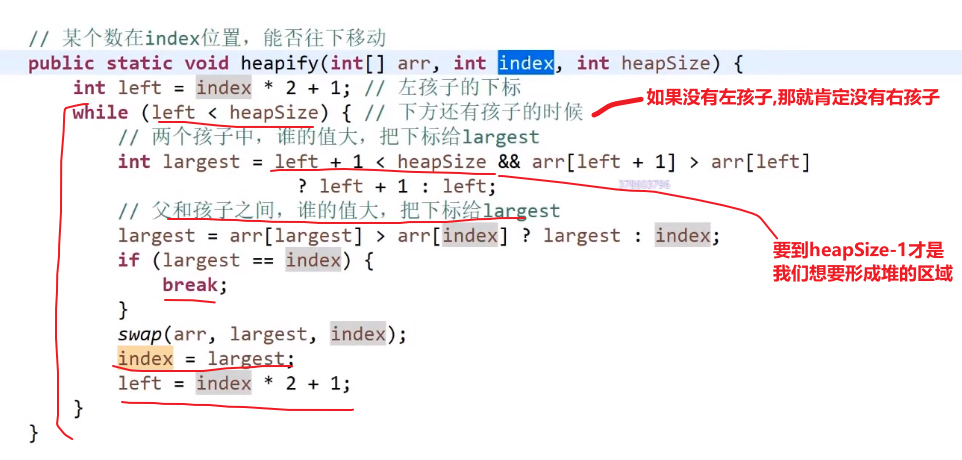

heapify

- 有了一个大根堆我们就可以从数组中取出第一个元素就是最大的元素,然后让剩下的进行 heapify 操作,再次形成大根堆,然后再取出第一个元素也就是我们所有的数据的第二个大的,so on…

- 不过我们也可以直接把第一个元素也就是最大的直接跟最后一个元素交换,heapSize–(此时 heapSize=nums.length-1, 没错就是这,不过我们知道我们接下来就不用管这最后一个元素了,因为已经在正确的位置上了)

- 此时我们第一个元素是当初最后一个元素,我们可以使用 heapify 也就是 bubble down, 跟他的 左孩子和右孩子 (都是使用数组下标可以算出来的) 之间更大 的那个,如果比我们当前元素更小,那么交换,注意左孩子或者 == 左孩子和右孩子 (因为堆结构就是往左到右 fill 的,想想也合理,你数组如果有左孩子和右孩子,那么右孩子的下标就是左孩子的下一个,怎么可能会有 左孩子有右孩子没有 的情况)== 可能会是 null!!! 如果是 null 那就不换呗

- 我们就一直比,直到我们的元素比他此时的 左孩子和右孩子之间更大 的那个更大或者一样的话,那就不换了,到那就行了

- 此时我们就又形成了堆结构,接着把第一个元素也就是数组所有数第二大的放到 heapSize 现在的值 - 1 的下标位置,然后 heapSize–, so on…

- 直到我们的 heapSize 变成 0 代表数组所有的数我们都排序好了

注意在每次我们的把一个数放到了正确的地方后,我们的 heapSize 就成为了那个数的下标的位置,我们下次 heapify 操作只需要针对数组下标为 0 到 heapSize-1 位置就行了

问题:

如果我们已经形成了一个大根堆,结果有人突然把大根堆里面的一个下标的数改了,我们再怎么形成堆?

- 我们可以__对这个下标的元素__调用一次 heapify, 调用一次 heap insert

- 这样如果这个数改小了,那么就会按照 heapify 到合适自己的位置上去,heap insert 不会起效果

- 这样如果这个数改大了,那么就会按照 heap insert 到合适自己的位置上去,heapify 不会起效果

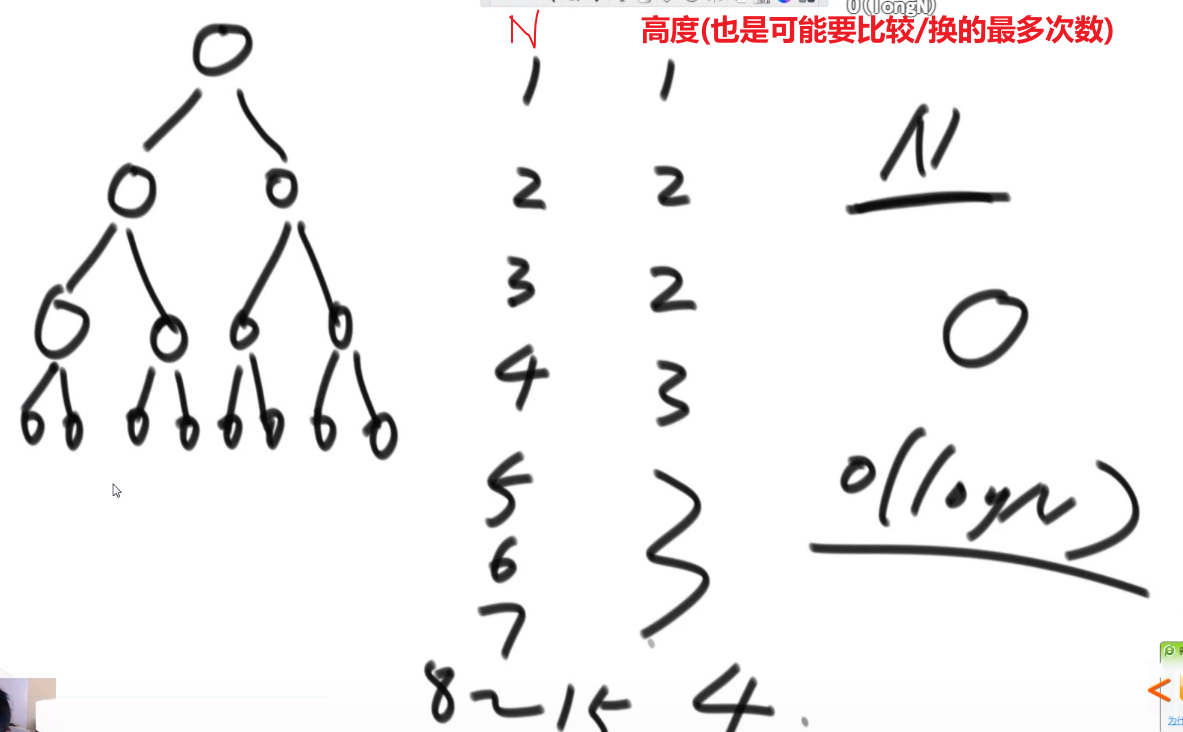

时间复杂度

因为堆其实就是二叉树操作相当于了,所以你对于一个元素然后 heap insert (也可以不用) 或者 heapify, 其实就是二叉树的高度,也就是 logN 级别,最多只需要走一个高度就行了,其他不需要碰

所有的 N 元素,那么就就是 O (NlogN)

空间复杂度

**O(1)!!!**

因为 heapify 和 heap insert 只有用到有限几个变量

# 桶排序、计数排序、基数排序

计数排序

每次统计当前数有多少个,然后给对应的元素位置中的数字 + 1,下次输出时按元素中的个数输出。

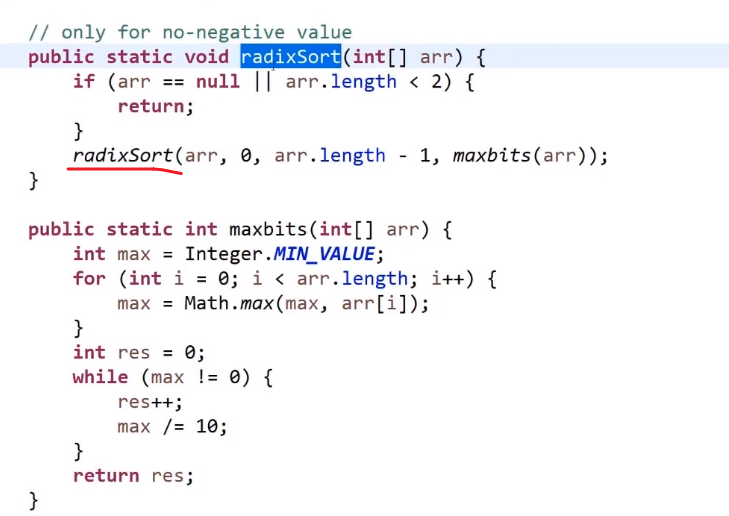

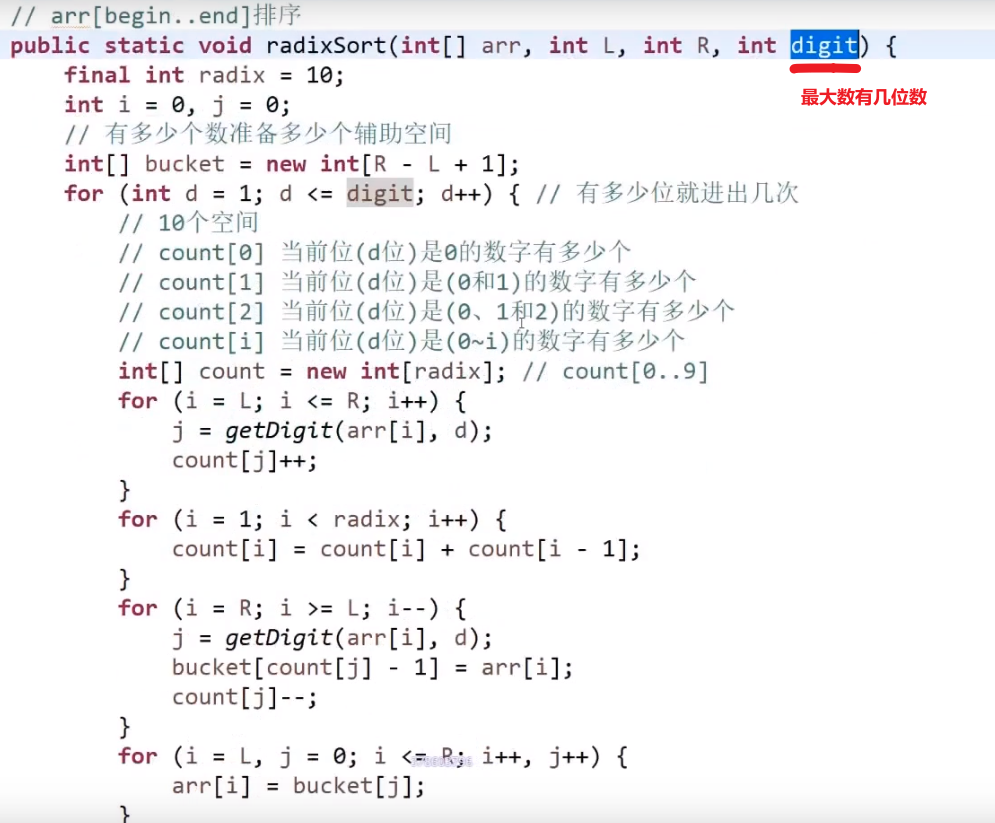

基数排序

比计数排序要好,因为没有那么麻烦创造那么多空间,只需要准备几个几个桶就行了,但是还是依然跟数据状况有关,排的东西还是需要是进制的,不然还是不行,不基于比较的排序都需要从数据状况搞点什么

- 非基于比较的排序,与被排序的样本的实际数据状况很有关系,所以实际中并不经常使用

- 时间复杂度 O (N),额外空间复杂度 O (N)

- 稳定的排序

时间复杂度、空间复杂度 均为 O (N),工程中不常用,但是笔试过程种可以使用这种办法来降低时间复杂度

对于给定的排序范围的数,进行排序。需要排序的数有 n 个。准备 n+1 个桶。

遍历每个数,将每个数装到对应的桶之后。再从第一个桶中取出,依次输出。

桶,基数排序就是先个位排序再十位排序,最后就是百位,然后等等等

先把个位数的排了,然后十位… 优先级更高的之后再排,先把个位数的优先级给搞好,然后一层一层来,最后就是所有位数的都排好了

都是准备十个桶

十进制的数就 10 个桶,3 进制 3 个,2 进制 2 个…

属于不基于比较的排序,但是要求数字就是某种进制的才行

实际理论比较复杂!!!(这里代码没用桶而是词频表,看视频!https://www.bilibili.com/video/BV13g41157hK?p=4 大概 2:09:35 部分)— 很大的优化 -> 分片,然后出桶直接从右到左等等等

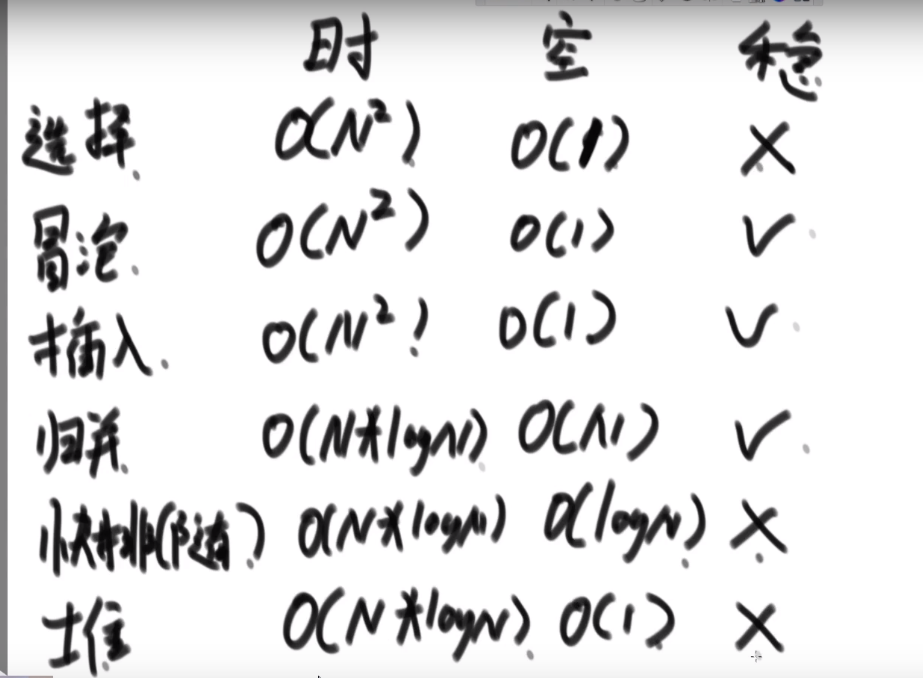

# 排序总结

不基于比较的排序,对样本数据有严格要求,不易改写

基于比较的排序,只要规定好两个样本怎么比大小就可以直接复用

基于比较的排序,时间复杂度的极限是 O (NlogN)

时间复杂度 O (NlogN)、额外空间复杂度__低于 O (N)__、且稳定的__基于比较的__排序是不存在的。

为了绝对的速度选快排、为了省空间选堆排、为了稳定性选归并

# 查找

# 二分

- 找出 mid position

- 看数组的 mid position 的元素跟我们要找的一不一样

- 可以使用

left + ((right - left) >> 1)防止溢出,移位也更高效

- 可以使用

- 要是要找的数字更大我们就去 mid+1 到 right 找回调自己继续找

- 要是要找的数字更小我们就去 left 到 mid-1 找回调自己继续找

- 所有操作要被

left < = right条件的 while 循环包括着,如果 left>right 说明- 比如说找到最后一个元素一比要是当前找的更大就往右找也就是 mid+1 到 right

- 因为当前是最后一个元素,说明 mid 算出来的就是他自己,此时要是 mid+1 然后还是那个 right 老值然后回调的话,收到的 left 就会比 right 更大,此时我们 return -1 说明二分到最后一个元素也不符合,所以没有要找的

- 比如说找到最后一个元素一比要是当前找的更小就往左找也就是 left 到 mid-1

- 因为当前是最后一个元素,说明 mid 算出来的就是他自己,此时要是 mid-1 然后还是那个 left 老值然后回调的话,收到的 right 就会比 left 更小,此时我们 return -1 说明二分到最后一个元素也不符合,所以没有要找的

- 比如说找到最后一个元素一比要是当前找的更大就往右找也就是 mid+1 到 right

/* 注意:题目保证数组不为空,且 n 大于等于 1 ,以下问题默认相同 */

int BinarySearch(int array[], int n, int value)

{

int left = 0;

int right = n - 1;

// 如果这里是 int right = n 的话,那么下面有两处地方需要修改,以保证一一对应:

// 1、下面循环的条件则是 while(left < right)

// 2、循环内当 array[middle] > value 的时候,right = middle

while (left <= right) // 循环条件,适时而变

{

int middle = left + ((right - left) >> 1); // 防止溢出,移位也更高效。同时,每次循环都需要更新。

if (array[middle] > value)

right = middle - 1;

else if (array[middle] < value)

left = middle + 1;

else

return middle;

// 可能会有读者认为刚开始时就要判断相等,但毕竟数组中不相等的情况更多

// 如果每次循环都判断一下是否相等,将耗费时间

}

return -1;

}O (logN)-> 因为比如说 N=16, 那最多要看 4 次,而 24=16, 所以 log16=4, 所以 logN = 最多要看的次数

一般是用于已经有序的数组但这不代表无序就不可以用了!!!

比如说数组中无序,邻近数字不相等,想找出任意一个局部最小的数字 -> 局部最小指的是比左右元素 (如果有) 都要小的数字,也可以用二分查找,肯定会找到一个的,这比暴力 O (N) in this case 更快

主要看情况,看适不适合

# 一些数据结构

# 堆

其实就是完全二叉树的结构,或者就是从左到右开始满的二叉树

用数组对应一个完全二叉树 (好像只是堆我们这么做,反正最上面 (数组第一个下标) 的放着我们最大的 / 最小的元素 -> 大根堆,小根堆)

这样因为是使用数组方式存的节点,所有对于每个下标为 i 的元素

- 他的左孩子,如果不是 null, 就会在 i*2+1 下标

- 他的右孩子,如果不是 null, 就会在 i*2+2 下标

- 他的父亲,就会在 (i-1)/2 下标 —> 如果是 root 也就是下标为 0 的,那么 (0-1)/2 照样还是 0, 还是他自己

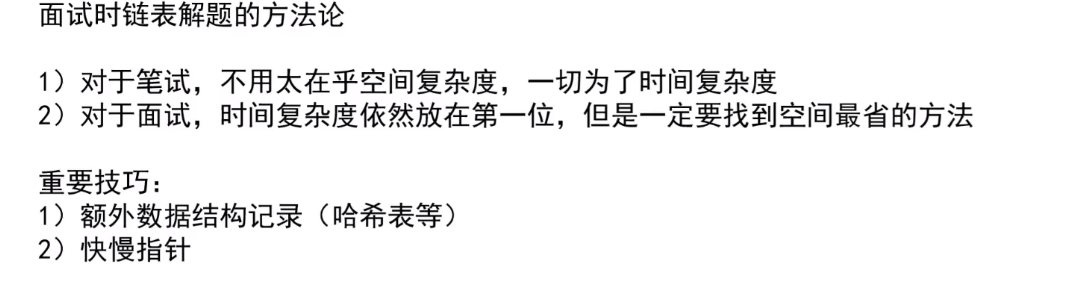

# 链表

记住如果链表带有换头操作,那么返回值设为 head, 返回的就是最终答案的 head (好像和这个还有助于递归算什么东西)

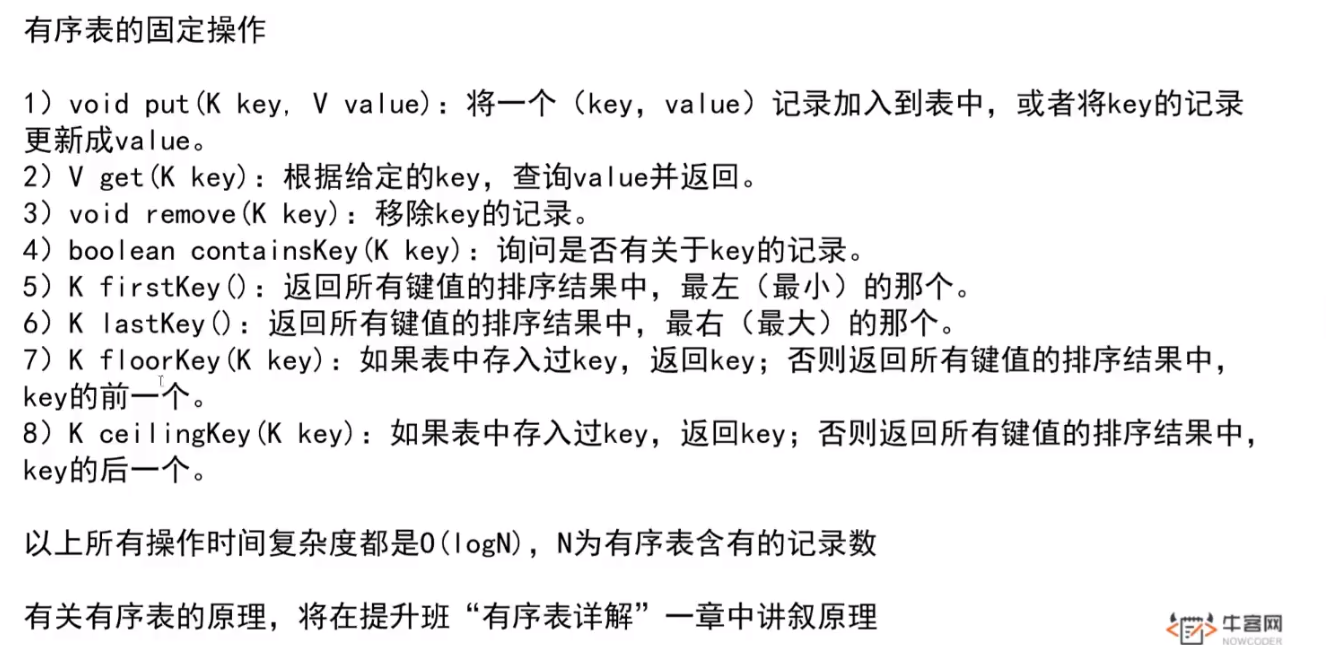

# 优先级队列和 java 的 Priority Queue

- 优先级队列底层就是堆结构,堆顶就是优先级最大的

- Java 里面的是 Priority Queue, 如果放的是数字,那么默认就是小根堆结构

这个底部是数组模拟二叉树的堆结构,所以会有时候加多了,需要扩容,扩容好像就是当前大小 x2, 然后把旧数组里面的拷贝到新建的大数组里面到对应的位置

一共加了 N 个数,经历了 logN 次,因为:

比如说 N=16

- 我们加了两个数超了一下,扩容

- 我们加了四个数超了一下,扩容

- 我们加了八个数超了一下,扩容

- 我们加了 16 个数超了一下,扩容

总共扩容了四次,也就是 logN 级别的 (log16=4)

而我们每次扩容的代价是 O (N) 时间复杂度的,所以所有的操作就会 O (NlogN), 也就是我们添加了 N 个元素的总代价就是 O (NlogN)

而我们想要的是平均下来,每添加一个数,会是多少时间复杂度,也就是

O(NlogN)÷N, 也就是平均下来, 每添加一个元素,即便考虑了扩容问题,也就是 O (logN) 的时间复杂度

所以扩容这个事,并不会影响__比如说让我们使用堆排序__最终的表现,以为我们每个元素的添加 /poll 形成的堆是 O (logN) 的时间复杂度的,这个扩容也是 O (logN) 的时间复杂度,所以并不会怎么影响我们 overall 时间复杂度的计算的

这个是人家 java 底层帮我们维持的堆结构,我们无法对堆结构里面的某一个元素进行改变然后 expecting it to 再次形成堆结构所以这个相当于是个不好的地方,我们自己创造堆结构的话可能会更 flexible 想改哪个改哪个,只不过之后自己要给那个调用 heapify 和 heap insert 让整个结构再次变成想要的堆结构

他就是个黑盒,你给他一个又一个,他可以按照结构给你一个又一个,你无法直接改变黑盒里面的东西,就算可以改也会是代价比较高的 (因为要扫描每一个找到那个被改的,然后进行各种操作变回堆结构)

# 哈希表 (hashMap,hashSet)

java 的 hashMap 和 hashSet 底层就是哈希表实现的

- hashmap/hashset 增删改查任何操作不管数据以及有了多少,都是常数操作 O (1), 比较大的常数 (比数组直接寻址要大得多)

- treemap/treeset (有序表) 增删改查任何操作不管数据以及有了多少,都是 O (log (n))

- 注意要是往 treemap/treeset 里面放复杂数据类型或者自己定义的各种类型,需要你提供一个比较器,按照你定的规则来排序

有序表!

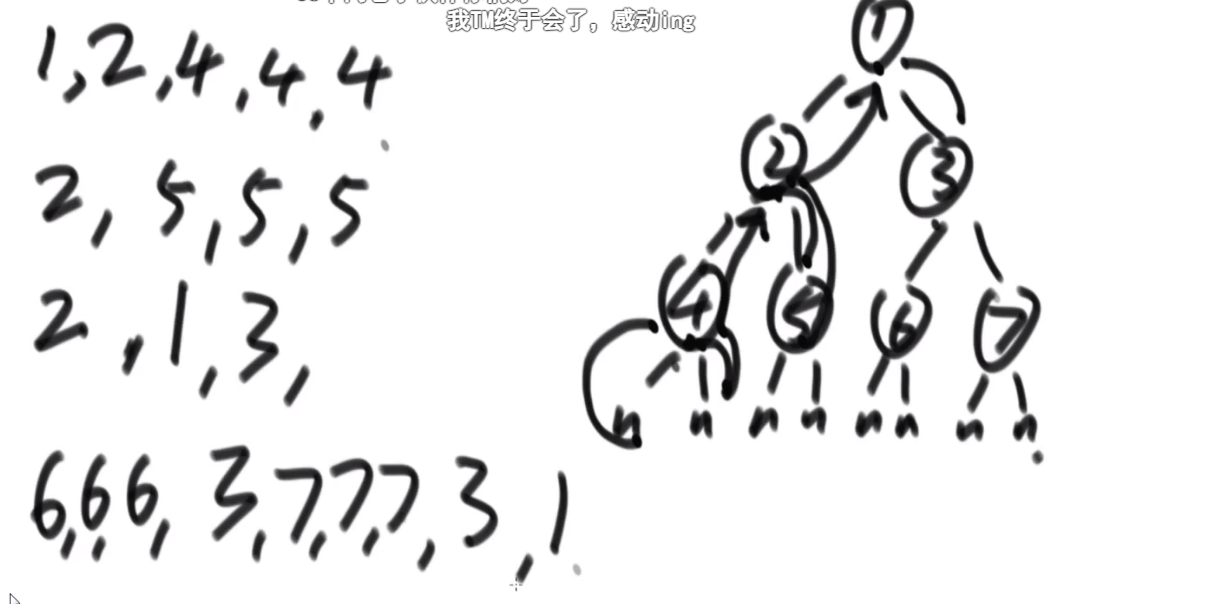

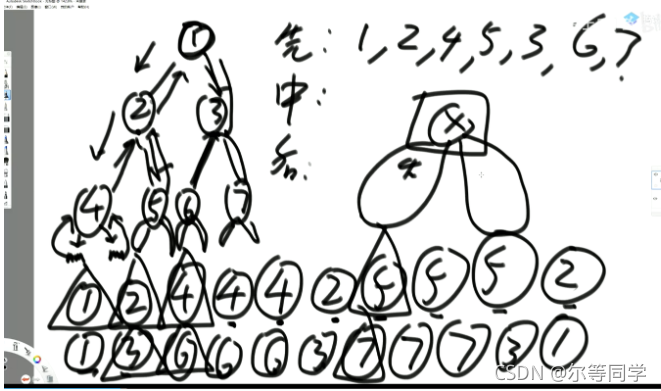

# 二叉树以及各种 (先中后序) 递归,非递归遍历

二叉树的先序、中序、后序遍历

先序: 任何子树的处理顺序都是,先头节点、再左子树、然后右子树

中序: 任何子树的处理顺序都是,先左子树、再头节点、然后右子树

后序: 任何子树的处理顺序都是,先左子树、再右子树、然后头节点

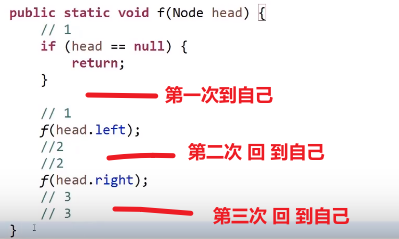

# 递归序

每个结点都会经过三次

递归序:

前序,第一次到达当前节点就打印

中序,第二次到达当前节点就打印

后序,第三次到达当前节点就打印

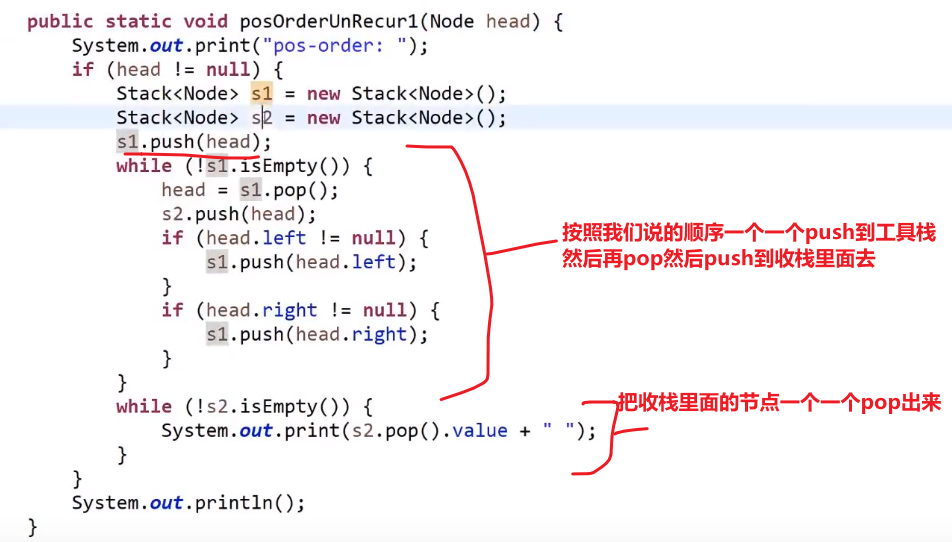

# 非递归遍历

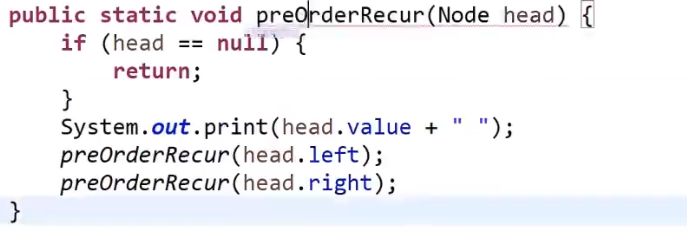

# 前序遍历

准备一个栈,

-

第一步__将非空根结点压栈__

出栈并打印

-

先将刚刚那个出栈的节点的非空右子树结点压栈 (空了就不压呗)

-

后将刚刚那个出栈的节点的非空左子树结点压栈 (空了就不压呗)

还是先序,只不过非递归方式就是我们自己放入栈,要先把右边的压进去,再把左边的压进去

当前栈顶的节点出栈并打印

- 重复 2,3

直到栈空了,说明所有的都出栈了 (这里出站顺序就是前序,我们可以做各种操作), 所有的都出栈了就一定是在所有节点 (每次循环栈 pop 出来的) 左孩子都已经压栈然后出栈或者就是空的,所有右孩子也都已经压栈然后出栈或者就是空的

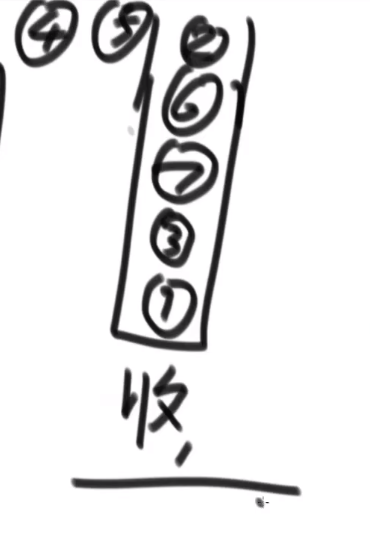

# 后序遍历

两个栈,一个工具栈,一个收栈

- 第一步__将非空根结点压栈__

出这个栈,入收栈

-

先将刚刚那个出栈的节点的非空左子树结点压栈 (空了就不压呗), 注意这里又是左边先了

-

后将刚刚那个出栈的节点的非空右子树结点压栈 (空了就不压呗)

出这个栈 (此时就是我们上面刚放的那个右孩子节点 (注意如果是空的话就不是这个了)), 入收栈

- 重复 2,3

最后收栈的样子就是:

此时再将收栈的节点一个一个 pop 出,那么最后的顺序就是后续了!

可以这么理解:

- 我们压入工具栈又取出的顺序就是 --> 头 右 左 (因为先压入然后先 pop 的头,然后先压入左边的又压入的右边的,然后 pop 的是先 pop 右边的再 pop 左边的)

- 把这个顺序一个一个压入收栈里面就是想要逆序呗 --> 左 右 头 (__先压入头,再压入左,再压入右,所以最后取出的顺序就是 左 右 头 __也就是后序了!)

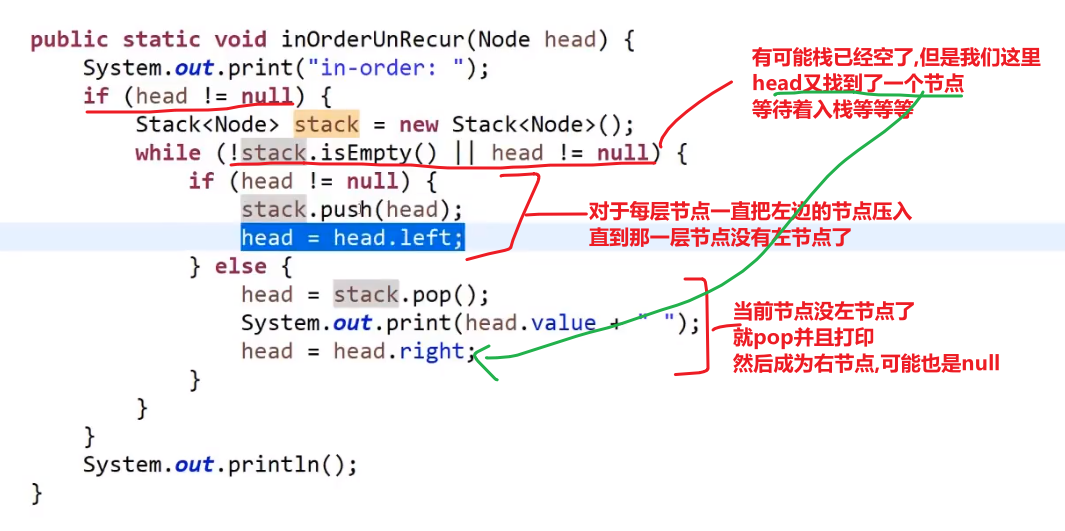

# 中序遍历

- 第一步__将非空根结点压栈__

- 将当前栈里面的节点的左节点压栈,一直重复直到当前栈顶的那个节点没有左节点了

第一次执行第二步

- pop, 打印 pop 出来的,再讲 pop 出来的右节点 **(如果不是空,如果没有右节点就不用管了,继续 pop 下一个栈顶然后打印然后看有没有右节点等等等)** 给压入栈中,然后对这个右节点 (可能代表的子树) 做第二步

这就做到了让头先入栈,接着左边再入栈一直入到底,然后弹出左的 (因为此时弹出左的肯定是 leaf, 没有右节点), 我们就会回到对于那个弹出的左节点是头节点,然后这个会再弹出,然后看有没有右节点有的话就压栈,此时这个右节点又会去看自己有没有左节点压栈的,有的话就重复我们上面的 steps, 没有的话就弹出来, 所以我们最终打印 (或者可以在弹栈进行操作的顺序为–> 左中右,就是中续!!!). 对于每一个子树来说都是左头右的顺序

都是任何树先做再头,然后对于右边的先做再头,so on…

我们当前完全反过来,按照右边的为主,那么就会是右头左顺序了, 看自己什么需求

# 二叉树的深度优先遍历

其实就是二叉树的先序遍历,就同一回事

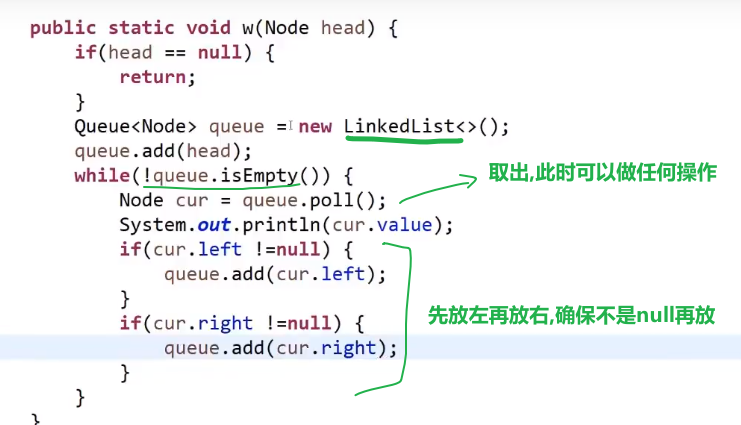

# 二叉树的宽度优先遍历

== 宽度遍历用队列!!!== 先进先出

-

首先头节点进去队列

然后出列,此时打印或者各种操作…

-

让当前出列的左节点 (如果有) 先入列

-

再让当前出列的右节点 (如果有) 再入列

然后出列,此时打印或者各种操作…

- 重复 2,3

就是按照宽度来的,一层一层打印

java 里面 linkedList 就是双链表,双链表可以做队列的 (也可以用来做 stack, 看你用什么方法了), 所以可以直接用 linkedList 当队列用

# 图

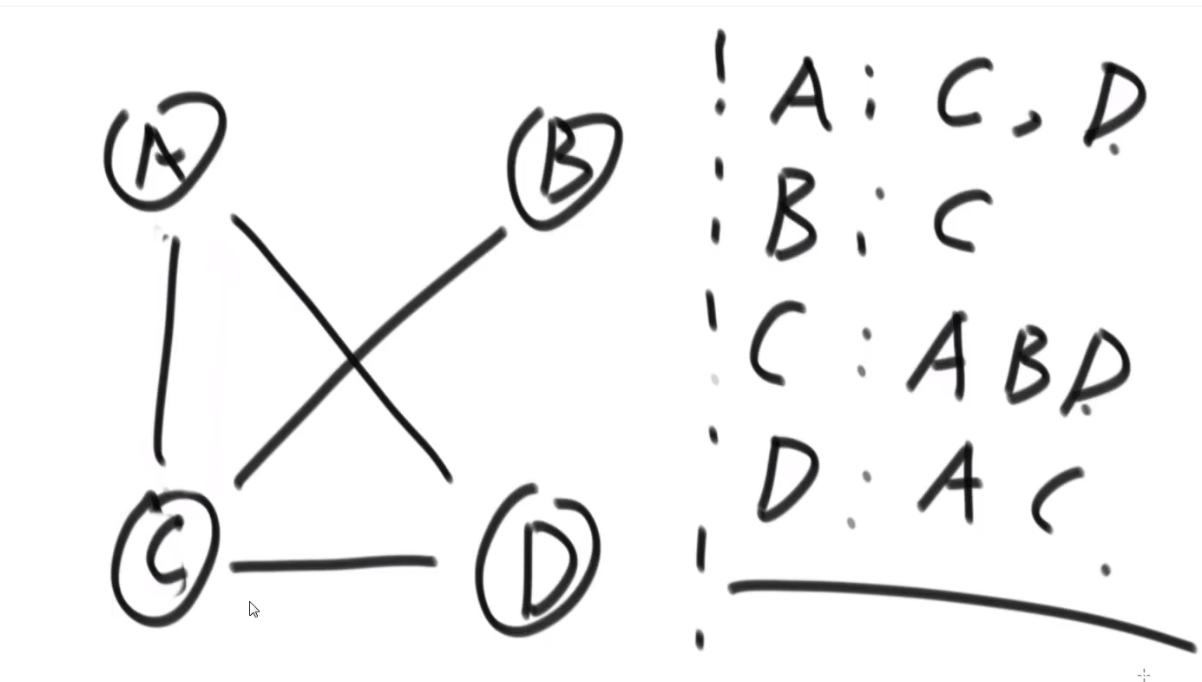

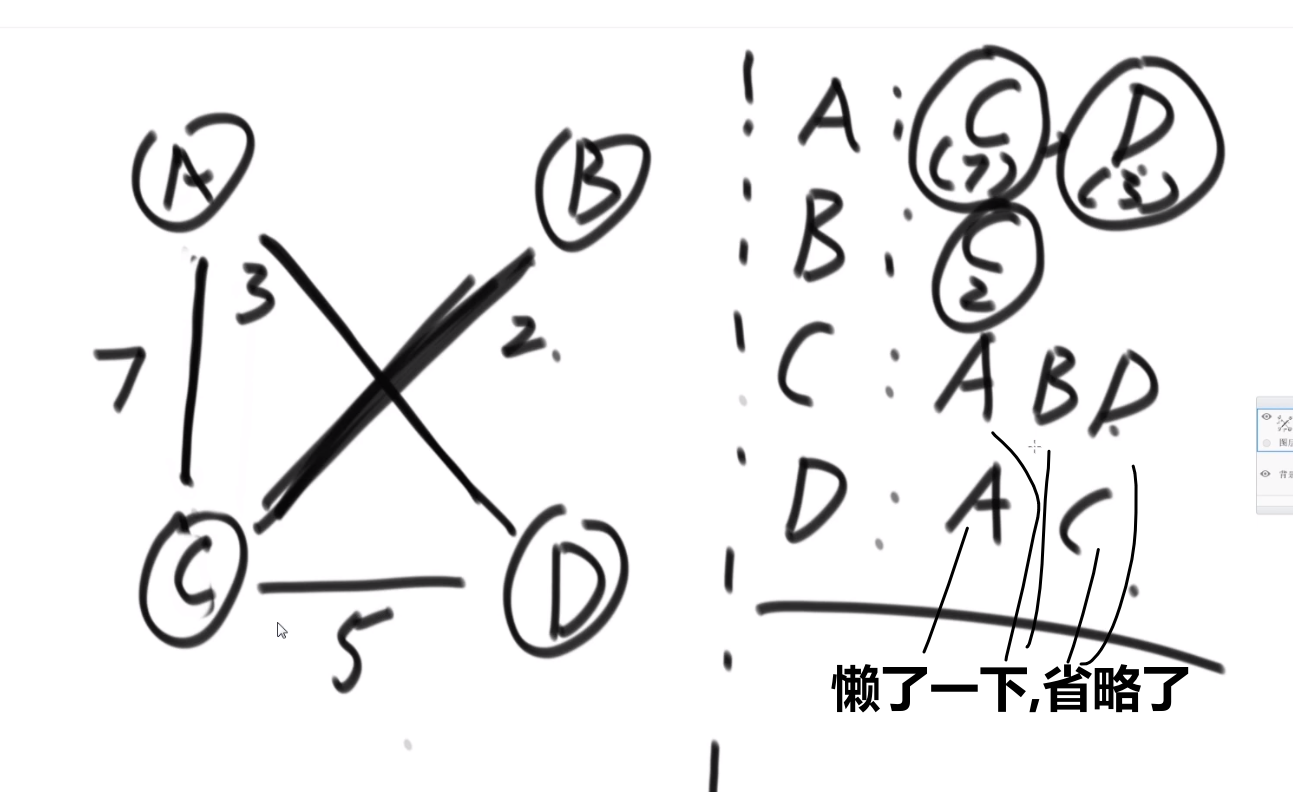

adjacency list

adjacency matrix

(直接带 weight 的)

矩阵中每一个值是按照 edge 来考虑的,有没有 direct edge (两个点直接就有一个 edge 而不是比如说 B 导向 C 然后 C 导向 D)

其实图的代表方式很多,甚至可以用一个数组来代表

我们可以对一种数据结构做所有图的算法,然后之后面试要是给我们不同数据结构代表的图,我们只需要 process 那个转化成我们想要的数据结构,然后传进去我们之前已经会的模板,就可以了

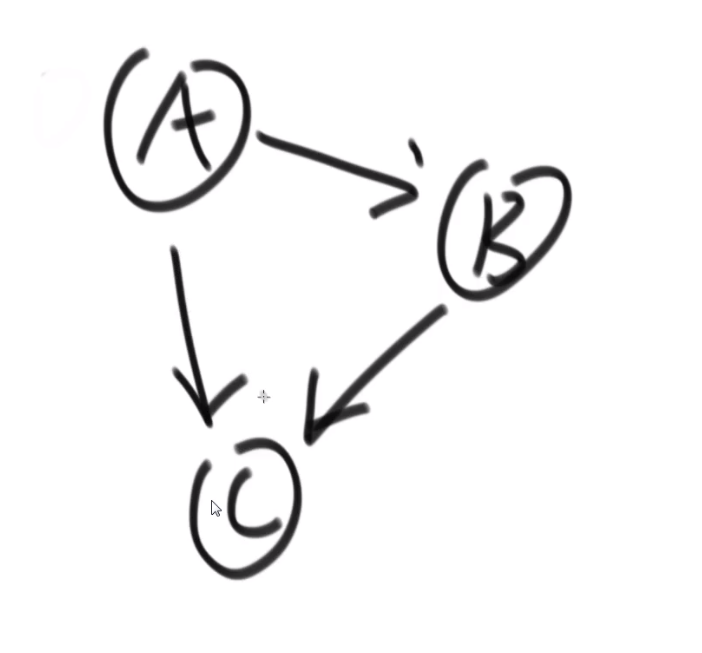

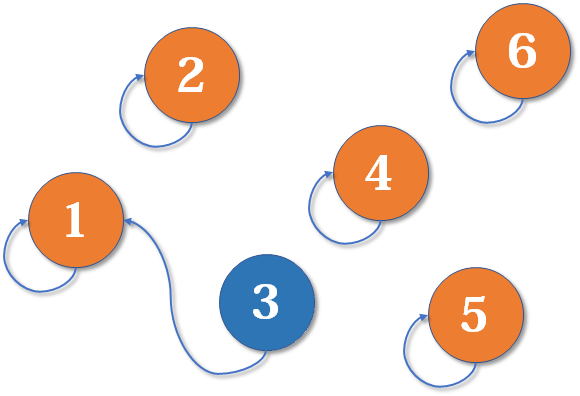

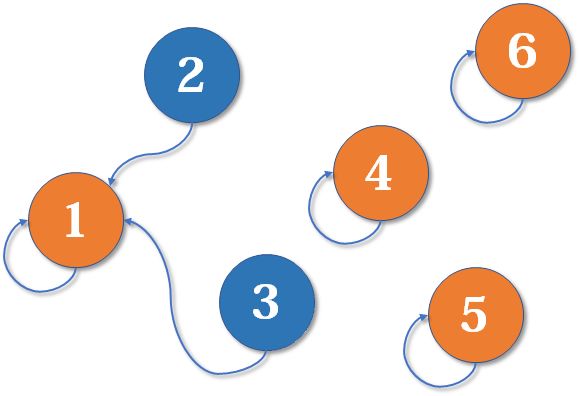

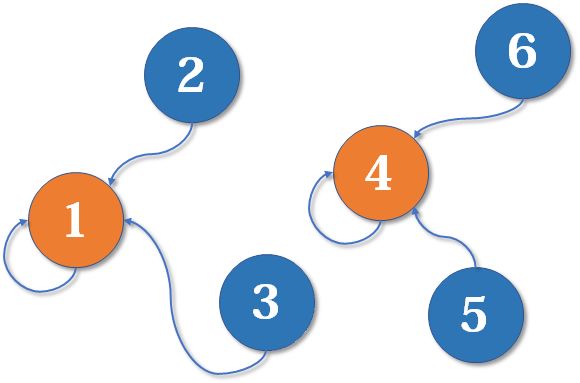

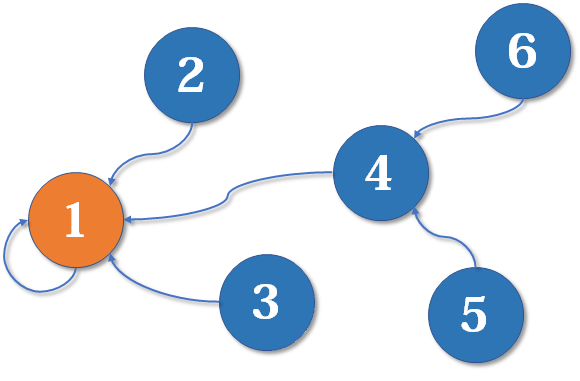

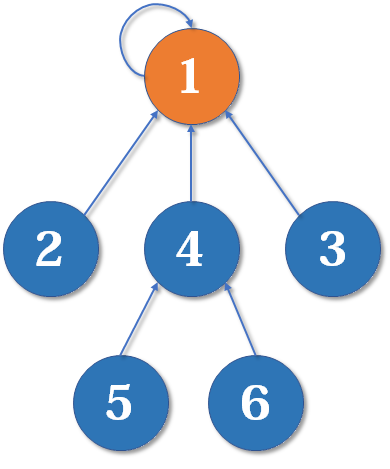

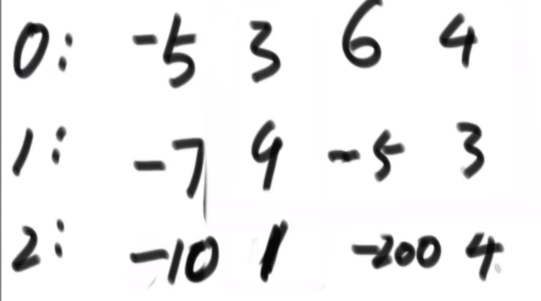

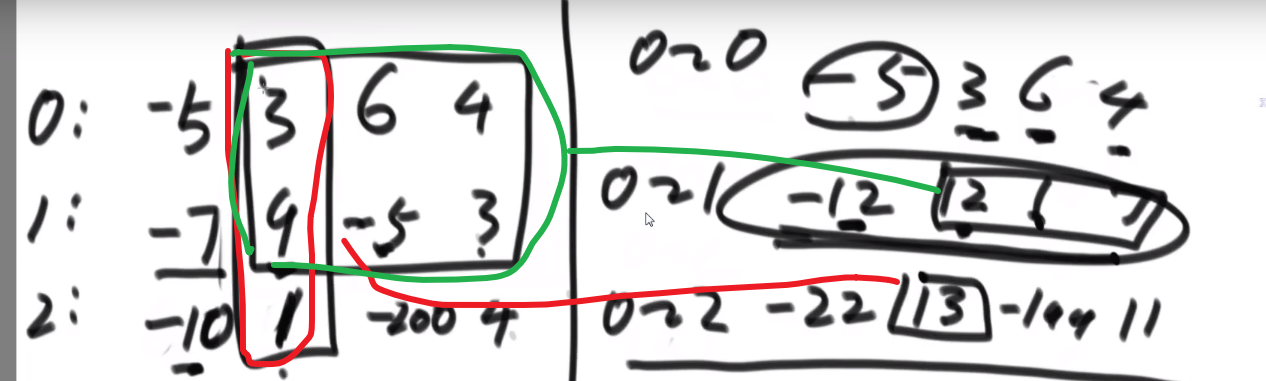

左神用的:

比如说这个

- A 的 nexts 是 B 和 C

- B 的 nexts 是 C

- C 的 nexts 是 null

也就是我们当前这个节点属于我们自己的 edge 而且是往外指向的节点

我们那个节点存的 edge 属性则是那个当前节点往外指的所有 edges 本身,并不是那些 edges 指向的节点

只要管 digraph 就足以,因为我们 graph 其实就是两面的 directed edges 互相指 (you get what i mean)

然后就是我们上面说到的接口函数转换成我们想要的结构:

左神的这种数据结构支持所有的 (大部分的) 算法

如果有哪个算法并不需要某些值,比如说不需要 Nodes 的 nexts 属性什么的,那么直接不用设了那个就好了

只把我们需要的设置好,我们就可以使用这个结构弄那个算法,复杂度不会提高很高

图跟二叉树不一样,可能有环,所以遍历要考虑这个,不要陷入死循环

注意下面这个只是针对于这个 graph 里面连着的节点,要是那个节点没有连,或者是对于 digraph, 然后他的 in 是 0 我们还不从那个节点出发,也会忽略掉那个节点

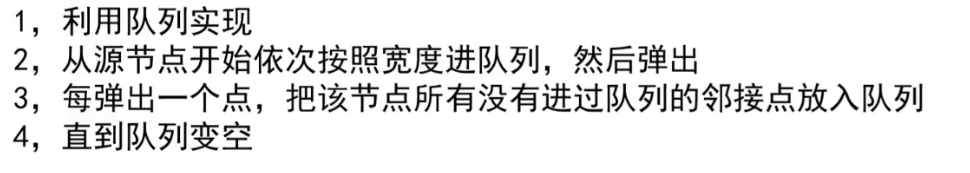

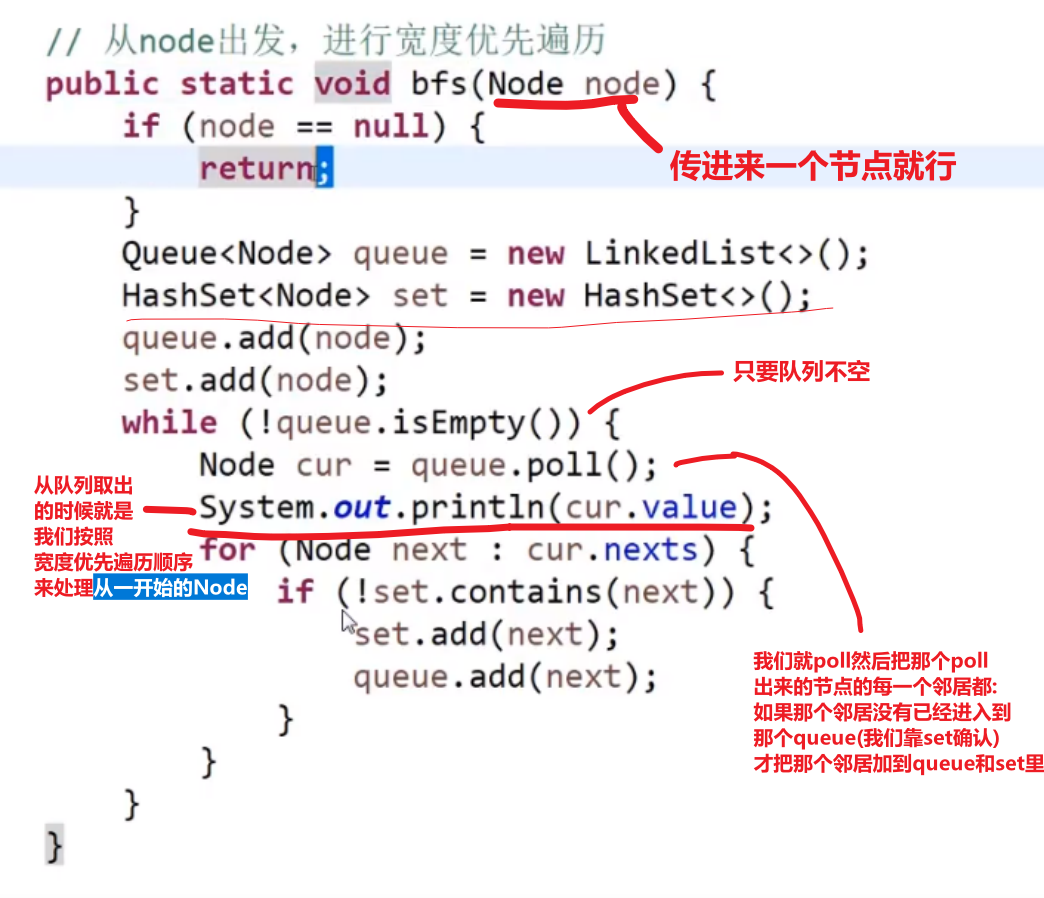

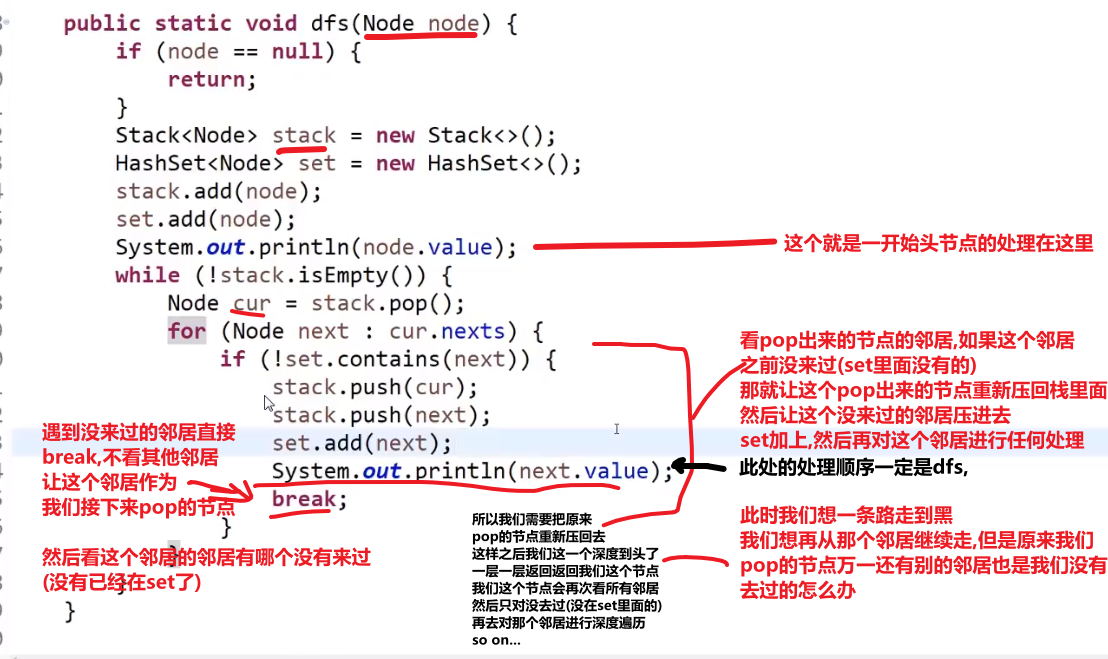

# 图的宽度优先遍历

# 图的广度优先遍历

注意用栈然后这种方式,有一刻会让所有的节点都会存在于栈中,然后之后他们因为还没空所以还是会挨个 pop, 也就是反序了

不过不管我们事,看需求吧大部分。反正我们处理一个节点是那个节点加入到 set (第一次加入到 stack 里面去 (可能会被重复加入好几次)) 就处理。就是别忘了一开始的头节点一开始加入到 set/stack 也是需要处理

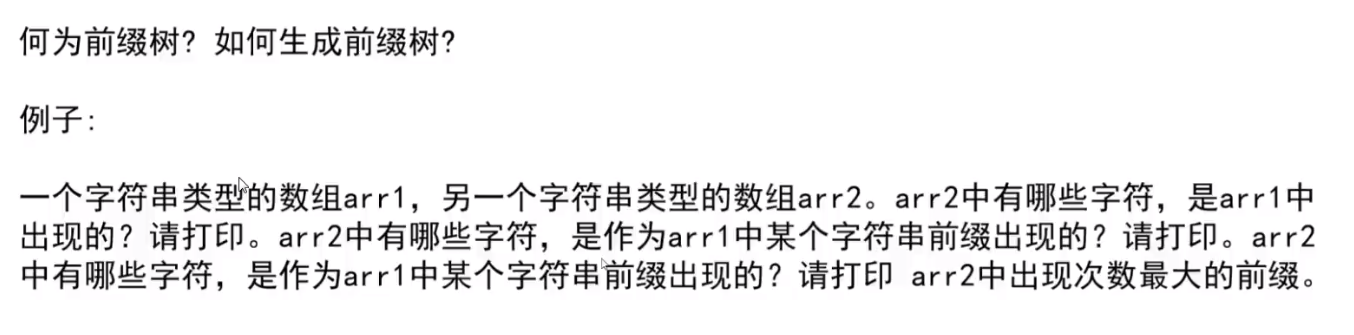

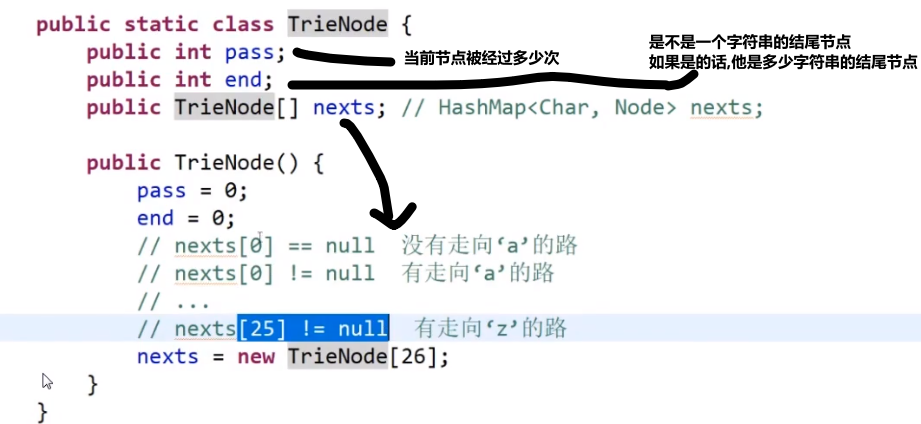

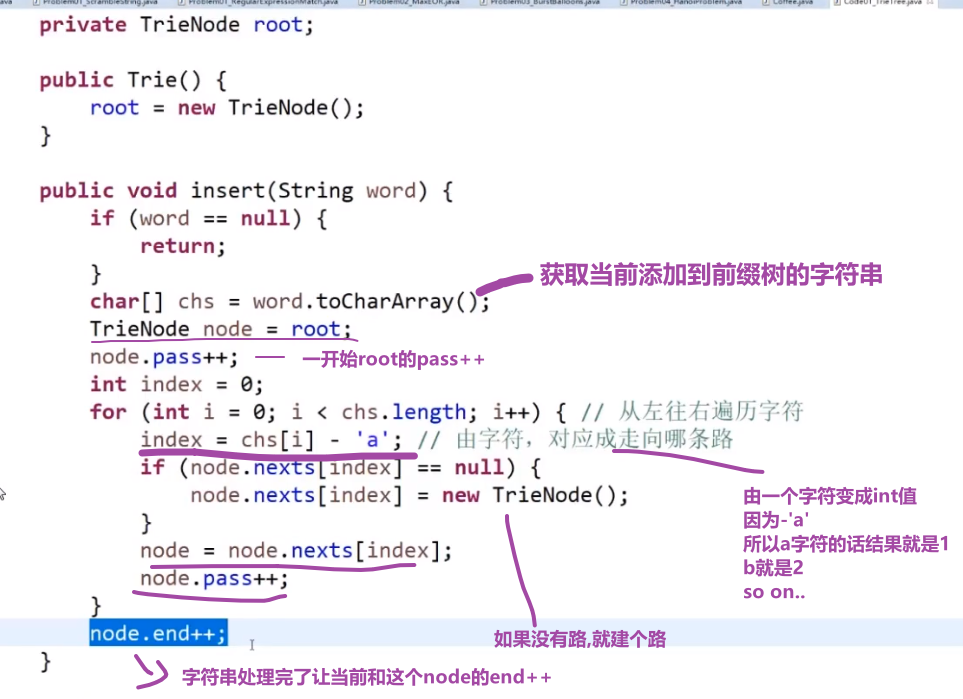

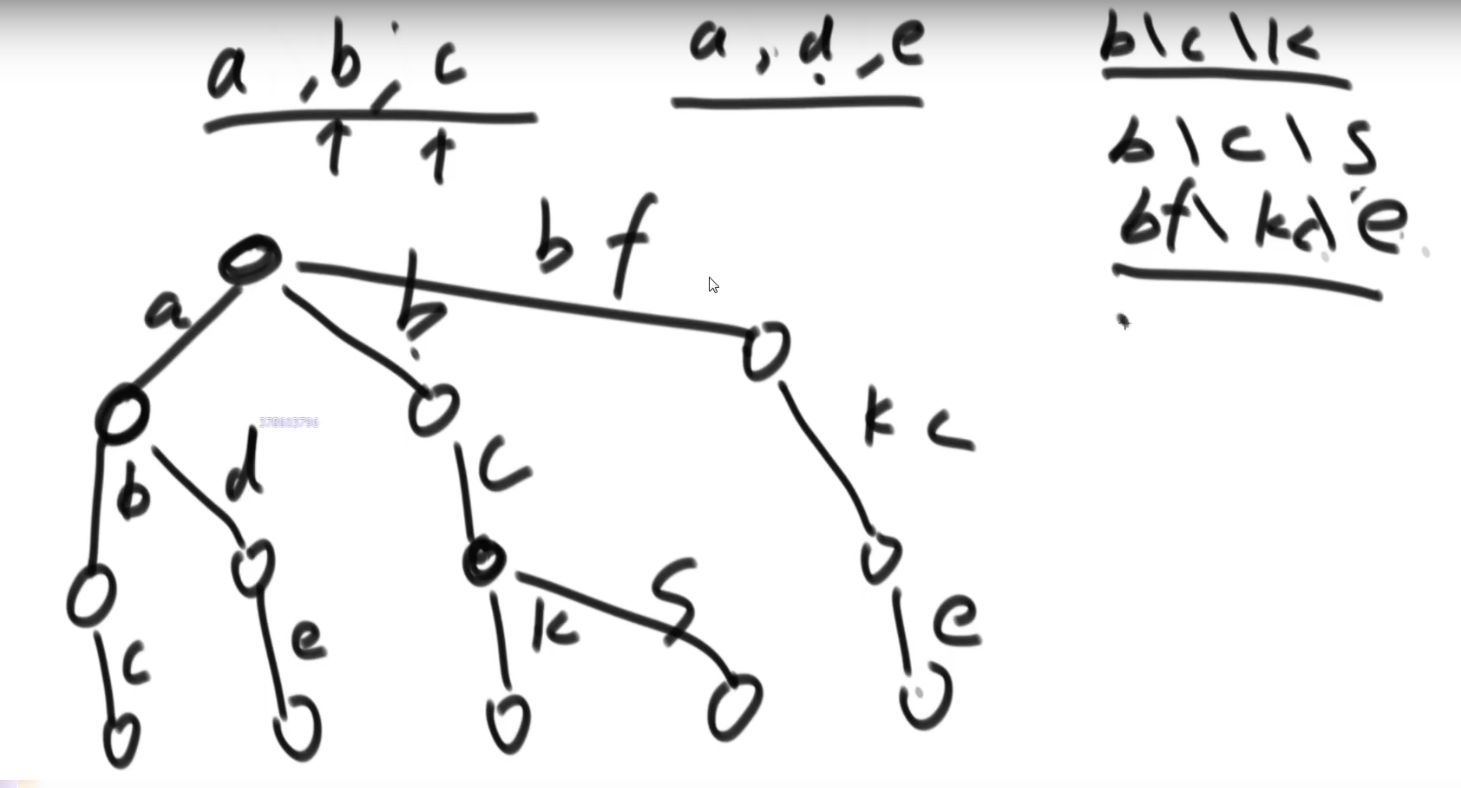

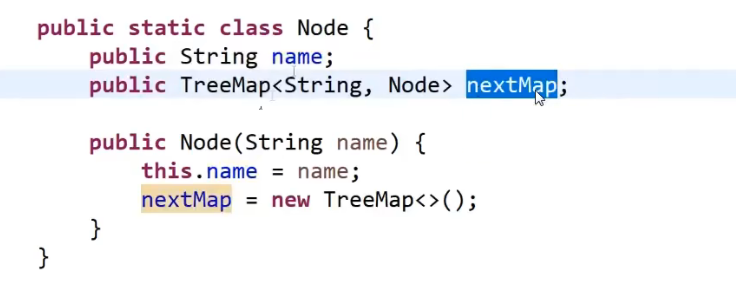

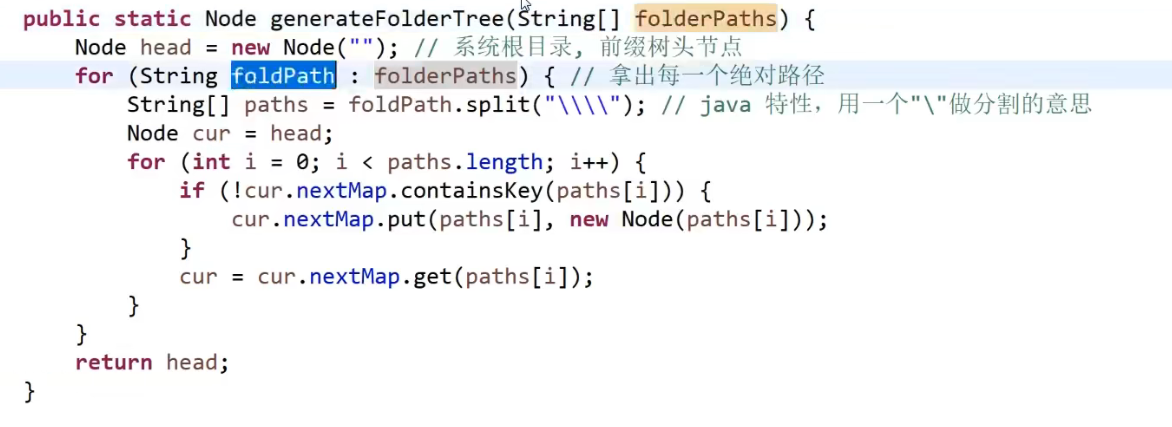

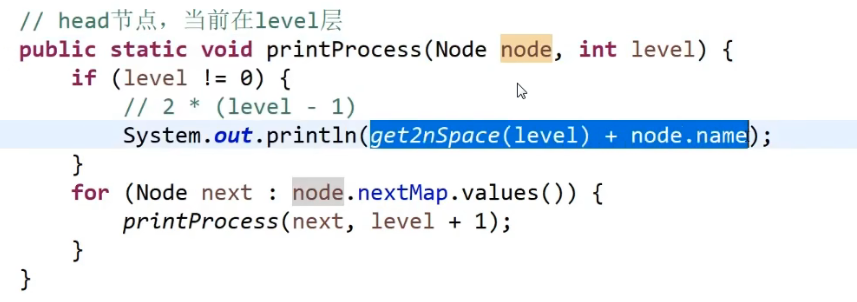

# 前缀树

首先我们可以把数组中存的字符串挨个来看

- 一般是用字符放到 edge 上然后 toNode 指向一个不是 null 的,也就是指向一个节点就行 (不过要是想把字符放到节点上也可以)

- 没有字符的道路那就建一个,如果有就复用等等等

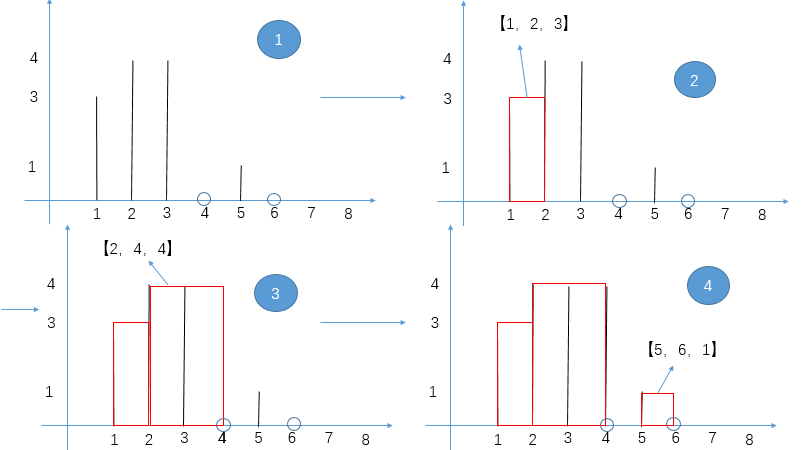

看以下数组形成的前缀树

我们其实可以对那些节点做些自定义,让他存一些我们想要他存的信息

比如说

- 一开始头节点,算是经过 pass 是 1,end 是 0,nexts 是一个数组,数组每个下标都是指向 null

- 接下来有了个 a 字符,我们看有没有 a 的路也就是我们头节点的 nexts 的下标为 0 指向的是不是 null

- 发现是 null 就会让那个改成不是 null-> 而是让下标指向我们新建的一个节点

- 然后我们这个新建的节点就会是 pass 是 1 (p++ 了),end 是 0, 然后处理 b 等等…

…

- 到了最后 c 处理完了生成了一个新节点,发现当前这个字符串结束,那么就让我们这个新建的节点的 end++ 此时就是变成 1 (要是之后还有字符串最后在这节点结束,那么继续加加等等等)

比如说一堆字符串,最后会是这样:

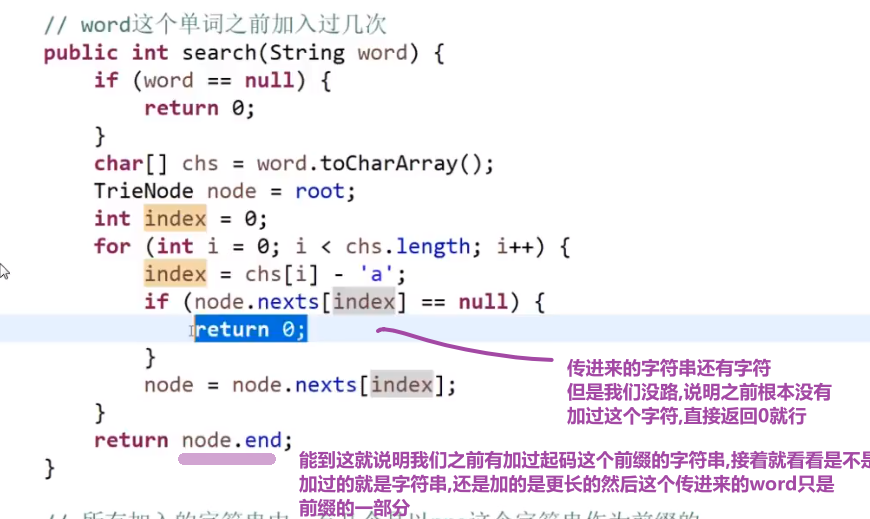

此时比如说我们想要查这些里面有没有 "bc" 这个字符串

- 我们先按照上面的方式让他一个一个走 (不要改值啊!我们之前已经把前缀树建好了,我们只是找一个字符串在不在而已), 走 b 然后走 c 然后那个 c 指向的节点再看那个节点的 end 值是不是 0, 如果是 0 说明你之前加的字符换都没有 "ab", 要是等于 x (不等于 0), 那就一定意味着之前已经加了 x 次这个字符串

我们这样做代价很低,我们只要把一个前缀树建好了,然后再去找一个字符在不在我们的那个数组或者等等等里面 (which we took as input and made a 前缀树 for it), 他的代价只是查找的字符串的字符的数量,只要从头结点出发走过字符这个数量的距离就可以确定这个事

你会发现这还不如用哈希表,还方便,其实这个前缀树还有更厉害的用处

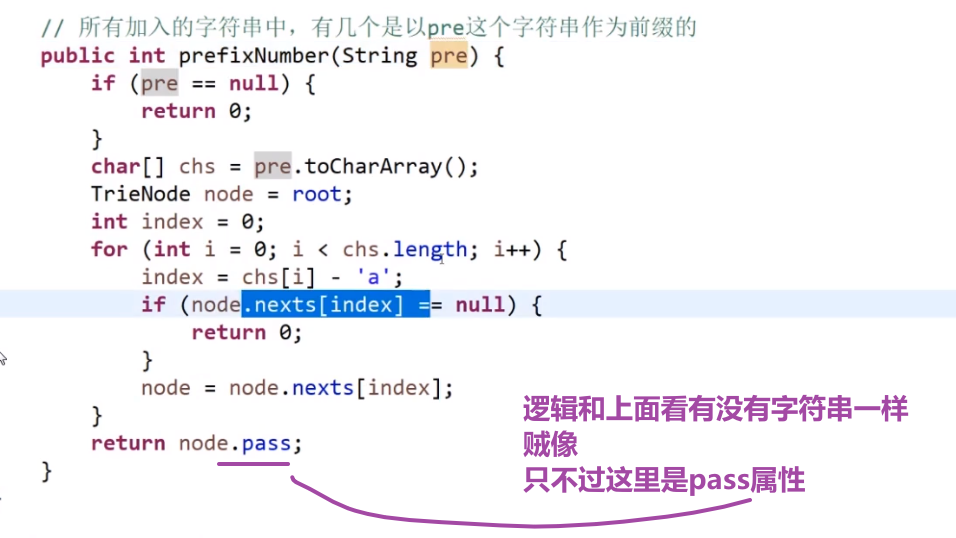

比如说:你想要找你之前加过的字符串,有多少个字符串是有 ab 作为前缀的?

- 我们可以先从头节点出发,然后看有没有 a 的道,有的话就走

- 接着看有没有 b 的道有的话就走,走到的这个节点他的 pass 值就是我们之前所有加过的字符串前缀为 ab 的数量

注意头节点的 pass 属性就是当前前缀树存的字符串是以 ""(空字符串) 作为前缀的

这个哈希表就做不到,而我们的前缀树可以做到

要是我们想要的不只是针对于 letters, 比如说任何可能的字符,那么我们可能需要一个一个 hashmap 来存 (nexts 属性) 信息,key 作为那个路 (也就是那个字符),value 作为那个路指向的节点,这样我们就不需要用数组 (元素一多就没法子了), 如果需要有序的还可以 treemap 等等等,都可以

搜索前缀树有没有一个字符串,如果有的话,有几个:

搜索前缀树有没有一个字符串作为前缀,如果有的话,有几个:

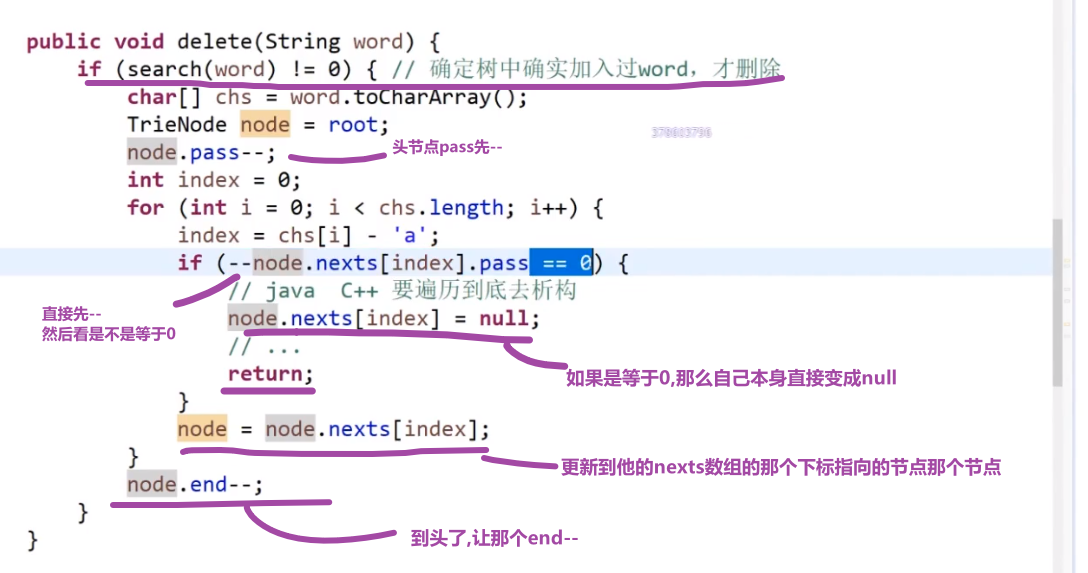

删除前缀树中的存的所有字符串的其中一个:

- 我们先看我们前缀树确实是有那个字符串 (用上面的那个方法看看返回值是不是不等于 0)

- 有的话我们再删,从头一个一个开始看,经过的节点都让 pass 值–, 然后让最后这个字符串结尾的那个节点的 end 值–就行了

如果我们删除的时候到了一个节点然后把他的 p 值–, 结果 p 变成了 0, 那么说明这个节点需要删掉,也就是上面那个的 nexts 数组里面的某个下标指向这个节点的指针应该指向 null 了,因为这个节点现在因为我们删除了那个字符串,导致了他的 pass 是 0 了说明就已经不会有任何字符串是通过他那里的,就算他后面还有节点,也都一样,不会有经过的了.

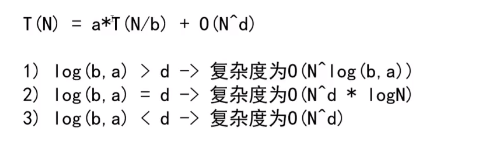

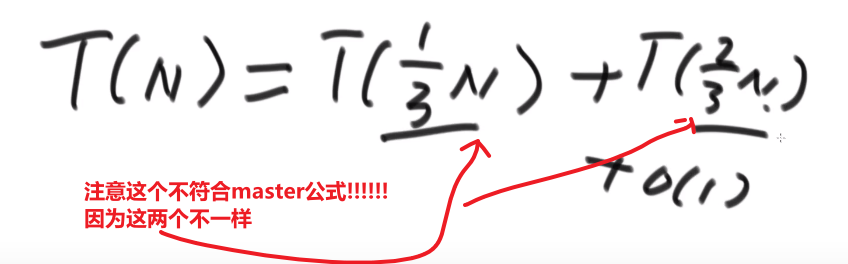

# Master 公式

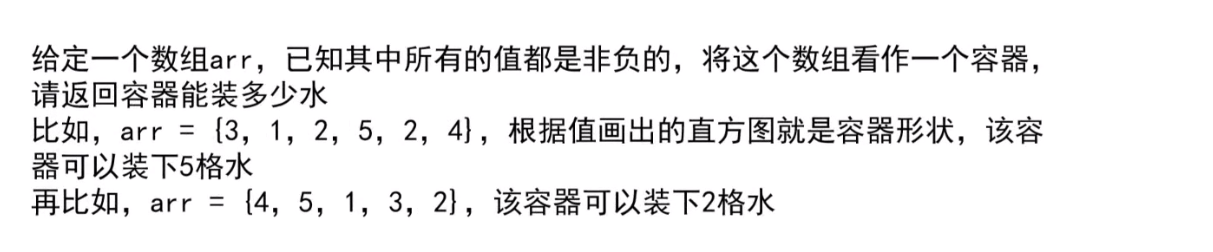

# 排序,数组等问题

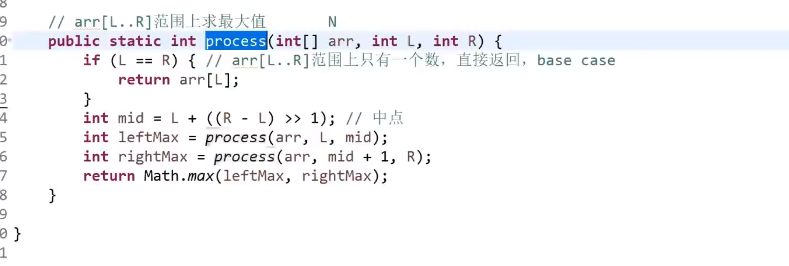

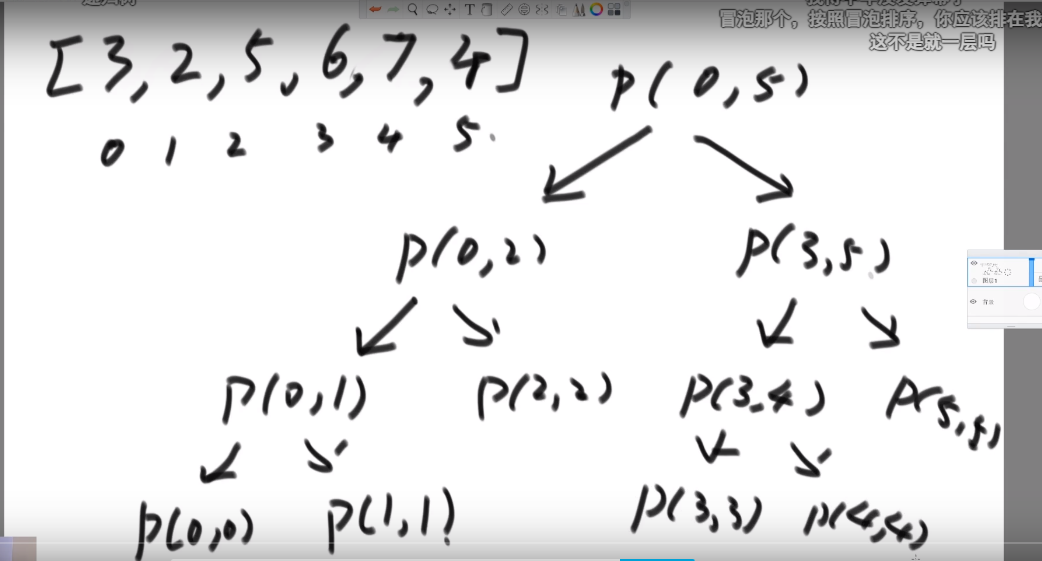

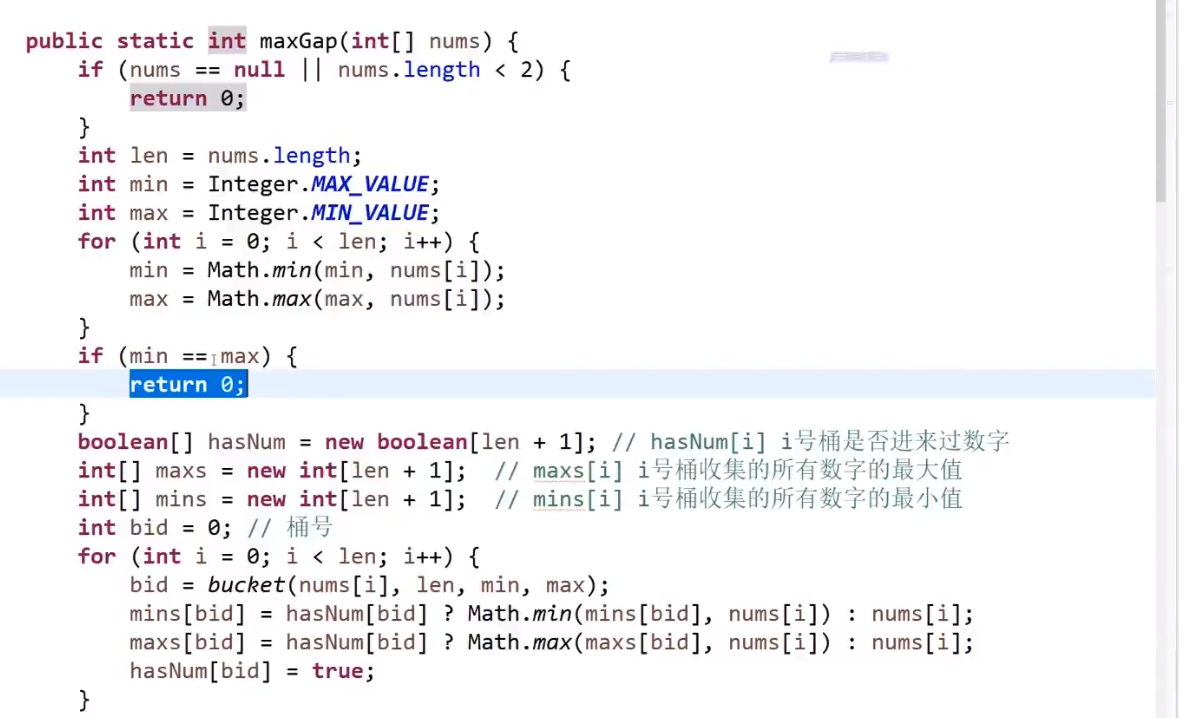

# 找出数组范围最大值

- O (logN) 时间复杂度 -> 用 master 公式

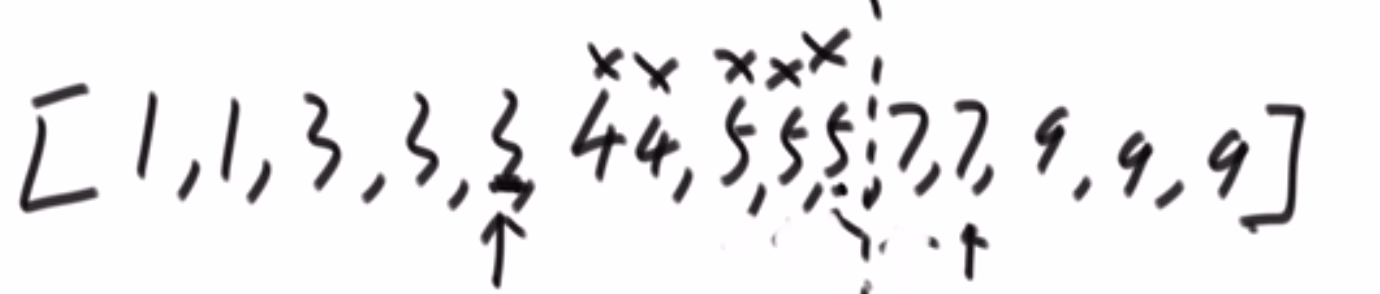

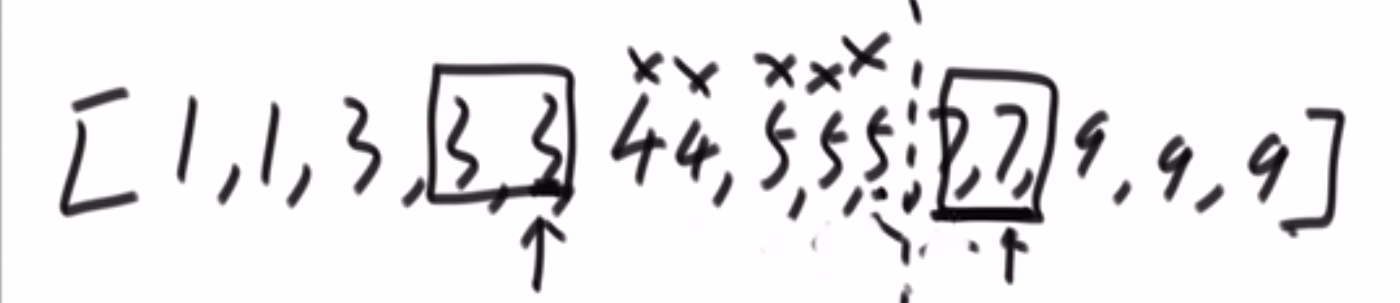

# 小和问题

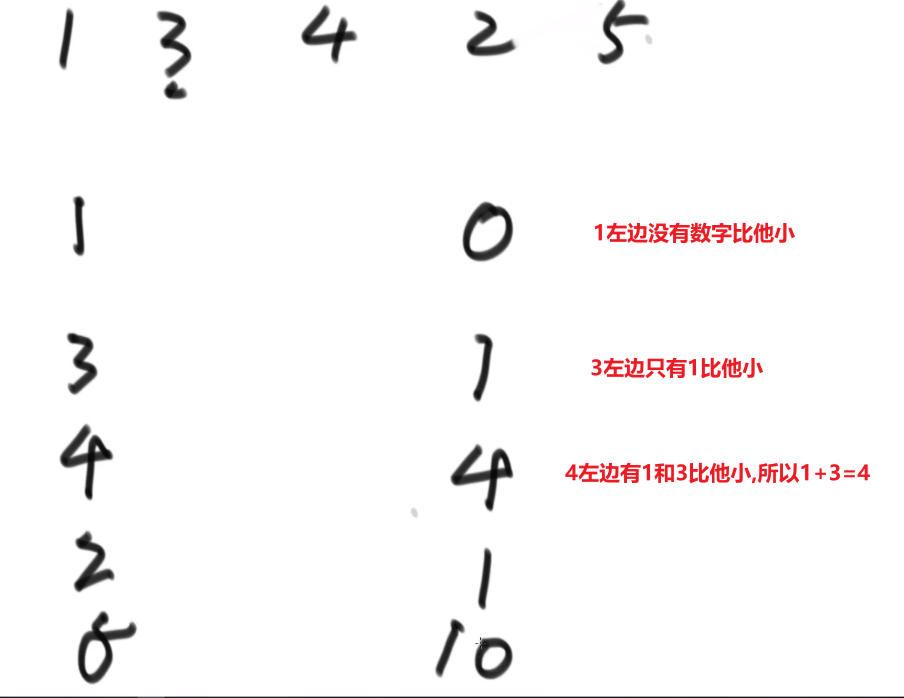

就是你遍历数组,所有在当前元素左边且要比当前元素的数字相加就是当前元素的小和,算出每个元素的小和然后把他们相加

整个数组的小和,在这例子里面是 0+1+4+1+10=16

这个我们可以在使用归并排序的同时,多做些操作,计算出来答案

我们换种想法,每个元素,他的右边有几个比自己大,比如说上面例子

- 第一个元素是 1, 然后看右边有 4 个元素比自己大,所以我们需要 4 个 1

- 第二个元素是 3, 然后看右边有 2 个元素比自己大,所以我们需要 2 个 3

- 第三个元素是 4, 然后看右边有 1 个元素比自己大,所以我们需要 1 个 4

- 第四个元素是 2, 然后看右边有 1 个元素比自己大,所以我们需要 1 个 2

- 第五个元素是 5, 然后看右边有 0 个元素,所以我们需要 0 个 5

所以最后 4*1 + 2*3 + 1*4 + 1*2 = 16, 所以一样的

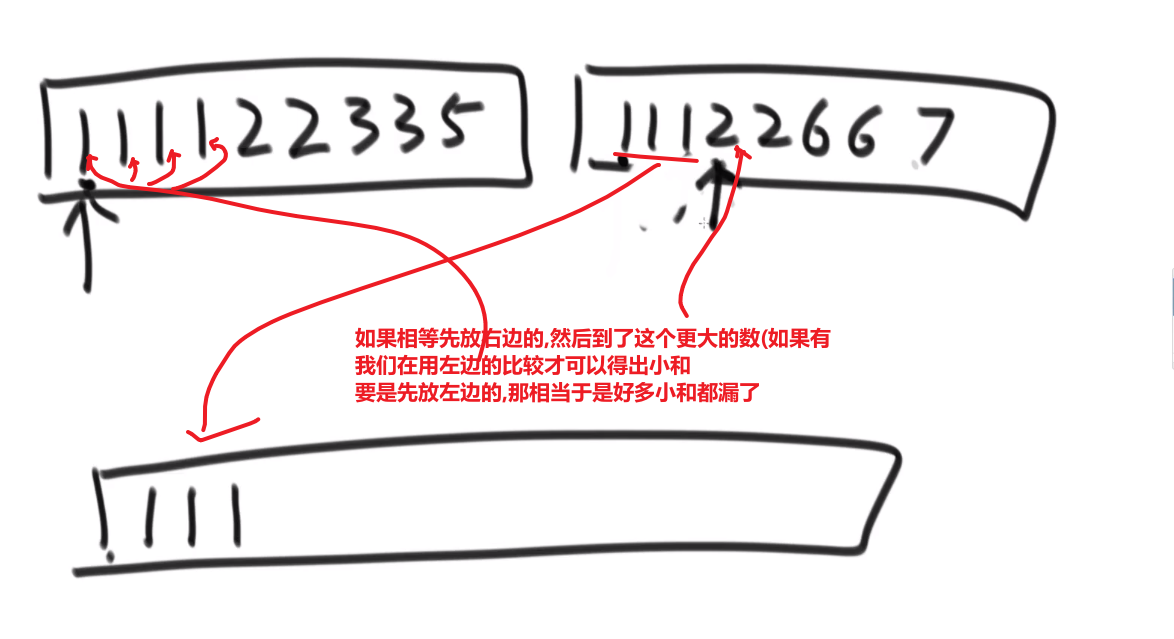

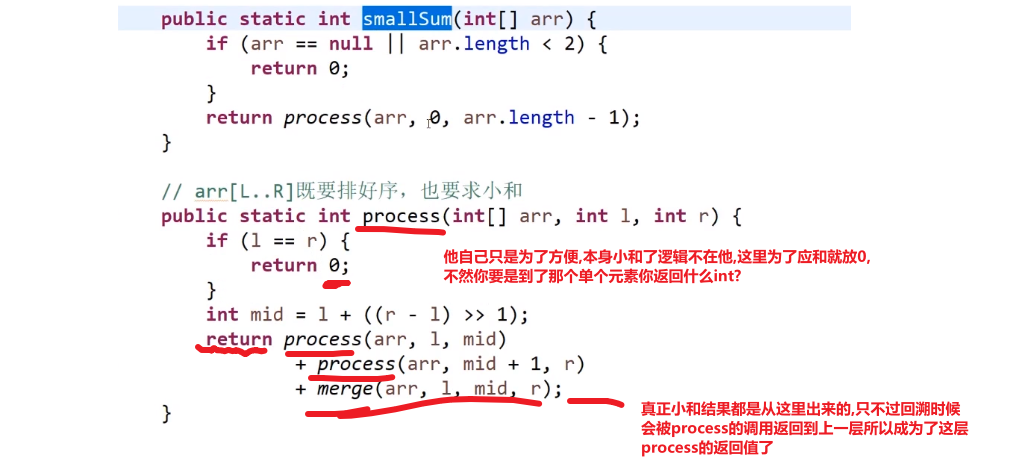

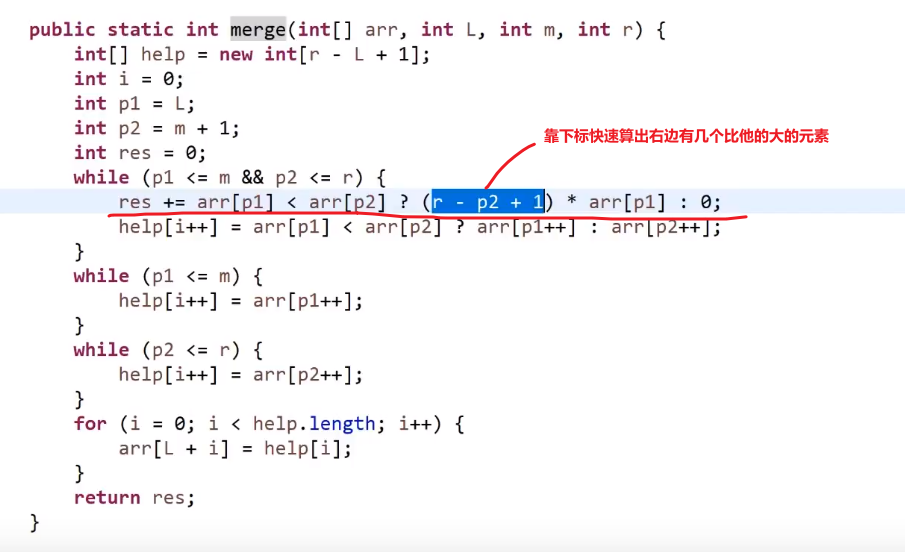

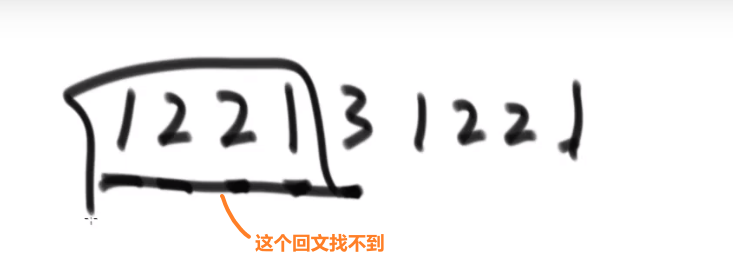

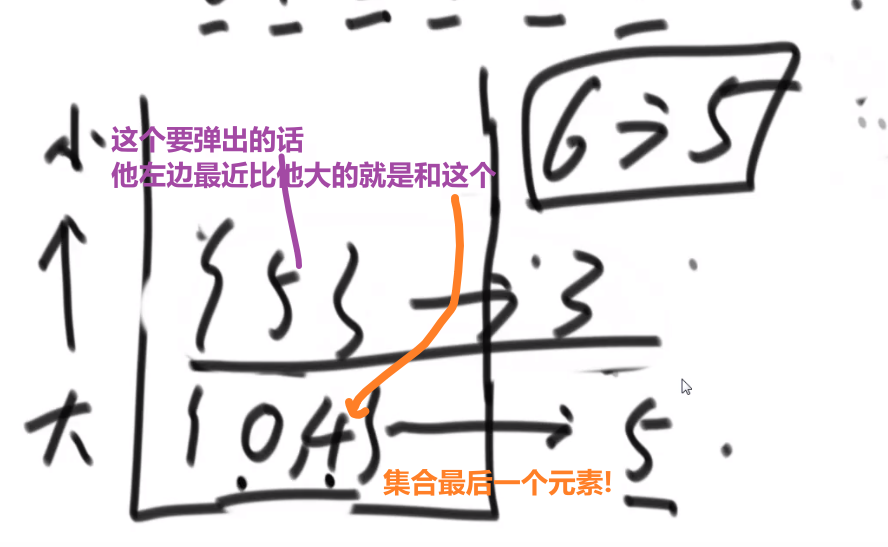

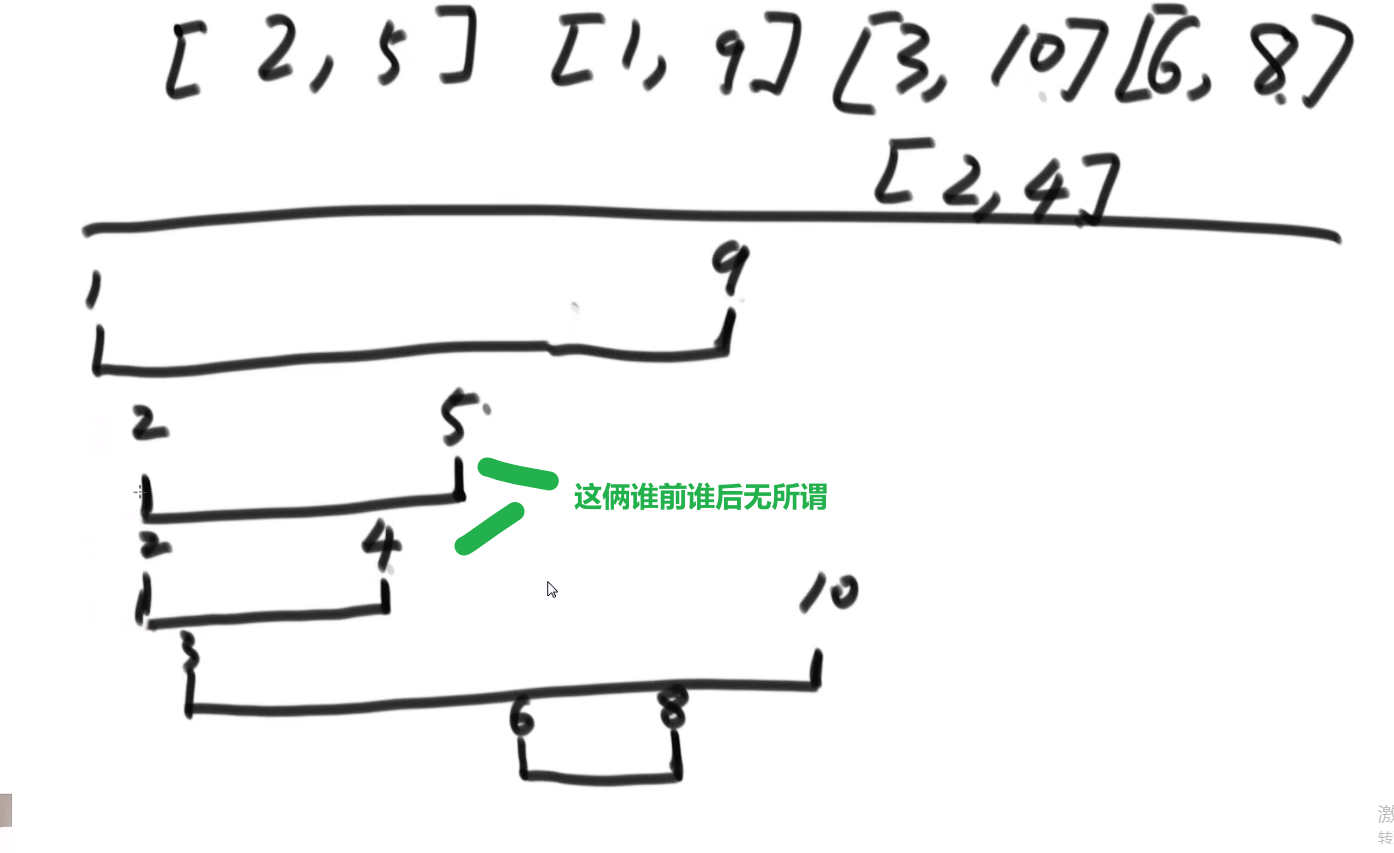

所以每次 merge 执行的时候,如果左边的要比右边的___要小___(注意 等于 不算!) 的话,就代表产生了小和,也就是当前左边这个值. 如果右边的这个数组是多个元素,那如果右边第一个比当前左边的这个元素要大,右边数组后面所有的元素都大,我们可以用右边数组下标快速地 (其实这个就是更快的原因,直接就找到了多少个元素更大,而不是一个一个比) 计算出有多少个比他大的然后小和值就增加比他大的那个靠下标快速算出来的数量 * 当前左边这个更小的值

== 但是注意!!!这个 merge 过程跟我们之前的 merge 过程有点不一样 ==

在这里, 我们如果左边和右边数组当前数是相等的,我们不会先放左边的,而是先放右边的

注意,正因为我们这里如果相等是先放了右边的,我们破坏了 merge sort 的稳定性,merge sort 在 O (logN) 的比较排序里面最有特色的就是他的稳定性,其他的都不怎么样 (比如说空间复杂度是 O (N), 是 O (logN) 的比较排序里面最大的)

当然需要本身的排序也是实实在在的需要的,要是不排序那就不对了,比如说右组必须是排序的我们才可以用下标快速的算出有多少个比元素更大的 ->(下标快速算就是 O (1) 啊)

每个小和都是没有遗漏的,分批的,没有重复的

- 不遗漏 -> 因为 merge 过程中,是一定会把某一个数右侧范围扩到一个整体的

- 不重复 -> 因为已经变成一个部分的东西,在这个东西内部是不重复产生小和的,只是左组跟右组 merge 的过程中,因为左组的数比右组的小,才会产生小和,所以不重算

因为这个差不多就是 merge sort, 所以时间复杂度就是 O (NlogN)

# 逆序队问题

比如说:

[3,2,4,5,0] -> 3,0 是个逆序队 3,2 是个逆序队 4,0 是个逆序队 etc…

计算总共有多少个逆序队

使用归并排序

- 每次 merge 我们都看,左边当前元素是不是比右边的要大

- 如果大,直接用下标方式快速算出多少个大的

- 如果小__或者等于__, 就直接左边的这个,然后看左边的下一个元素进行比较,…

不难看出,跟小和问题贼像,只不过反过来了,而且没那么复杂了

** 多想想像这种类似于 combination 的题,他问的不是 combination 哈,反正总是试试看 merge sort 能不能行,merge sort 就是可以快速找出左边和右边的某种区别 (一般是大于,小于这些的), 然后要是我们平常需要一个一个比,但是因为 merge sort 确保每次 merge 两边都已经是有序的,我们可以非常迅速靠着下标算出有多个匹配的!!!**

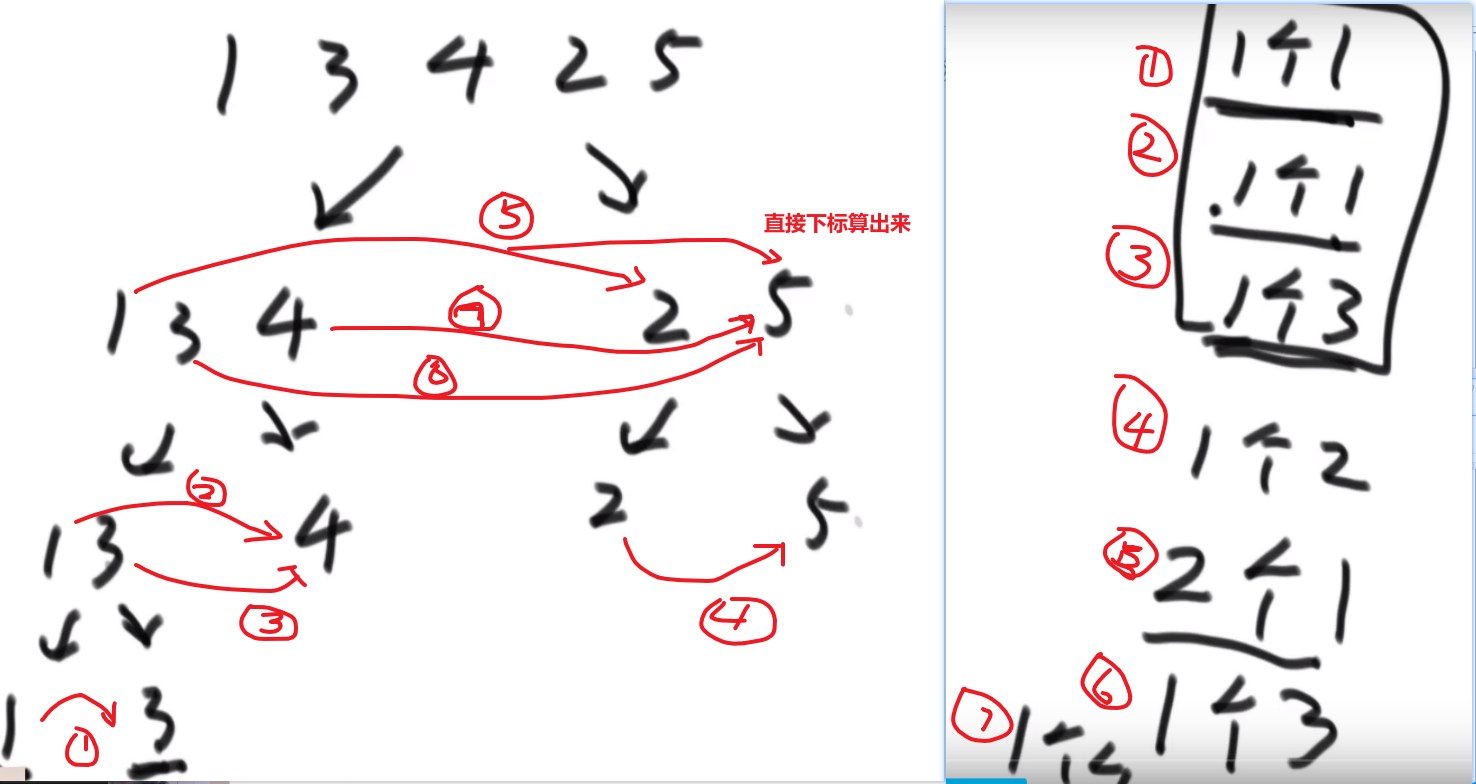

# 荷兰国旗问题

很简单

- 遍历我们数组,下标 i 一开始是 0

- 有个小于区域和大于区域 (如果只想要小于一个数的在左边,其他随便就不需要大于区域,大于区域是为了把大于那个数的放到右边,这样既有小于区域和大于区域,那么如果有和那个数一样的,那么会出现在中间左右的位置)

- 如果当前元素 <那个数,把当前元素跟小于区域下一个元素互换,小于区域往前走一步 (用下标比如说 j++),i++

- 如果当前元素 = 那个数,直接跳过让 i++

- 如果当前元素 > 那个数,把当前元素跟大于区域上一个元素互换,大于区域往前走一步 (用下标比如说 k–),i__不变!__

- 当 i 和 k 的值一样了,说明都处理完了,结束,完成!

如果只想要小于等于的放在左边,大于的放到右边的规则:

- 如果当前元素 <= 那个数,把当前元素跟小于等于区域下一个元素互换,小于等于区域往前走一步 (用下标比如说 j++),i++

- 如果当前元素 > 那个数,直接跳过让 i++

这就跟双指针一样的

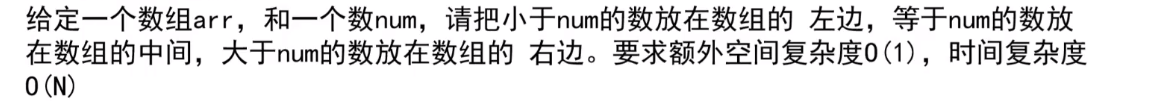

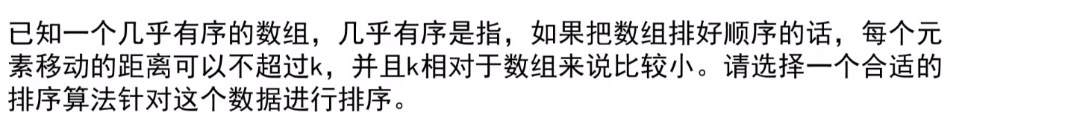

# 排序一个几乎有序的数组

** 使用堆排序!!!**

- 首先我们有个数组,然后一个 k 值

- 我们首先把下标从 0 到 k 的所有数字放到一个小根堆 (这里使用小根堆是为了方便,因为我们取的就是从 0 下标开始的一些数字) 里面,这样我们就有了这个范围的小根堆,我们知道数组最小的数字肯定是在这里,因为最多不会超过 k, 不会出现在超过那个范围的!

- 我们接着取出堆顶也就是数组最小值把它放入数组下标为 0 的位置,注意我们小跟堆需要把那个堆顶 pop 掉!!!

- 我们再从数组的 k+1 下标的位置取出一个放入到小根堆,然后让那个 heap insert 或者什么什么的再次形成小跟堆

- 此时我们再取出堆顶也就是数组第二个最小的放入到数组下标为 1 的位置,注意我们小跟堆需要把那个堆顶 pop 掉!!!

- so on…

- 直到我们数组取不出元素了,到头了,我们就让现在的小根堆 pop 完后那个样子自己形成小根堆,然后取堆顶等等等就行了

- 最后我们数组都是有序了

我们小根堆每次只处理 k+1 个数,所以每次每一个元素 heapify 形成一个新的小根堆,其实就是 O (logk) 左右的时间复杂度

我们数组有 N 个元素,每个元素都要被放到小跟堆进行 heapify/heap insert, 也就是总共就共__O (NlogN) 的时间复杂度__

所以如果 k 的值很小,我们这个甚至就跟 O (N) 差不多了!所以堆排序很适合这个问题!!!

学到了 堆结构很管用!!!任何合适的都可以,任何想要我们选择某一个数,然后是按照某种跟其他的比较的规则,比如说比其他的都小 / 都大都可以!!!

注意我们可以用自己自定义的类的实例按照他们的属性的值来进行这个堆结构然后堆排序都可以,很自定义,很不错!

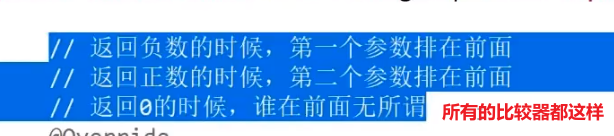

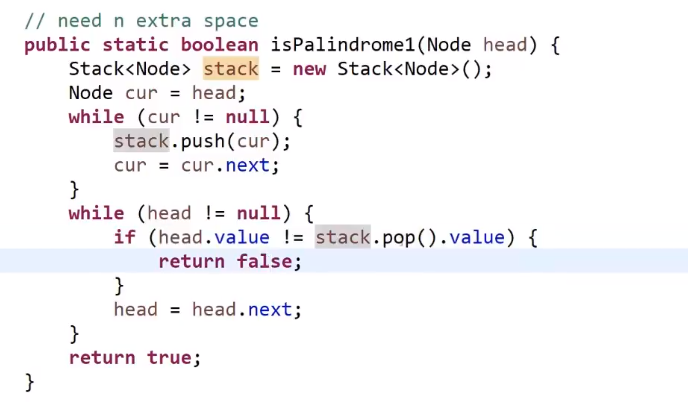

# 比较器和 java 底层的排序操作

就是一般:

- return 第一个参数 - 第二个参数,那么就是从小到大排 (貌似)

- return 第二个参数 - 第一个参数,那么就是从大到小排 (貌似)

- java 的 priority queue 直接用默认是小根堆,要是想要大根堆就要创建个类实现 comparator 接口重写 compare 方法并把那个类实例化传给 priority queue 的构造函数才可以实现实例化出来的 priority queue 是别样的,比如说大根堆,或者我们那个 priority queue 放我们自定义的类,也可以按照我们的某个属性 (我们定的规则) 来吧对应的放到堆顶

- 就是如果那个 compare 方法返回正数代表第一个参数 (或者那个类的某个属性的值等等等) 在顶堆,返回负数第一个参数放上面等等等

大根堆就是第二个减第一个参数就行了,如果是正数说明会把第二个放到堆顶,第二个数更大,所以放堆顶是大根堆

还可以自己自定义各种复杂的比较策略

java 底层的排序操作:

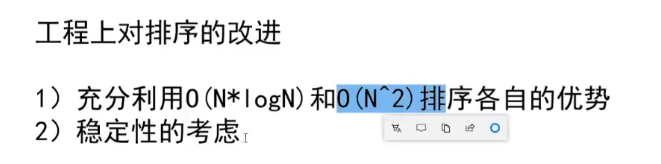

size 大于 60 时 使用 merge 和 quick 进行综合排序,如果小于 60,系统默认使用插入排序以求最快速度完成。

自己定义的 class 类型排序时,会使用 merge 排序, 为什么???原因当然是稳定性,自己定义的类型一般会想要稳定性的,快排又做不到稳定性。

这是因为小样本量的时候,N 平方没那么起的快,反之插入排序的常数系数啥的更低,所以小样本量的时候用这些 N 平方更快一些些,按照情况使用不同排序的优点

比如说

# 链表问题

# 找出两个有序链表共同值的节点

- 一个指针指向第一个链表头,另外一个指向第二个链表头

- 比大小,谁更小谁移动到下一个

- 如果遇到一样的,记录那个一样的,然后共同移动 (两个都往下一个移,说不定还有一样的)

- 任何一个链表到头了,结束

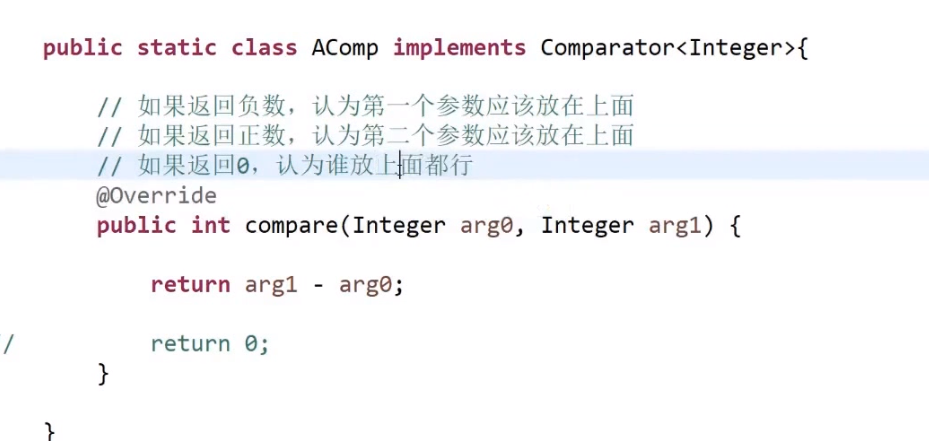

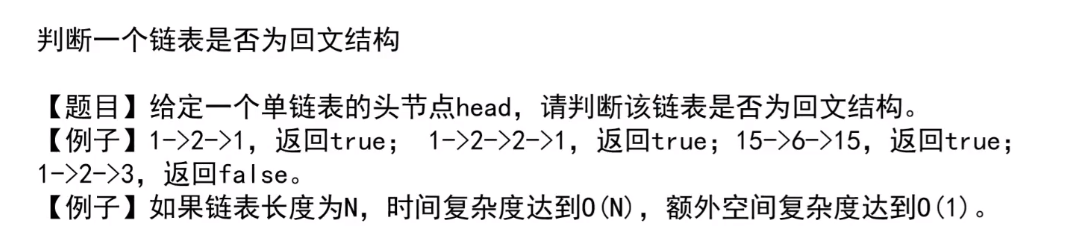

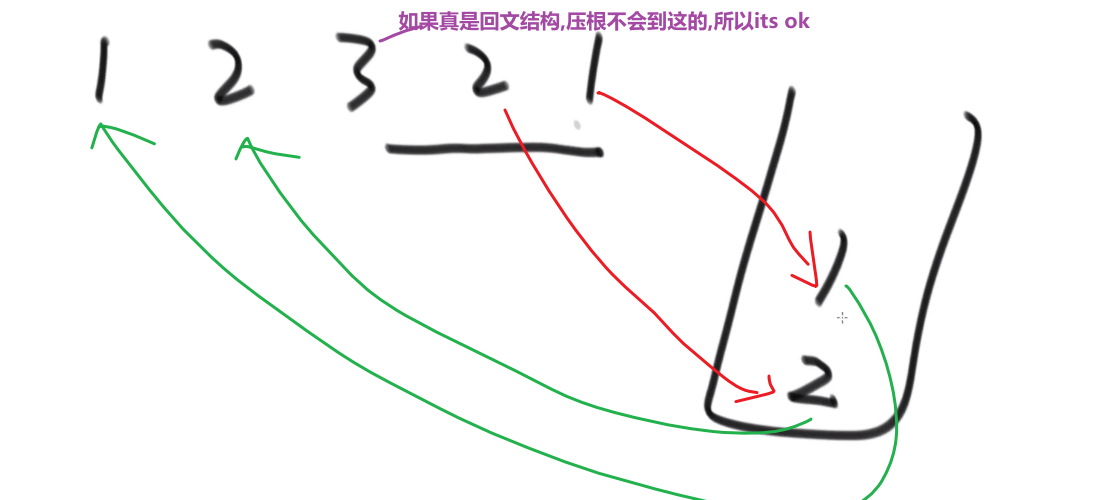

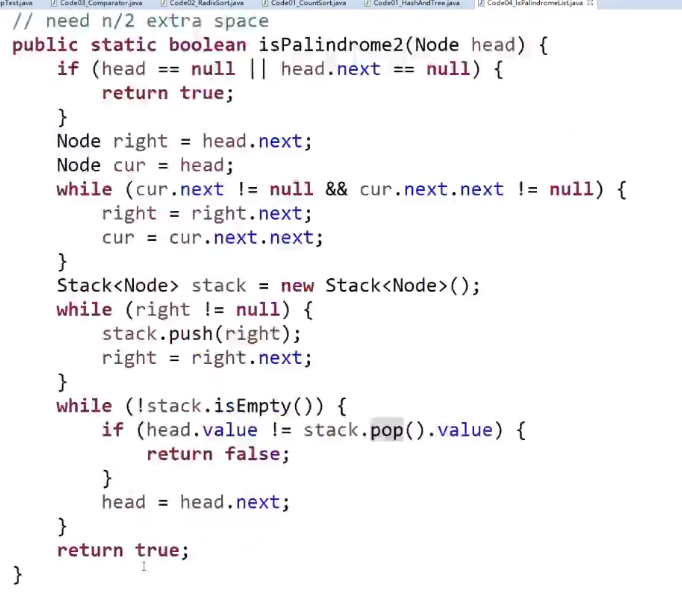

# 两个链表是否有回文结构

使用额外空间方式:

- 把每一个元素放入栈里面

- 从栈取出的顺序就是链表的逆序,我们边弹出边比较一不一样,如果回文结构一定一样,所以直到栈弹空要是还是都一样那么就回文

- 如果有一步不一样,就不是回文

稍微再省一些空间的方法:

- 把链表右边的放在栈里面,然后再跟链表前一半比

- 栈只要弹空了就停

- 因为要是是回文结构,不管链表有的元素是不是偶数或者奇数个,反正比了左边和右边就会是一样的,就算是奇数个也不会 reach 到中间那个

但是我们怎么做到只把右边的放入栈?

快慢指针!

- 快指针比如说一次走两步

- 慢指针比如说一次走两步

- 这样最后快指针最后指向最后一个,慢指针差不多指到中间位置

这些快慢指针可以自己任何定制,按照自己想要的方式实现

我们想要

- 如果链表奇数个节点,我们慢指针指向中间那个

- 如果链表偶数个节点,我们慢指针指向中间的左边那个

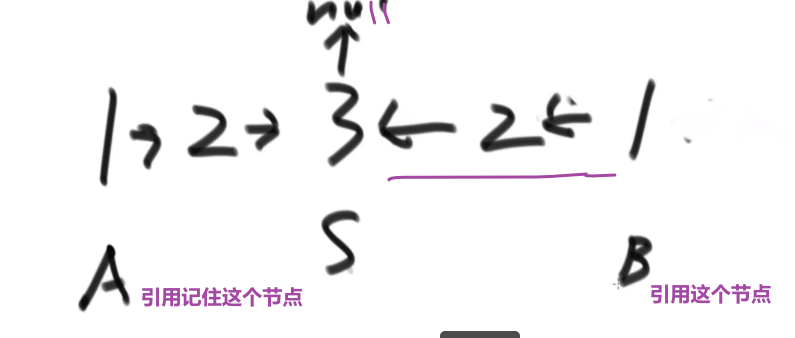

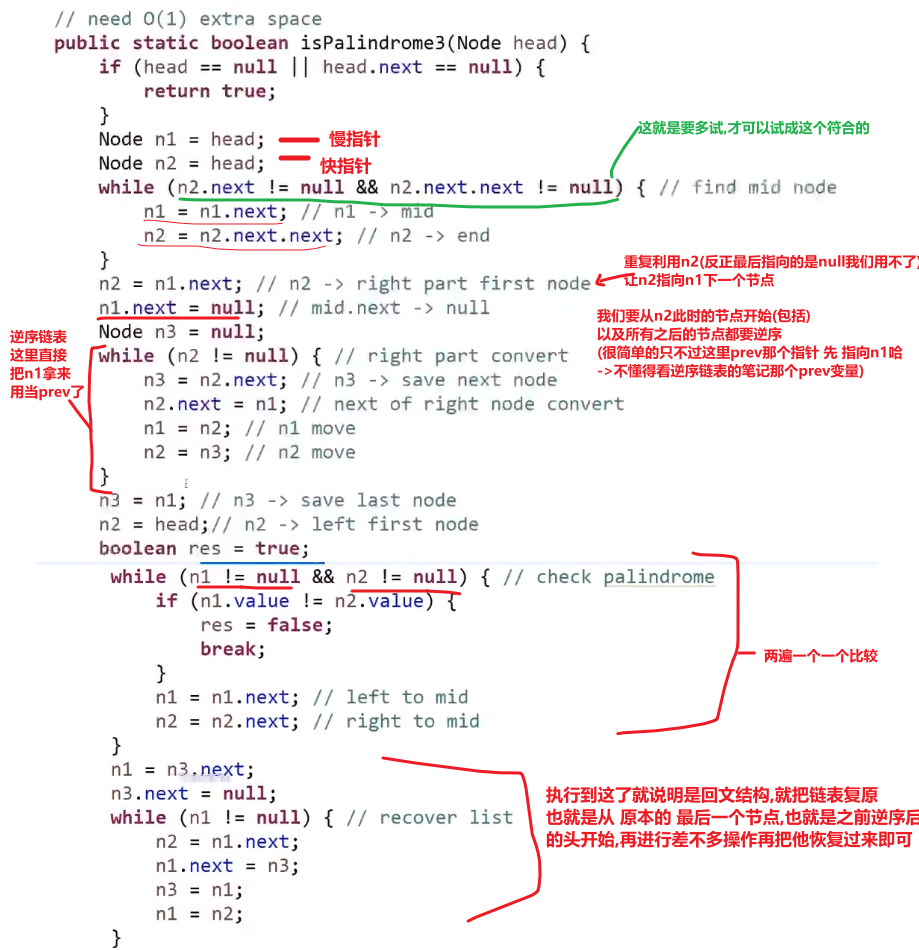

超级省空间的方法 (面试做的时候很加分):

- 快慢指针,最后让慢指针指向差不多中间位置

- 中间那个节点的 next 指向 null

- 然后让那个节点后面的节点都逆序

然后再 A 指针和 B 指针挨个比,一样的话就一块走下一个,如果有一个不一样就返回 false

一直到最后有任何一个为空 (null), 就停止,就说明最终结果就是回文结构

注意如果最后返回 true 的话,有时候需要把链表的指向恢复一下,看需求吧

这个对于偶数次的节点的链表也可以!自己想象一下!

这个方法就有限几个变量,最省空间的!!!

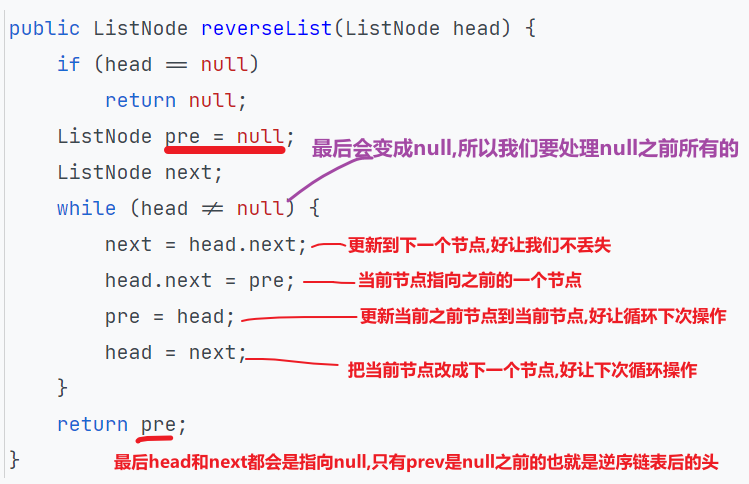

# 逆序链表

还有什么递归方式等等等

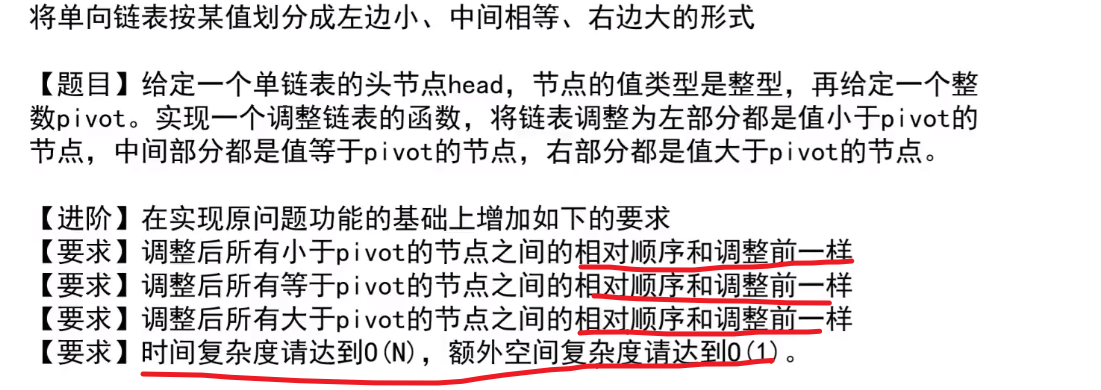

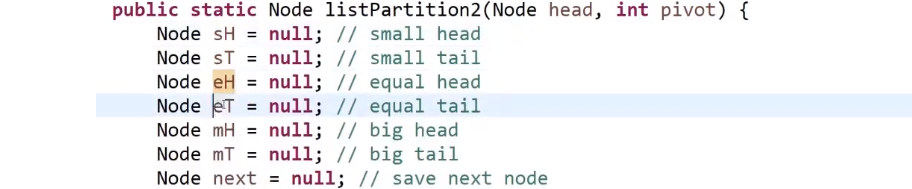

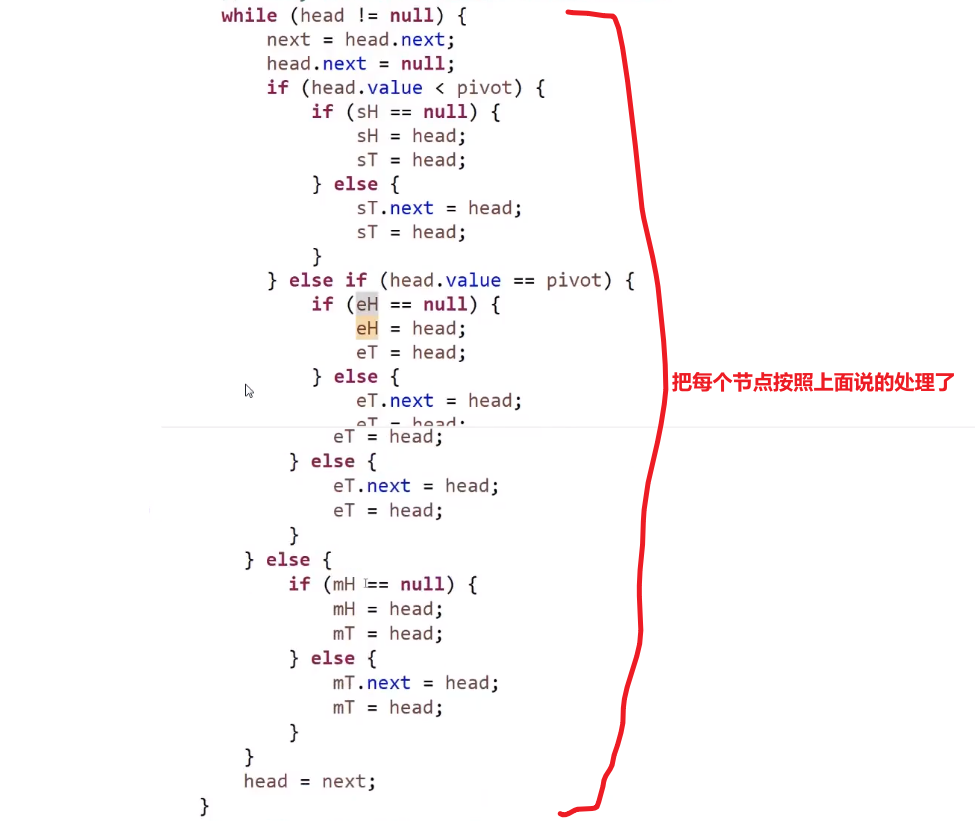

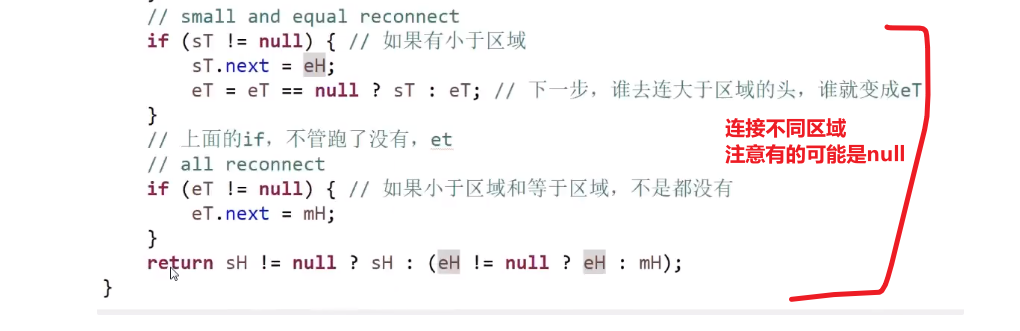

# 单链表按某值划分左边小,中间相等,右边大的形式

笔试里面做法:

把链表里面的数放到__Node 类型的__数组里面去,然后对数组玩 partition, 然后再把数组里面的数放回链表就行了

面试里面做法 (省空间!):

有很多类似于这种的问题,要多想想类似的看看这个解法适不适用

有些复杂我们用一个例子来讲解答案:

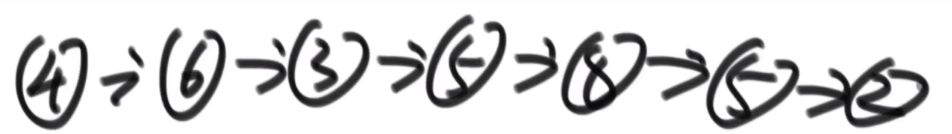

链表:

对于划分的值是⑤

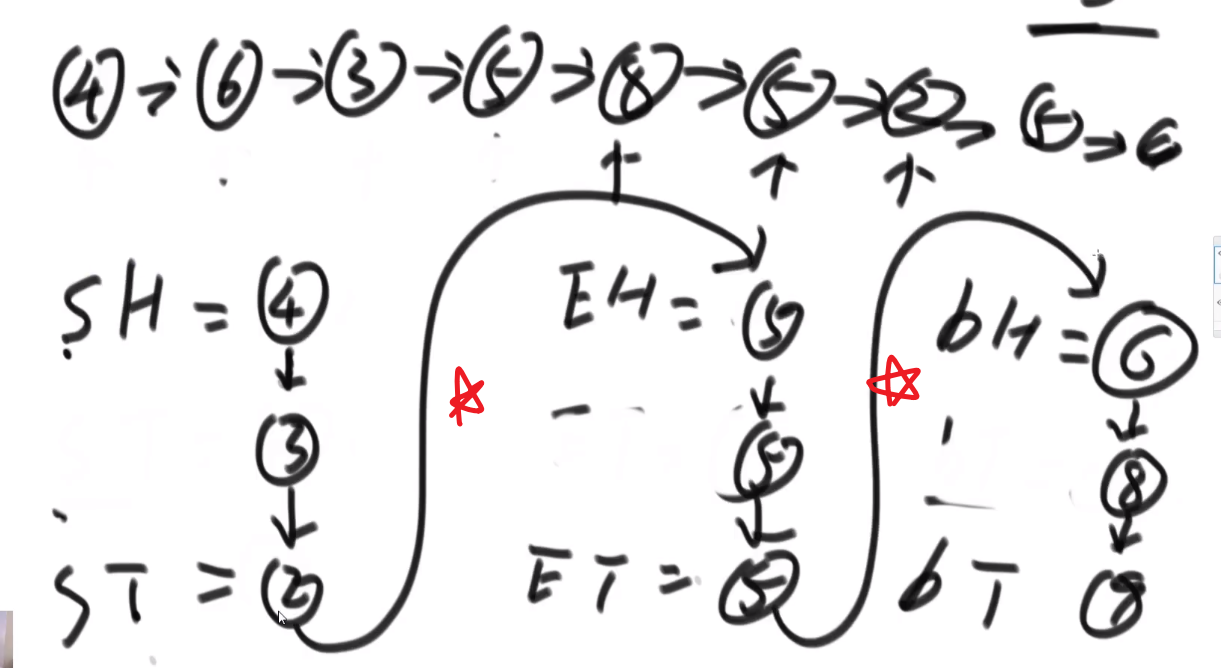

需要六个变量:

| 变量名 | 等于什么 |

|---|---|

| SH (一开始是 null) | 小于部分的头 |

| ST (一开始是 null) | 小于部分的尾 |

| EH (一开始是 null) | 等于部分的头 |

| ET (一开始是 null) | 等于部分的尾 |

| BH (一开始是 null) | 大于部分的头 |

| BT (一开始是 null) | 大于部分的尾 |

- 首先第一个节点④, 发现比我们的⑤小,所以让 SH 和 ST④

- 下一个节点⑥, 发现比我们的⑤大,所以让 BH 和 BT⑥

- 下一个节点③, 发现比我们的⑤小,所以让 ST 当前指向的节点④指向③, 然后让 ST 指向③(SH 不要动之后只有是一开始 null 的时候才会被第一个更新)

- 下一个节点⑤, 发现跟我们的⑤相等,所以让 EH 和 ET 都指向这个当前找到的⑤!!! 需要这个,因为可能有多个,我们要串起来所有相等的,然后让头代表第一个,尾代表最后一个 (可以看出是稳定的,保持了顺序,小于区域和大于区域都是同理)

- 等等等

- 最后就是:

- ST 的当前指向的节点的 next 指向 EH

- ET 的当前指向的节点的 next 指向 BH

== 不过注意!!!== 可能压根没有小于区域,可能压根没有等于区域,可能压根没有大于区域!!!

所以只有不是 null 的时候才可以调用 next 连,如果有一个是 null, 需要连下一个区域等等等

完成,结束!

我们相当于用很多指针 (基本上就是两个指针一个头一个尾代表一个区域,然后可能有多个这种对子), 然后我们就可以按照我们想来的规则把代表不同区域的指针头和尾指向不同节点 (期间需要如果那个区域的尾指针要换成别的,就让当前的尾指针 (如果不是 null) 的 next 指向新的那个,这样才能全部最终正确得串起来)

说到底就是那个链表,我们只是对节点的 next 改变就可以做很多事请

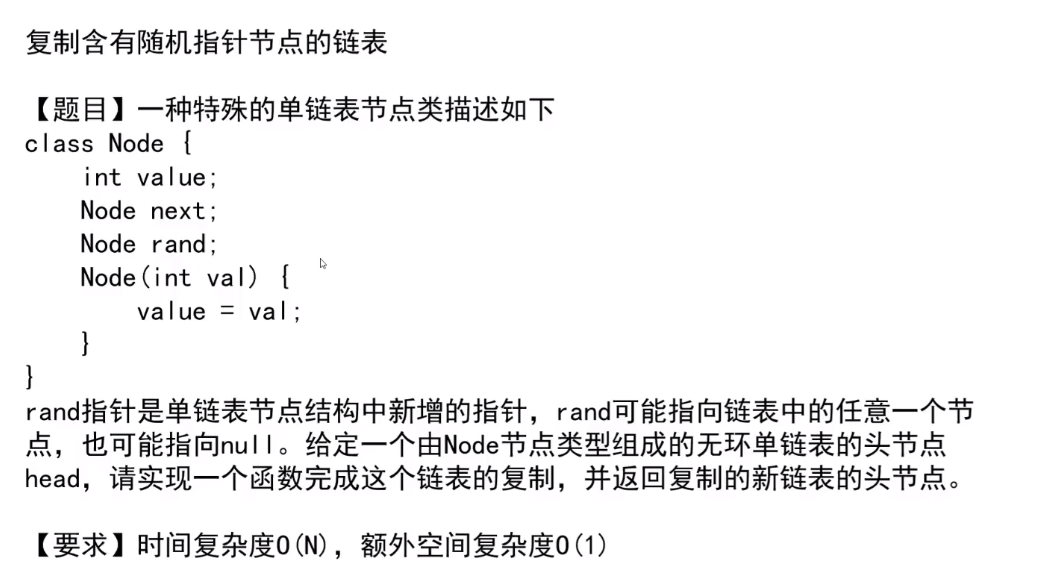

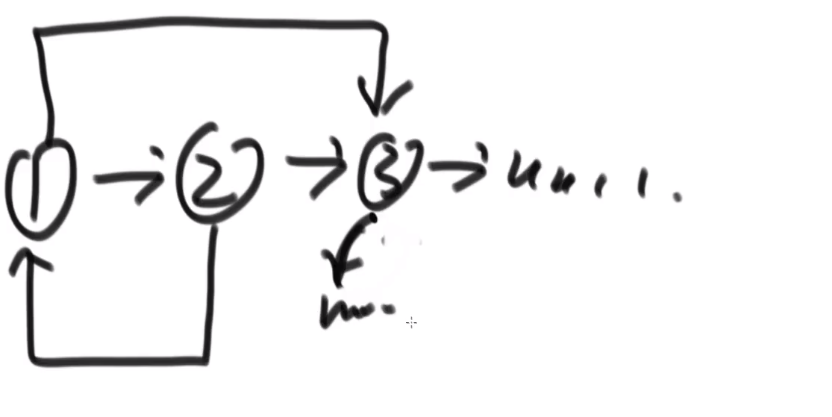

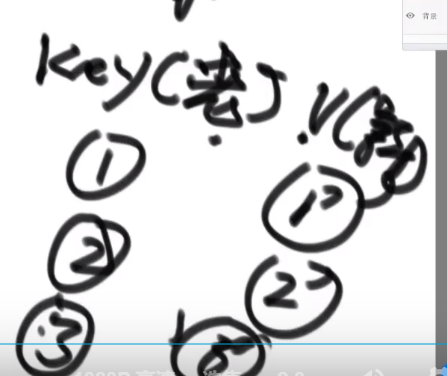

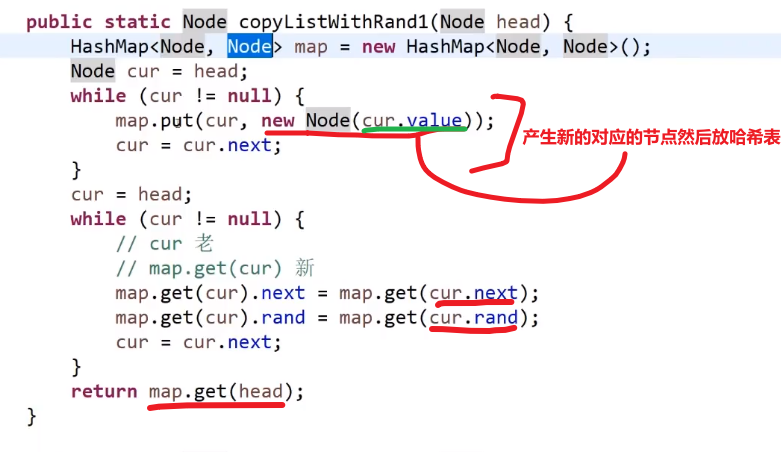

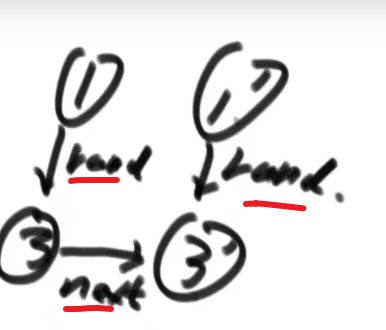

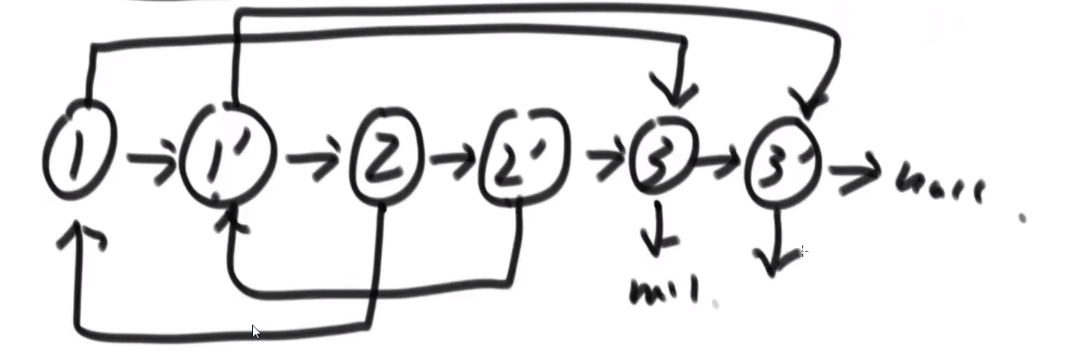

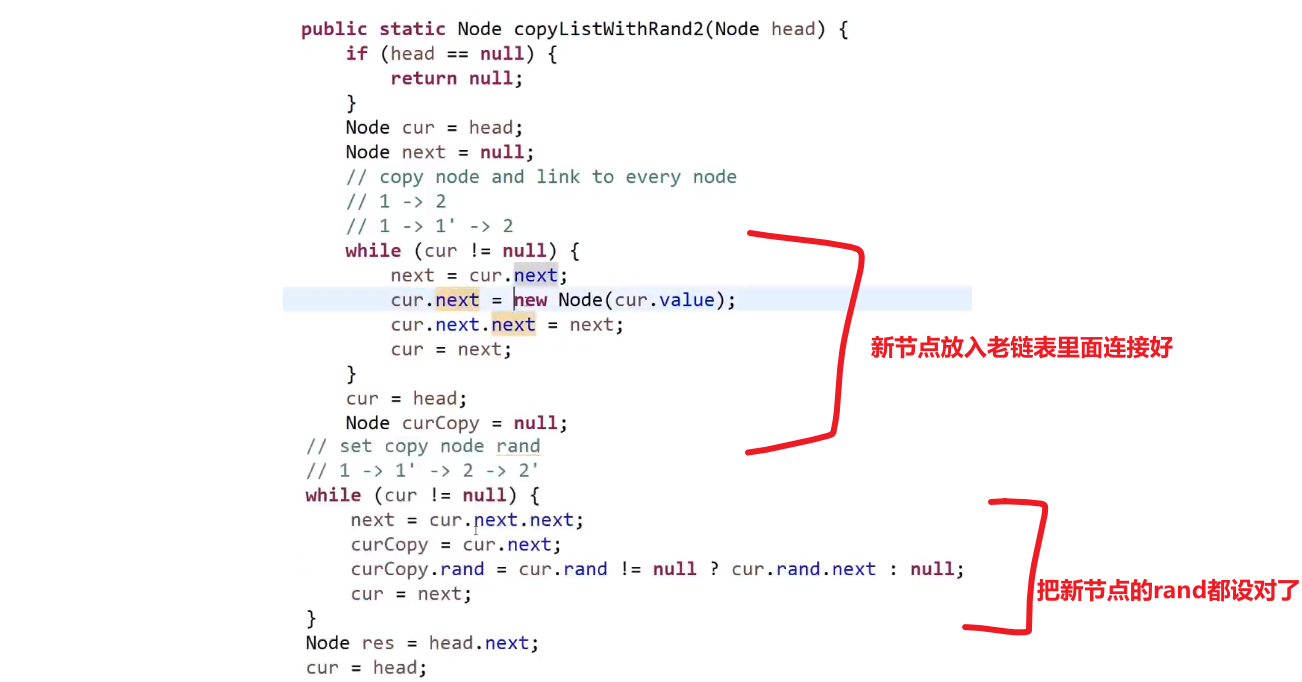

# 复制含有随机指针的链表

比如说:

使用比较多额外空间方式:

哈希表!HashMap!

- 遍历原来的链表,我们只需要把原来的链表的节点 (的指针) 和对应的新链表的新建的节点 (的指针) 作为 key 和 value 存入 hashMap

- 遍历老链表,或者遍历哈希表

- 对于每一个哈希表里面的值也就是新链表的节点的指针,我们让他的 next 指向这个新节点对应的 key (也就是老节点的指针) 的 next 指向的节点在哈希表里面对应的值,然后让他的 rand 指向这个新节点对应的 key (也就是老节点的指针) 的 rand 指向的节点在哈希表里面对应的值,就可以了

我们产生了一个 mapping (自己造的次) 相当于,就大概理念就这样!

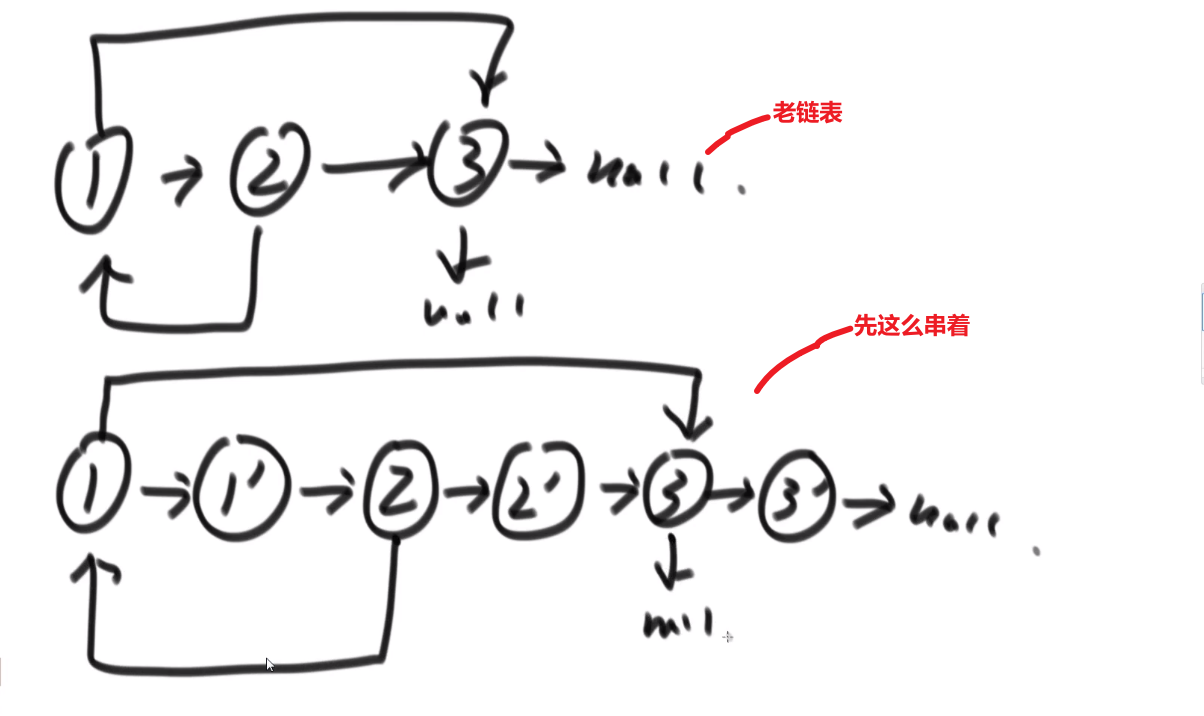

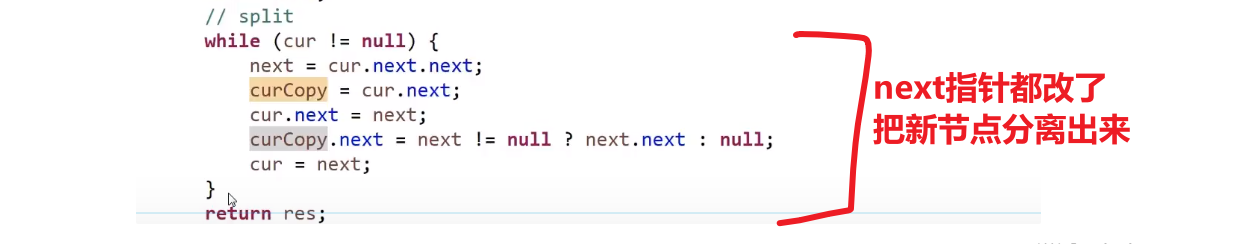

不使用比较多额外空间方式:

- 生成一个个新节点,但是我们让他们跟老链表的节点这么串起来

- 我们让每一个新生成的节点的 rand 指针指向当前这个新节点对应的老节点的 rand 指向的节点的 next

反正这种想法就是让老的节点和旧的产生连接,这样我们就可以按照老节点的方式连的连我们自己的这个新节点,毕竟我们想要的是复制嘛,肯定是照着来啊

- 这么做后,就会成这样:

- 接着就把 next 改变,让新链表从这里分离出来

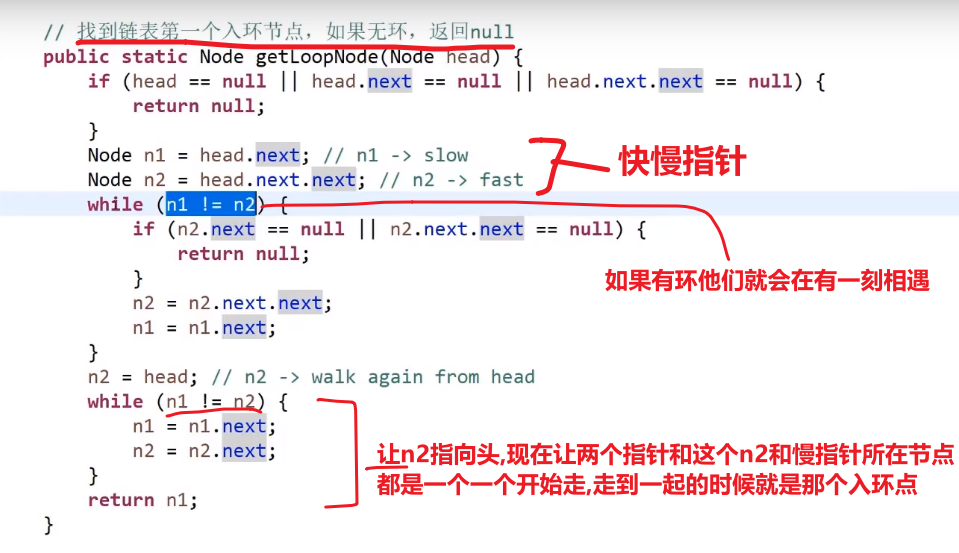

# 一个链表是否有环,如果有怎么找到入环点

一个有环的链表,和他的入环节点:

可以发现有环的最终不会指向 null, 所以最后要是走到了 null, 说明肯定没有环

使用 HashSet 方式很容易:

- 每个节点 (存节点的 HashSet, 不是节点的值!!) 存入哈希表之前先看看是不是已经有了,如果没有才存,如果有说明有环

不适用那么多额外空间的方式:

* 快慢指针!!!*

链表好多都是快慢指针和哈希表解法啊

- 两个指针方法,快指针慢指针

- 如果一个链表有环 (说明最终不会指向 null)

- 那么快指针一下走两步,满指针一下走一步

- 他们肯定会在有环的部分相遇的! 并且满指针和快指针在环中转的圈数不会大于两次以上!!!

- 这个时候!接着让快指针指向 head, 然后跟慢指针一样一步一步走,直到他们相遇,他们相遇的那个节点一定是链表入环的节点!!!

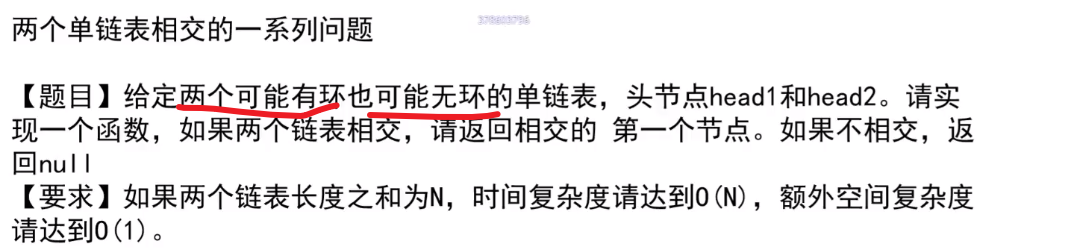

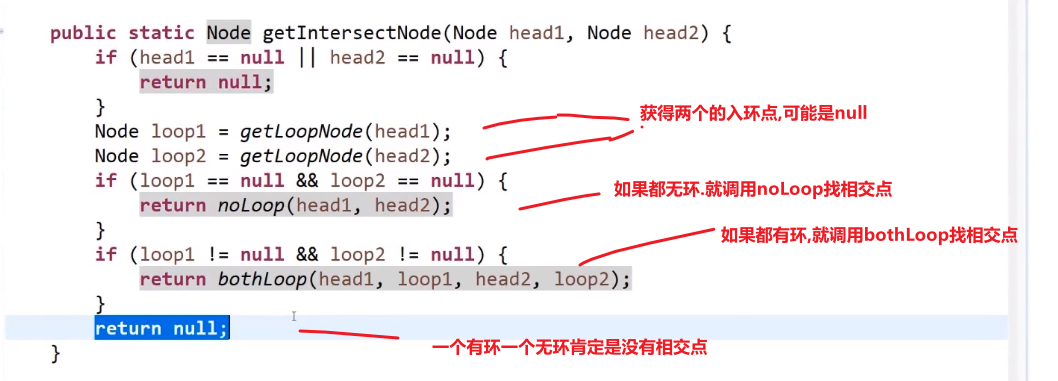

# 两个单链表相交

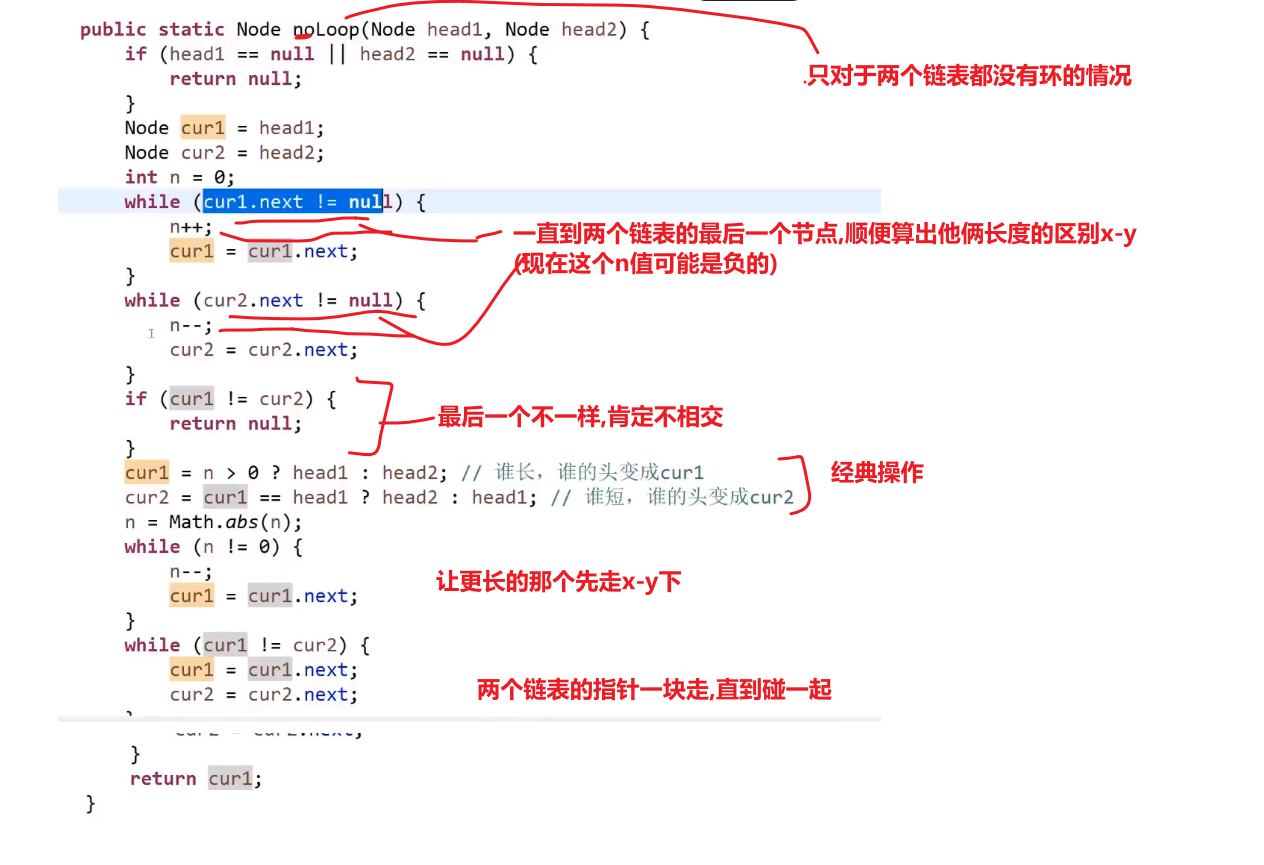

# 如果两条链表都无环

用 set 方式:

第一条链表节点都入 set,第二条链表查,查到重复即为相交节点

不用 set:

- 遍历第一条链表,记录最后一个节点,且记录链表长度 (长度记作 x)

- 遍历第二条链表,记录最后一个节点,且记录链表长度 (长度记作 y)

- 如果两个最后节点不同,则不相交 —> 如果相交最后一个节点肯定会是一样的

- 如果最后一个节点是一样的,那么 x 与 y 大的先开始走, 走 x-y 步 (如果相交,那么共享的部分肯定不会出现在那个 x-y 步里面,因为后面的长度都会是共享的部分,细品,细细品)

- 然后那个长的那个走完 x-y 步后,两条链表一起走,某一刻肯定会在相交的节点相遇

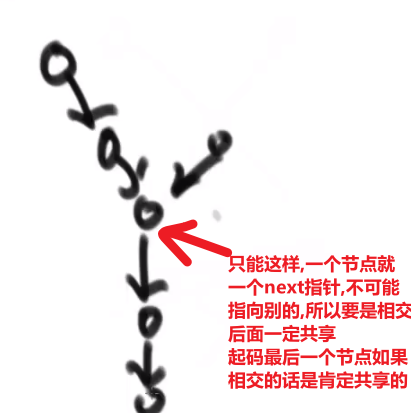

# 如果一条链表无环一条节点无环

这种情况绝对不会发生,因为只有 next 一个指针,只能最终指向一个方向

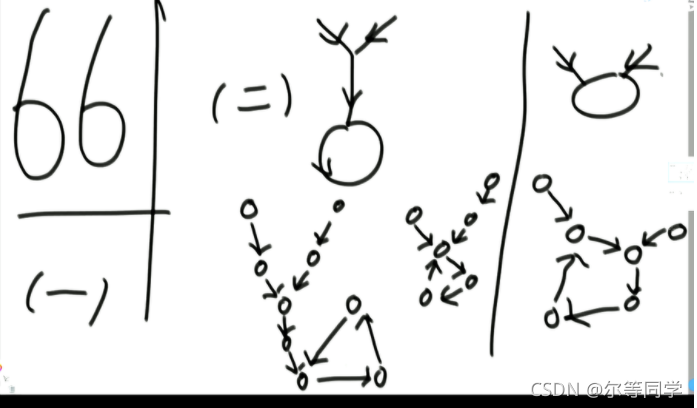

# 两个都有环

如果两个有环链表相交,那他们一定是共用这个环

一共有三种情况

- 两个有环但是不相交

- 两个有环且相交点是同一个

- 两个有环且是靠着环来相交的 (这里我们认为任何一个链表的入环点就是相交点)

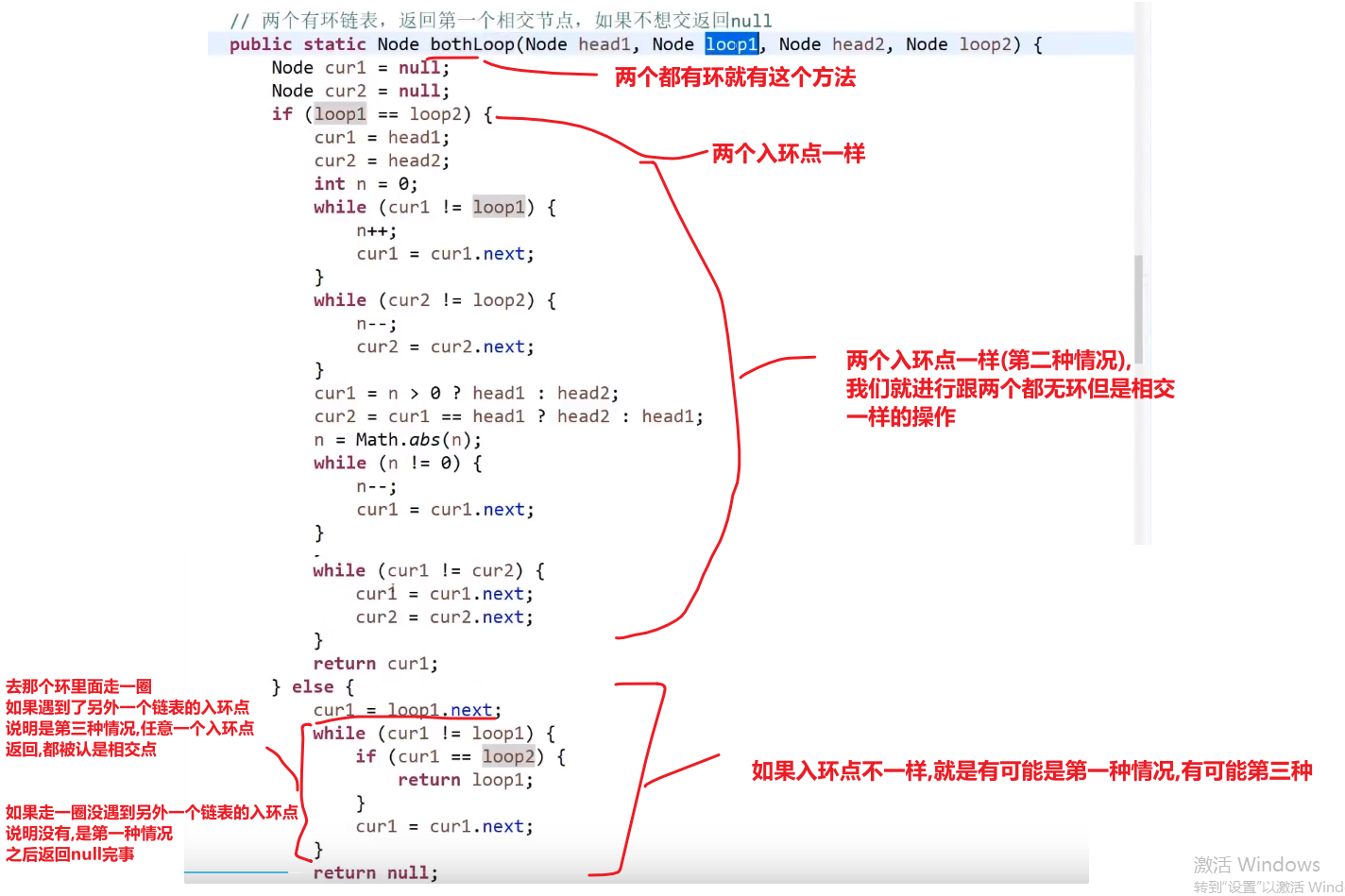

-

如果 loop1 (第一个链表的入环点) 的内存地址等于 loop2 (第二个链表的入环点) 的内存地址 -> 则为第二种情况 (两个入环节点一样)

- 那我们就用无环的方式就行了,差不太多的

-

如果 loop 1 不等于 loop 2

- 让 loop1 沿着环走,如果没有遇到 loop2 则为第一种情况,也就是没有相交

- 如果遇到了 loop2 就是第三种情况 (两个入环节点不一样)

- 无非就是有了两个头节点和两个链表的入环节点

- 如果入环节点一样,说明是第二种情况,就按照我们无环的做法一样就行,长的先走 x-y 步,然后两个一起一块走,一直走到一样的说明找到了相交点 (* 这个不一定他们的入环点,因为可能入环点之前就相交了,参考第二种情况的图片!!!*)

- 如果如环节点不一样,我们就 while loop 让那个 loop1 入环节点走一圈,如果这一圈没遇到和另外一个 loop2 入换节点,说明是情况 1, 如果遇到了一样的说明是情况 3-> 返回 loop1 或者 loop2 都行,都叫做第一个相交的节点

# 能不能不给单链表的头节点,只给想要删除的节点,就能做到在链表上把这个点删掉?

抖机灵

- 将删除节点的下一个结点的值赋值给删除节点

- 然后将删除节点的 next 指向下一个节点的下一个节点

- 然后删除下一个节点就行了

注意这个不能删除最后一个节点

# 二叉树问题

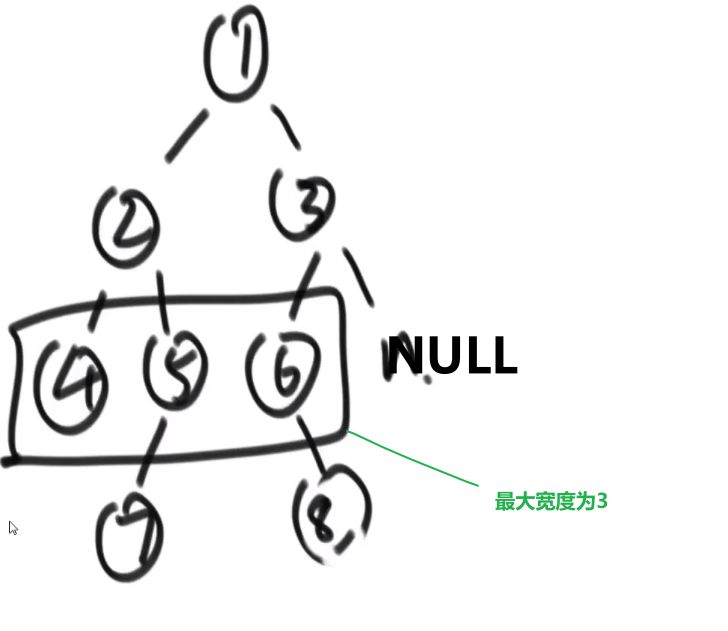

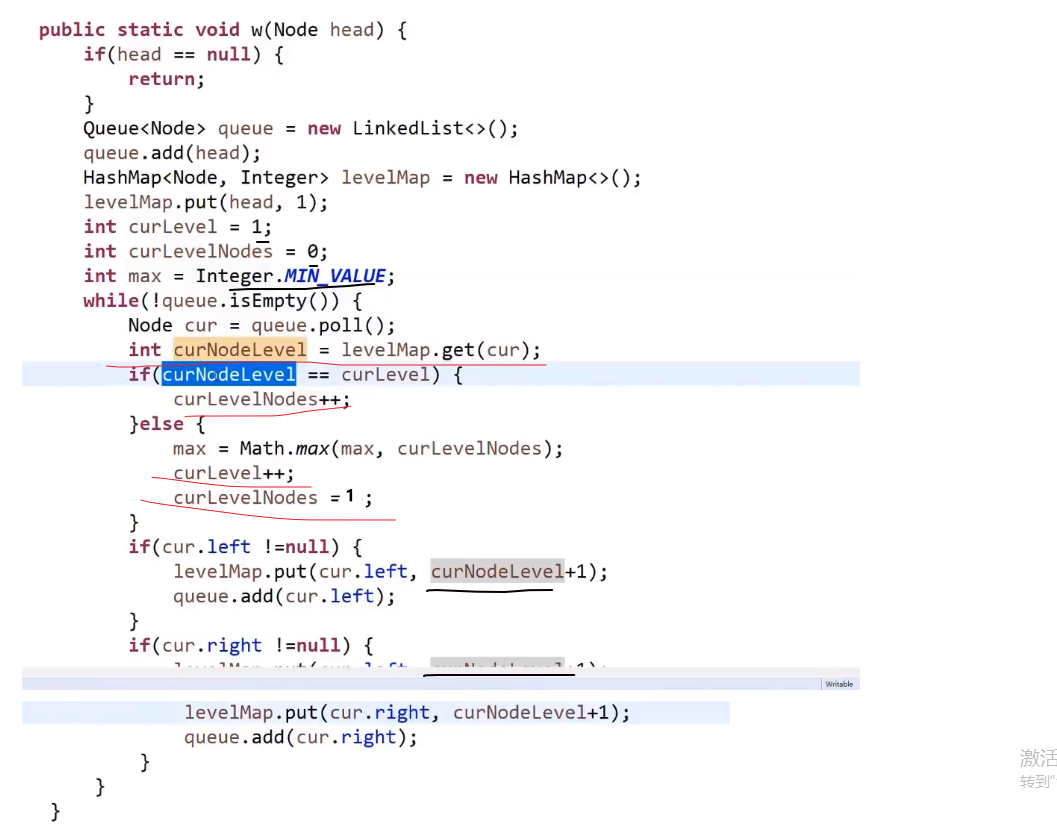

# 求一个二叉树的最大宽度

比如说:

我们只需要在宽度遍历的时候能知道当前的节点是第几层就能开始计数了

使用 hashMap!

下面的听个大概意思就行,不需要死记硬背

- 一开始我们把那个头节点插入到队列中,我们也 put 一个 key 为那个头节点然后 value 为 1 (代表第 1 层) 到 hashMap 里面去

- 到了我们循环里面,每次我们让一个节点出列,我们就靠这个节点来查 hashMap 里面对应的 value, 也就是那个出列的节点的值

- 如果取出的值跟我们当前操作的层次 (一开始设置为了 1) 一样,那么就说明当前是同一层的节点,我们就让保存那一层节点数量的变量 ++

- 如果取出的值跟我们当前操作的层次 (一开始设置为了 1) 不一样,那么就说明当前是下一层的节点,说明上一层我们那个那一层节点数量的变量已经是计算完了那一层的数量

- 我们就需要计算看这个跟我们当前用变量 max (一开始设置为了数字最小值) 比,如果更大,就要更新 max 值

- 并且我们还需要把那个当前层数的变量 ++

- 然后清空当前层一共多少节点的那个变量设置为 1 (因为当前就是这一层的节点,所以发现了一个)

- 然后就是之前的宽度遍历部分先让非空左节点的进队列

- 我们把这个非空左节点作为 key 存入 hashmap, 他的 value 就是当前保存层数的变量 + 1

- 再让非空右节点的进队列

- 我们把这个非空右节点作为 key 存入 hashmap, 他的 value 就是当前保存层数的变量 + 1

上面代码有点 bug, 比如说出列最后一个节点时,可能会没有到 Math.max (那里比较), 也就是没有比较最后一层

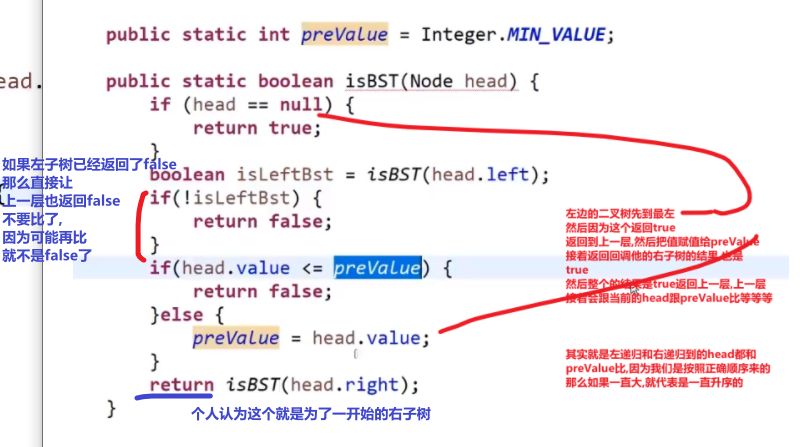

# 如何判断一颗二叉树是否是搜索二叉树

搜索二叉树就是每一颗子树,他的左孩子都要比头小,他的右孩子都要比头大

经典的搜索二叉树没有重复的

答案:

我们直接使用中序递归–> 左中右,如果是搜索二叉树,那么最后中序递归出来的顺序一定是升序的

如果某个点不是升序的,那就不是搜索二叉树

递归方法:

递归的想法就是把问题缩小到你最关心的大小上,比如说这里最主要的是每一个节点 (mergesort 最小的就是两个连着的元素,等等等), 然后这里这个可能不是最小的,比如说 leaf 也是一个节点,但他的左孩子和右孩子是 null, 我们一般不会用到 null 做什么处理,就测如果 head==null 那就怎么怎么样直接返回等或者返回 true/false. 这样就足够了,因为回调自己的 null 左 / 右子节点都会遇到这个。接着就是在合适的顺序,处理那个那个你关心的最小单位,爱这里处理你只要关心你那关心的节点就好了 (可能一个,可能两个,等等等), 当然他们的结果可能是当前回调自己参数传进来的,可能是来自之前回调自己的结果等等等,反正你可能会有多个自己的调用,顺序很重要,返回值也重要!

我们把关心的那个范围的节点处理好了,我们只要保证其他节点 (或其他) 都要经过我们设置的操作就行,如果是返回什么值,一定要注意所有可能性,有没有需要多些 if 看看情况等等

就是我们左边子树需要先判断,也就是一直到左节点,这里我们再跟我们那个比较逻辑比,然后返回上一层,上一层会调用右边的逻辑也是那一层的 head 比 (还没必过!) 然后让右子树也这么做,要是都对了返回 true 到他的上一层,到了这一层又要拿那一层的 head 跟那个比,然后右子树也这么做 (因为还没处理过).

但是我们如果这整个有哪个返回 false, 我们直接作为上一层的左子树调用,返回了 false, 然后我们那个一层还没判断这个左边的是不是 false 就直接拿他的一层的 head 比较,万一比过了,那就是 true 了,明明他的左子树没有符合,但他这一层却把整个他所代表的他自己 (head) 和他子树的结果返回为 true 了,这肯定不对!!!我们要先测左边的对不对,要是不对,直接让这个一整层就返回 false,head 也不用比了,右子树也不用比了,直接一直返回到一开始的 (栈底) 的那个一层然后直接返回 false 作为整个方法的结果.

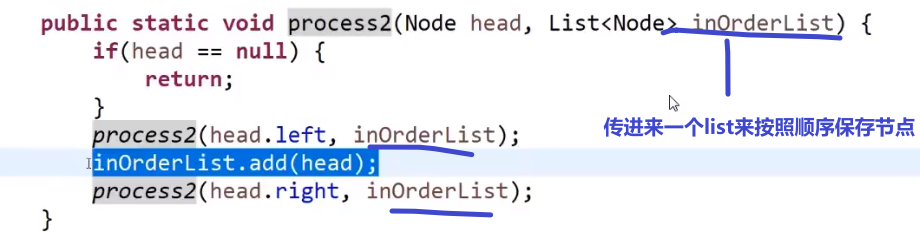

比较费空间的写法:

然后再主函数调用这个方法传参数,接着我们只要对那个传进去的 list 在这个方法结束后遍历一下,看看是不是升序的就行了

非递归方法:

同理:我们当然可以做到–> 后头左,这个样子的中序,看你什么需求了

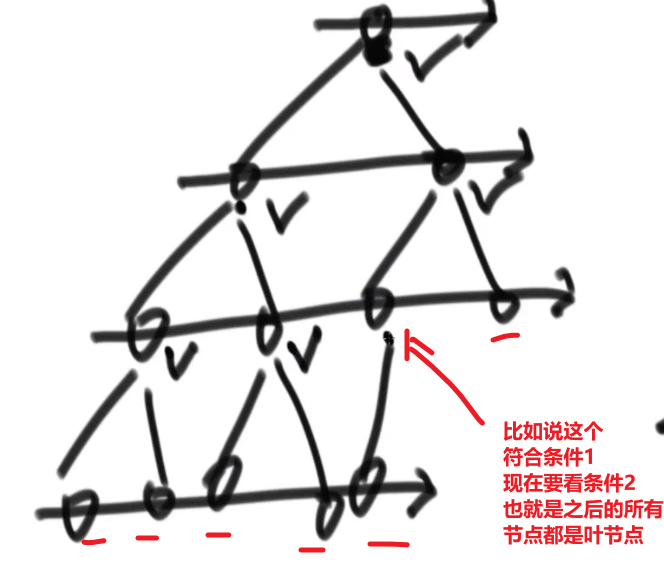

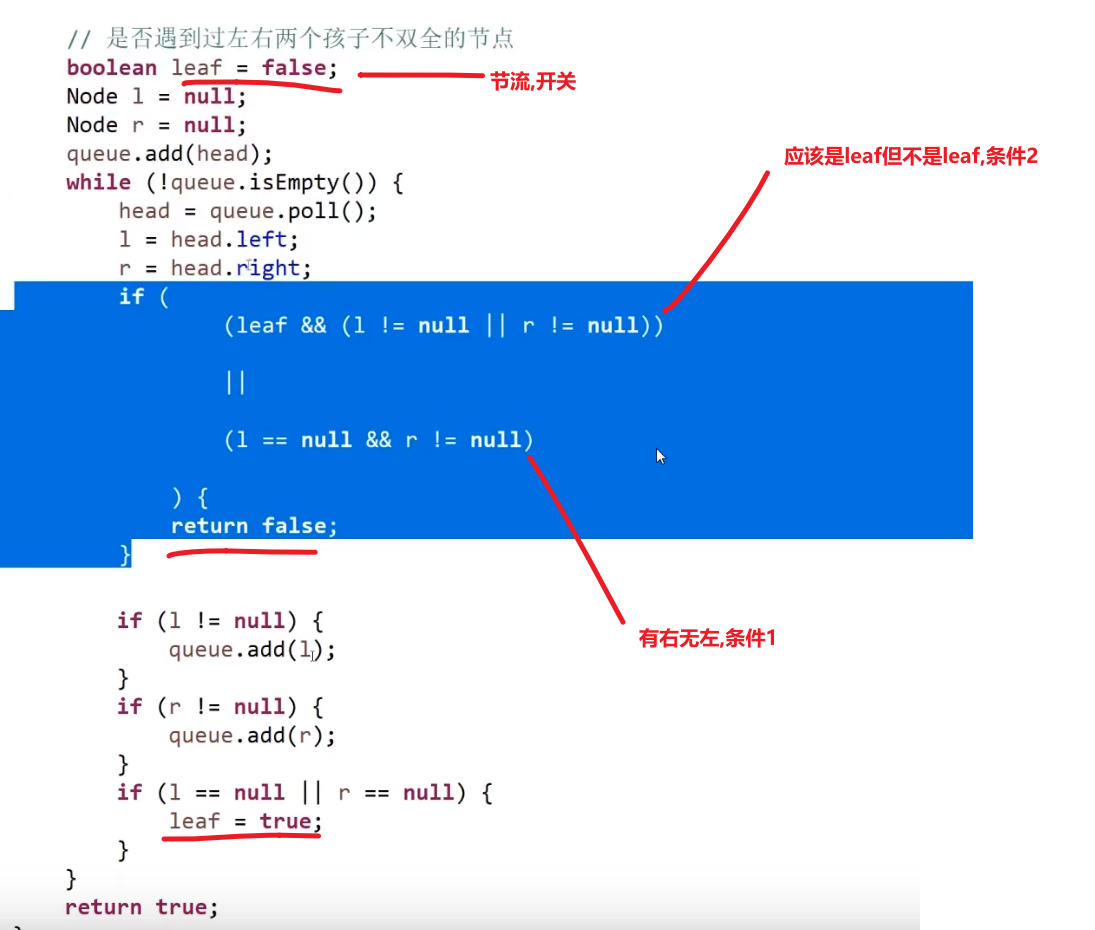

# 如何判断一颗二叉树是否是完全二叉树

完全二叉树就是要么全满,要么左边往右填,右边的还没满

答案: 使用宽度遍历!

- 遇到的每一个节点,如果这个节点有右孩子没有左孩子,直接返回 false

- 在第一个条件不违规的情况下,如果遇到的第一个节点他要么只有左孩子,或者两个都没有 (复合第一个条件), 那么之后的所有节点都必须是叶节点,如果不是则返回 false, 如果都是返回 true

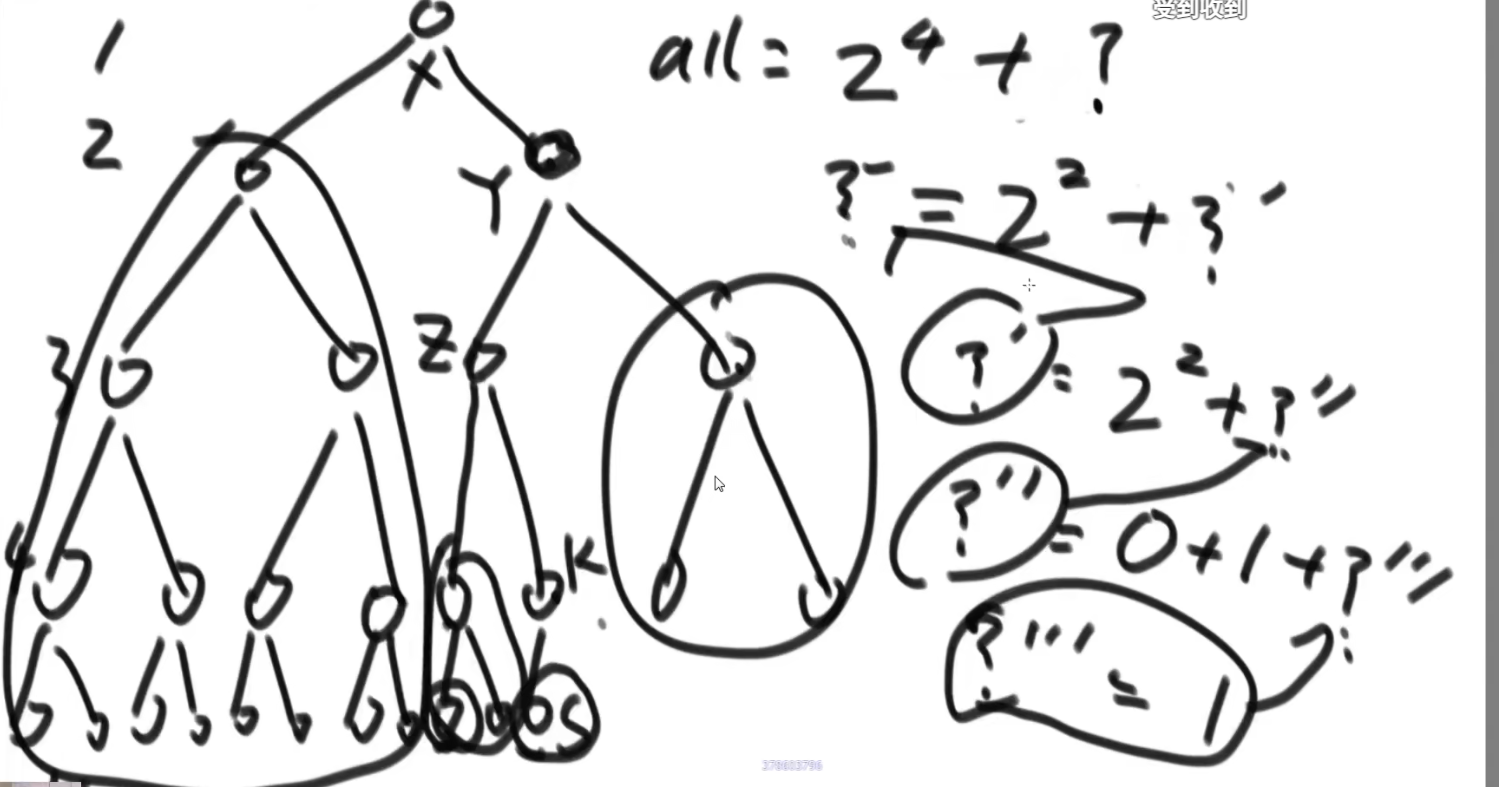

# 如何判断一颗二叉树是否是满二叉树

麻烦但好理解的做法:

- 有个函数统计这个树的最大深度 (D)

- 有个函数统计这个树的节点个数 (N)

满二叉树一定符合 N = 2D-1

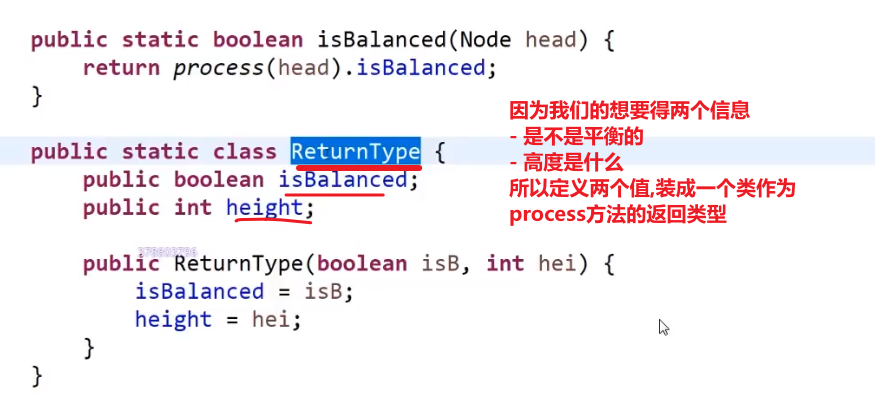

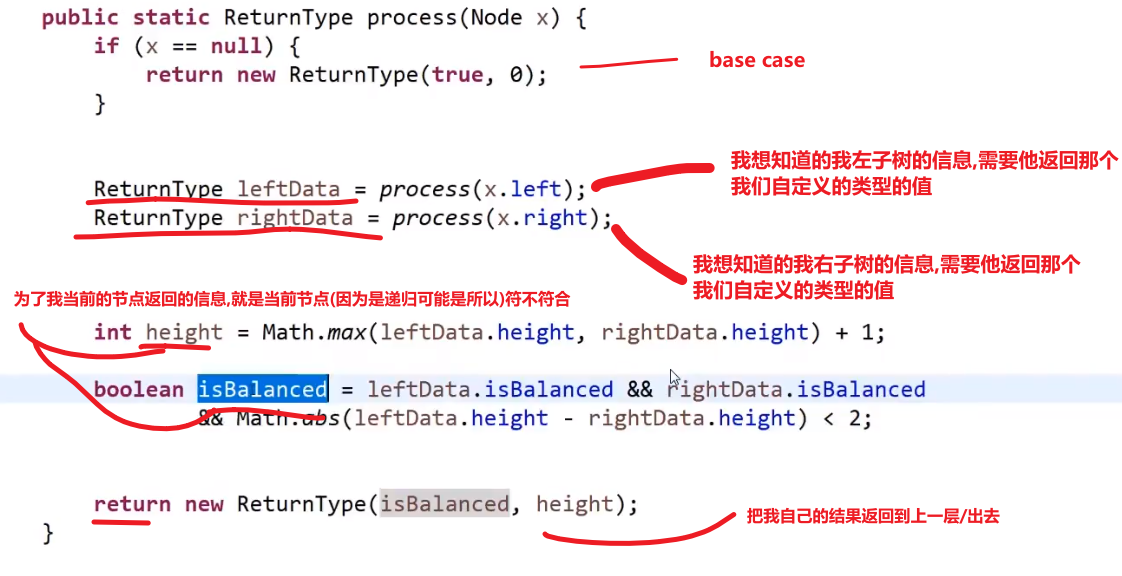

# 如何判断一颗二叉树是否是平衡二叉树 (以及树型 dp 套路介绍⭐️重要!!!)

这里就可以说到了二叉树题目 (判断是不是满二叉树,是不是搜索二叉树等等等) 的套路!注意这里的逻辑,很重要!以后遇到问题这么来没差

平衡二叉树就是对于任何一个子树来说,他的左子树的层数和他的右子树的层数相差最多为 1

对于一个头节点来说

- 他的左子树是平衡的

- 他的右子树是平衡的

- 然后 | 左高 - 右高 | <= 1

才可以代表这棵树是平衡二叉树

所以我们需要

- 左边是不是平的?以及高度是多少?

- 右边是不是平的?以及高度是多少?

所以我知道,左树和右树需求是一样的,那就递归

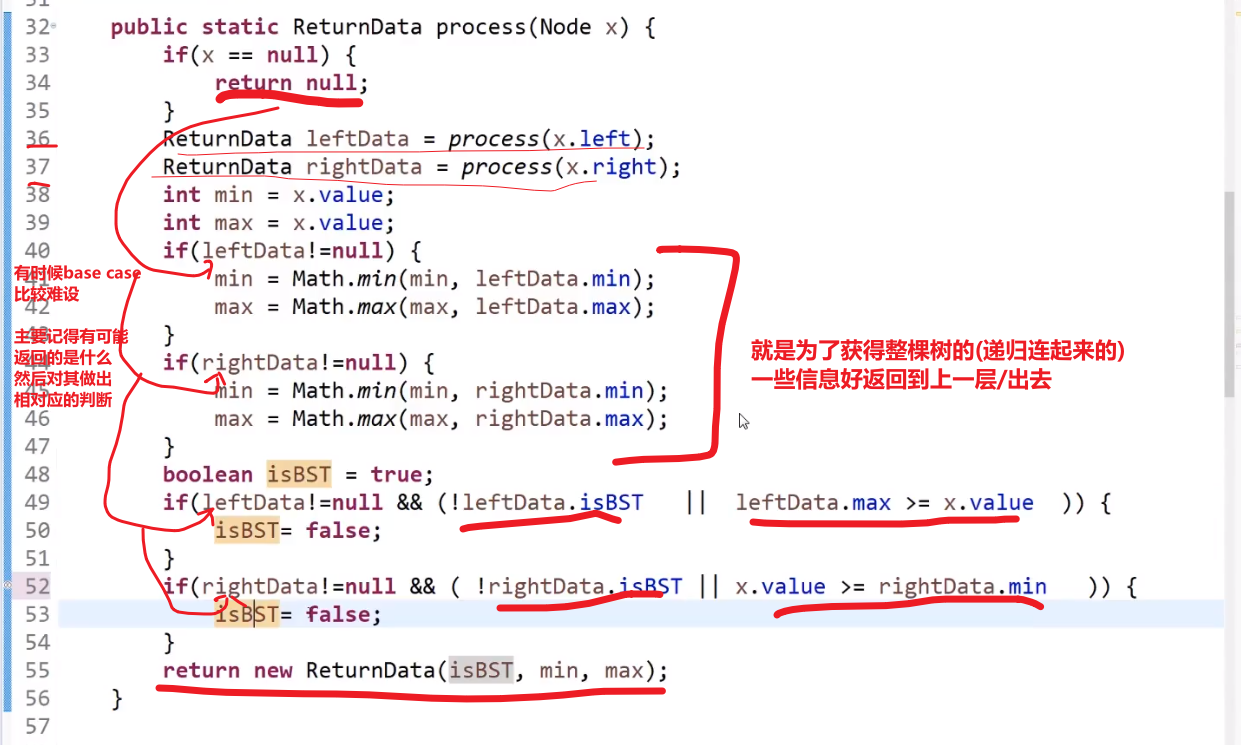

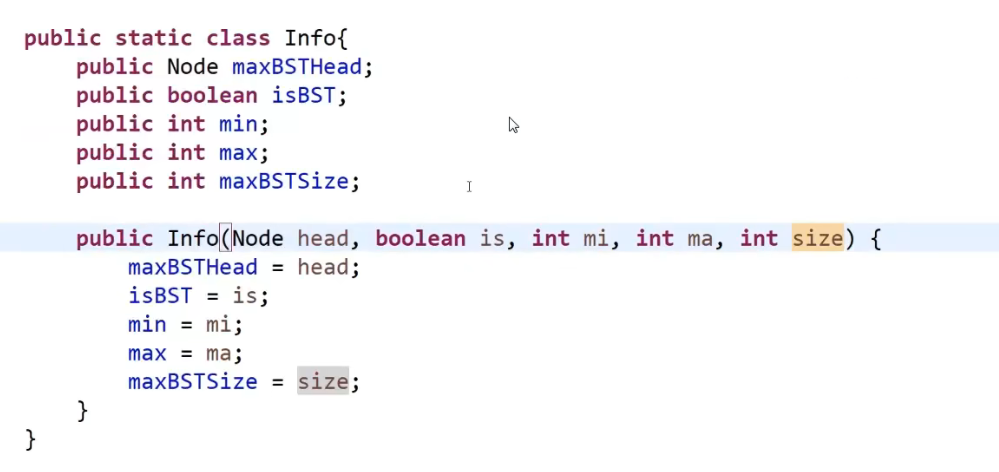

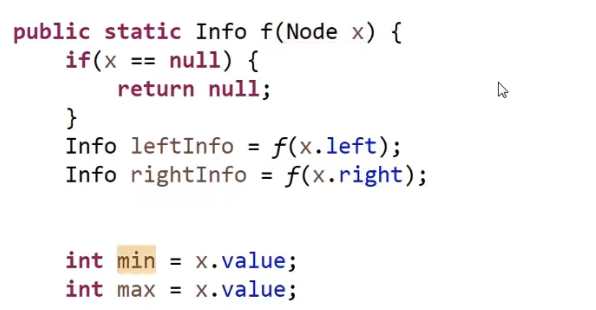

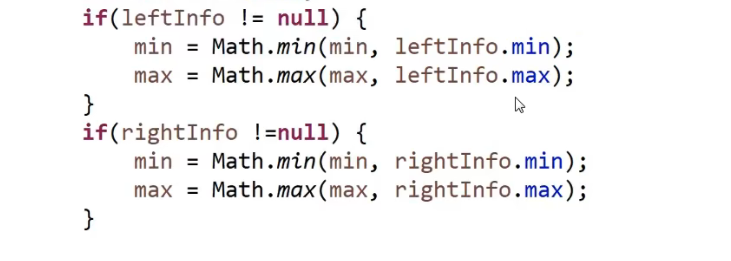

# 同理看是不是搜索二叉树还是使用同一个套路 (递归)

就像给了我们一个节点,问我们这个节点以及他下面的这个树是不是搜索二叉树

- 首先左边是个二叉树

- 右边是个二叉树

- 并且左树的最大值应该小于我 (这是对于每一个子树 (有左孩子的) 来说,因为是递归,确实啊,没毛病)

- 并且右树的最小值应该大于我 (这是对于每一个子树 (有右孩子的) 来说,因为是递归,确实啊,没毛病)

== 我们可以跟他的_左树要信息,可以跟他的_右树要信息,我们再看有什么需求 (要什么信息)==__

我们需要左树的信息

- 是不是搜索二叉树

- 这个左树的最大值

我们需要右树的信息

- 是不是搜索二叉树

- 这个右树的最小值

但是!我们递归全都是一样的,参数等等等

所以, 不管是哪边的树,我们都会让他返回三个信息

- 是不是二叉树

- 最小值

- 最大值

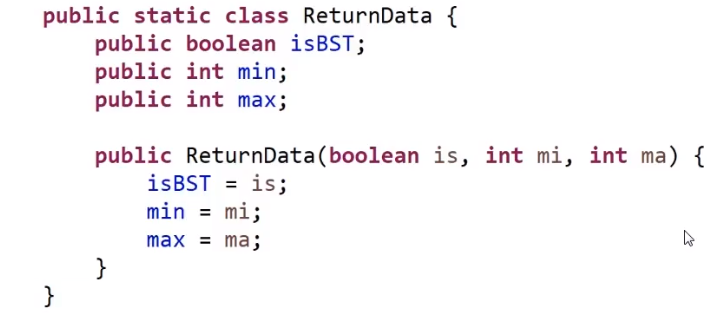

代码:

首先是自定义返回值:

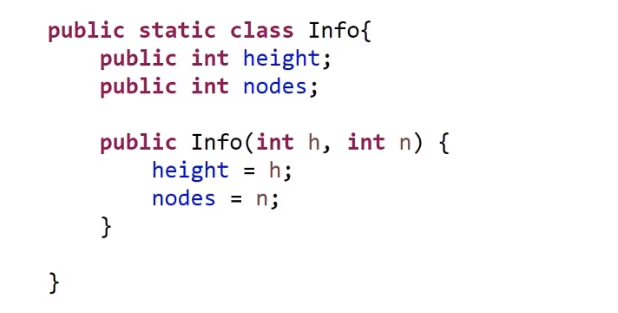

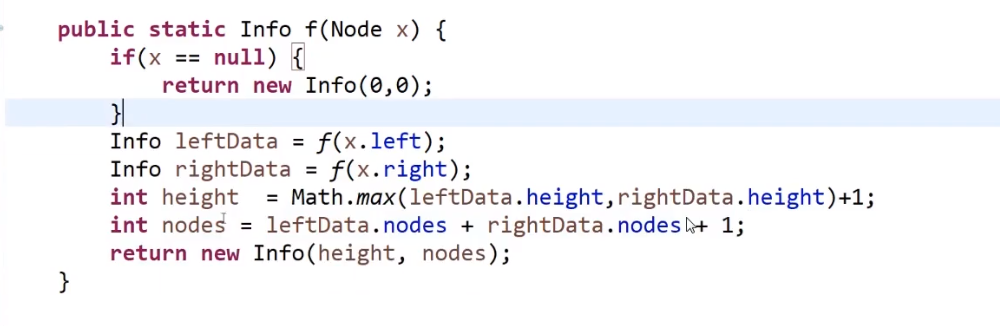

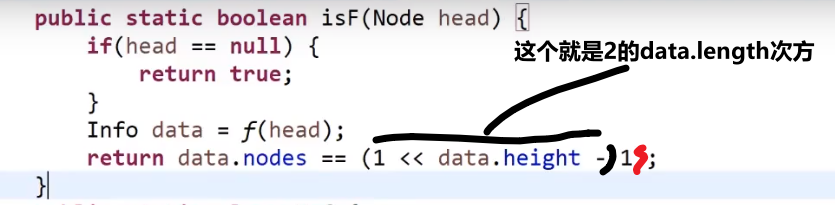

# 同理看是不是满二叉树还是使用同一个套路

比如说给我们了一个头节点,我们要看是不是满二叉树,我们

- 首先知道他左子树的高度以及多少个节点

- 再知道他右子树的高度以及多少个节点

我们可以结合当前节点的信息 (高度加 1, 节点加 1), 然后调用这个这个 formula—>N = 2D-1

满二叉树一定符合 N = 2D-1

我们需要左子树的信息:

- 多少个节点

- 最高什么高度

我们需要右子树的信息:

- 多少个节点

- 最高什么高度

所以我们自定义返回值就是有这个两个属性

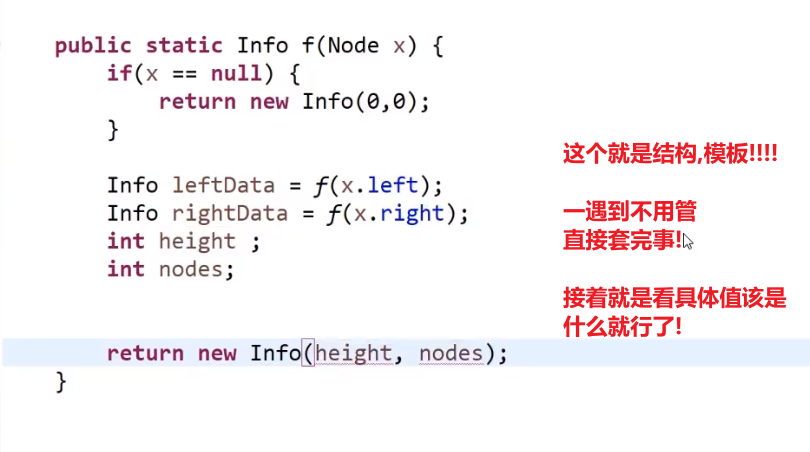

模板

正确答案:

主函数调用:

这里相当于是先把所有要的值都获取了,然后才一块判定对不对

而不是之前那种让每一个左树 / 右树附带一个 isFull 这种数据作为返回值等等等

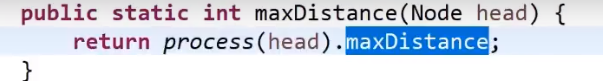

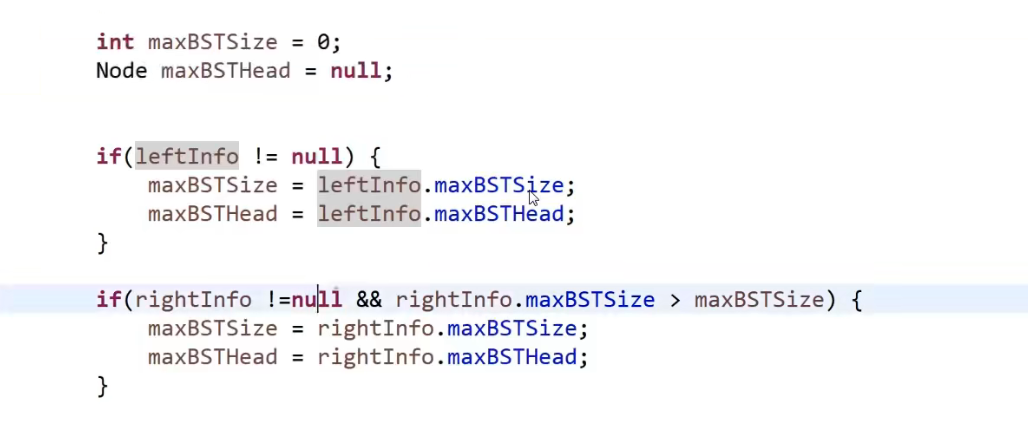

# 树型 dp 套路

这个不一定可以解决所有二叉树问题,但是可以解决所有树型 dp 类型的题

比如说,需要看整棵树才可以决定的答案,这种需要结合所有情况来看的,不过这种一般都是没有优化的方法,都是暴力解,面试中一般不会考的

树型 dp 的题就是解一个题可以通过跟左树和右树要信息,把这个事给解决了,只要是这种类型的,都可以这个套路解决

所以发现套路了吧!!!

我们一般都是自定义返回值,里面存着我们想要的 (不管是左树还是右树还是什么) 各种信息

然后递归方法里面,首先返回值肯定是我们的那个自定义的返回值,然后一般接收参数也是一个节点 (当前的头节点)

我们 base case, 这里一般要看你感兴趣的范围以及返回的值都是看你需求

接着调用自己传参传当前节点左边的树,然后这个返回一个我们自定义类型的值代表我们每一颗子树都有可能返回的值 (不用管那么多其实,就当做是黑盒,你只管调用自己就行)

反正最后会返回给你那个想要的左边树的信息

接着调用自己传参传当前右节边的树,然后这个返回一个我们自定义类型的值代表我们每一颗子树都有可能返回的值 (不用管那么多其实,就当做是黑盒,你只管调用自己就行)

反正最后会返回给你那个想要的右边树的信息

_我们接下来必须要考虑有了左边数的信息和右边树的信息,他们怎么和我们当前这个节点比,才能让他们连起来 (这个很重要!!!)_

- 我们首先可以给那个自定义类的每个属性定义一个变量代表

- 接着对着每一个变量,让他们,结合着左边数的信息和右边树的信息来设对应的值

- 然后我们再把这些值封装成我们自定义类然后返回,作为我们这个当前整个树的返回值 (这个因为会是递归,会被每一个能算是被叫成树的 (有左孩子 / 右孩子 / 都有等等等) 都会执行这一块)

再多说几句:

我们在最后处理当前节点的,只要考虑我们左边数的信息和右边树的信息就行了,比如说左边数的信息和右边树的信息里面有最小值,直接用,那肯定就是我们左树 / 右树一个一个算出来最后到了那一层算出的最小值 (就认为左 / 右树给的信息就是全量的–> 我们想要的信息都有,“比如 36,37 行的递归代码,我管你怎么执行,反正你把我要的结果给我了”), 然后我们这一层再比,跟当前节点比,如果当前节点更小,那么更新那个最小值,由此可见,其实最小值就是这么更出来的,最后这个也会返回到上一层!

这个套路可以解决一切面试里面的树型的 dp 题

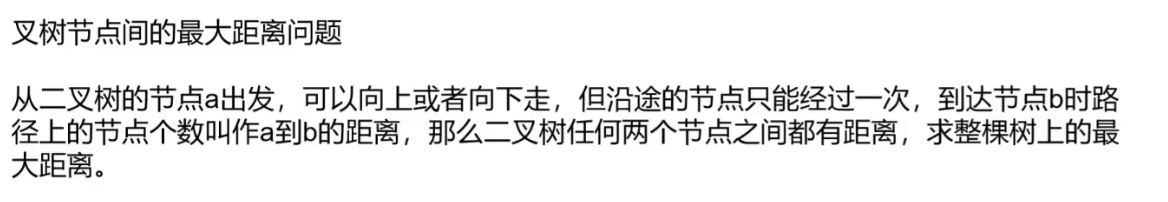

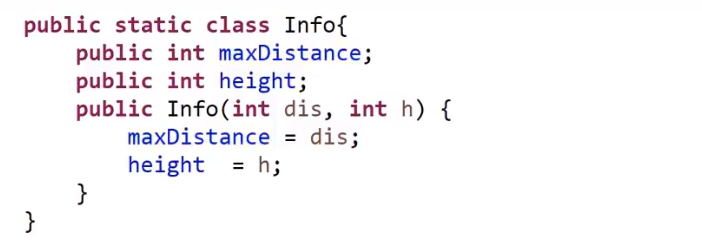

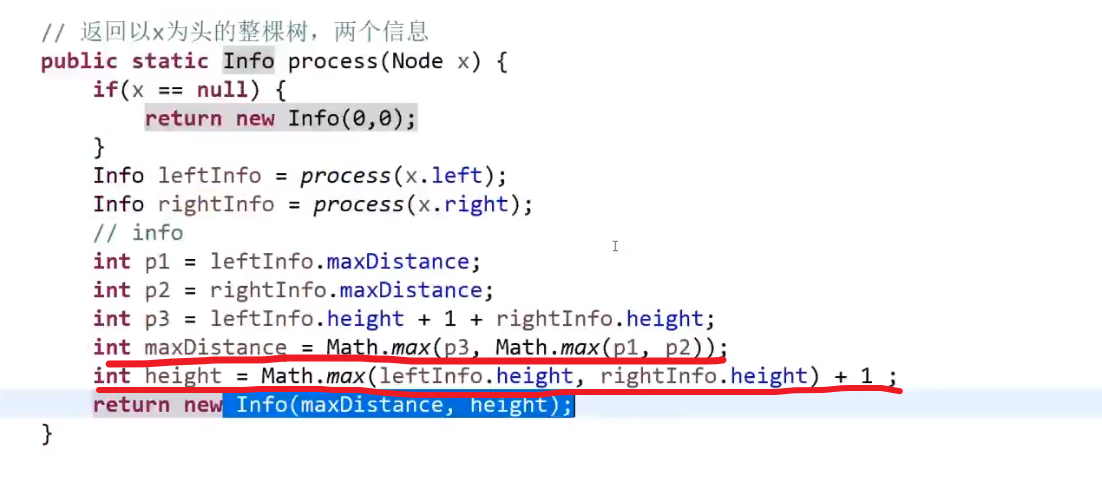

# 树型 dp 题之二叉树节点间最大距离问题

两种可能性

- 不包括头节点 x, 说明就是要么 x 的左树 / 右树有两个节点他们之间距离最大

- 包括头节点 x, 说明就是 x 左树最深的节点到 x 右树最深的节点 (也就是

左高+右高+1(x他自己))

所以就是左边取最大距离,右边取最大距离,然后左高 + 右高 + 1 (x 他自己), 这三个当中取最大值

这种按照头节点包不包括的可能性分类就是经验,这种可能性的分类很重要!

树型 dp 套路

- 左树和右树都需要最大距离 (这个最大距离就是按照每一层的节点以他来看高度的得出来的) 和高度信息

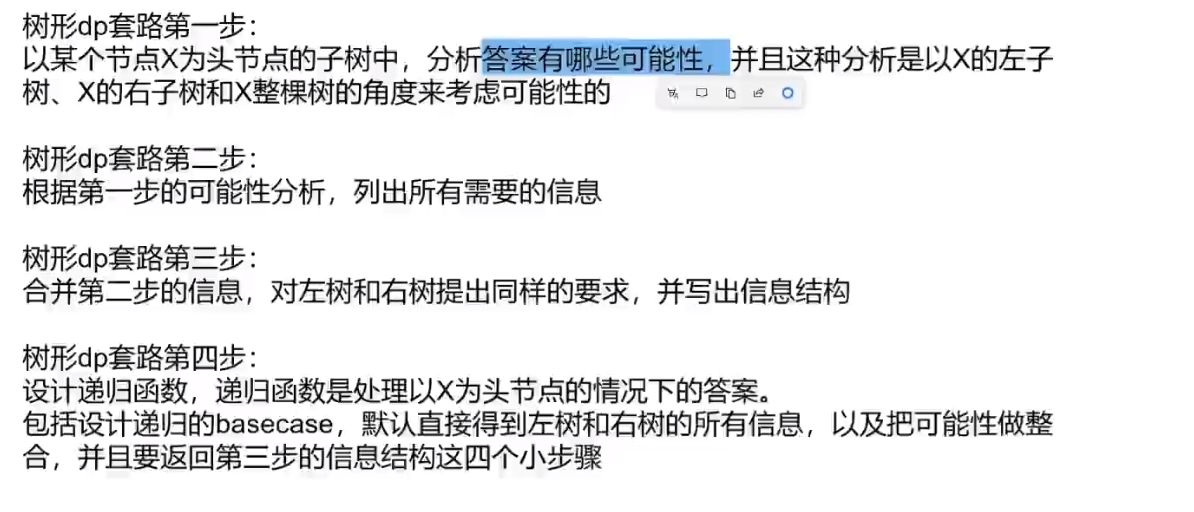

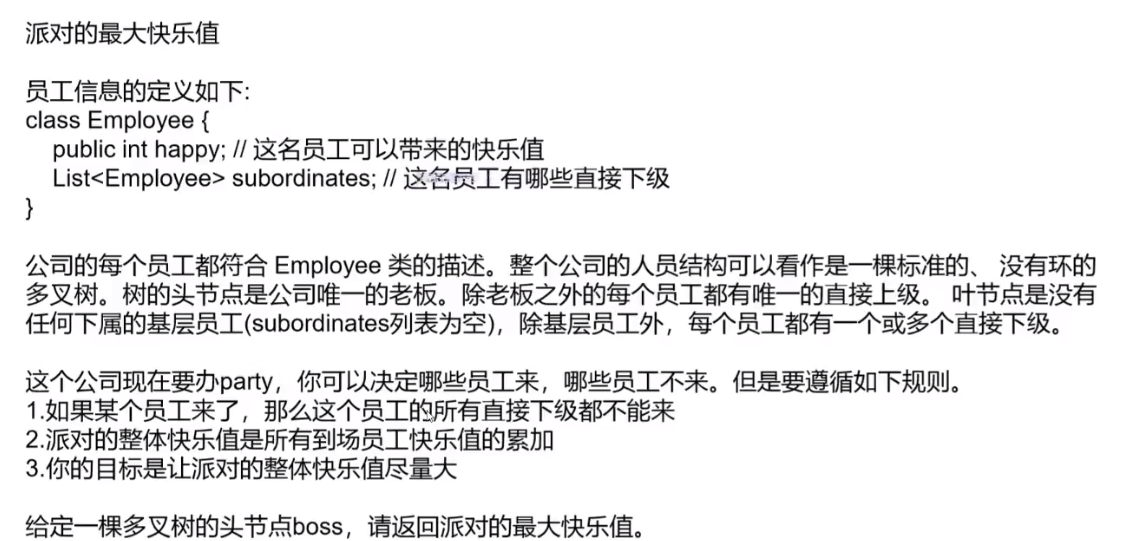

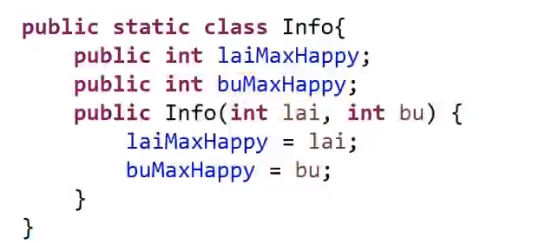

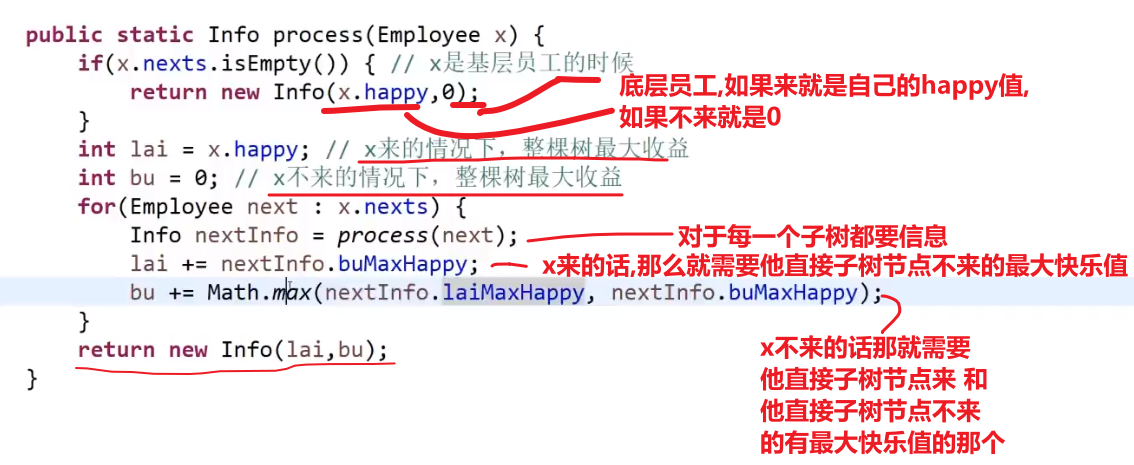

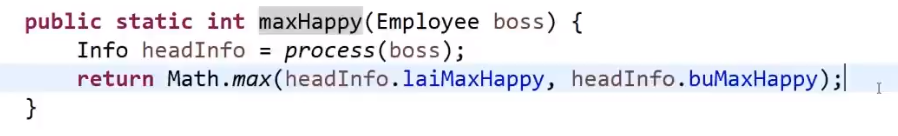

# 树型 dp 题之排队最大快乐值问题

这个是个多叉树的结构

解法:

假设 x 头节点,然后直接孩子是 a,b,c

- x 参与,代表 abc 就无法参加,那么整颗 x 代表的树的最大快乐值就是

x快乐值+a整棵树在a不来的情况下最大的快乐值+b整棵树在b不来的情况下最大的快乐值+c整棵树在c不来的情况下最大的快乐值

- x 不参与,代表 abc 可以参加也可以不参加,那么整颗 x 代表的树的最大快乐值就是

0 + Math.max(a整棵树在a来的情况下最大的快乐值,a整棵树在a不来的情况下最大的快乐值) + Math.max(b整棵树在b来的情况下最大的快乐值,b整棵树在b不来的情况下最大的快乐值) + Math.max(c整棵树在c来的情况下最大的快乐值,c整棵树在c不来的情况下最大的快乐值)

所以对于我们的所有子树 (多叉树), 我们需要:

- 那个子树包括子树节点来的最大值

- 那个子树不包括子树节点来的最大值

树型 dp 套路可以对多叉树也可以用,都是那个想法

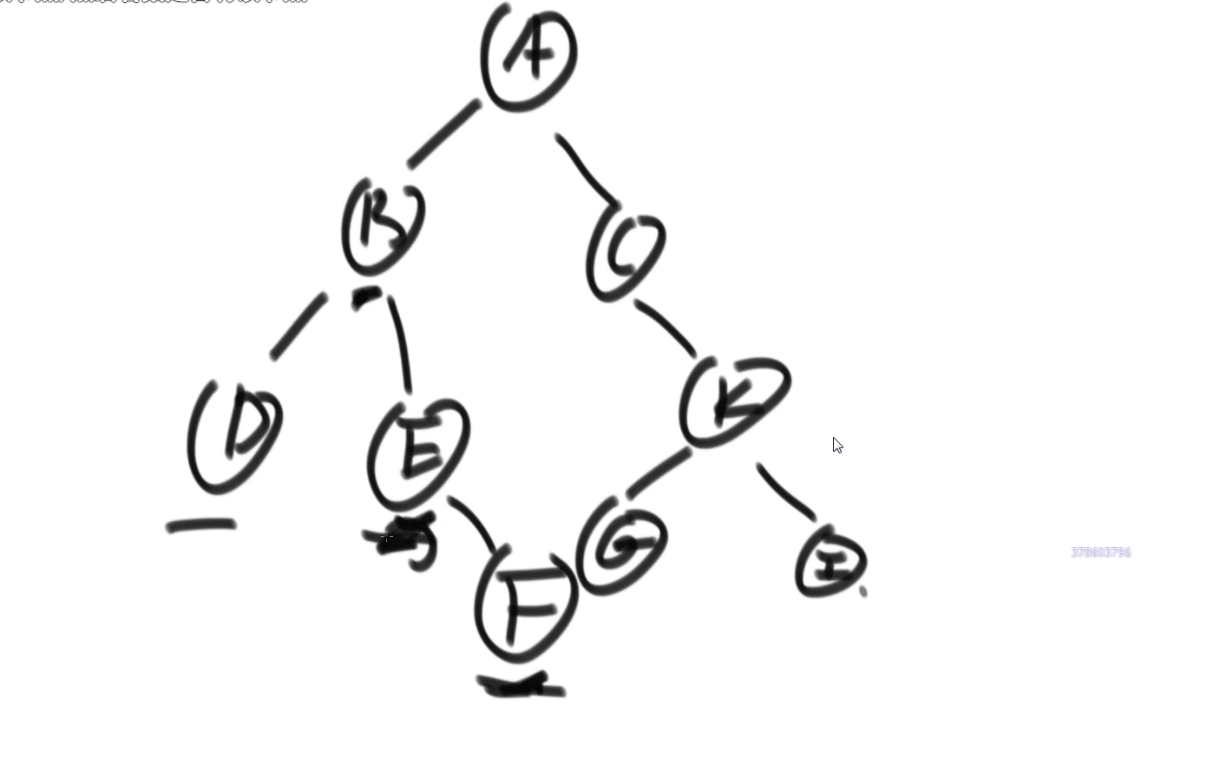

# 两个二叉树的最低公共祖先

比如说:

- D 和 E 的最低公共祖先是 B

- E 和 F 的最低公共祖先是 E

所以问题就是整个二叉树的头给我们,然后给了那个 node1 和 node2

潜规则,node1 和 node2 一定是属于 head 为头的这个二叉树的节点

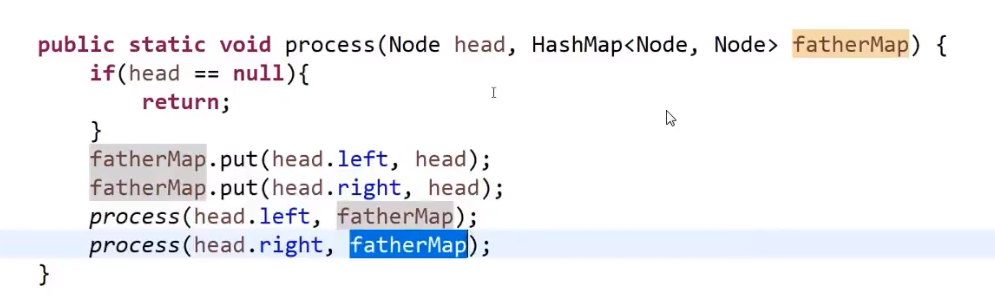

- 使用 HashMap 来存每一个节点 (key) 和他的父亲 (value)

- 接着把 head 和这个 hashMap 作为参数传进一个递归方法

- 这个递归方法里面的套路就是模板 (有稍微一点不一样)(只不过我们这里没有返回值,不用自定义返回值类型,我们只是改 hashMap 里面的数据)

我们在这个递归方法里面:

- base case

- 把左节点作为 key 和当前 head 作为 value 存进 hashmap

- 把右节点作为 key 和当前 head 作为 value 存进 hashmap

- 调用自己左子树传进去 hashMap

- 调用自己右子树传进去 hashMap

这个样子所有左子树会把他的所有节点和对应的父亲都设置好放进了 hashMap, 所有右子树会把他的所有节点和对应的父亲都设置好放进了 hashMap, 我们就可以返回到我们的主函数里面再做操作

- 首先,我们 ** 整个的大头 head (只有这一个!)** 他的父节点是没有设置的,所以在主函数一个设置一下

- 然后使用一个 hashSet 把 node1 (或者 node2) 先放进去

- 然后接着一直放,放到头节点 (包括) 为止,此时这个 hashSet 就是这个 node1 到头节点的道路经过的节点

- 然后接着我们可以使用 hashMap, 让 node2 检查是不是已经在那个 hashSet 里面了,如果没有一个一个往上升 (变成他自己的父亲), 然后一个一个检查,直到查到一样的 (可能是 head 主的那个头节点), 然后返回那个节点就行了,因为就是从下往上的 (通过成为找父亲,找父亲的父亲), 要是有一样的 (一定会有的,因为最后肯定都是 head), 那么一定就是最低的公共祖先

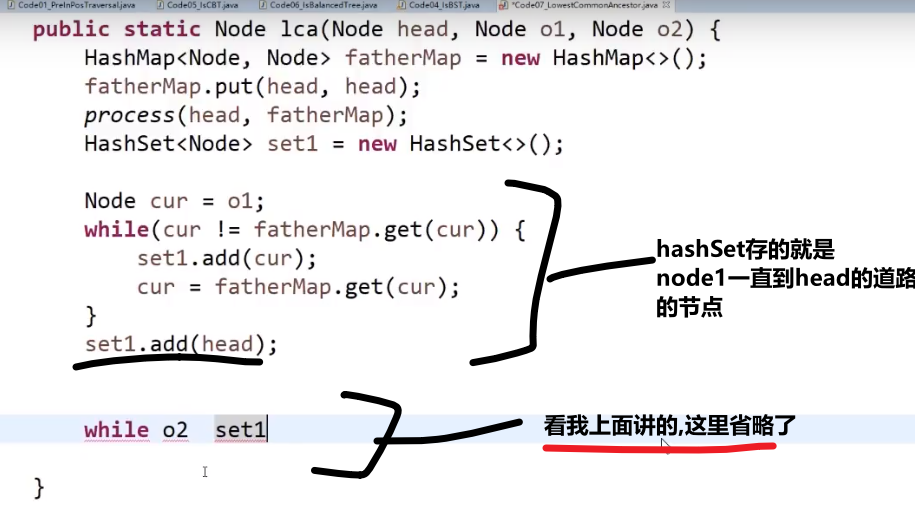

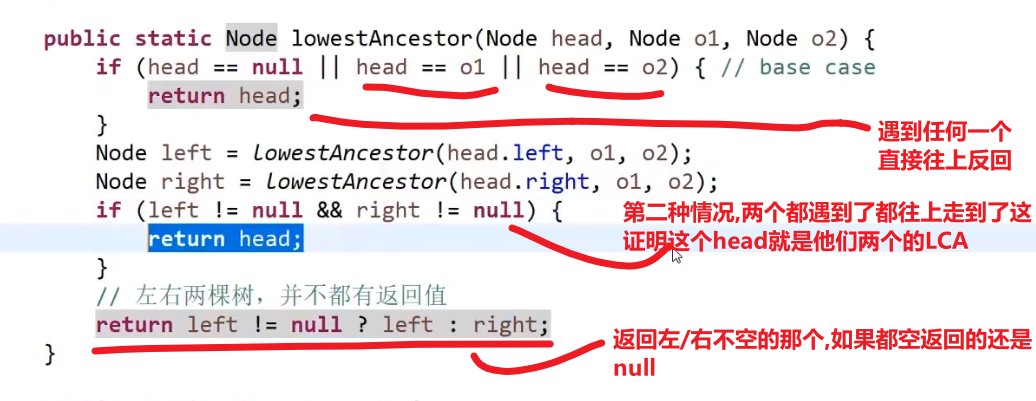

# 更短,但是很难理解的方法

https://www.bilibili.com/video/BV13g41157hK?p=7&spm_id_from=pageDriver

1:35:00, 比较抽象

有两种可能

-

O1 是 O2 的 LCA (最低公共祖先), 或者 O2 是 O1 的 LCA

那么我们直接把那个更上面的那个返回出来,另外一个没有遇到 (根本不去), 代表最后只有一个然后另外一个是 null

那么整体返回的就是那一个,也就是对的

-

O1 和 O2 不互为 LCA, 要往上才能找到

那么这两个都会被找到然后往上传,一直传到他们的 LCA 就会直接返回那个 LCA

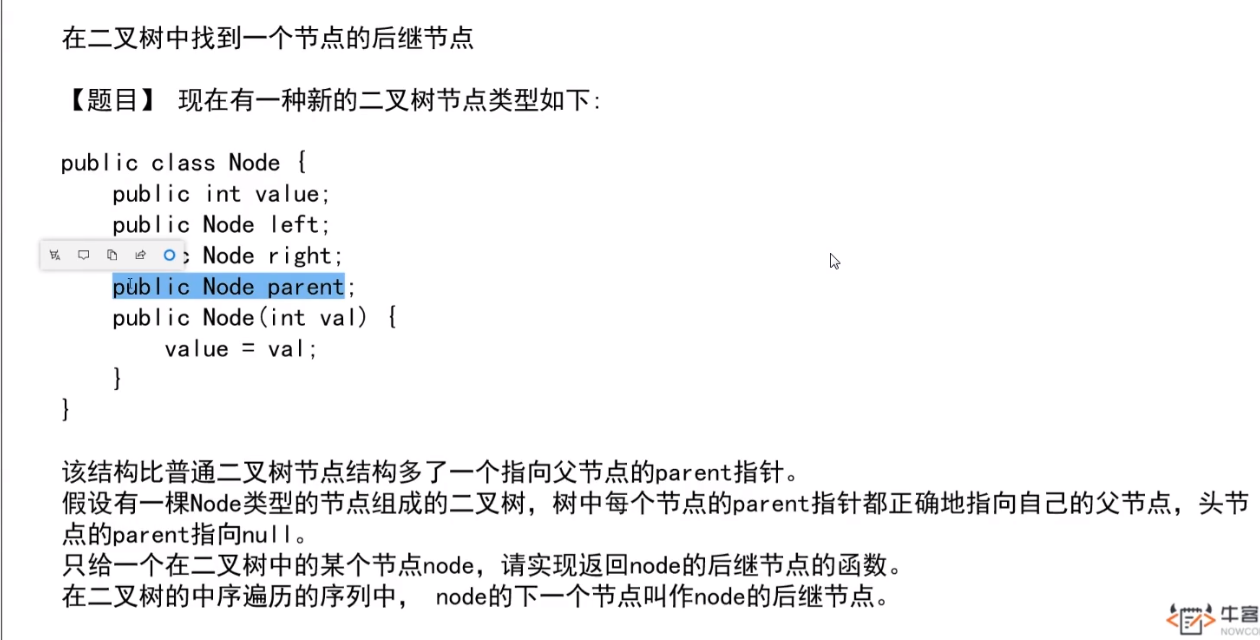

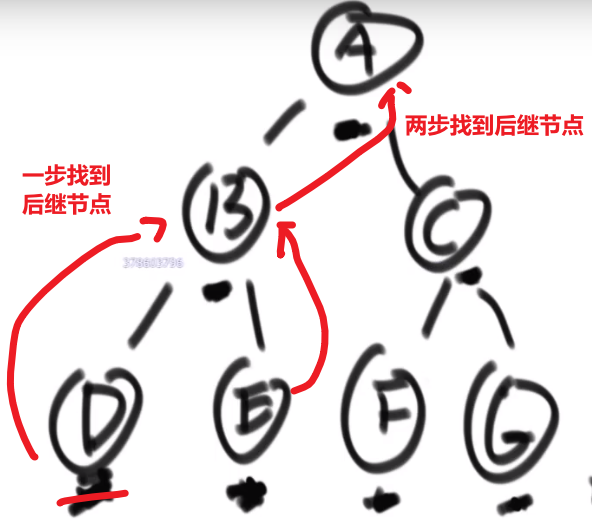

# 二叉树找一个节点的后继节点

这里 ->D 的后继节点是 B,B 的后继节点是 E,E 的后继节点是 A,…G 的后继节点是 null

也就是中序排序中的一个节点后一个节点

同理,前驱节点就是后继节点反过来–> 中序排序的一个节点的前一个节点

题目:

我们之前做法可能就是遍历一下然后把所有的按照中序排好存到一个 set 里面,然后看节点后面的节点是什么就行,但是这样会耗空间因为有那个 set, 我们这里有很好的解法:

我们这里每个节点都有 parent 指针指向他的 parent, 所以没有必要像之前的做法

我们完全可以让那个节点他的 parent 指针找到对应的后继节点就行了

- 假设我们节点是在第三层然后他的 parent 也就是他的后继节点在第二层,那么只需要走一步就行了

- 假设我们节点是在第三层然后他的 parent 的 parent 也就是他的后继节点在第一层,那么只需要走两步就行了

还有各种可能,或许不是通过 parent 等等等,看代码!!!

所以,假设我们节点和他的后继节点之间的距离是 k, 那么我们可以有个 O (k) 时间复杂度的解法

比如说给了个节点 X 找后继节点,有几种情况:

-

X 有右子树的时候,那么右子树的最左的 leaf 节点就是这个 X 的后继节点 (因为中序遍历,搞完 X 就去的右子树,他的右子树会先去搞他的左子树,等等等)

-

X 没有右子树,那么就会看 parent 然后看是不是我父亲的左孩子

- 如果是,那么这个父亲就是我们的后继节点

- 如果不是,那就继续往上看,一直看是头还不是,那就代表我们这个 X 是整颗数最右的叶节点,中序排序最后一个节点,没有后继节点,返回 null

- 如果不是,那就继续往上看,一直看是为止,此时那个父亲 (我们这个是左孩子了) 就是我们的 X 的后继节点

这是因为对于我们 Y 节点来说,我们的 X 就是 Y 的左子树最右的叶节点,也就是中序排序中他前面的那个节点 (打印完 X 就打印 Y)

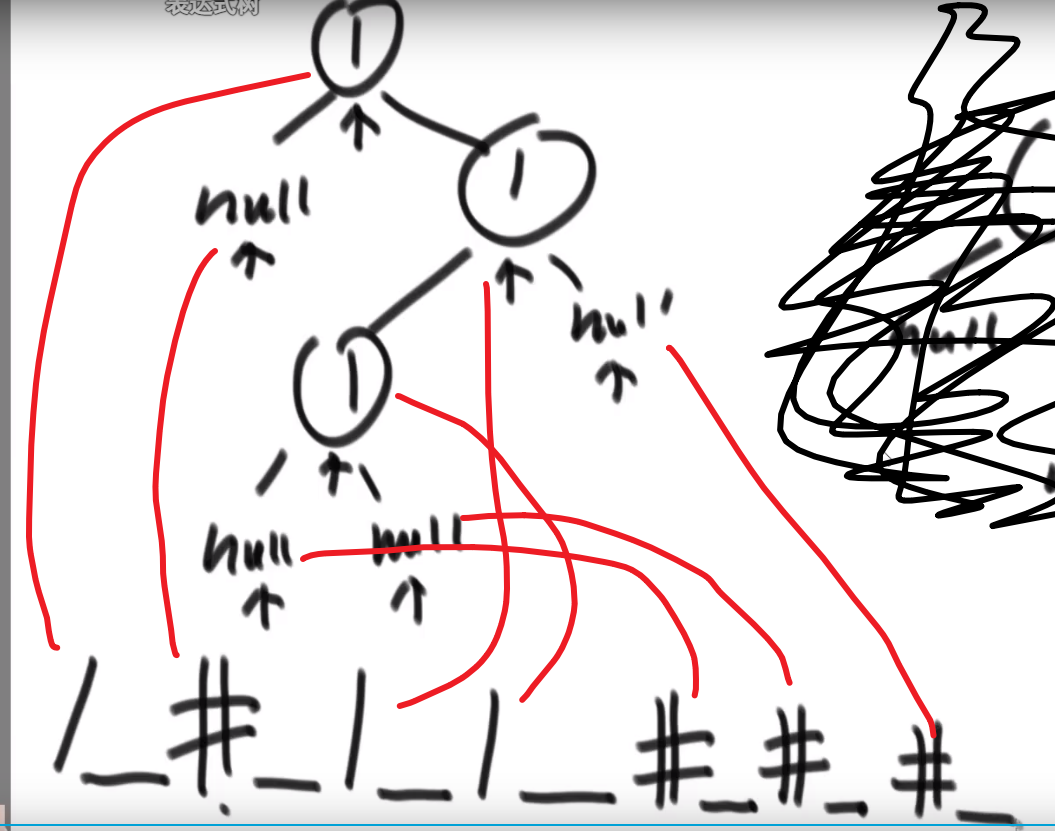

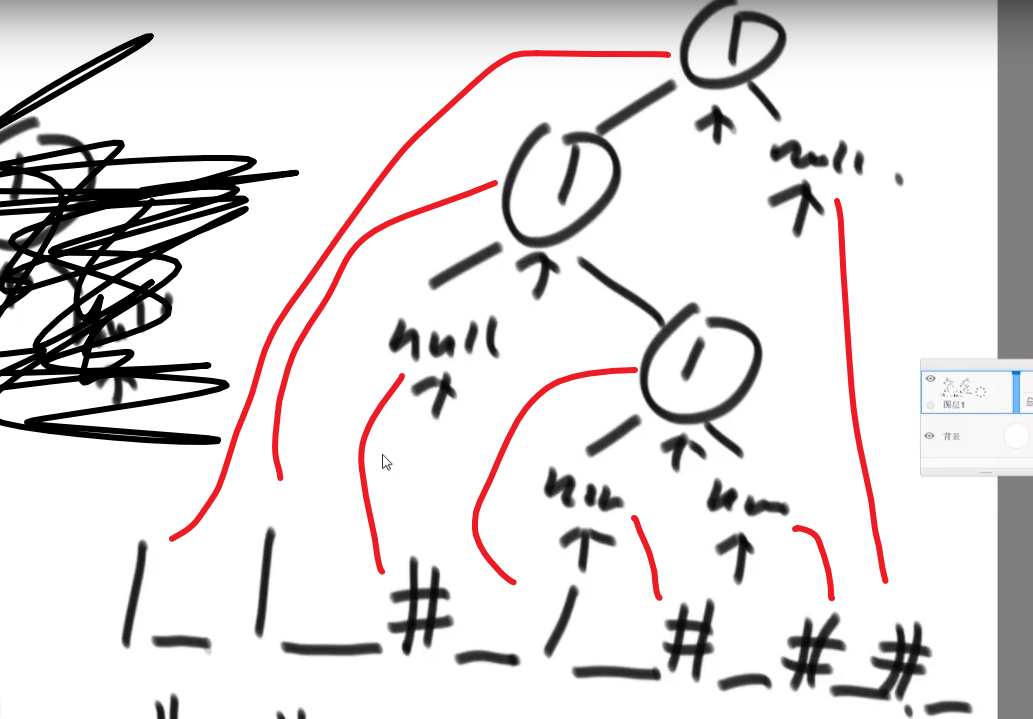

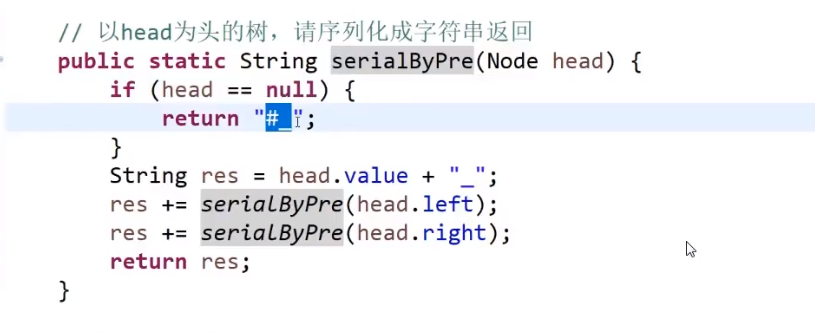

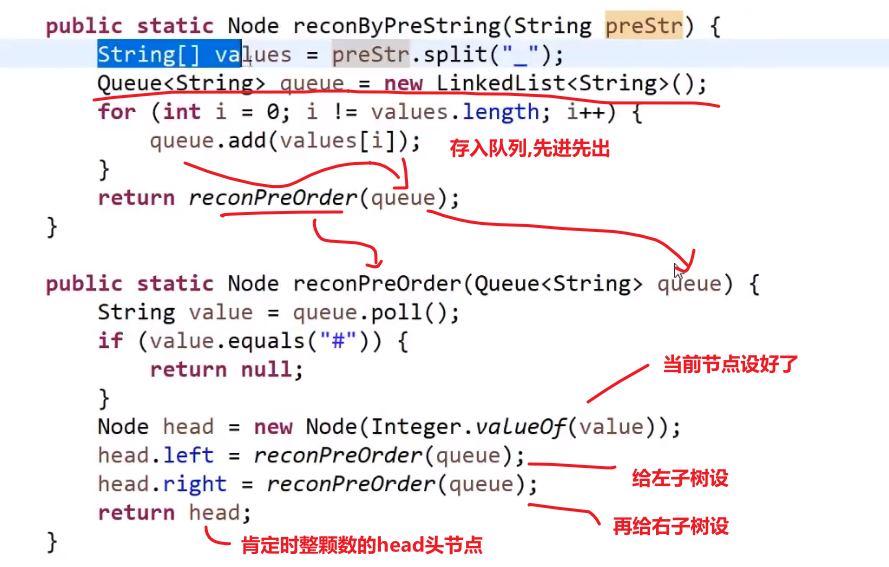

# 二叉树的序列化和反序列化

就是我们这颗树的结构以及他的值都能对应一个字符串,这样我们可以序列化 (内存变成字符串), 然后接着反序列化 -> 字符串还原出来之前那棵树的结构以及值

好几种做法

- 先序

序列化:

可以看出不一样,easy

反序列化:

- 因为我们序列化是用_作为每个数的结尾,我们可以把_之前的每一个数都存入存入数组中

- 当初按照先序序列化的,现在按照先序反序列化

- 然后读数组第一个值作为 head, 然后再看下一个数作为 head 的左边的节点,so on…

- 如果遇到一个 #代表 null, 我们返回上一层,看那一层的右节点,so on…

这不就递归嘛!

# 凹凸折痕

假设一张纸,给你个 N, 让你算出这张纸折叠 N 次,让你给出这张纸平摊后从上到下的折叠方向

整个就是二叉树

- 左子树都是凹折痕

- 右子树都是凸折痕

- 然后整个的头节点就是凹折痕

就是中序遍历,因为毕竟要求是从上到下的折叠方向也就是先把那个比如说 3 凹打印,然后 2 凹,3 凸等等等

我们这里的空间复杂度是 O (N),N 是那个传进来的 N 值,因为我们最深 (递归) 打印到 N 层,所以很省空间

要是让我们暴力,可能会发现凹凸折痕是 2N-1 个,然后我们就挨个存上面的,然后挨个打印,那么空间复杂度就到了 O (2N) 级别了

我们这里直接递归,最多就是空间复杂度是 O (N), 因为我们最多深入到 N 层,之后返回就会挨个清空,之后要是还再深入也还是用我们之前清空的空间,也就最多 O (N) 空间复杂度

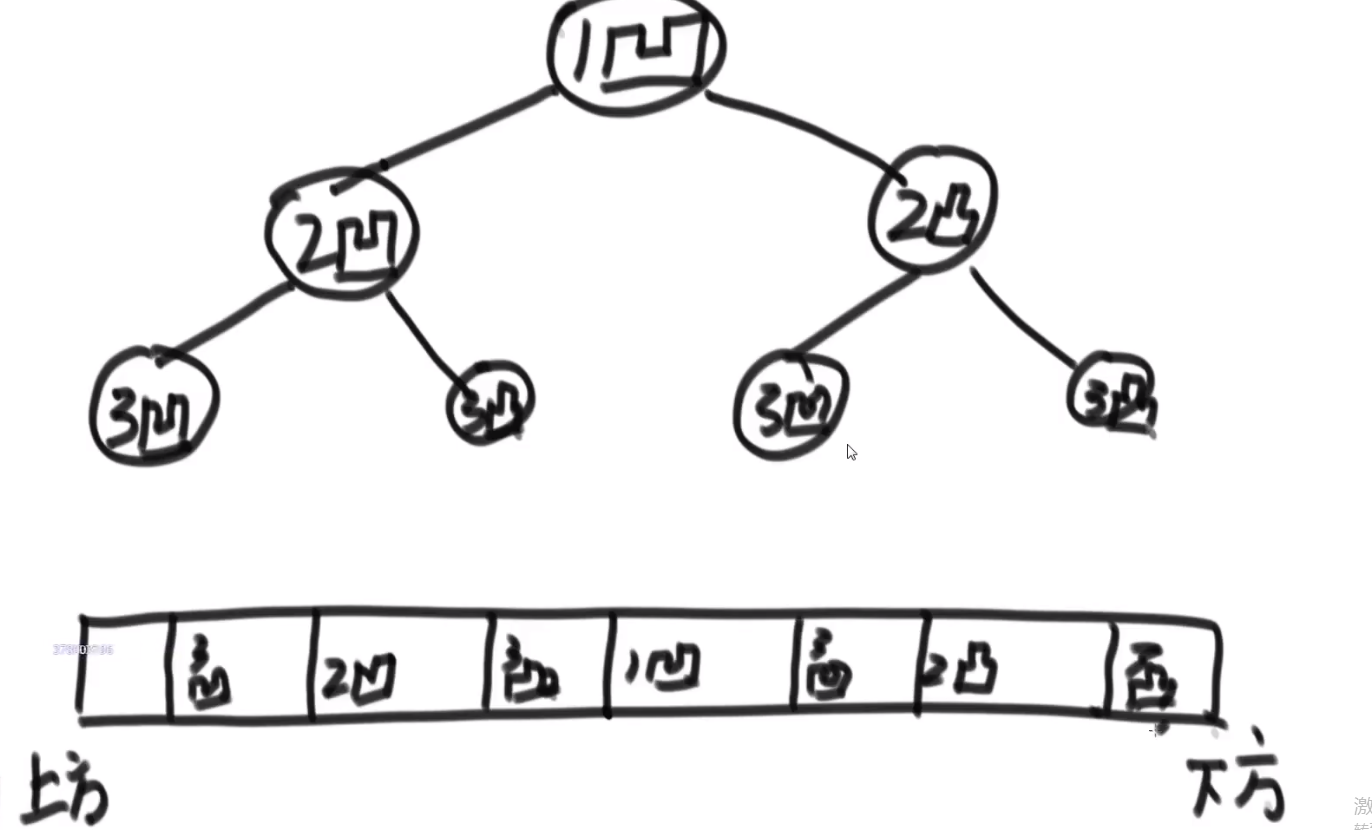

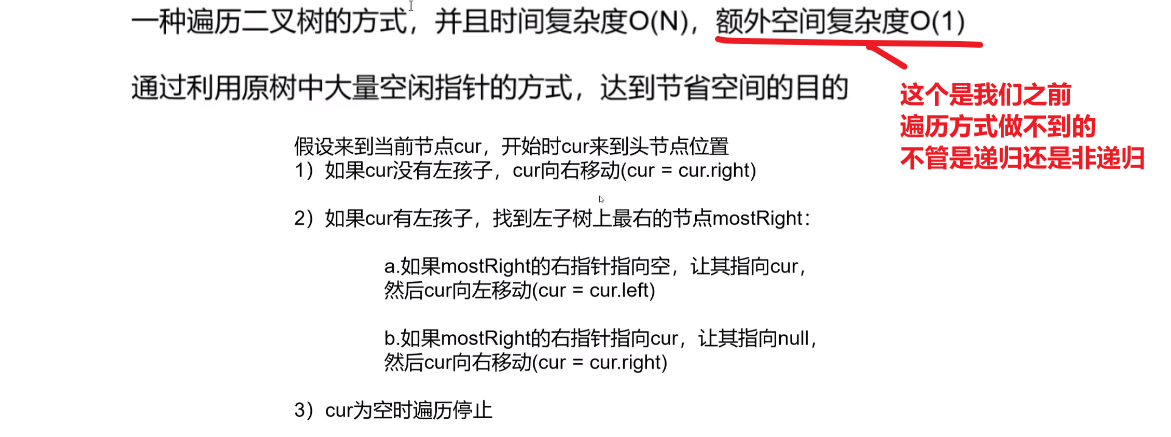

# 二叉树的 Morris 遍历

Morris 遍历,每个有左子节点的节点都会被访问两次,没有左子节点的只会被访问一次

时间复杂度就是 O (N), 因为每一个节点都最多被访问两次所以其实就是 O (n)(具体看视频)

空间复杂度就是 O (1), 就用了那几个指针

# 先序遍历

1

2 3

4 5 6 7

morris 序列 1 2 4 2 5 3 6 3 7

打印 morris 序列中第一次出现的元素就是先序遍历

(有左孩子即会出现两次)

先序 1 2 4 5 3 6 7

//第一次到达时,打印

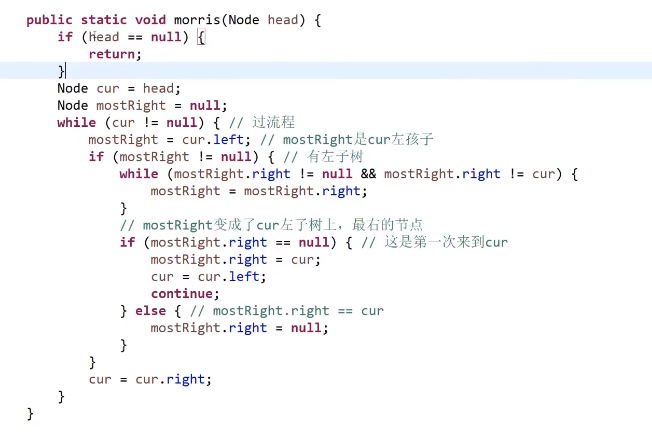

public static void morrisPre(Node head) {

if (head == null) {

return;

}

Node cur = head;

Node mostRight = null;

while (cur != null) {

mostRight = cur.left;

if (mostRight != null) {

while (mostRight.right != null && mostRight.right != cur) {

mostRight = mostRight.right;

}

if (mostRight.right == null) {

// 有左树,第二次到达时打印

System.out.print(cur.value + " ");

mostRight.right = cur;

cur = cur.left;

continue;

} else {

mostRight.right = null;

}

} else {

// 没有左树,第一次就打印

System.out.print(cur.value + " ");

}

cur = cur.right;

}

System.out.println();

}

# 中序遍历

对于出现两次的元素,第二次打印,只出现一次的元素,第一次出现就打印

morris 序列 1 2 4 2 5 3 6 3 7

中序 4 2 5 1 6 3 7

public static void morrisIn(Node head) {

if (head == null) {

return;

}

Node cur = head;

Node mostRight = null;

while (cur != null) {

mostRight = cur.left;

if (mostRight != null) {

while (mostRight.right != null && mostRight.right != cur) {

mostRight = mostRight.right;

}

if (mostRight.right == null) {

mostRight.right = cur;

cur = cur.left;

continue;

} else {

mostRight.right = null;

}

}

//只能到达一次的第一次打印,可以到达两次的第二次到达才打印

System.out.print(cur.value + " ");

cur = cur.right;

}

System.out.println();

}

# 后序遍历

对于可以到达两次的元素,第二次回到该元素时,逆序打印右边界

整个树遍历后,逆序打印整棵树的右边界

原理为:

一个树可以被右边界分解掉,由左往右,每次逆序打印其右边界,就是后序遍历

中途要求逆序打印,但 morris 要求 O(1)空间,即排除了使用额外空间的办法

可以使用反转链表来实现逆序打印

public static void morrisPos(Node head) {

if (head == null) {

return;

}

Node cur = head;

Node mostRight = null;

while (cur != null) {

mostRight = cur.left;

if (mostRight != null) {

while (mostRight.right != null && mostRight.right != cur) {

mostRight = mostRight.right;

}

if (mostRight.right == null) {

mostRight.right = cur;

cur = cur.left;

continue;

} else {

mostRight.right = null;

//第二次回到该节点时,逆序打印此节点

printEdge(cur.left);

}

}

cur = cur.right;

}

// 结束之后,打印整个树的右边界

printEdge(head);

System.out.println();

}

//先链表反转,遍历后再反转回去

public static void printEdge(Node head) {

Node tail = reverseEdge(head);

Node cur = tail;

while (cur != null) {

System.out.print(cur.value + " ");

cur = cur.right;

}

reverseEdge(tail);

}

public static Node reverseEdge(Node from) {

Node pre = null;

Node next = null;

while (from != null) {

next = from.right;

from.right = pre;

pre = from;

from = next;

}

return pre;

}

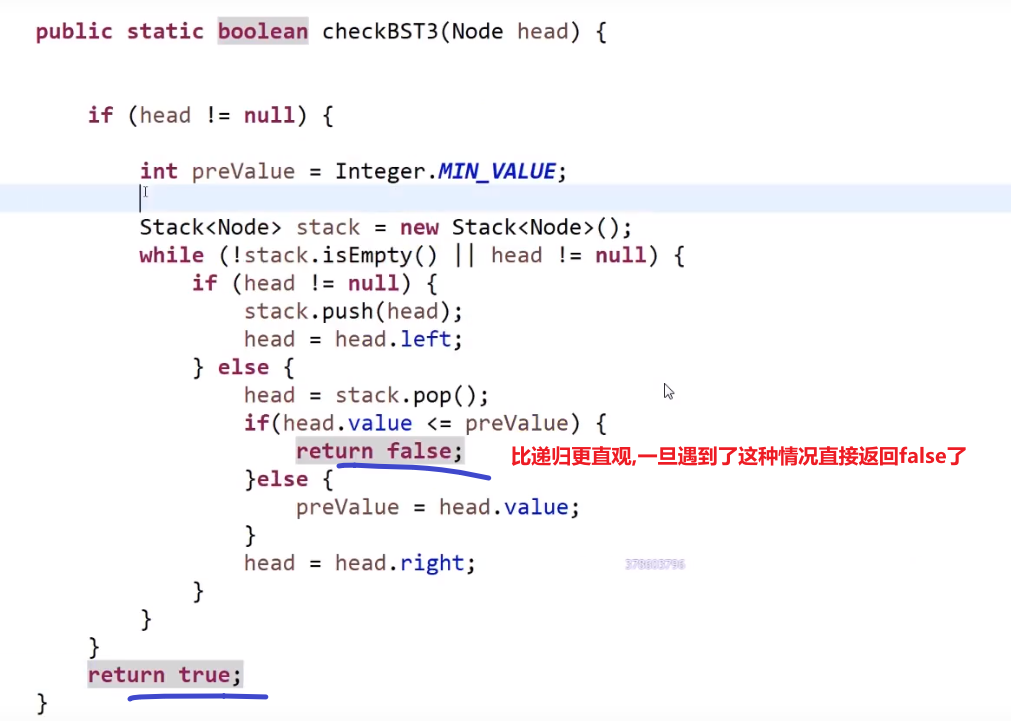

# 判断是否为二叉查找树

中序遍历为递增序列则为二叉查找树

使用 morris 遍历

public static boolean isBST(Node head) {

if (head == null) {

return;

}

Node cur = head;

Node mostRight = null;

Integer pre= null;

while (cur != null) {

mostRight = cur.left;

if (mostRight != null) {

while (mostRight.right != null && mostRight.right != cur) {

mostRight = mostRight.right;

}

if (mostRight.right == null) {

mostRight.right = cur;

cur = cur.left;

continue;

} else {

mostRight.right = null;

}

}

// 如果上一个值大于等于当前值,则这个树一定不是 bst

if(pre !=null && pre>=cur.value ){

return false;

}

pre =cur.value;

cur = cur.right;

}

return true;

}

# 求二叉树最小高度

给定一棵二叉树的头节点 head

求以 head 为头的树中,最小深度是多少?

递归办法

public static class Node {

public int val;

public Node left;

public Node right;

public Node(int x) {

val = x;

}

}

public static int minHeight1(Node head) {

if (head == null) {

return 0;

}

return p(head);

}

// 返回x为头的树,最小深度是多少

// 使用递归求解

public static int p(Node x) {

if (x.left == null && x.right == null) {

return 1;

}

// 左右子树起码有一个不为空

int leftH = Integer.MAX_VALUE;

if (x.left != null) {

leftH = p(x.left);

}

int rightH = Integer.MAX_VALUE;

if (x.right != null) {

rightH = p(x.right);

}

return 1 + Math.min(leftH, rightH);

}

morris 办法

需要做到以下两点

每到一个节点,可以知道它的高度

每到一个节点,可以判断出是否为叶子节点

// 根据morris遍历改写

public static int minHeight2(Node head) {

if (head == null) {

return 0;

}

Node cur = head;

Node mostRight = null;

int curLevel = 0;

int minHeight = Integer.MAX_VALUE;

while (cur != null) {

mostRight = cur.left;

if (mostRight != null) {

int rightBoardSize = 1;

while (mostRight.right != null && mostRight.right != cur) {

// 由下往上的元素层数

rightBoardSize++;

mostRight = mostRight.right;

}

if (mostRight.right == null) { // 第一次到达

curLevel++;

mostRight.right = cur;

cur = cur.left;

continue;

} else {

// 第二次到达,需要减去rightBoardSize

if (mostRight.left == null) {

//此时到达叶节点,计算最小高度

minHeight = Math.min(minHeight, curLevel);

}

curLevel -= rightBoardSize;

mostRight.right = null;

}

} else {

// 只有一次到达

curLevel++;

}

cur = cur.right;

}

int finalRight = 1;

cur = head;

while (cur.right != null) {

finalRight++;

cur = cur.right;

}

// 单独去找一下最右部分的最小高度

if (cur.left == null && cur.right == null) {

minHeight = Math.min(minHeight, finalRight);

}

return minHeight;

}

# 图问题

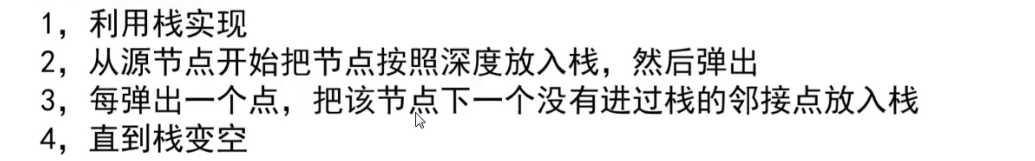

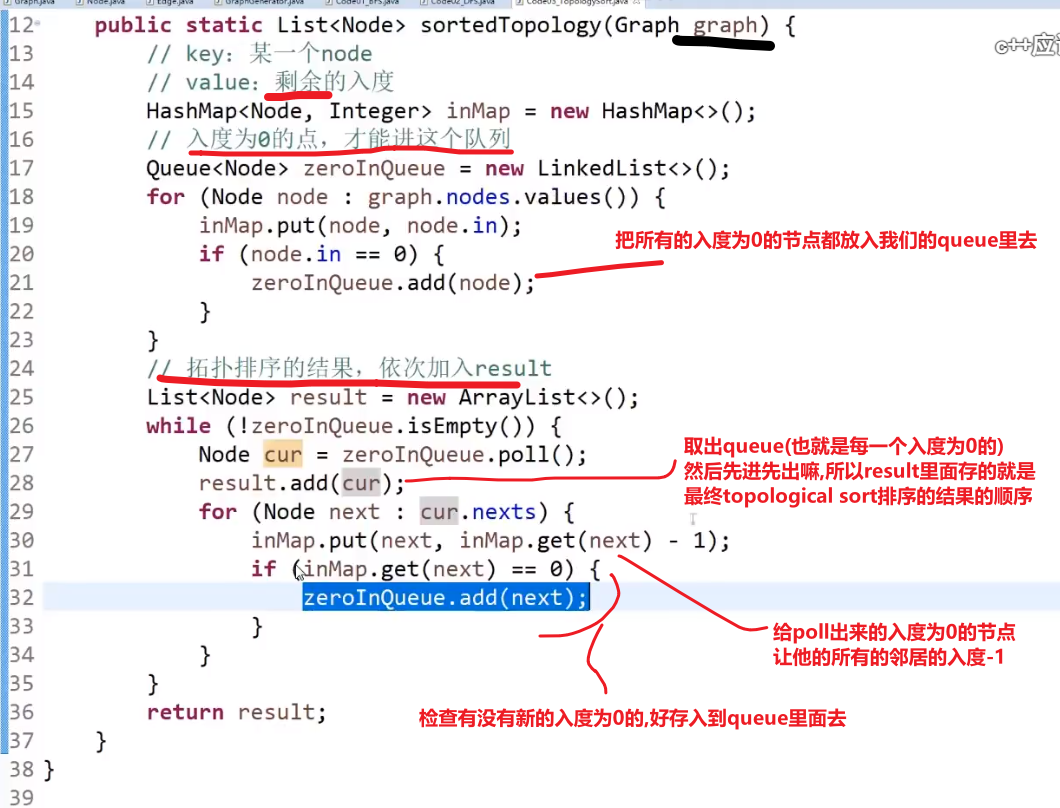

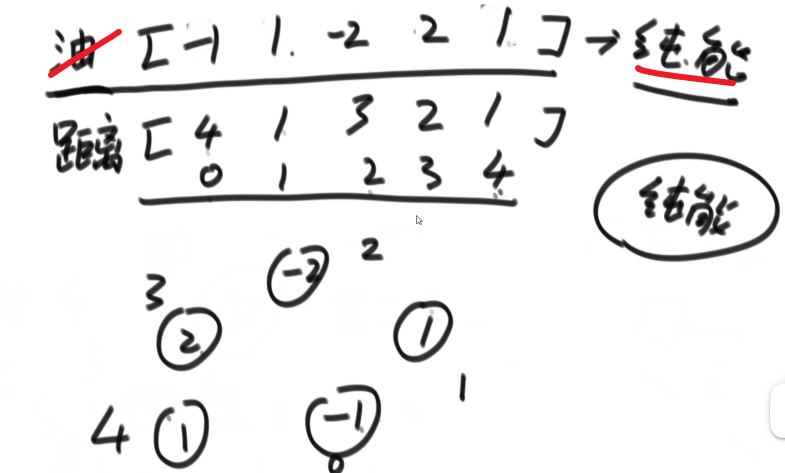

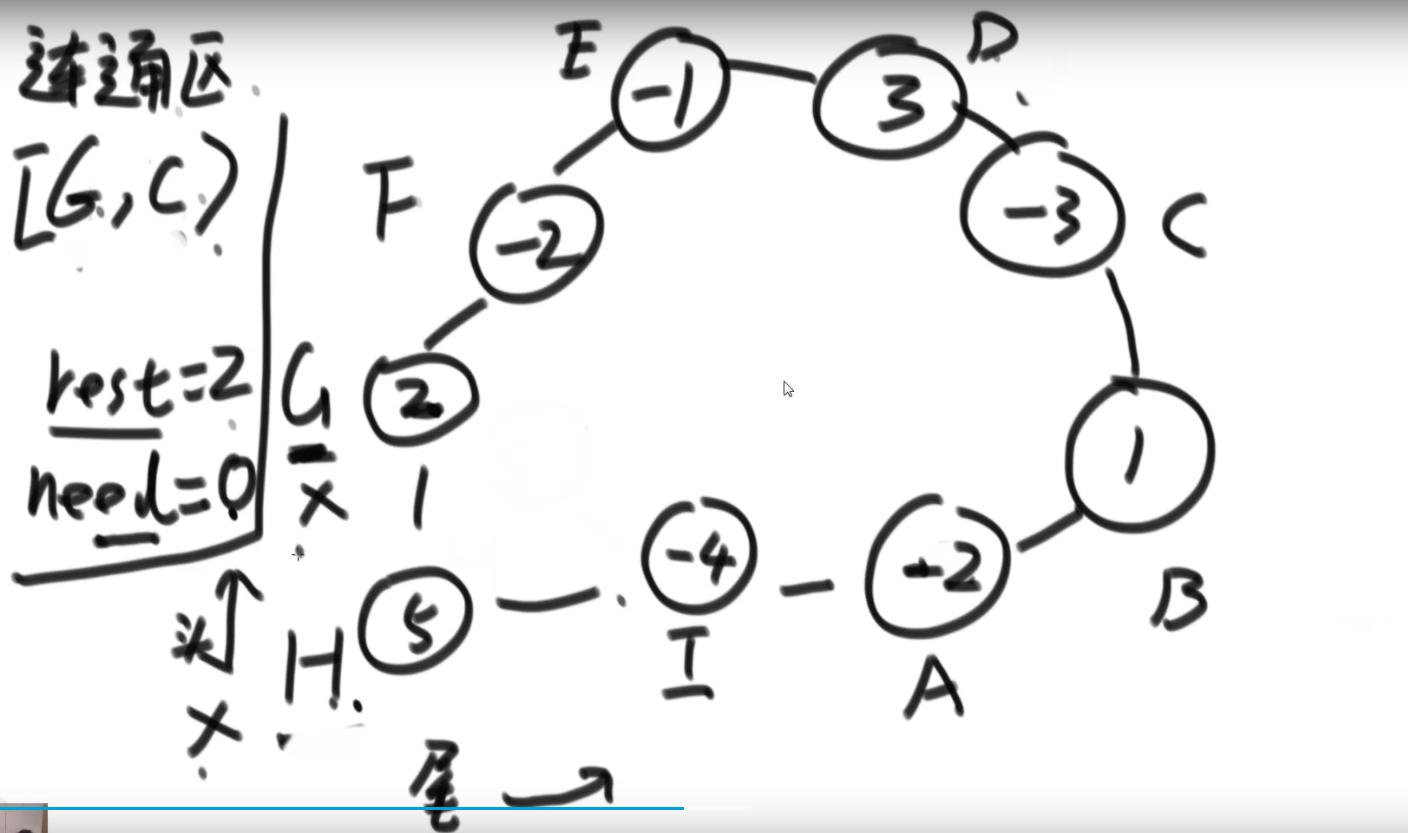

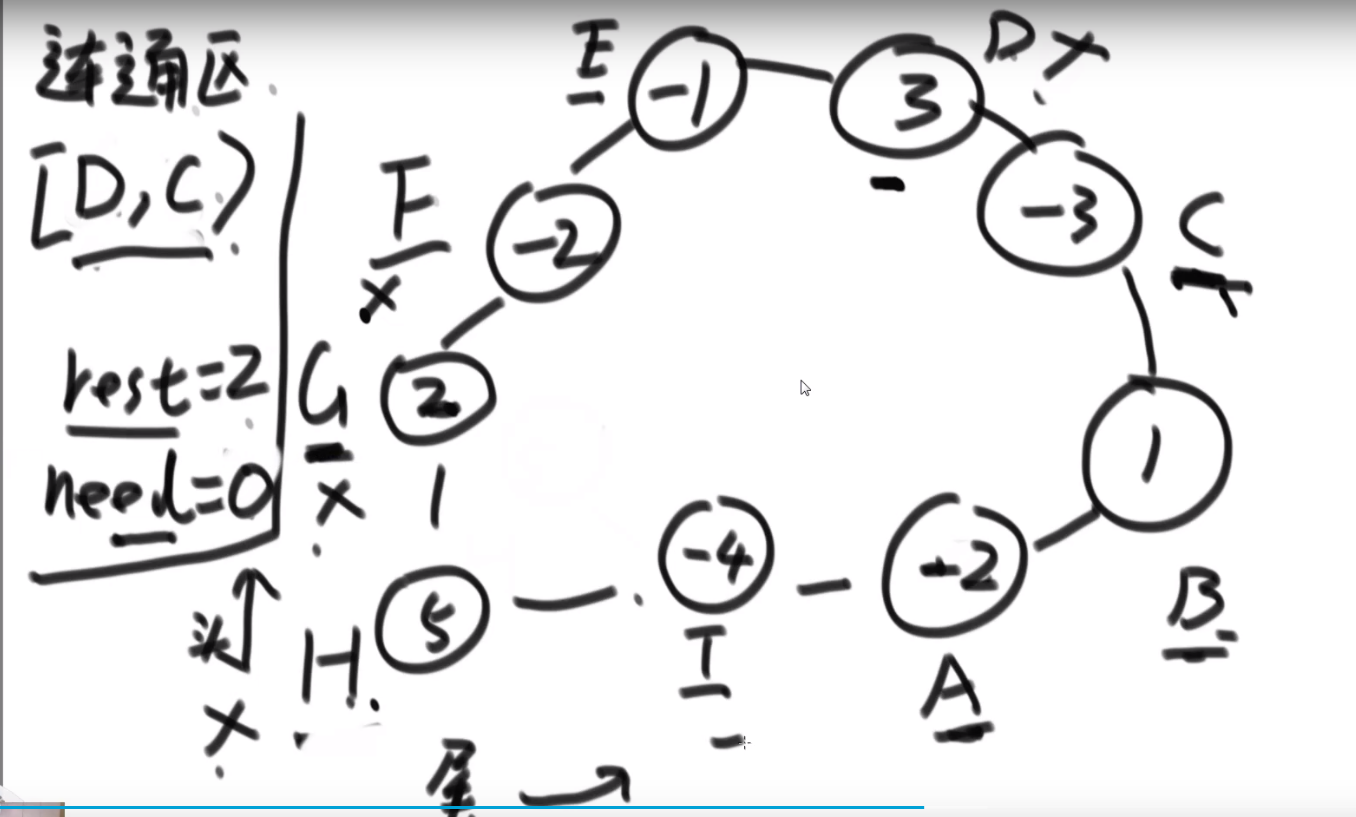

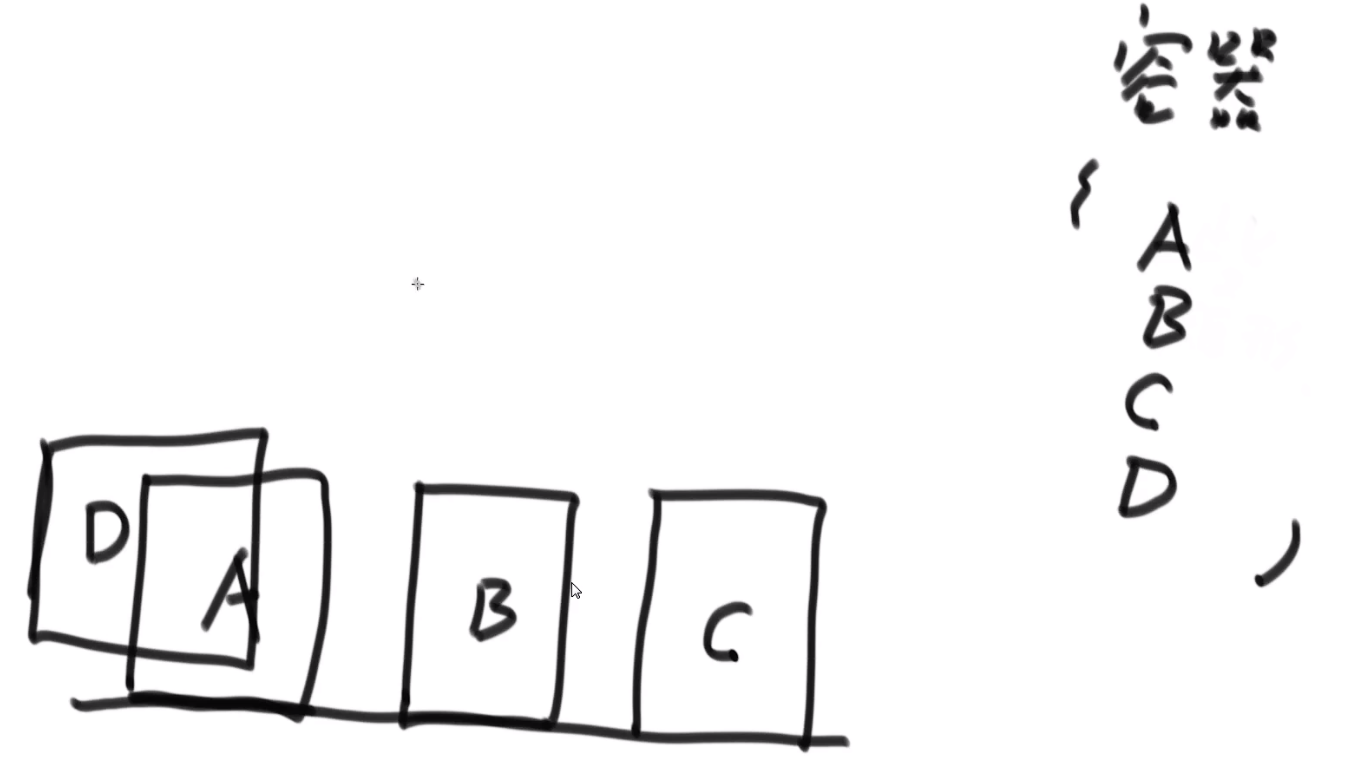

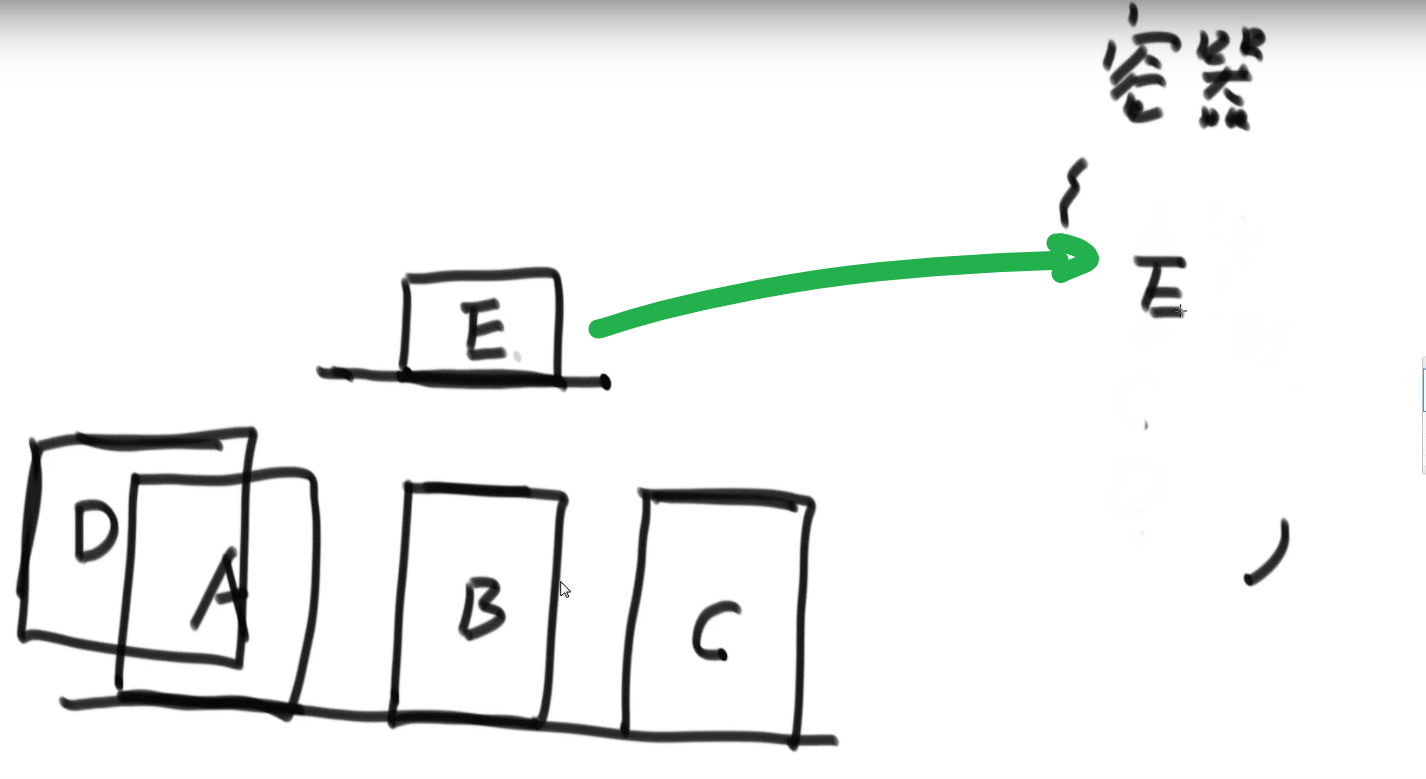

# 括扑排序算法 (topological sort)

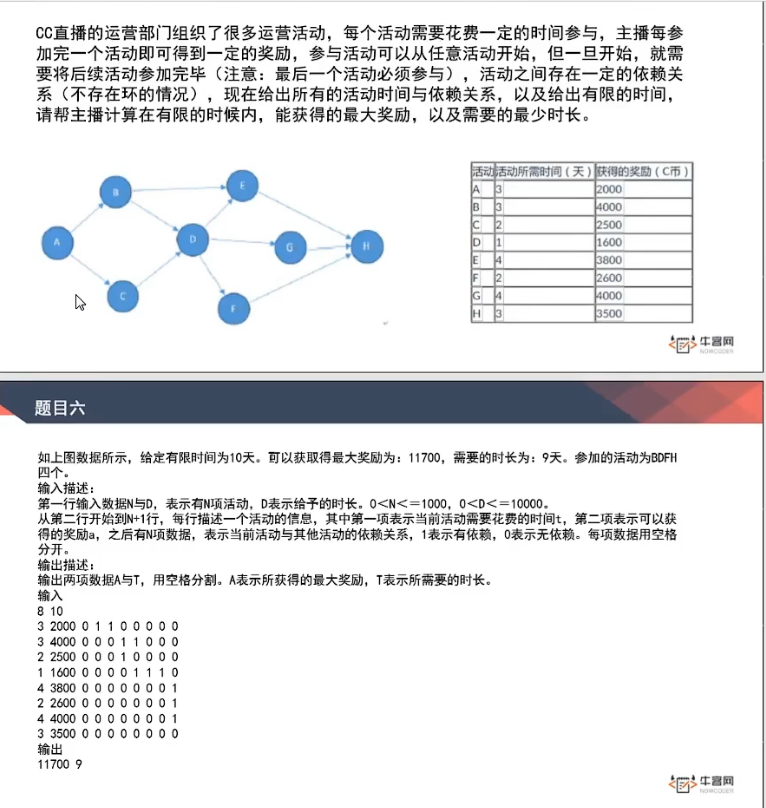

- 适用于 Directed Acyclic Graph --> directed graph with no loops (无环–> 指的不只是自己指向自己的那种环,还包括多个节点形成的环)

比如说:工程中的依赖

注意不能拥有环,也就像工程中依赖之间不能循环依赖一样

对于上方的图,我们可以看到我们先需要 E 依赖,然后 C 依赖然后 D 依赖,然后 B 依赖,然后 A 依赖

问题例子:

解法:

- 我们首先入度为 0 的 (如果要拿 topological sort 来解答的话那就一定有这个)(一开始就是 A 节点)

这个节点就相当于是 (此时) 必须先要有的依赖,然后其他的依赖才可以设起来

-

接着把这个节点以及他的 outward edge 都擦掉 (肯定只会有 outward, 因为我们找到的是入度为 0 的),

记得把这个节点保存啊,进行什么操作啊等等等

-

重复 1,2–> 因为我们上面把 A 以及他的 outward edge 都擦掉了,此时 B 就是入度为零的节点,等等等

最终的 topological sort 顺序就是:

注意如果有多个入度为 0 的节点,那随便哪一个都行,反正我们之后顺序一定不会产生需要依赖的在前面然后被依赖的那个在后面.

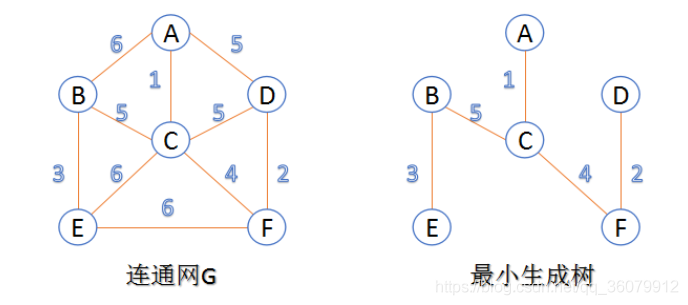

# 最小生成树以及相关算法 (和一些 terminologies)

关于图的几个概念定义:

** 连通图:** 在无向图中,若任意两个顶点 vivi 与 vjvj 都有路径相通,则称该无向图为连通图。

** 强连通图:** 在有向图中,若任意两个顶点 vivi 与 vjvj 都有路径相通,则称该有向图为强连通图。

** 连通网:** 在连通图中,若图的边具有一定的意义,每一条边都对应着一个数,称为权;权代表着连接连个顶点的代价,称这种连通图叫做连通网。

** 生成树:** 一个连通图的生成树是指一个连通子图,它含有图中全部 n 个顶点,但只有足以构成一棵树的 n-1 条边。一颗有 n 个顶点的生成树有且仅有 n-1 条边,如果生成树中再添加一条边,则必定成环。

** 最小生成树 (minimum weight spanning tree):** 在连通网的所有生成树中,所有边的代价和最小的生成树,称为最小生成树。

可以用 kruskal 或者 Prim 生成最小生成树

# Terminologies

# Definitions: Graph, Vertices, Edges

-

Define a graph G = (V, E) by defining a pair of sets:

- V = a set of vertices

- E = a set of edges

-

Edges:

- Each edge is defined by a pair of vertices

- An edge connects the vertices that define it

- In some cases, the vertices can be the same

-

Vertices:

- Vertices also called nodes

- Denote vertices with labels

-

Representation:

- Represent vertices with circles, perhaps containing a label

- Represent edges with lines between circles

-

Example:

- V =

- E =

# Motivation

Many algorithms use a graph representation to represent data or the problem to be solved

Examples:

-

Cities with distances between

-

Roads with distances between intersection points

-

Course prerequisites

-

Network

-

Social networks

-

Program call graph and variable dependency graph

# Graph Classifications

-

There are seveal common kinds of graphs

- Weighted or unweighted

- Directed or undirected

- Cyclic or acyclic

-

Choose the kind required for problem and determined by data

-

We examine each below

# Kinds of Graphs: Weighted and Unweighted

Graphs can be classified by whether or not their edges have weights

- Weighted graph: edges have a weight

- Weight typically shows cost of traversing

- Example: weights are distances between cities

- Unweighted graph: edges have no weight

- Edges simply show connections

- Example: course prereqs

# Kinds of Graphs: Directed and Undirected

Graphs can be classified by whether or their edges are have direction

- Undirected Graphs: each edge can be traversed in either direction

- Directed Graphs: each edge can be traversed only in a specified direction

# Undirected Graphs

-

Undirected Graph: no implied direction on edge between nodes

-

The example from above is an undirected graph

-

In diagrams, edges have no direction (ie they are not arrows)

-

Can traverse edges in either directions

-

-

In an undirected graph, an edge is an unordered pair

-

Actually, an edge is a set of 2 nodes, but for simplicity we write it with parens

- For example, we write (A, B) instead of

- Thus, (A,B) = (B,A), etc

- If (A,B) ∈ E then (B,A) ∈ E

-

Formally: ∀ u,v ∈ E, (u,v)=(v,u) and u ≠ v

-

-

A node normally does not have an edge to itself

# Directed Graphs

-

Digraph: A graph whose edges are directed (ie have a direction)

-

Edge drawn as arrow

-

Edge can only be traversed in direction of arrow

-

Example: E =

-

Examples: courses and prerequisites, program call graph

-

-

In a digraph, an edge is an ordered pair

- Thus: (u,v) and (v,u) are not the same edge

- In the example, (D,C) ∈ E, (C,D) ∉ E

- What would edge (B,A) look like? Remember (A,B) ≠ (B,A)

-

A node can have an edge to itself (eg (A,A) is valid)

# Subgraph

- If graph G=(V, E)

- Then Graph G’=(V’,E’) is a subgraph of G if V’ ⊆ V and E’ ⊆ E and

# Degree of a Node

-

The degree of a node is the number of edges the node is used to define

-

In the example above:

- Degree 2: B and C

- Degree 3: A and D

- A and D have odd degree, and B and C have even degree

-

Can also define in-degree and out-degree

- In-degree: Number of edges pointing to a node

- Out-degree: Number of edges pointing from a node

# Graphs: Terminology Involving Paths

-

Path: sequence of vertices in which each pair of successive vertices is connected by an edge

-

Cycle: a path that starts and ends on the same vertex

-

Simple path: a path that does not cross itself

- That is, no vertex is repeated (except first and last)

- Simple paths cannot contain cycles

-

Length of a path: Number of edges in the path

- Sometimes the sum of the weights of the edges

# Cyclic and Acyclic Graphs

-

A Cyclic graph contains cycles

Example: roads (normally)

-

An acyclic graph contains no cycles

Example: Course prereqs!

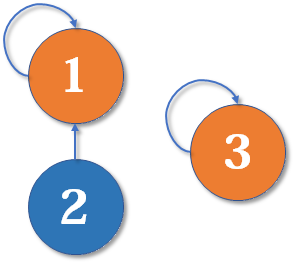

# Connected and Unconnected Graphs and Connected Components

-

An undirected graph is connected if every pair of vertices has a path between it

- Otherwise it is unconnected

-

An unconnected graph can be broken in to connected components

-

A directed graph is strongly connected if every pair of vertices has a path between them, in both directions

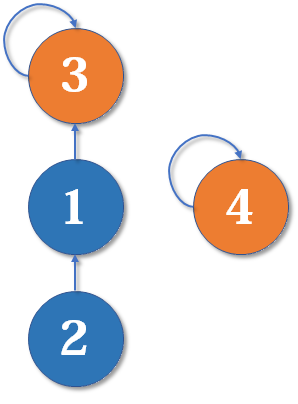

# Trees and Minimum Spanning Trees

- Tree: undirected, connected graph with no cycles

- Spanning tree: a spanning tree of G is a connected subgraph of G that is a tree

- Minimum spanning tree (MST): a spanning tree with minimum weight

- Spanning trees and minimum spanning tree are not necessarily unique

- We will look at two famous MST algorithms: Prim’s and Kruskal’s

# Data Structures for Representing Graphs

- Two common data structures for representing graphs:

- Adjacency lists

- Adjacency matrix

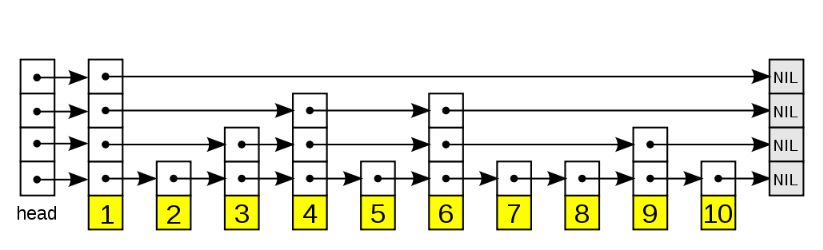

# Adjacency List Representation

-

Each node has a list of adjacent nodes

-

Example (undirected graph):

-

A: B, C, D

-

B: A, D

-

C: A, D

-

D: A, B, C

-

-

Example (directed graph):

-

A: B, C, D

-

B: D

-

C: Nil

-

D: C

-

-

Weighted graph can store weights in list

-

Space: Θ(V + E) (ie |V| + |E|)

-

Time:

- To visit each node that is adjacent to node u: Θ(degree(u))

- To determine if node u is adjacent to node v: Θ(degree(u))

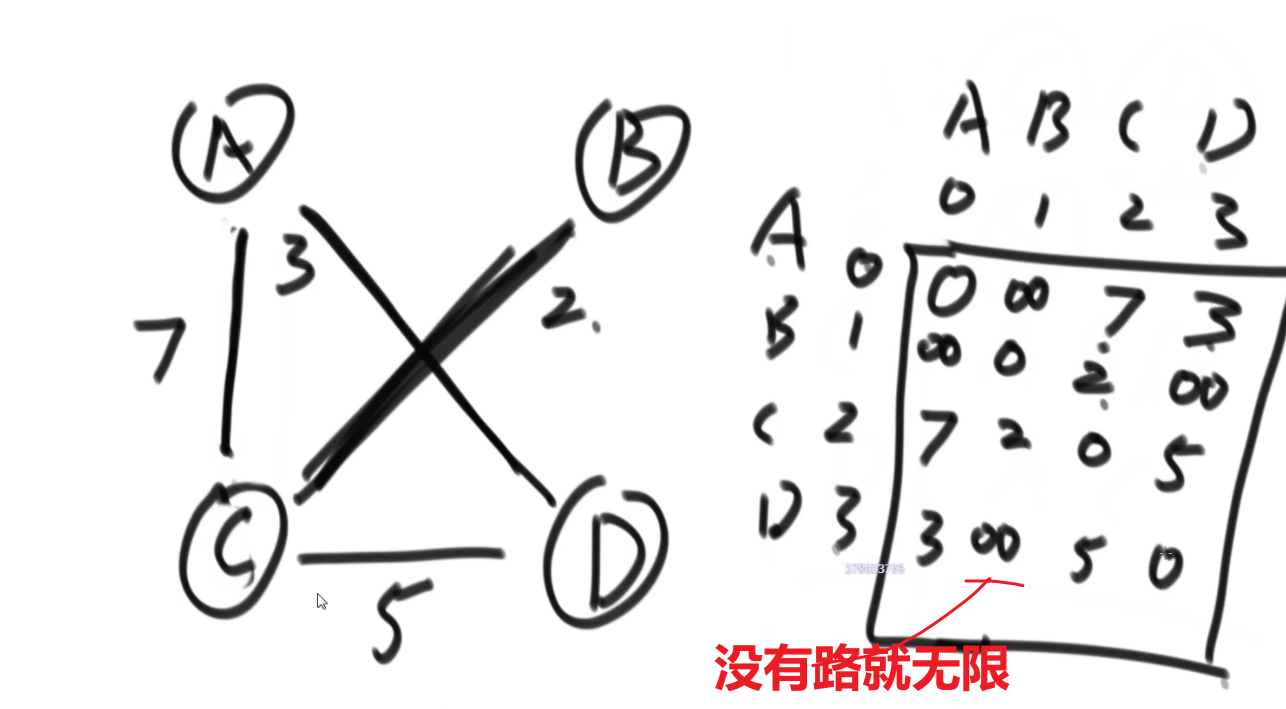

# Adjacency Matrix Representation

-

Adjacency Matrix: 2D array containing weights on edges

- Row for each vertex

- Column for each vertex

- Entries contain weight of edge from row vertex to column vertex

- Entries contain ∞ (ie Integer’last) if no edge from row vertex to column vertex

- Entries contain 0 on diagonal (if self edges not allowed)

-

Example undirected graph (assume self-edges not allowed):

A B C D A 0 1 1 1 B 1 0 ∞ 1 C 1 ∞ 0 1 D 1 1 1 0 -

Example directed graph (assume self-edges allowed):

A B C D A ∞ 1 1 1 B ∞ ∞ ∞ 1 C ∞ ∞ ∞ ∞ D ∞ ∞ 1 ∞ -

Can store weights in cells

-

Space: Θ(V2)

-

Time:

- To visit each node that is adjacent to node u: Θ(V)

- To determine if node u is adjacent to node v: Θ(1)

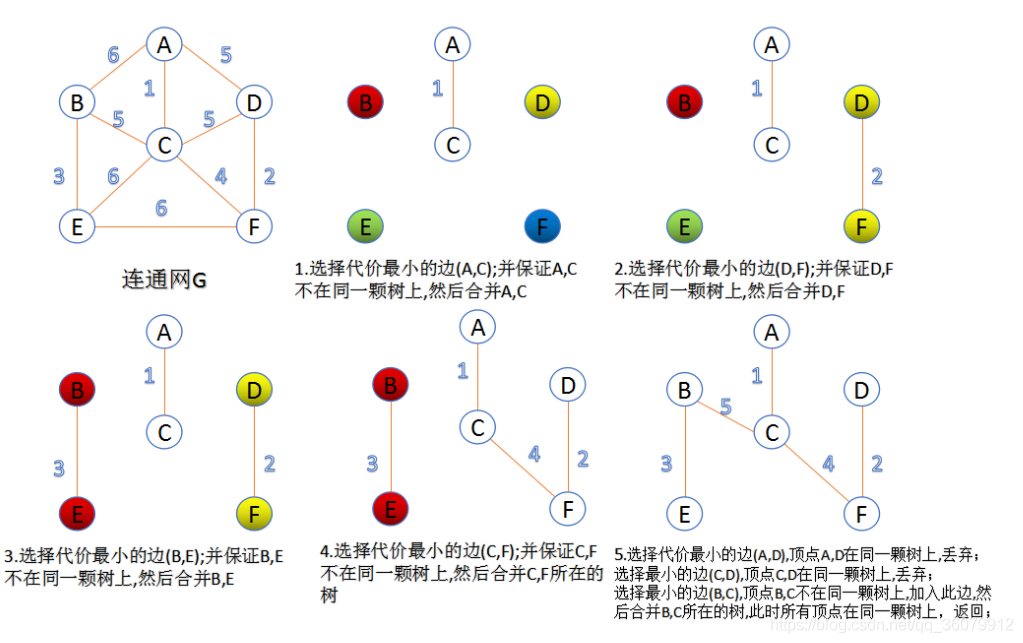

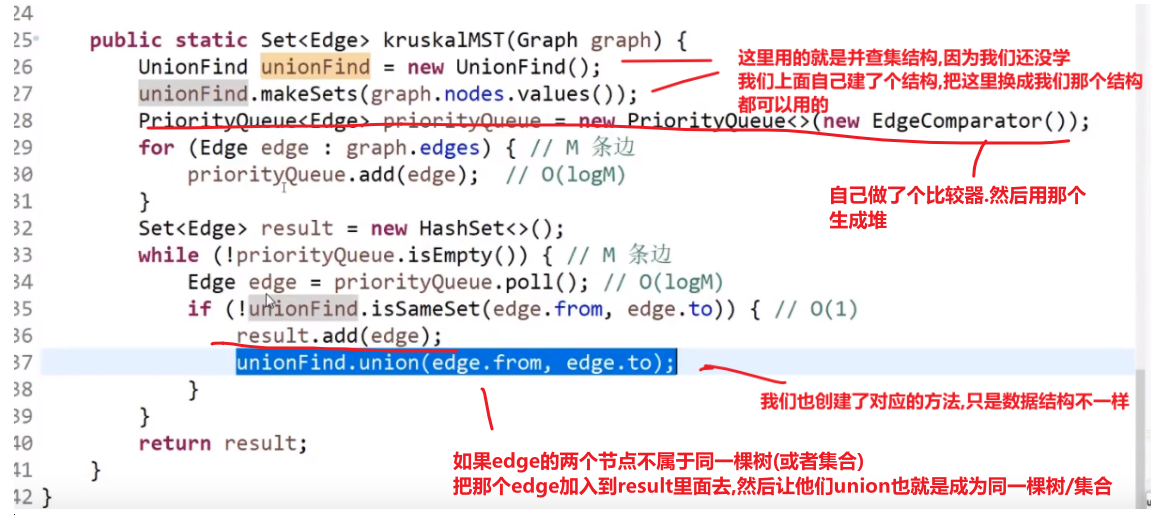

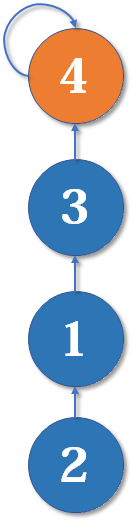

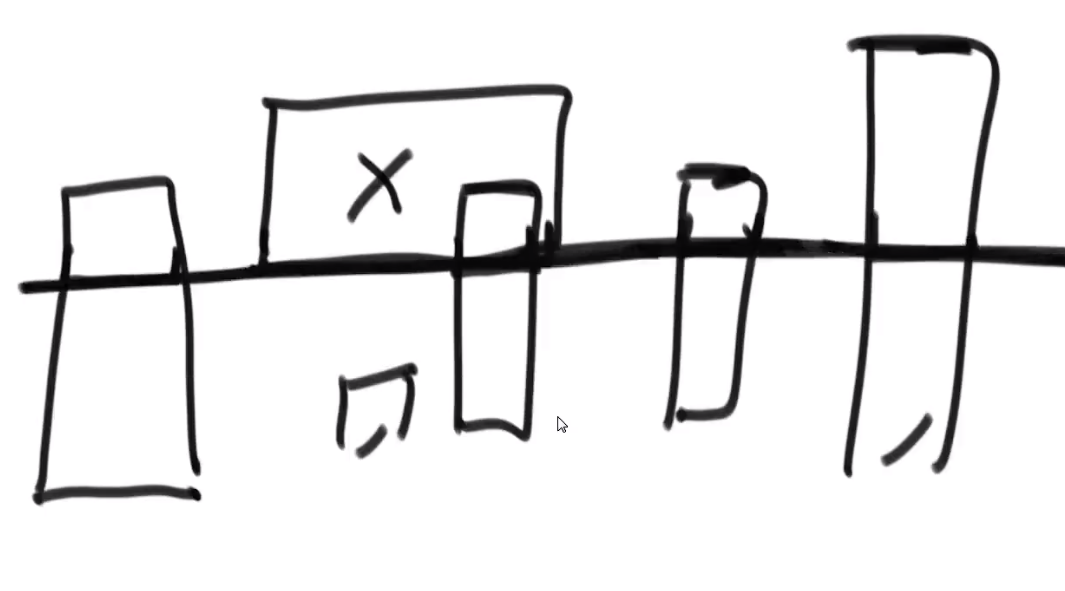

# kruskal 算法(K 算法) 适用范围:要求无向图 (undirected graph/graph)

此算法可以称为 “加边法”,初始最小生成树边数为 0,每迭代一次就选择一条满足条件的最小代价边,加入到最小生成树的边集合里。

-

可以想象一开始每个点就是一个集合 (甚至可以想象是整张 graph 是 n 棵树组成的森林然后把图中的 n 个顶点看成独立的 n 棵树组成的森林)

-

我们接着按照图中所有的 edges 最小 weight 的那个开始 (升序一个一个来)

-

然后对于那个 edge, 我们检查他的 u (from) 节点和 v (to) 节点是不是在一个集合中 (也就是这个边连接的点是不是已经是同一棵树了还是两颗不同的树)

-

如果不在我们就把这个 edge 加入到我们最小生成树里面,然后把 u 和 v 放到一个集合里面去,

------> 当前的边进入最小生成树的集合中不会形成环

-

如果在我们不会把 edge 加入到我们的最小生成树里面,(这说明他们之间已经有路 (path) 了,不需要这个 weight 更高的路)

------> 当前的边进入最小生成树的集合中会形成环

-

-

然后当我们的 edges 都处理完,说明我们最小生成树就有了

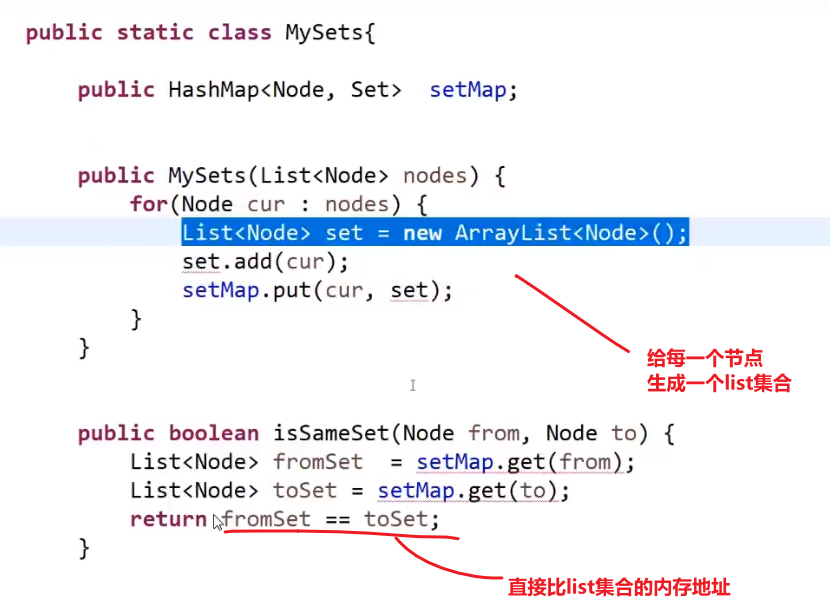

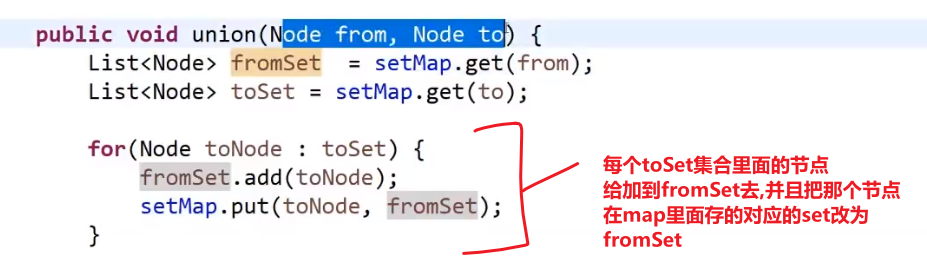

这种需要并查集结构才好实现–> 我们这里只是模拟,之后会学到并查集

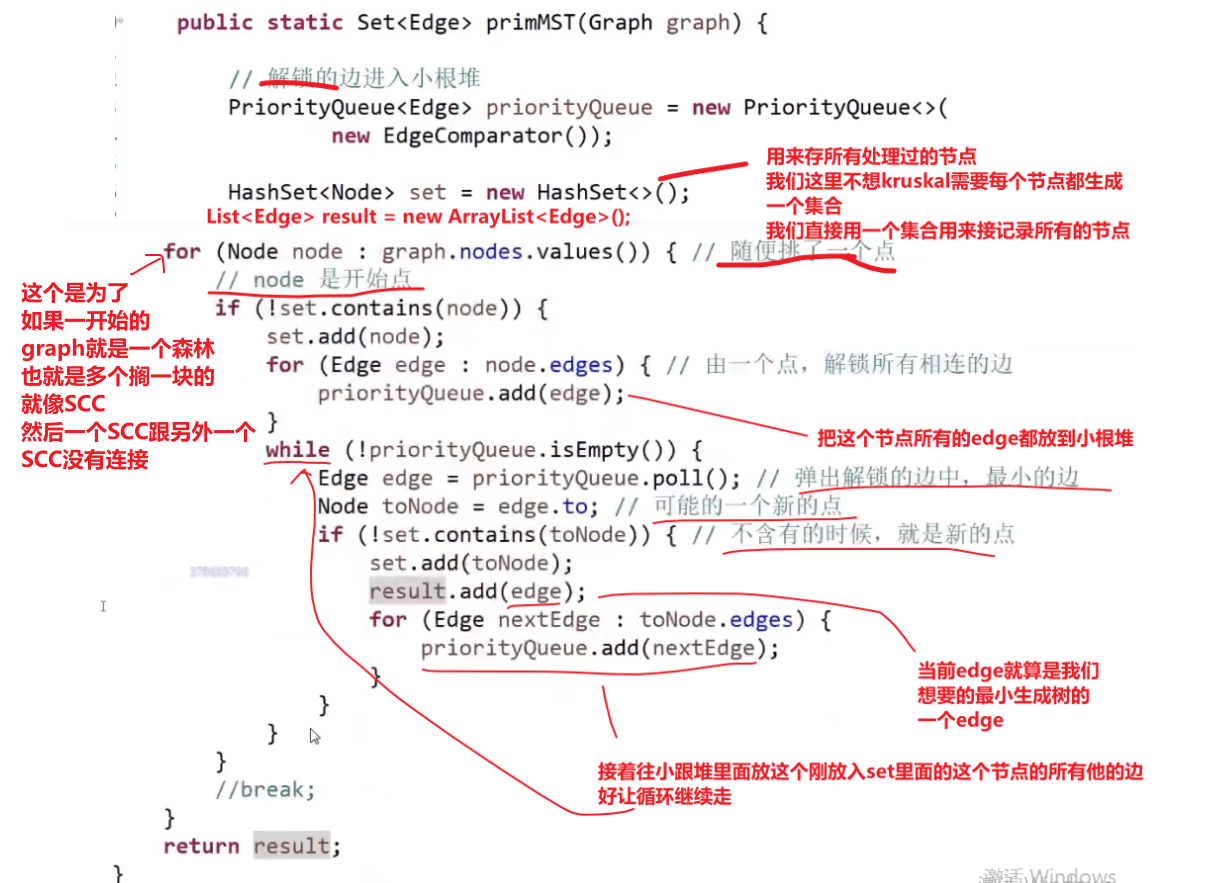

# Prim 算法(P 算法)适用范围:要求无向图 (undirected graph/graph)

此算法可以称为 “加点法”,每次迭代选择代价最小的边对应的点,加入到最小生成树中。算法从某一个顶点 s 开始,逐渐长大覆盖整个连通网的所有顶点。

-

任意一个节点开始

-

我们搜索他的 edges, 然后找那个最小 weight 的,看那个 edge 连着的节点是不是已经访问过 (加入到 set 了)

- 已经访问过,那就继续看下一个最小 weight 的 edge 连接的节点

- 没有访问过,那就把这个节点存入到 set 里面去,并记录这个 edge, 接着把这个新纪录到 set 里面去的节点所有的 edges 放入到小根堆里面,继续找出现在所有的解锁的小根堆里面的有的 edges 按照我们给的比较器规则会找出那个当前最小的 weight 的那个 edge

重复,so on…

(这期间可能会把同一个 edges 多次存入到小根堆,这个没事,因为之后我们取出来都会看那个 toNode 是不是已经是在 set 了,如已经在了那个 edge 也不会被处理) 结果就是找到最小生成树,result 存的都是一个一个最小生成树的 edges

所以要是问题只是告诉你只是一个连通的,那就没必要那个 for 循环

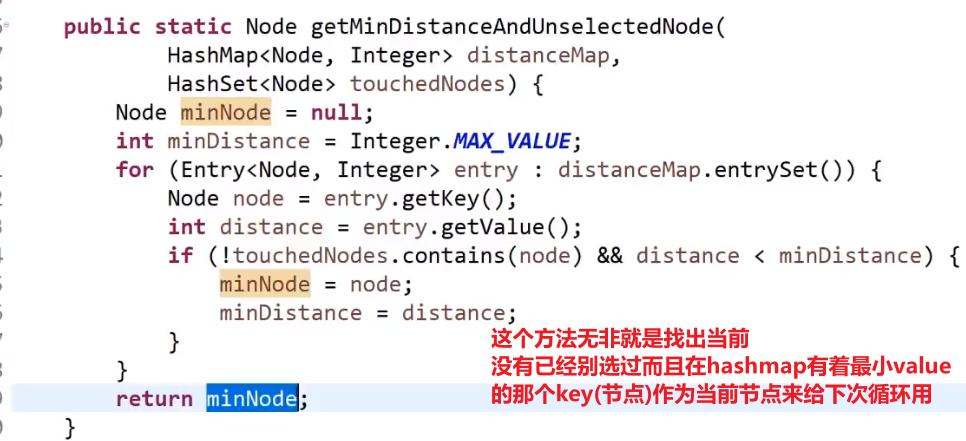

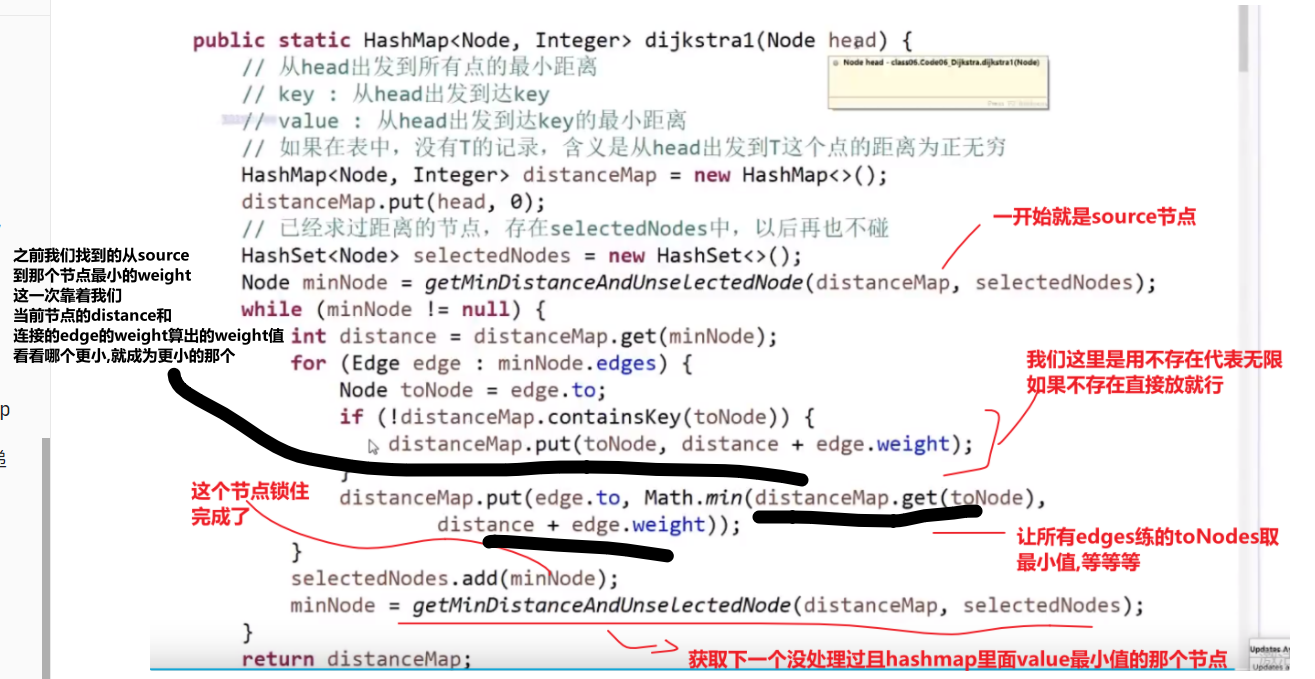

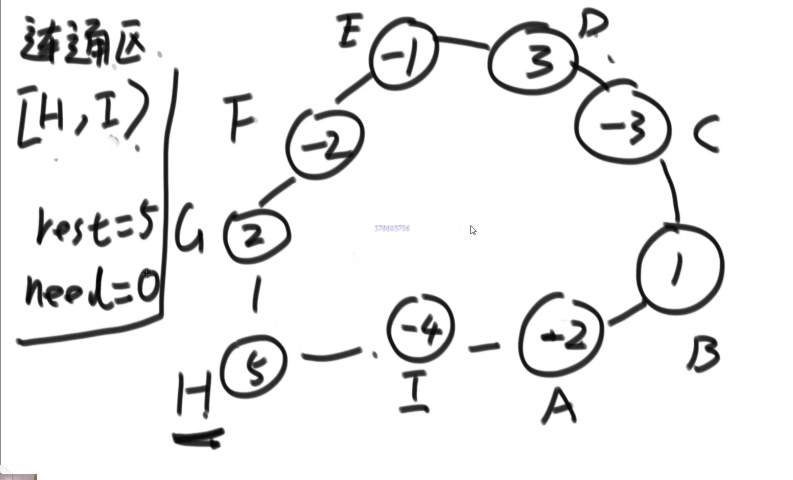

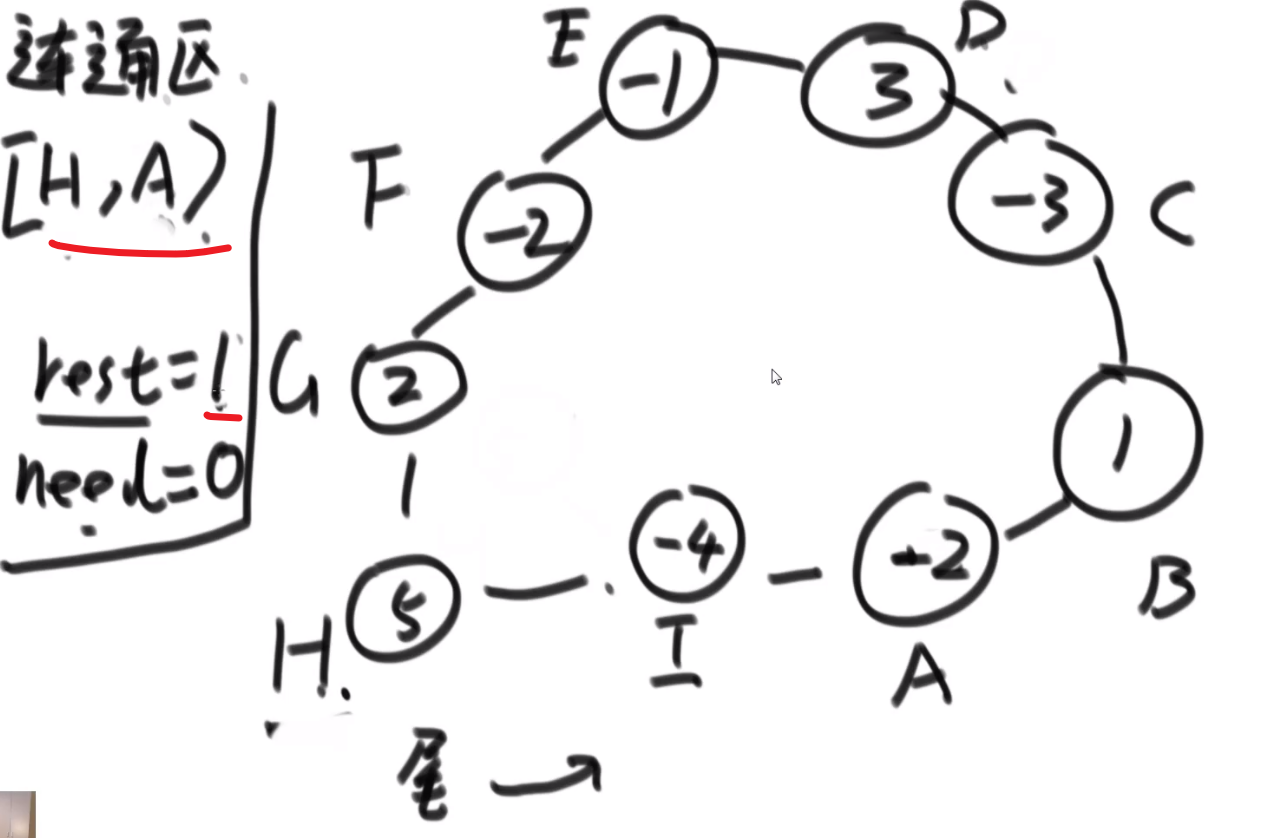

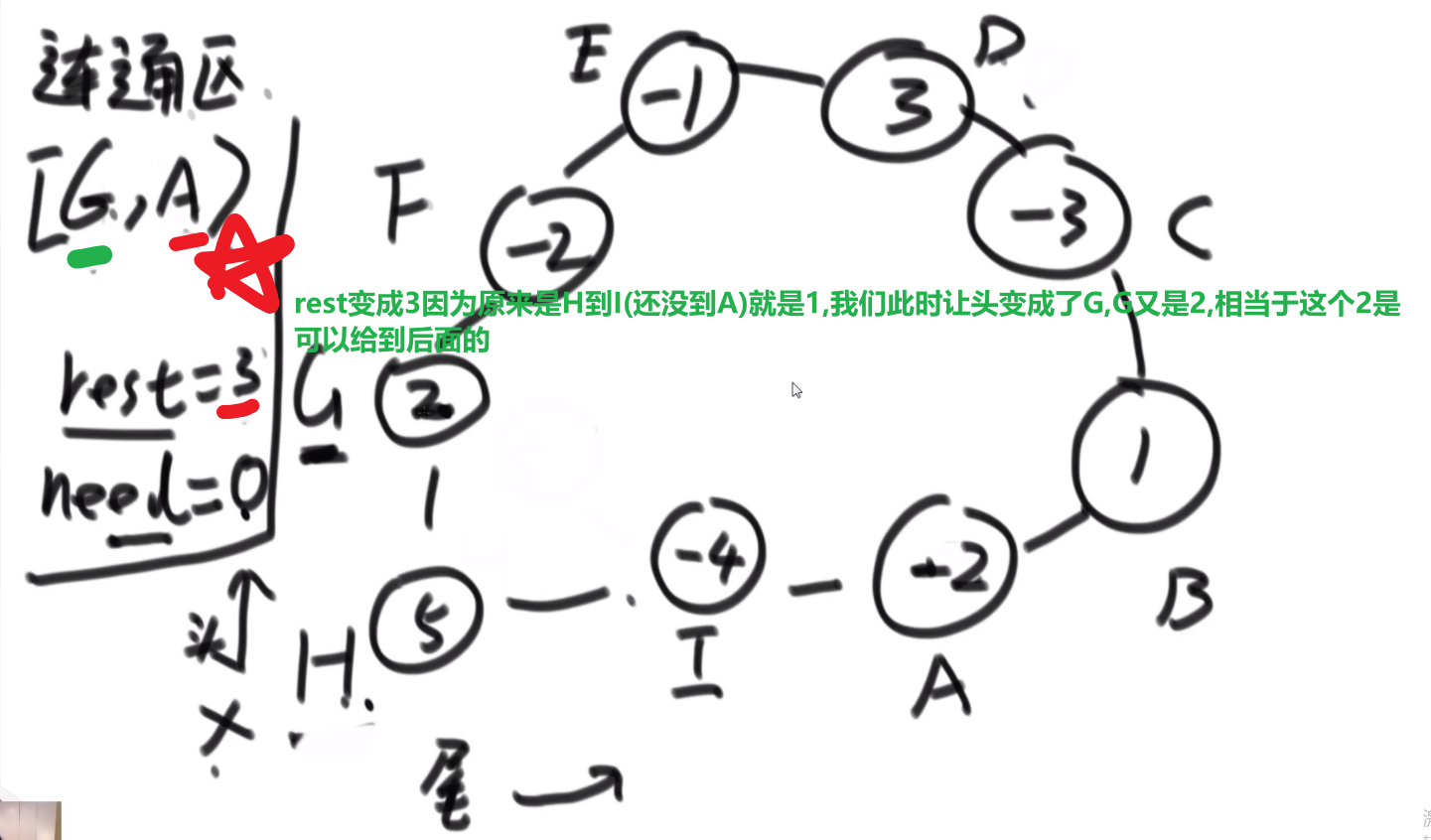

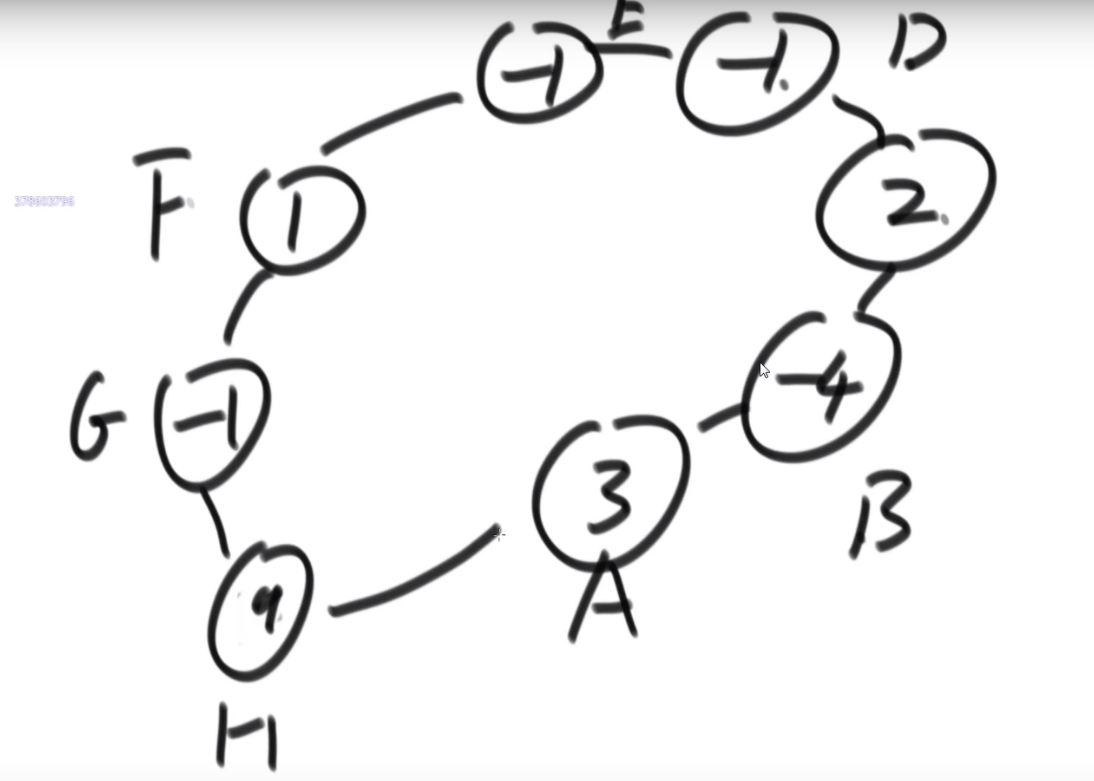

# 迪杰斯特拉算法

求解单元点的最短路径问题:给定带权 (weight) 有向图 G 和源点 v,求 v 到 G 中其他顶点的最短路径

限制条件:图 G 中不可以存在 negative cycle (肯定不行), 也不可以有 negative weight (貌似)

The algorithm creates a tree of shortest paths from the starting vertex, the source, to all other points in the graph.

比如说:

要是有 A 节点无法抵达的节点,那么之间的距离就是无限

迪杰斯特拉算法总共就干了两件事:

【1】不断运行广度优先算法找可见点,计算可见点到源点的距离长度

【2】从当前已知的路径中选择长度最短的将其顶点加入 S 作为确定找到的最短路径的顶点。

有点贪心的意思,每次都锁死一个值,这也为什么不能有 negative weight 因为要是有了那肯定会让之前已经锁死的边的值变,那就不对了

- 一开始存答案的 hashmap, 每个 key 对应一个图中的节点然后 value 就是 source 到那个节点的最小 weight, 一开始 source 到自己是 0 其他都是无限

- 先从 source 出发,然后找到他所有的 edges

- 然后把当前自己的 hashmap 中的值加上每个 edge 的 weight 值然后跟那个 edge 连向的节点当前数组中 hashmap 中的值比较,然后把 hashmap 值改成最小的那个值

- 处理完这个所有 edges, 我们就相当于结束了由 source 开始的所有 edges (我们也可以锁定当前节点在 hashmap 中的值,因为是第一次所以我们这次锁定就是 source 自己再 hashmap 中的值也就是 0, 他的距离到他自己就是 0)

- 然后我们从 hashmap 中选出除了以及当过当前节点的比如说 source 的所拥有的最小值的那个节点,然后让那个节点进行一样的操作 (看 edges 然后对于所有的 edges 的 toNodes 让他们的更新), 然后之后我们就把当前的这个节点在 hashmap 中的值锁死,然后让下一个…so on…

- 直到所有的都锁死了就结束,此时 hashmap 中存的值就是从 source 开始到图中每一个节点所需要的最小 weight (如果没有路就是无限)

一个优化 -> 在选择我们没有处理过且值最小的节点的时候是遍历的方式,可以使用堆结构来存储,然后每次就是存还没处理的,最小值的在堆顶,然后处理过的让他别参加堆结构

但是有一个问题,因为我们那些 values 是存从 source 到每个节点最小的 weight, 所以可能哪次遍历中我们会把一个堆结构中一个节点的值改了改成了一个更小的值,我们知道系统提供的堆结构无法接收让我们改变里面已经在的节点 (你要是硬改,系统里面自己做出的操作其实就跟我们直接遍历的复杂度都差不多了 —> 他需要全局扫描), 所以要是想实现,必须我们自己写一个堆

# 贪心算法

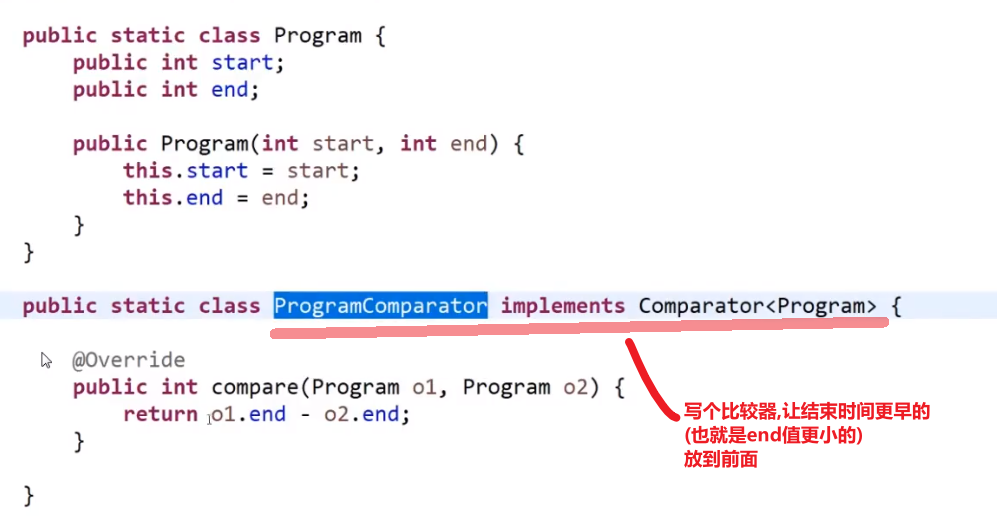

# 会议问题

- 开始时间最早的先安排是不对的,因为这个开始早的很长,之后要是有很多个短的项目都排不上

- 时间间隔最短的项目先安排也是不对的,万一你有两个长的在两遍不相互干扰,但是你有个短的正好一部分用了前面的时间另外一部分用了后面的时间

我们在这里正确的贪心的就是

哪一个项目的结束时间早,就先安排谁

- 把当前所有项目哪个结束的最早先安排

- 然后把所有因为我们安排了那个项目导致进行不了的项目删除掉

- 接着把下一个结束最早的项目进行安排

等等等…

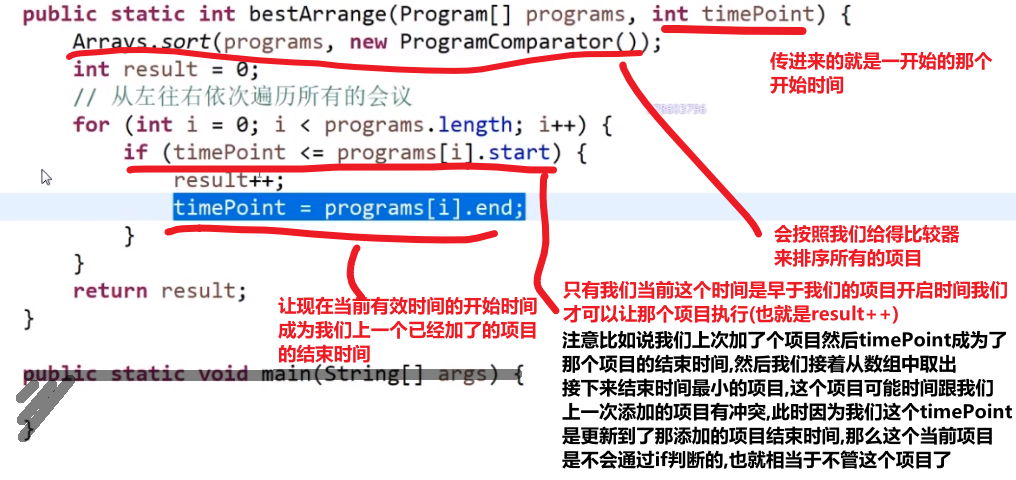

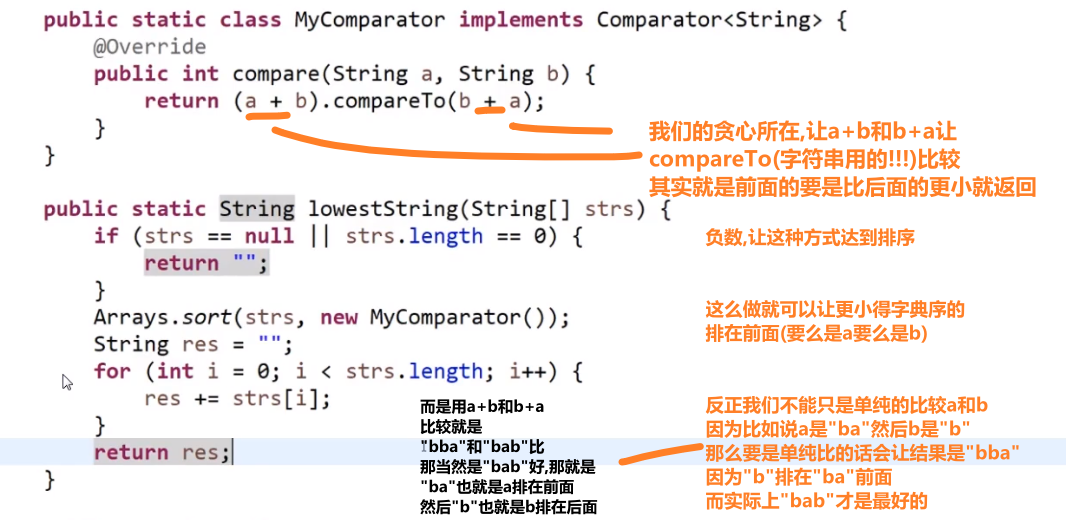

# 贪心题目笔试中套路

多去想,如果想好一个贪心策略,尝试想出一个反例,想出一个就直接 pass 那个贪心策略,继续想别的贪心策略

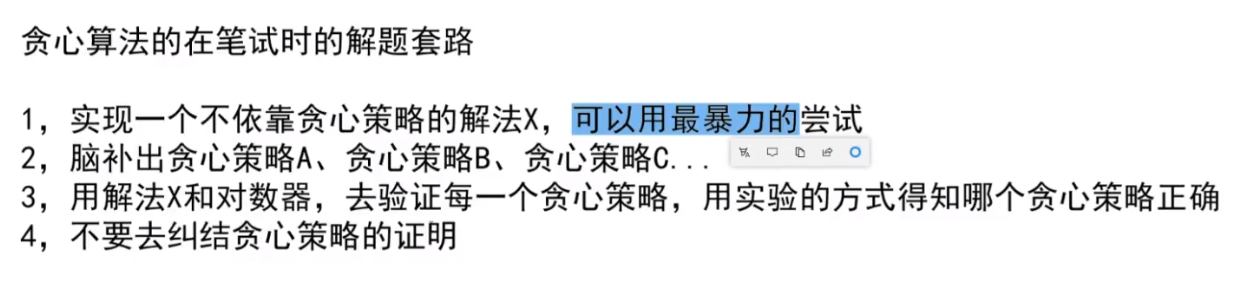

# 字典序例子

而且注意,贪心策略需要注意传递性,像 1<2,2<3 这种都是默认的传递性,而有的传递性就不一样了,需要想好贪心策略

这里的传递性 (transitivity):

然后各种证明…

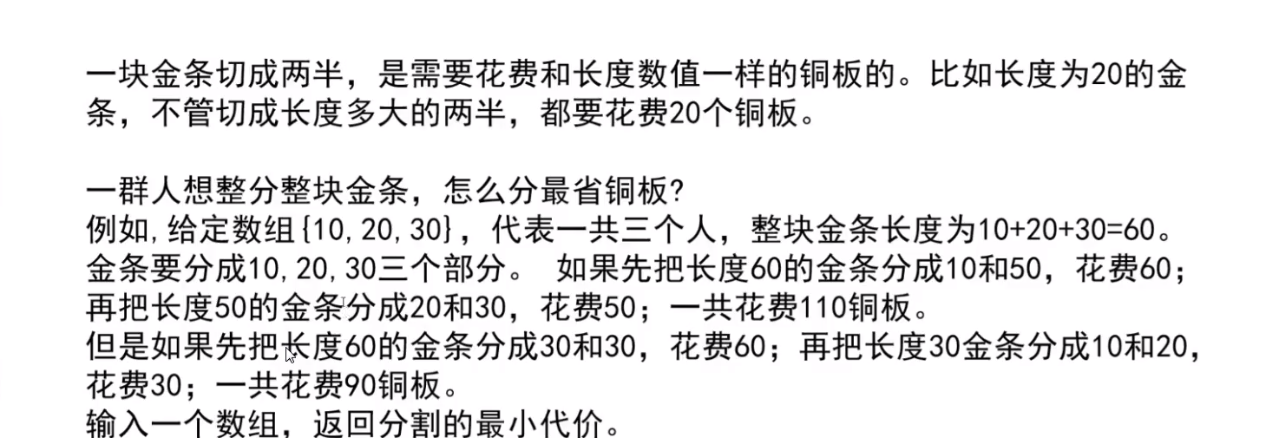

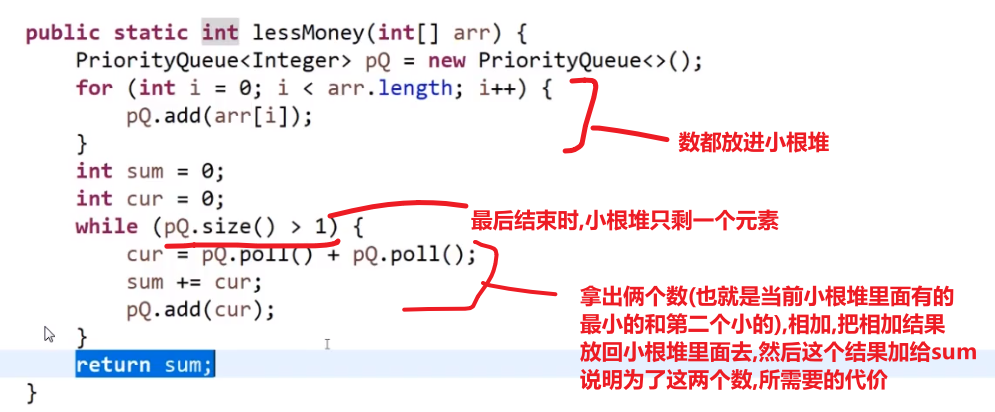

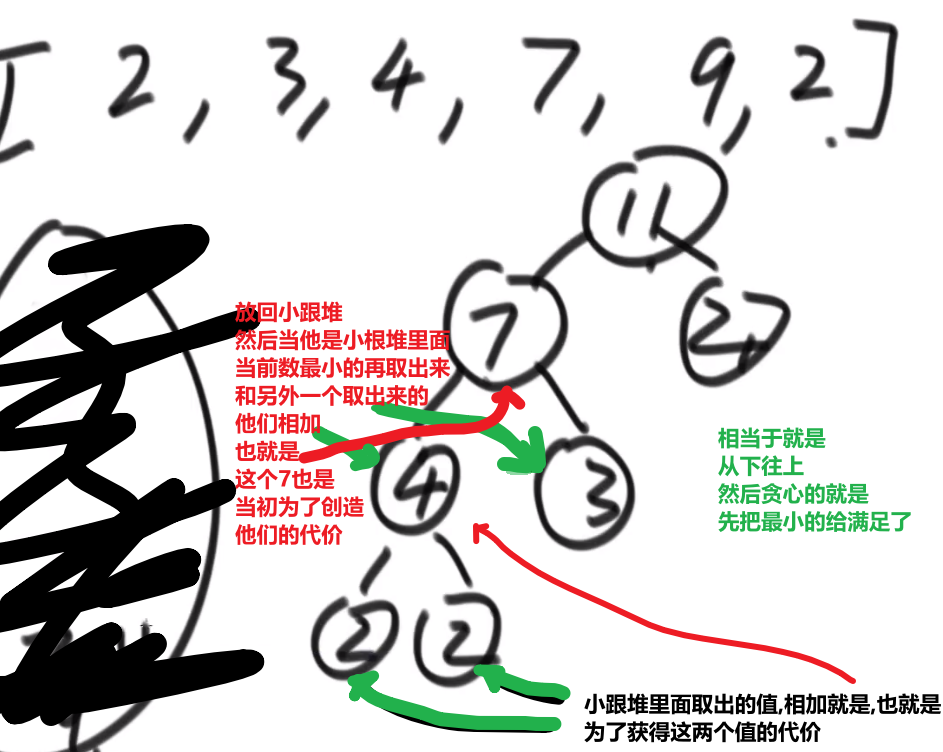

# 金条 (贪心) 问题–> 哈夫曼编码树

- 先把数都放进小根堆

- 接着取出最小的然后 (取完之后那个小根堆结构又形成) 再取那个时候最小的

- 然后我们拿着这俩相加,也就是当初那个树里面分割自己形成的这两个数,然后那个被分割代表的那个就是所要出的代价 (看下面图,有点难说)

- 把这个相加的结果记录到一共的代价里面,然后再把这个相加的结果放回小根堆因为为了形成他,当初可能分割了他和另外一个的数的和

- 重复直到最后只剩一个数,那个数肯定是 60 (in this case), 就一开始的长度

这图只是过程中的一步,11 并不是一开始的长度,27 才是,后面的几步这里没画出来,可以看出来大概就是这么的步骤

最后树的真正样子应该是

贪心策略中

- 堆和排序是最常用的两个技巧

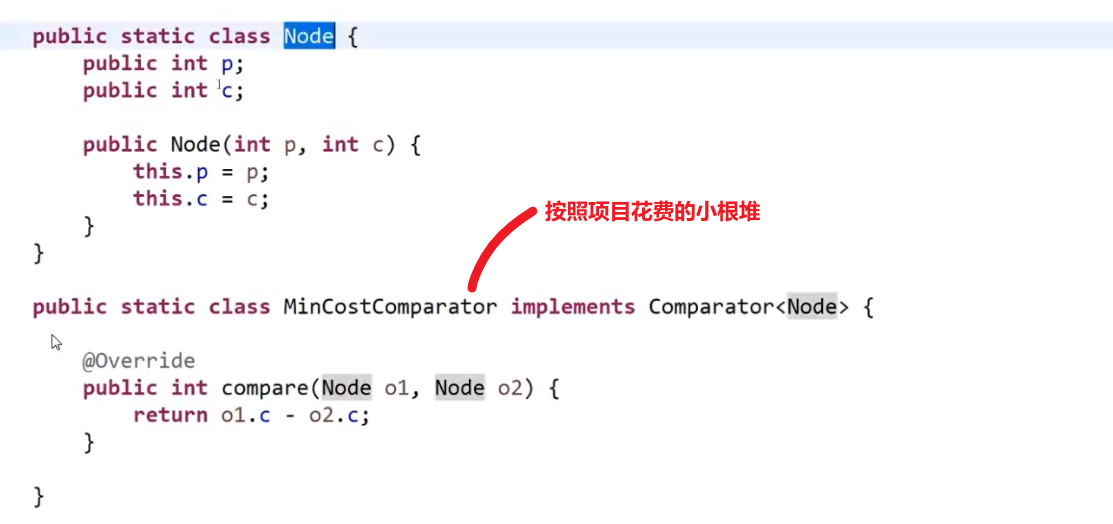

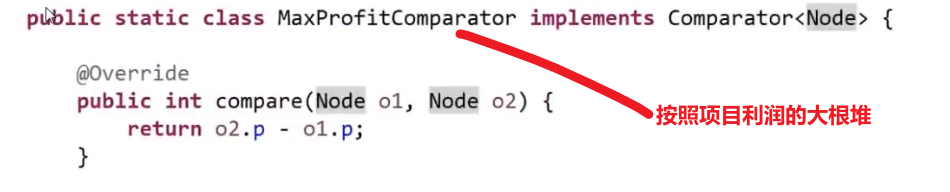

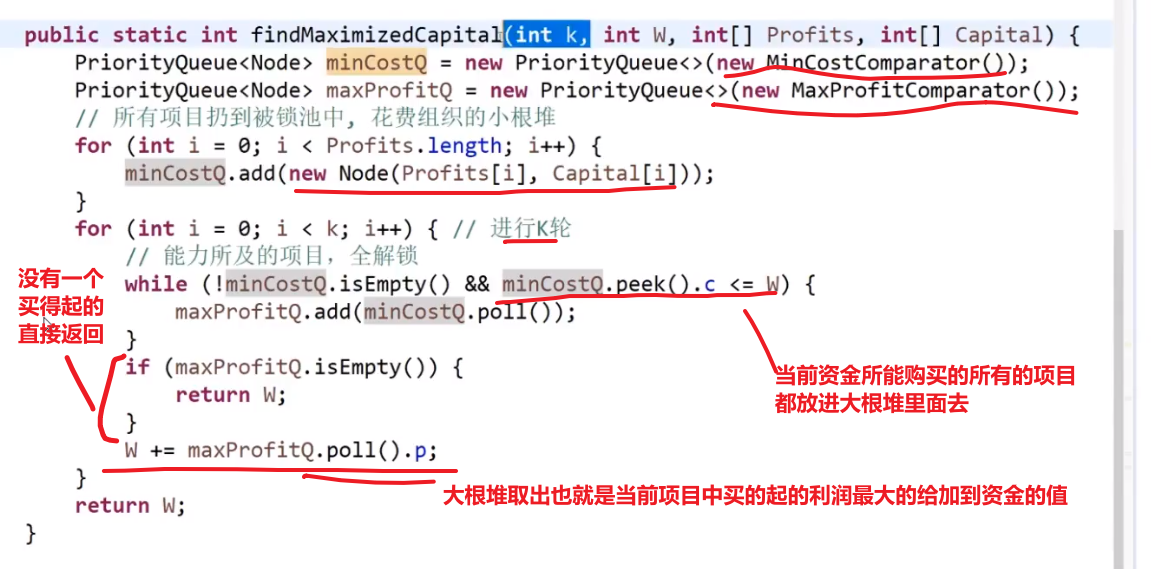

# 项目利润

想法是:

-

先把所有的项目按照他们的花费放到小根堆里面去 (自己写比较器)

-

再从小根堆取出当前资金可以花费的所有的项目

-

把那些项目放到一个按照项目利润的大根堆 (自己写比较器)

-

每次花费一个项目获得其利润都要更新当前资金值

-

如果遇到当前资金买不了任何小根堆里面的花费的 (从最低开始比) 也就代表大根堆里面没有元素了,或者已经交易了 k 次,那就直接返回当前资金

此处的贪心就是按照当前自己的资金可以买的所有的项目中挑选出利润最大的做,做完了更新资金,接着看当前资金可以买的所有的项目中挑选出利润最大的做,…

记住这种大根堆小根堆配合的!!!

这里是有两个可以排序的规则

- 花费

- 利润

然后就想一想对于每一个是用大根堆还是小根堆

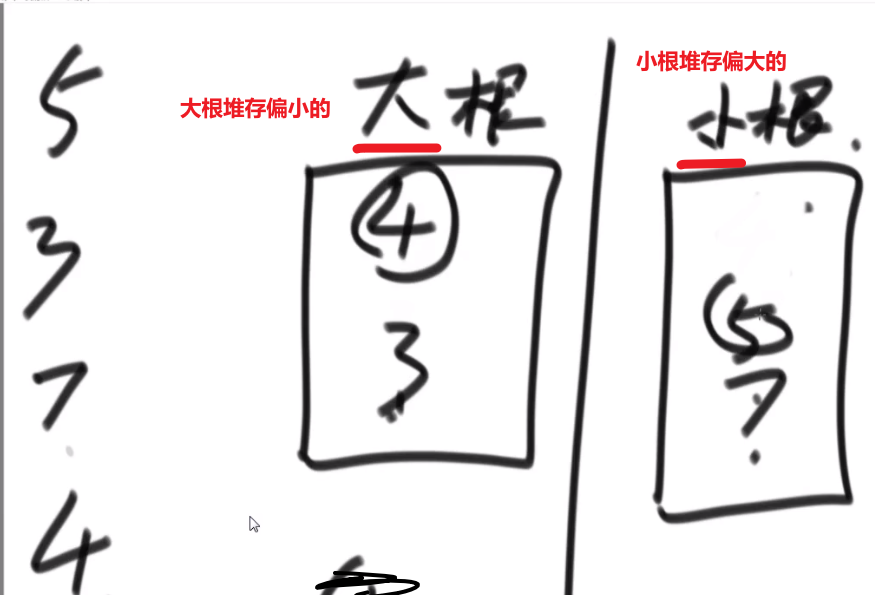

# 取得中位数

就是一个一个给你数,你如何很快地返回一个当前数中的中位数?

答案:大根堆和小根堆!

- 传进来一个数,我们先和大根堆堆顶比

- 如果这个数更小,我们直接放到大根堆里面

- 如果这个数更大,我们直接放到小根堆里面

- 然后接着就是检查当前大根堆和小根堆的 size 是不是大于等于 2

- 是的话就需要把 size 更大的那个根堆的元素取出来放到另外一个根堆里面去

- 不是的话就不用做什么

- 接着要还传了数,就接着处理

这样不管传了多少个数,较小的数都在大根堆里面,较大的数都在小根堆里面

因为各自维持了堆顶,中位数就很好获取到

然后就是看偶数还是奇数,偶数就是两个堆顶相加除 2, 奇数个就是 size 大的那个根堆的堆顶

很快,以为大根堆小根堆的调整水平都是 logN 水平的

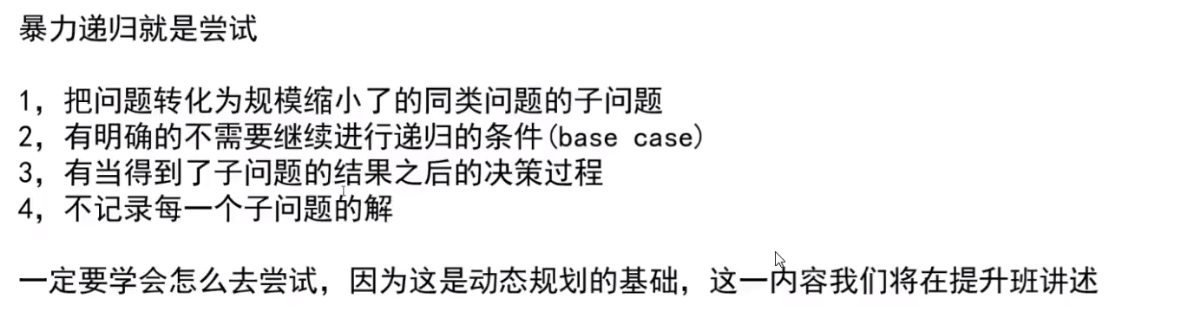

# 暴力递归

回溯就是在递归的基础之上在每一个步骤上进行标记和取消标记的处理

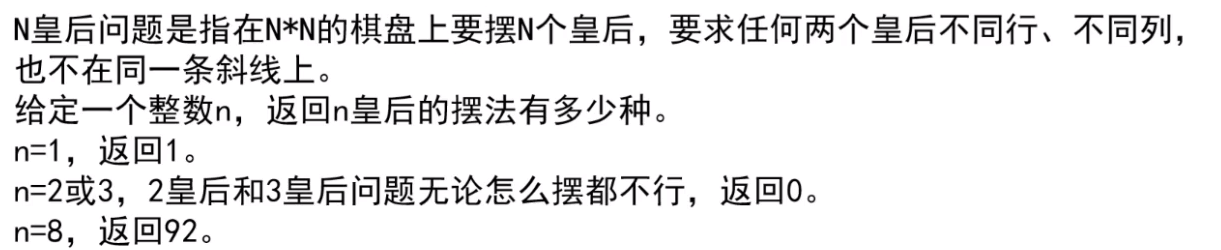

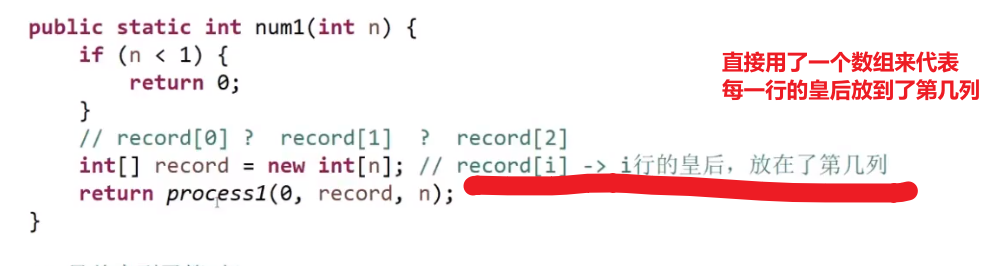

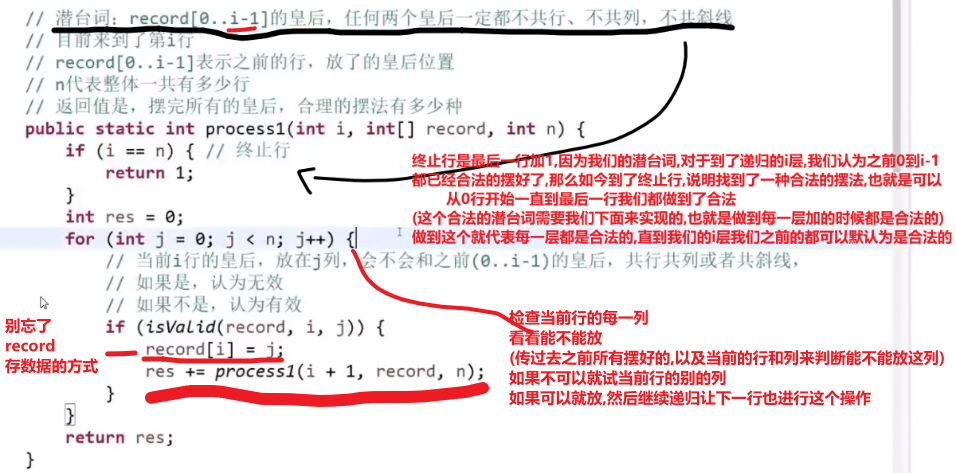

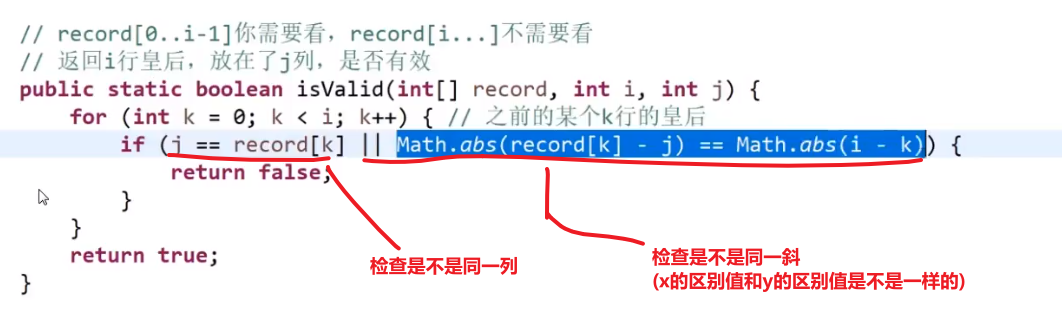

# N 皇后

此处的 for 循环检查每一列很关键,这可以直接给出所有可能性,这个性质其实就是 dfs, 每一条路都试了试

斜线就是 dy/dx=1, 也就是 change in x = change in y

这个算法 ** 时间复杂度是 NN** 因为第一行 N 种选择,第二行 N 种选择,第 N 行 N 种选择 —>(NxNxNxNx…) 相乘 N 次

这个复杂度优化不了,但是我们可以做些常数优化:

用位运算加速!

… 比较复杂

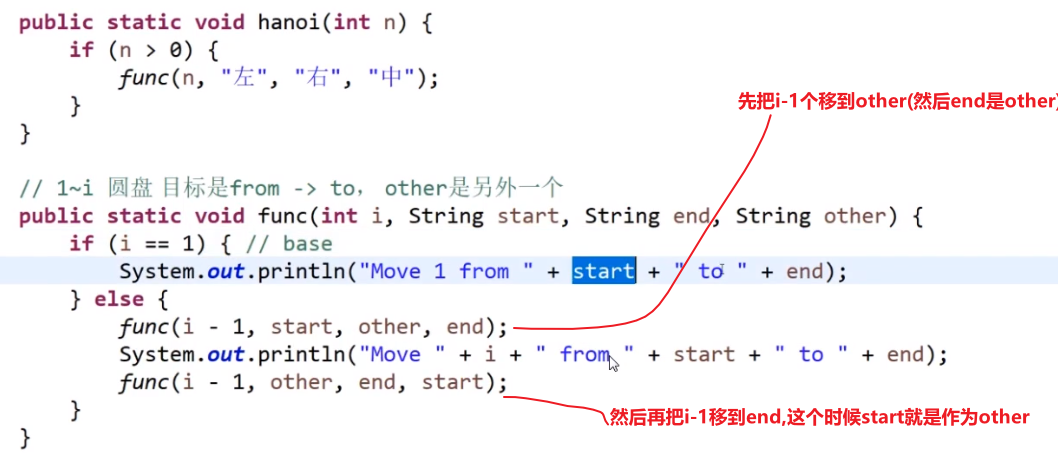

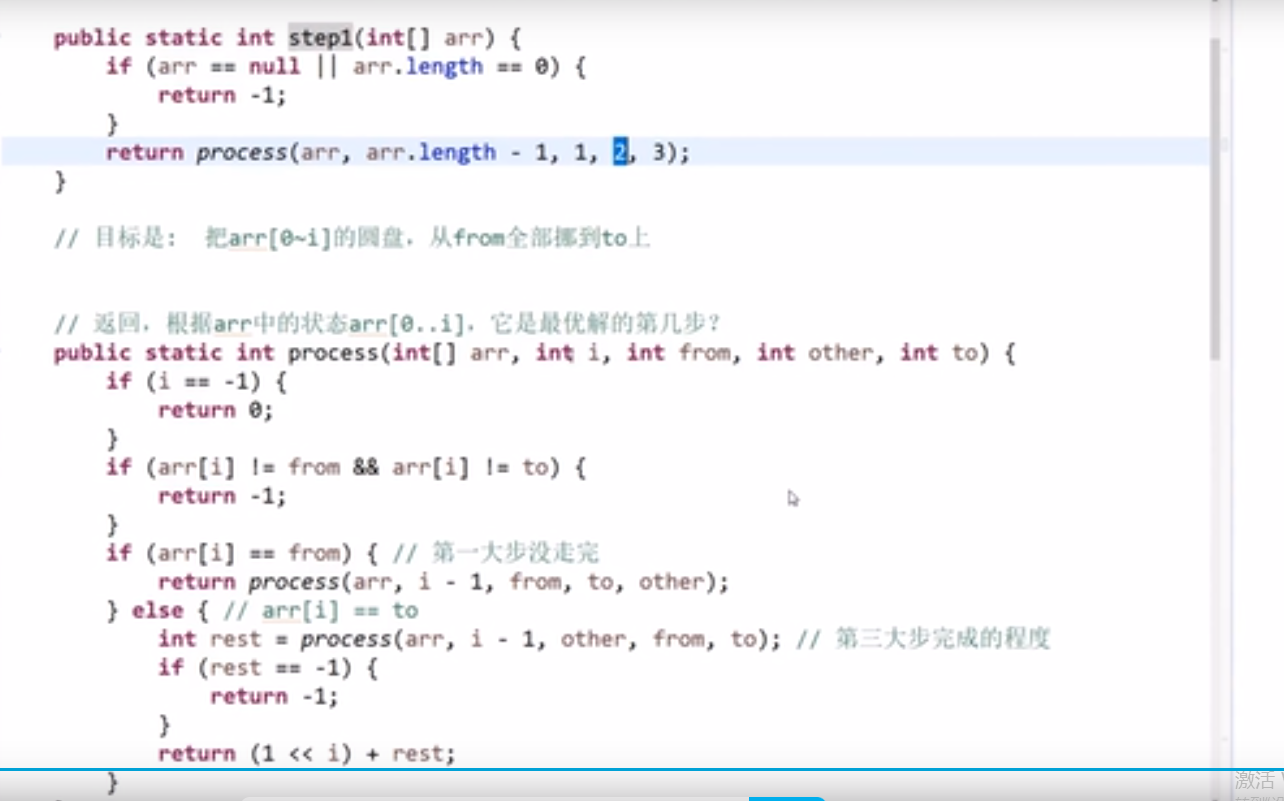

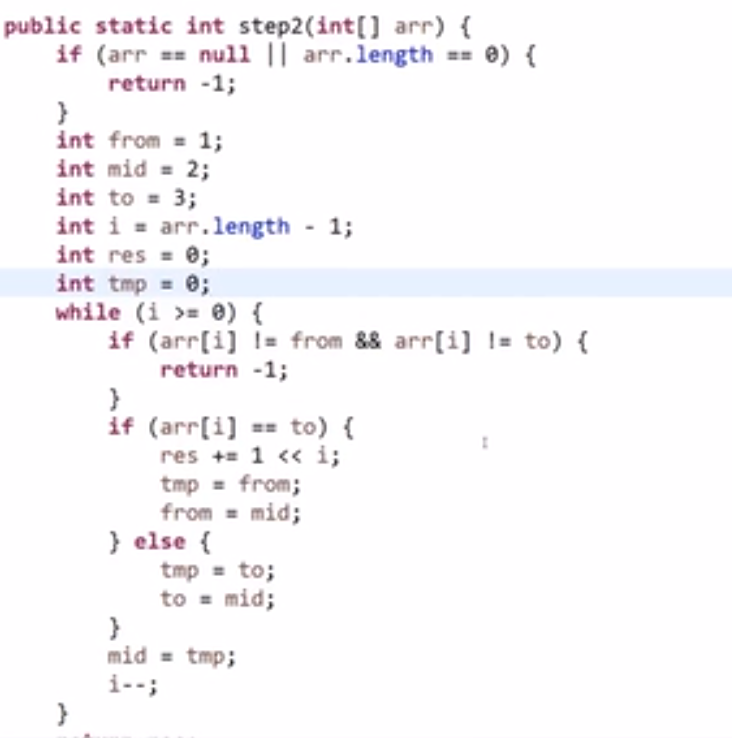

# 汉诺塔问题

解题思路:from: 圆盘所在位置;to: 圆盘要去的地方;help: 用于辅助

- n-1 个圆盘从 from 到 help; (也就是左 -> 中,此时 help 就是右)

- 第 n 个圆盘从 from 到 to; (也就是左 -> 右,此时 help 就是中)

- 把那 n-1 个圆盘从 help 移动到 to 上面来。 (也就是中 -> 右,此时 help 就是左)

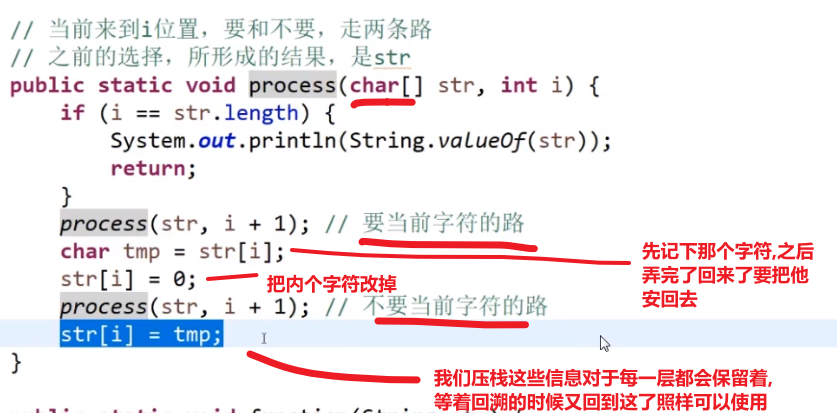

# 打印一个字符串的全部子序列 (subsets),包括空字符串

- 区分子串和子序列: 给定 “pwwkew”

- 子串是 pww,wwk 等很多个子串 是连在一起的

- 子序列是 pwk,pke 等很多个子序列 ,但是子序列中的字符在字符串中不一定是连在一起的。

public class Code_03_PrintSubString {

public static void printSubStr(char[] chs,int i,String res){

if(i == chs.length){

System.out.println(res);

return;

}

printSubStr(chs,i + 1,res);//不需要当前的字符的

printSubStr(chs,i + 1,res + chs[i]);//需要当前的字符的

}

public static void main(String[] args) {

String s = "abc";

printSubStr(s.toCharArray(),0,"");

}

}

//输出

(包含一个空字符串)

c

b

bc

a

ac

ab

abc老师做法:

# 打印一个字符串的全部子序列,要求不要出现重复字面值的子序列

输出前,加入 set 去重

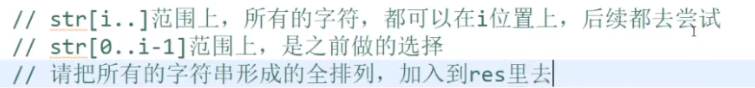

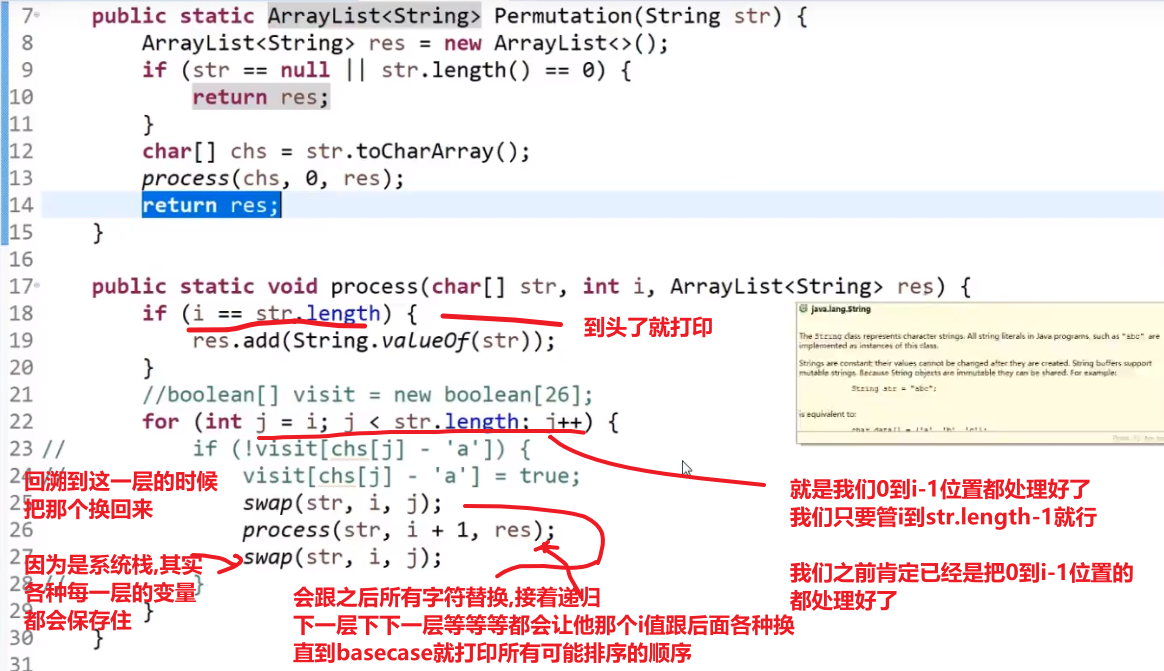

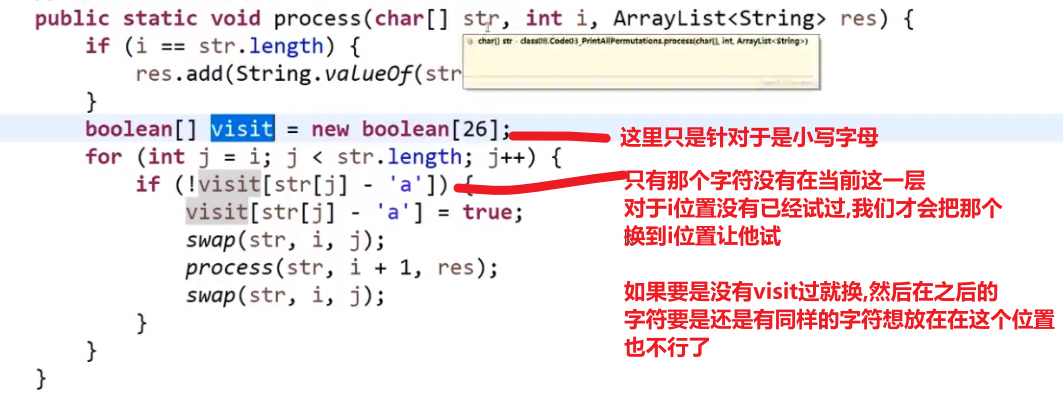

# 打印一个字符串的全部排列

举个栗子:

字符不重复的情况下:

输入:abc

输出:abc acb bac bca cab cba

字符重复的情况下:

输入:acc

输出:acc acc cac cca cca cac

解题思路:把一个字符串看成由两部分组成:第一部分是它的第一个字符;第二部分是后面的所有字符。而我们求整个字符串的排列,可以看成两步。

求所有可能出现在第一个位置的字符,即把第一个字符和后面所有的字符交换。

固定第一个字符,求后面所有字符的排列。

这时候我们仍把后面的所有字符分成两个部分:后面字符的第一个字符,以及这个字符之后的所有字符。然后把第一个字符和它后面的所有字符交换。(重复 1、2 步骤)

printAllPermutations2 为分治限界方法,可以减少递归次数

public class Code_04_Print_All_Permutations {

public static void printAllPermutations1(String str) {

char[] chs = str.toCharArray();

process1(chs, 0);

}

public static void process1(char[] chs, int i) {//交换的是当前位置之后的元素

if (i == chs.length) {

System.out.println(String.valueOf(chs));

}

//如果i没有终止,i... 都可以来到位置

for (int j = i; j < chs.length; j++) {//这个的理解是难点

swap(chs, i, j);

process1(chs, i + 1);

swap(chs, i, j);

}

}

// 在选择位置时就利用set ,减少递归次数,时间换空间

public static void printAllPermutations2(String str) {

char[] chs = str.toCharArray();

process2(chs, 0);

}

public static void process2(char[] chs, int i) {

if (i == chs.length) {

System.out.println(String.valueOf(chs));

}

HashSet<Character> set = new HashSet<>();

for (int j = i; j < chs.length; j++) {

if (!set.contains(chs[j])) {

set.add(chs[j]);

swap(chs, i, j);

process2(chs, i + 1);

swap(chs, i, j);

}

}

}

public static void swap(char[] chs, int i, int j) {

char tmp = chs[i];

chs[i] = chs[j];

chs[j] = tmp;

}

public static void main(String[] args) {

String test1 = "abc";

printAllPermutations1(test1);

System.out.println("======");

printAllPermutations2(test1);

System.out.println("======");

String test2 = "acc";

printAllPermutations1(test2);

System.out.println("======");

printAllPermutations2(test1);

System.out.println("======");

}

}

[[1,2,3],

[4,5,6],

[7,8,9]

]老师做法:

- 那个 str 的 char array 相当于就是我们递归的每一层所做的选择

个人认为那个 for 循环才是秒

- 首先一般你要考虑各种可能性 (然后这个可能性是指这第一个元素各种可能性,第二个元素也是各种可能性,so on…), 那么就可以考虑 for 循环第一个给他安排各种选择,然后递归调用自己的 (也就是对于他第二个元素等等), 然后那一层接着会调用下一层

- 这样就做到了每一层接着都实现了各种可能性,当然要保证 base case 到达了之后我们做出我们对于每种可能性的结果做出合理的处理 (存起来?打印?返回上一层?等等等)

- 我们还可以设置各种条件,比如说当前元素有没有已经存在等等等 (这个操作可能需要我们额外传一些参数,这样每一层都能知道当前状况) 如果有,也不要继续递归直接返回什么的,相当于把这个 branch 直接断掉了

# 打印一个字符串的全部排列,要求不要出现重复的排列

-

举个栗子:

输入:acc

输出:acc cac cca

思路同上,加入了 HashSet 来去重。

public class PrintAllSort {

public static void printAllSort(String string){

if(string == null){

return;

}

char[] chars = string.toCharArray();

if(chars.length > 0){

func2(0, chars);

}

}

// 对i及i以后的字符进行全排序

public static void func2(int i, char[] chars){

if(i == chars.length){

System.out.println(String.valueOf(chars));

}

// 用于保证每次交换的字符不存在重复字符

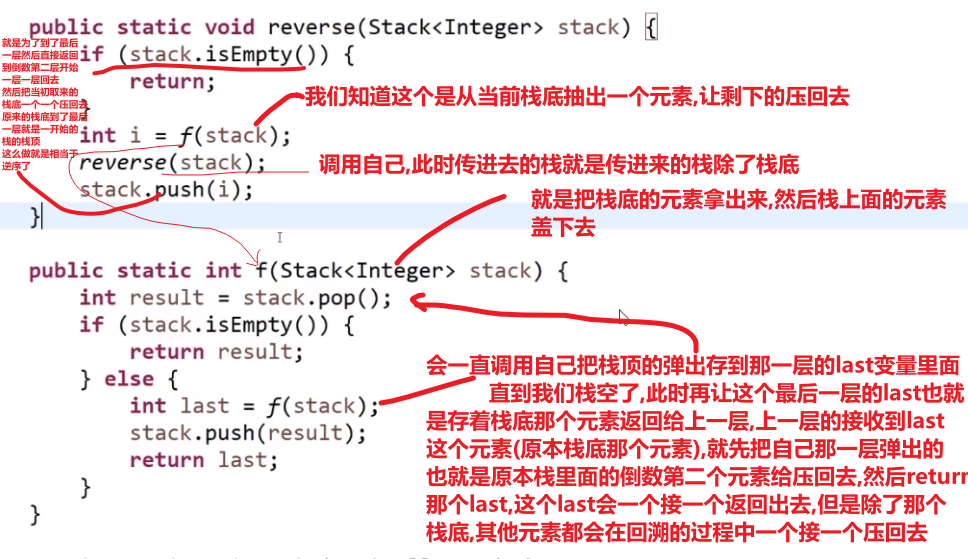

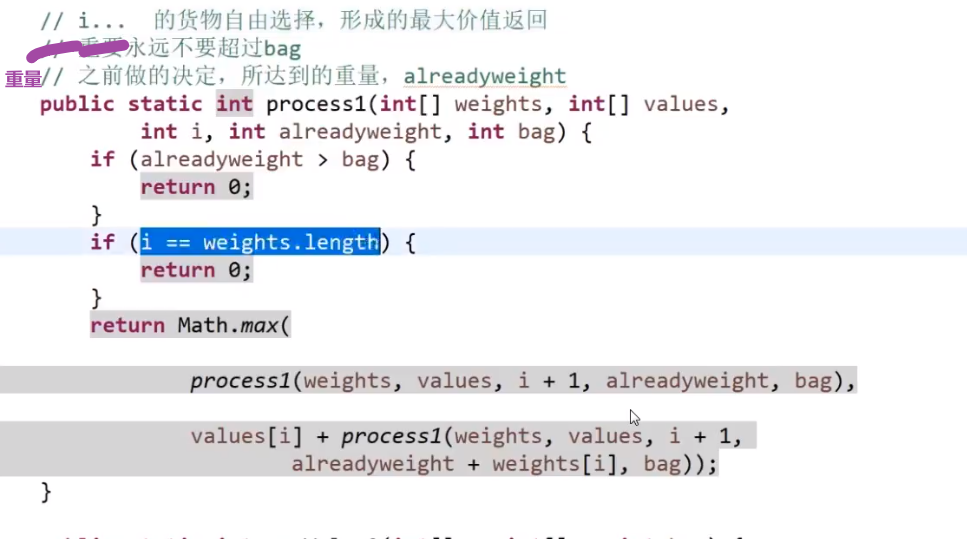

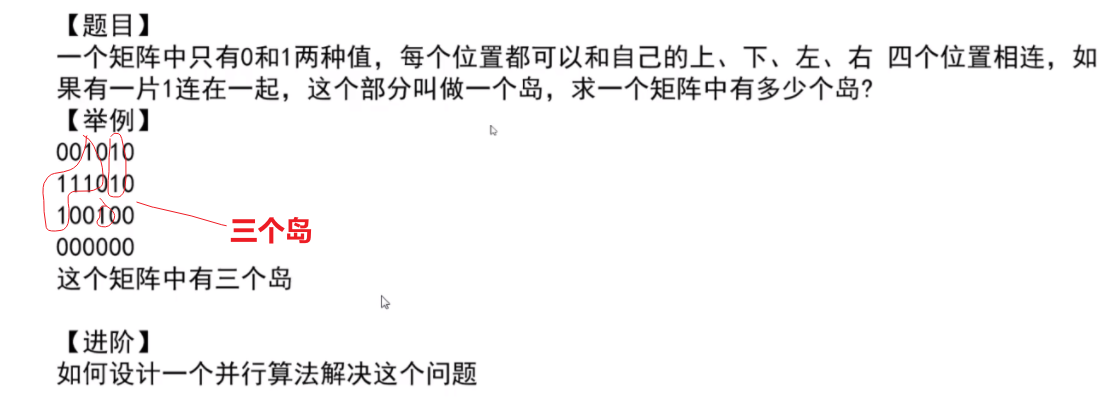

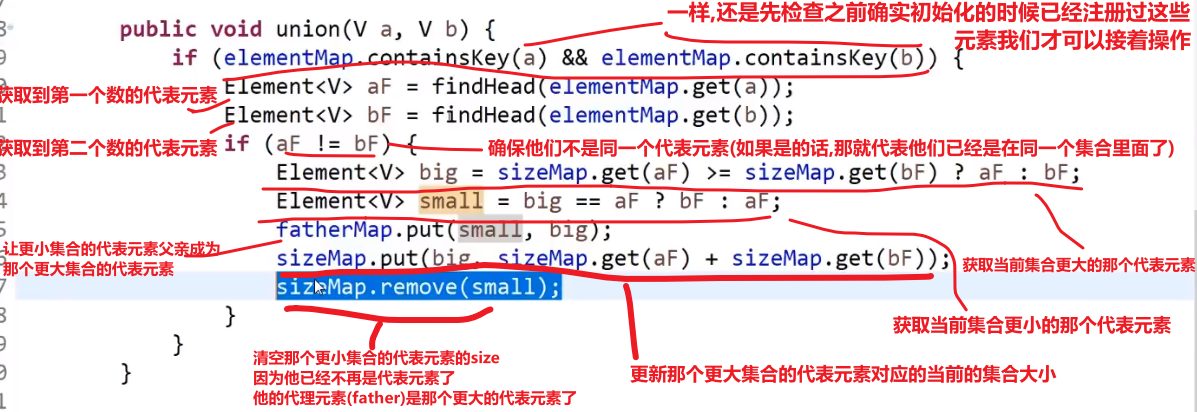

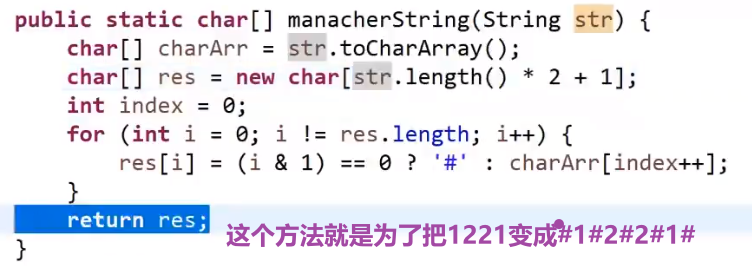

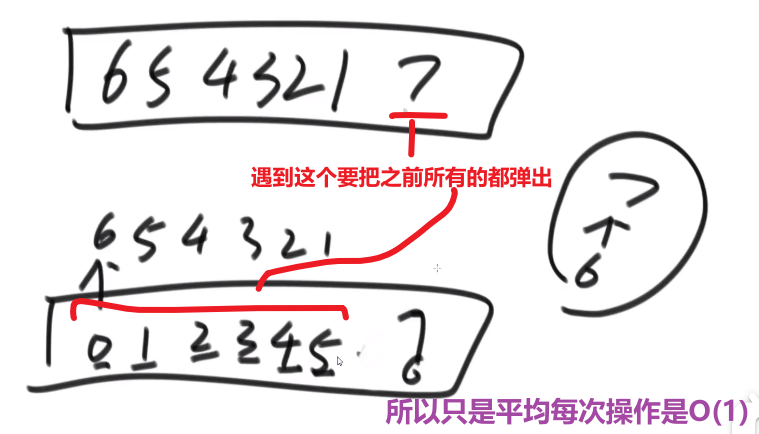

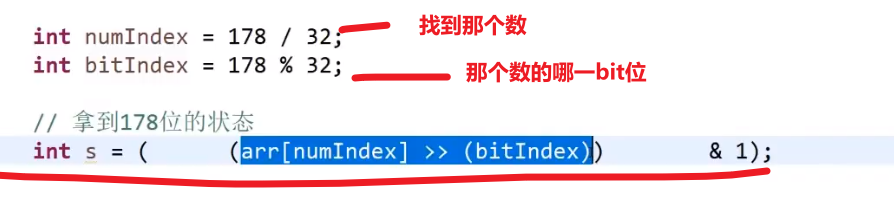

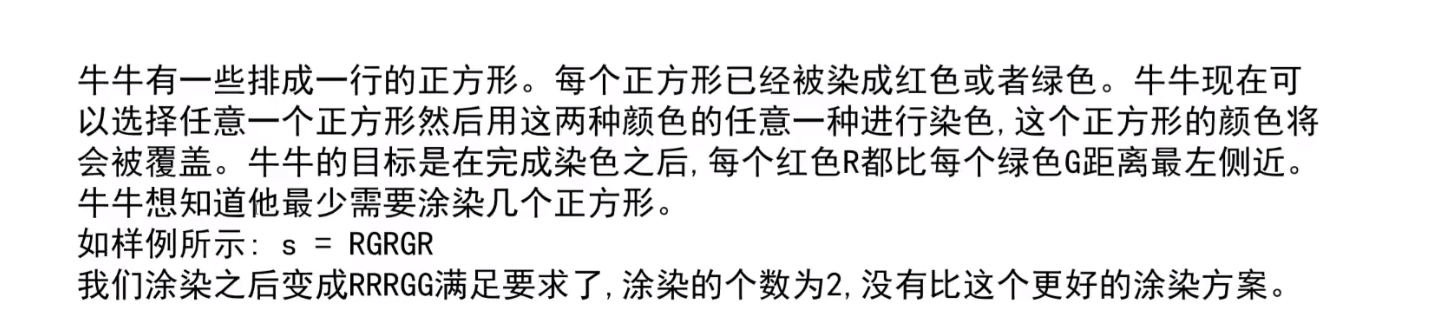

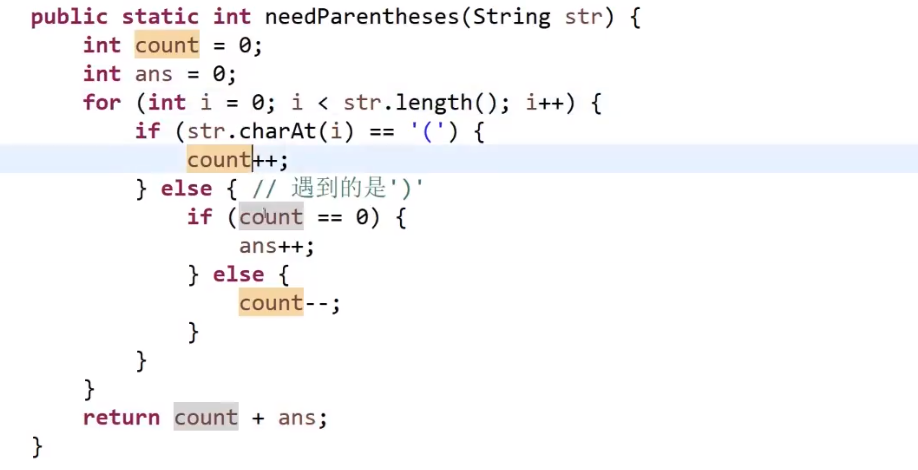

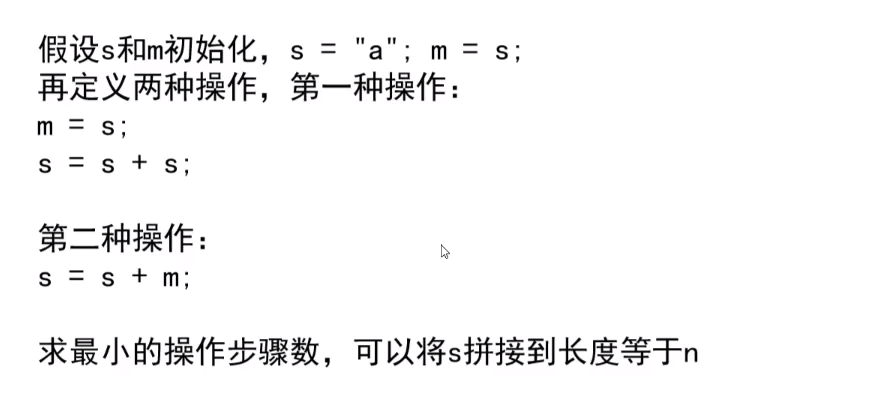

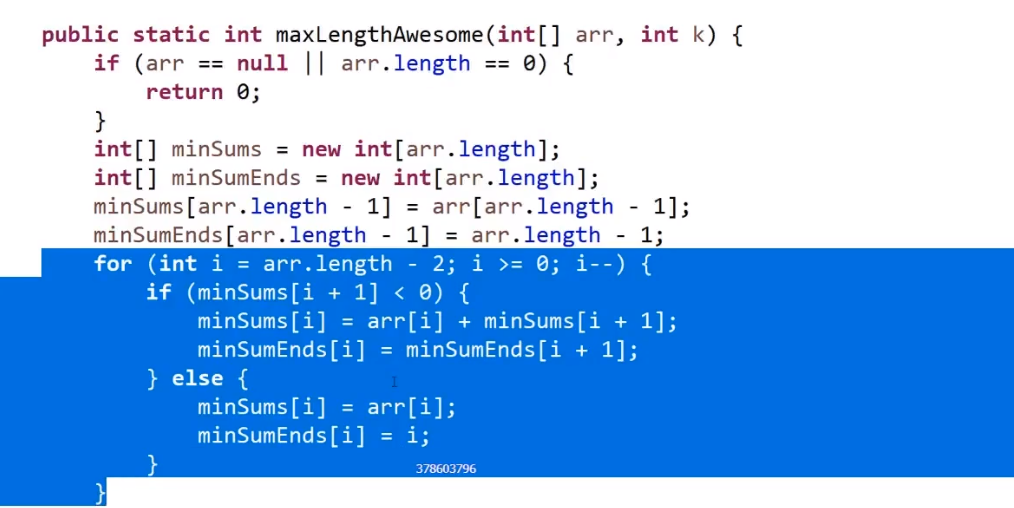

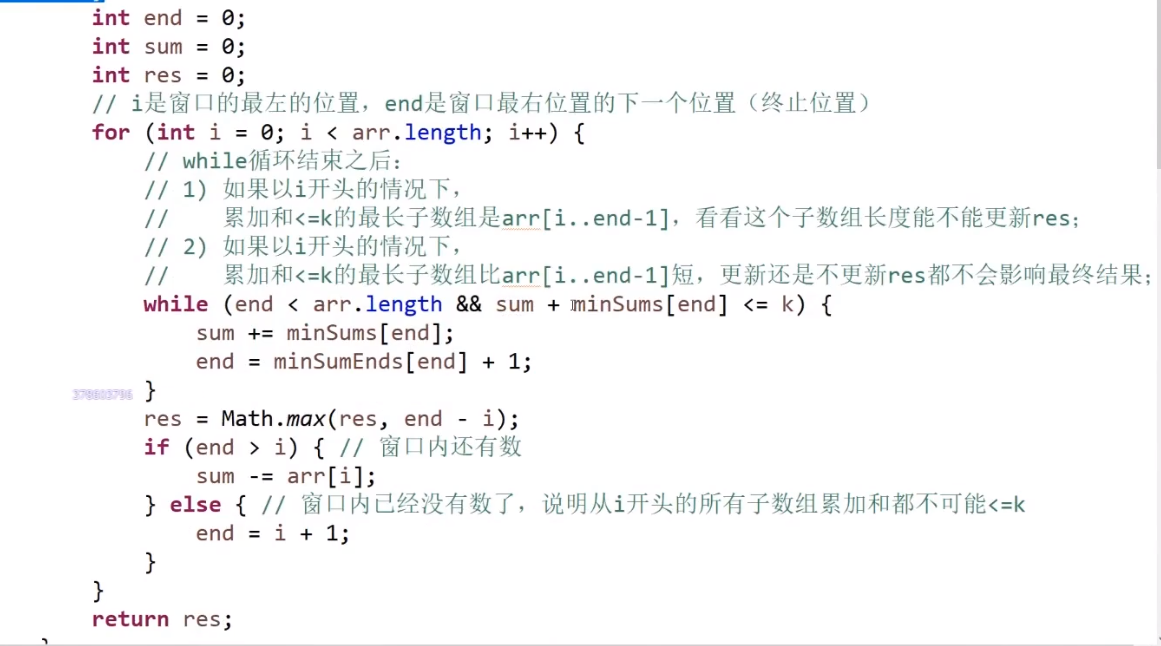

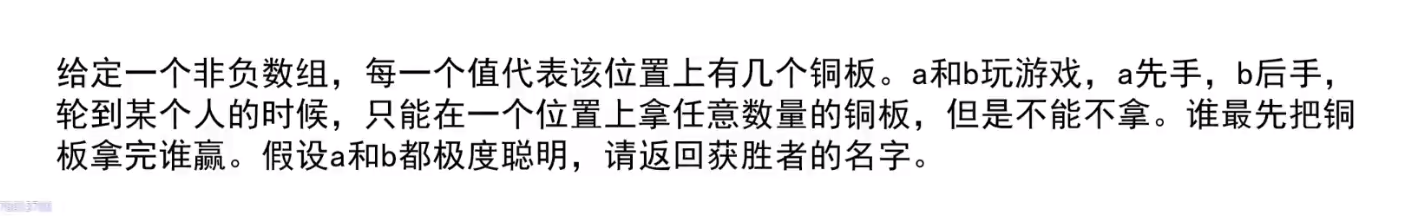

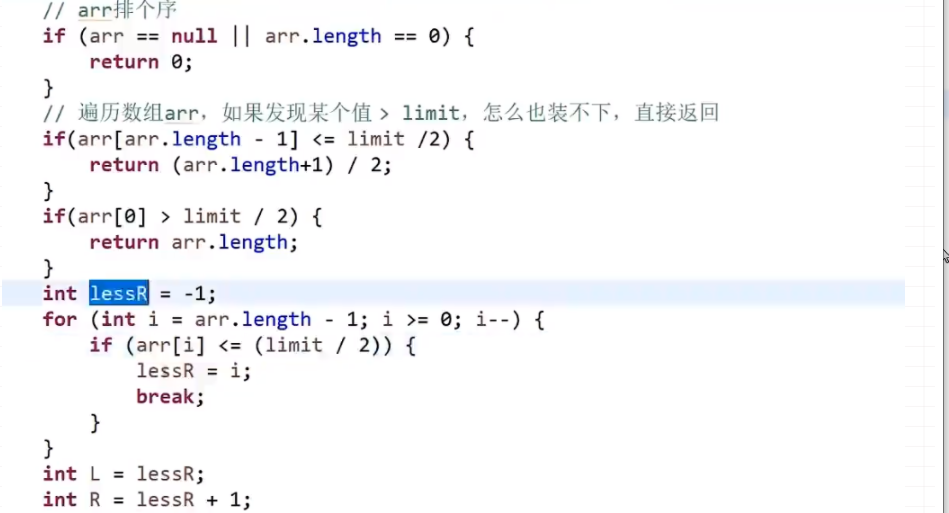

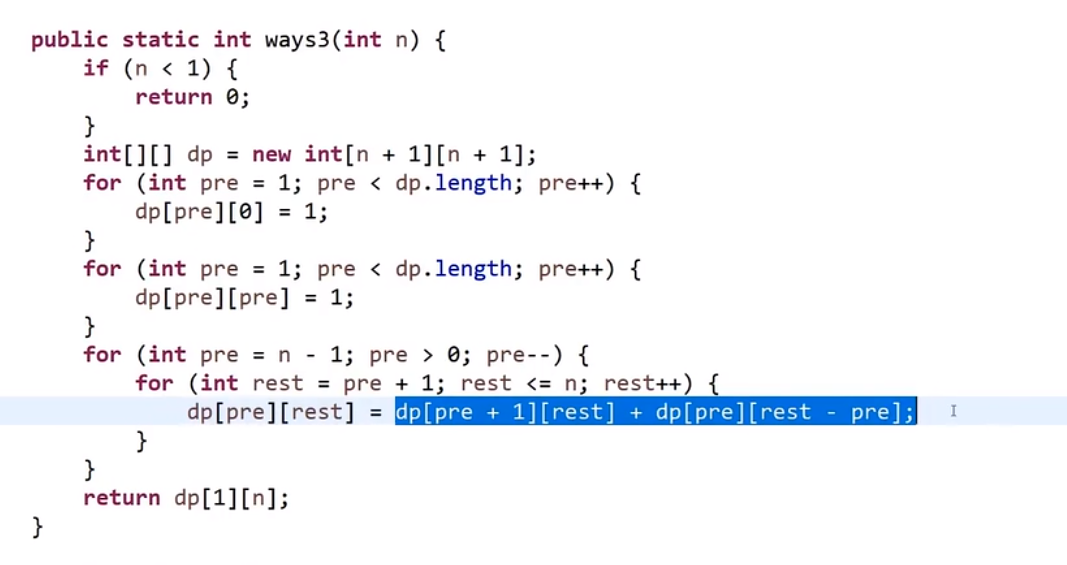

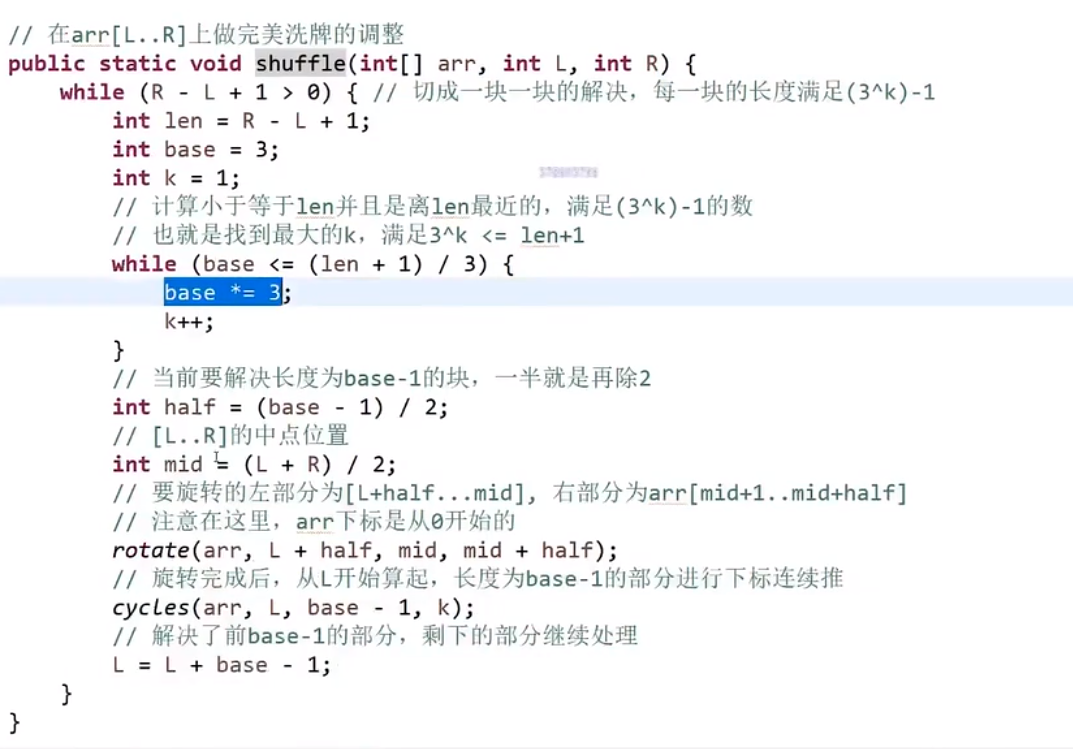

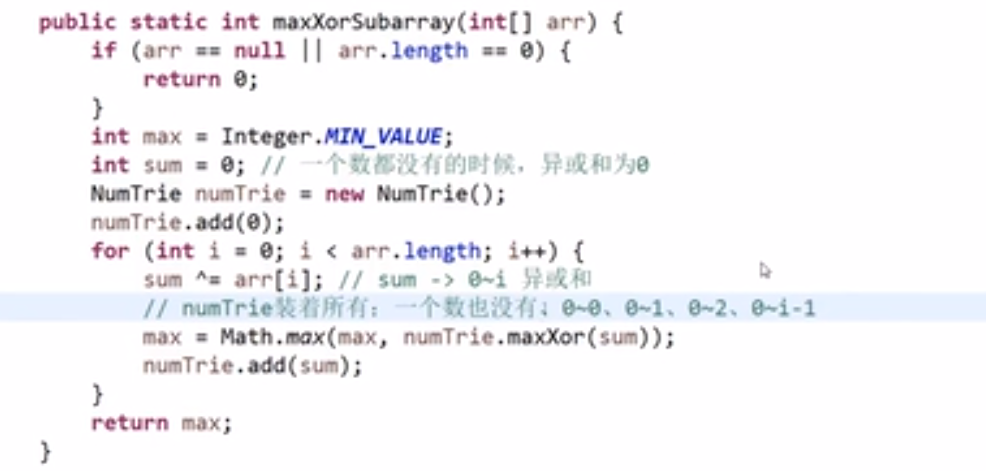

HashSet<Character> set = new HashSet<>();